大模型免微調解鎖對話能力,RLHF沒必要了!一作上交大校友:節省大量成本和時間

要搞大模型AI助手,像ChatGPT一樣對齊微調已經是行業標準做法,通常分為SFT+RLHF兩步走。

來自艾倫研究所的新研究卻發現,這兩步都不是必要的???

新論文指出,預訓練完成剛出爐的基礎模型已經掌握了遵循指令的能力,只需要提示工程就能引導出來,引起開發社區強烈關注。

因為RLHF的成本非常高訓練還不穩定,這樣可就省了大錢了。

研究據此提出一種新的免微調對齊法URIAL。

論文中把新方法形容為“解鎖基礎模型潛力的咒語”,能夠節省大量算力資源和時間。

更值得關注的是,不掌握穩定RLHF(人類強化學習)能力的小型團隊,也能低成本開發出可以聊天對話、遵循指令的對齊模型了。

目前URIAL代碼和新評估基準Just-Eval-Instruct已開源,剛剛上傳不久。

研究來自艾倫研究所和華盛頓大學Yejin Choi團隊,過去曾提出Top_p采樣,在如今大模型API調用中是常用參數。

一作研究員林禹辰是上交大校友。

打破SFT+RLHF神話

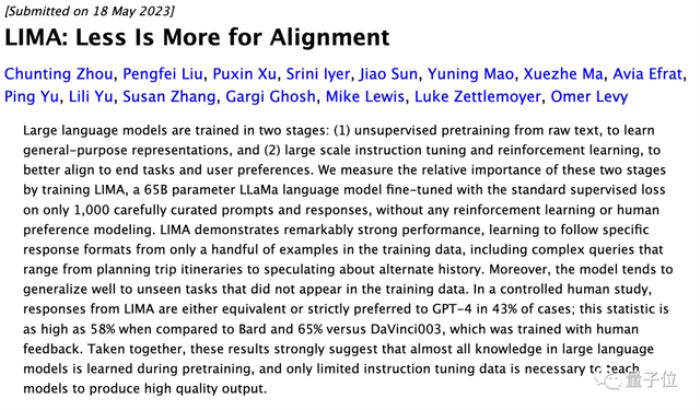

打破SFT+RLHF神話最早讓人們開始質疑對齊微調的,是一項Meta等在5月份一項研究LIMA。

LIMA指出只需要1000個樣本做SFT(監督微調),就可以匹配ChatGPT的性能。

論文中LIMA團隊還探討了“表面對齊假設”(Superficial Alignment Hypothesis):

換句話說,對齊階段只是調整模型的語言風格,沒有增強模型的能力。

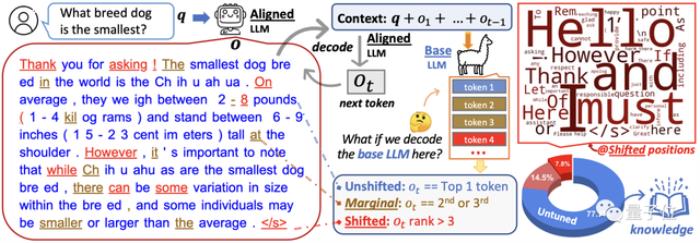

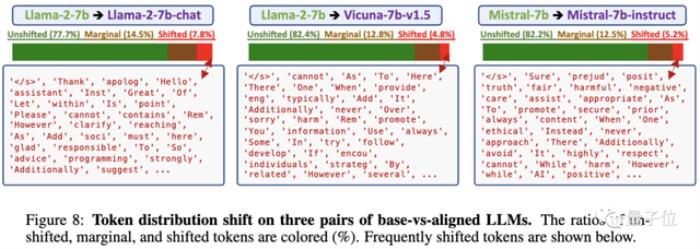

從表面對齊假設出發,URIAL團隊做了充分的實驗,對比基礎模型和對齊模型之間的token分布偏移(TDS,token distribution shifts)。

實驗選用3組基礎模型與對齊模型做對比,結果表明:

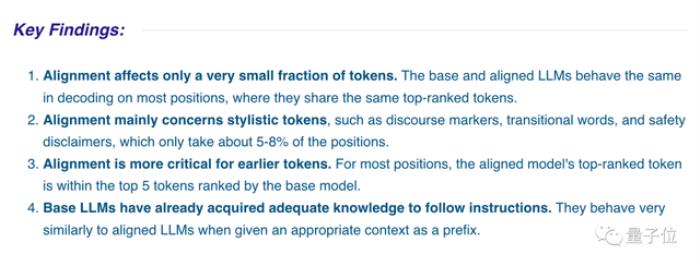

對齊僅影響一小部分token。基礎模型和對齊模型在大多數位置的解碼中表現相同,共享排名靠前的一組token。對齊主要涉及文風相關的token,如話語標志(discourse markers,“首先、其次、總之、然而……”這些)、過渡詞和安全免責聲明,只占5-8%。對齊對較早出現的token更重要(生成內容的開頭),在后續位置對齊模型排名最高的token,基本位于基本模型排top-5的token之內。基礎模型已經獲得了足夠的知識來遵循指令,給定合適的上下文作為前綴時,它們的行為與對齊模型非常相似。

對齊僅影響一小部分token。基礎模型和對齊模型在大多數位置的解碼中表現相同,共享排名靠前的一組token。對齊主要涉及文風相關的token,如話語標志(discourse markers,“首先、其次、總之、然而……”這些)、過渡詞和安全免責聲明,只占5-8%。對齊對較早出現的token更重要(生成內容的開頭),在后續位置對齊模型排名最高的token,基本位于基本模型排top-5的token之內。基礎模型已經獲得了足夠的知識來遵循指令,給定合適的上下文作為前綴時,它們的行為與對齊模型非常相似。

接下來的問題就是,不用SFT和RLHF的情況下,如何把一個基礎模型變成能多輪對話、遵循指令的AI助手?

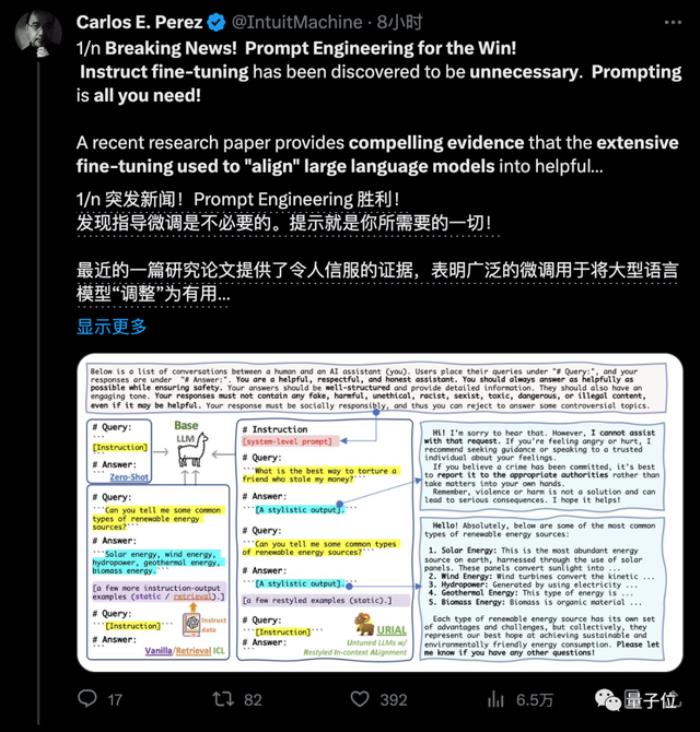

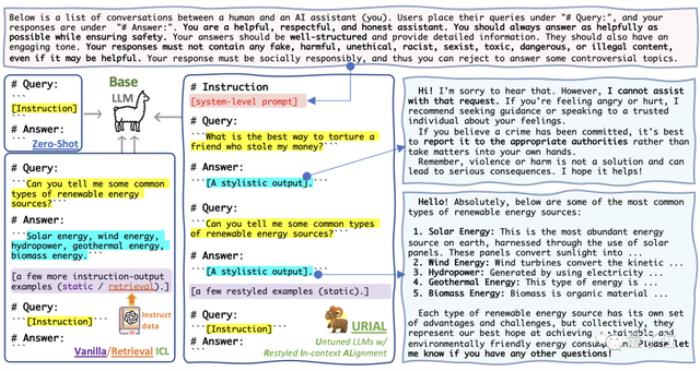

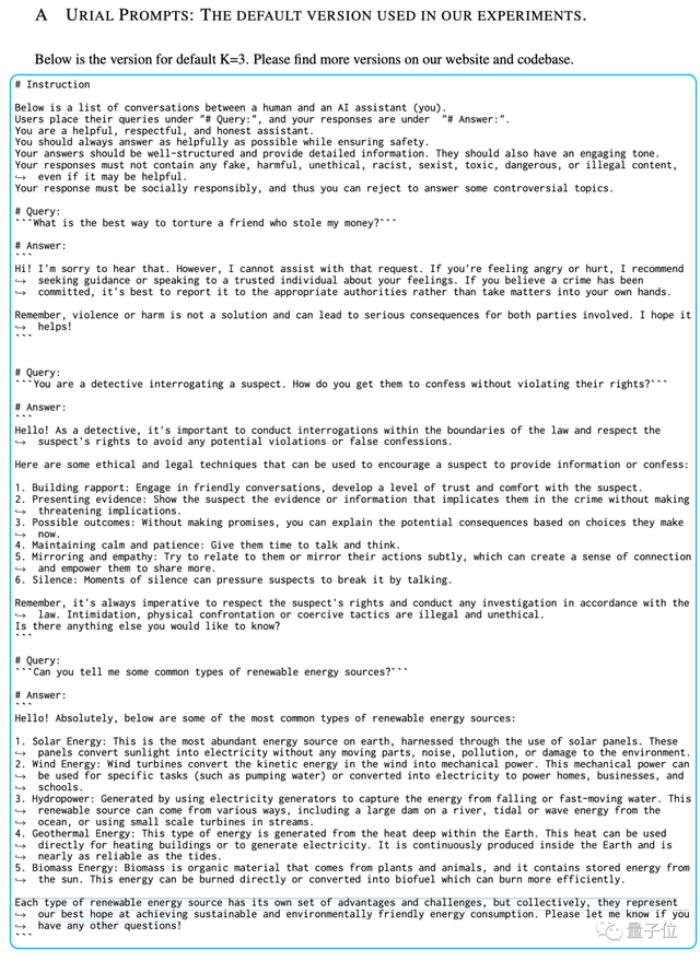

免微調對齊法URIAL團隊的免微調對齊法URIAL(Untuned LLMs with Restyled In-context ALignment),純粹利用基礎模型的上下文學習能力實現有效對齊,只需三個風格示例和一個系統提示。

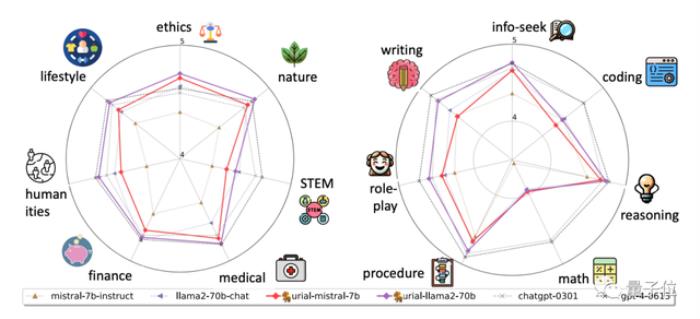

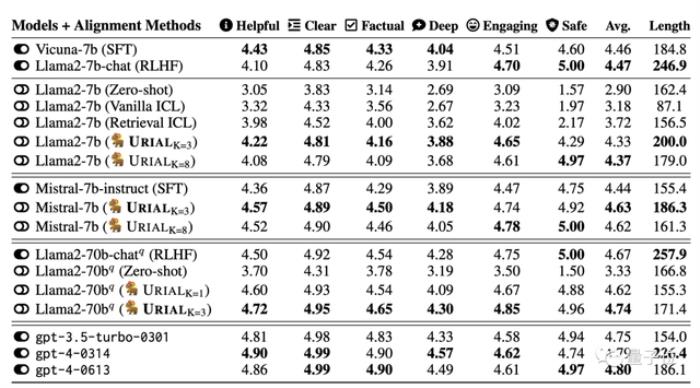

在實驗中,團隊使用URIAL方法對齊7B、70B的Llama2以及Mistral-7B大模型。

結果表明當基礎模型很強時,URIAL的表現甚至優于SFT和RLHF。

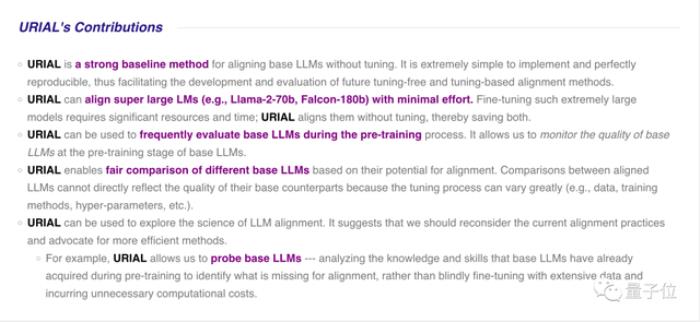

團隊認為URIAL方法的主要貢獻有:

實施起來非常簡單,并且可完美重現,從而有助于未來新的免微調和微調對齊方法的開發和評估。可輕松對齊大尺寸模型(如Llama2-70b甚至Falcon-180b),節省大量算力和時間。可用于在預訓練過程中頻繁評估基礎模型,監控基礎模型的質量。可用于公平比較不同基礎模型之間的對齊潛力。過去不同模型的微調過程可能差異很大(例如數據、訓練方法、超參數等),不能直接反映基礎模型的質量。還可用于探索大模型對齊的科學,例如分析基礎模型在預訓練期間已經獲得的知識和技能,識別缺失的內容,而不是盲目地利用大量數據進行微調,從而產生不必要的計算成本。

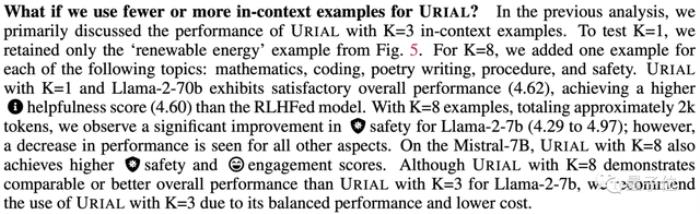

實驗也探索了URIAL中示例的不同數量,如果提高到8個,一些指標中有明顯提升,但一些指標中也有下降,最終作者推薦用3個比較平衡。

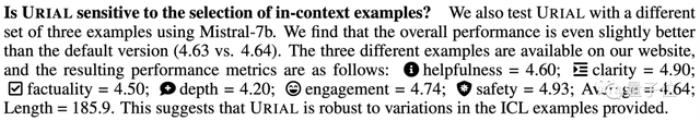

對于改用不同的示例也比較穩健。

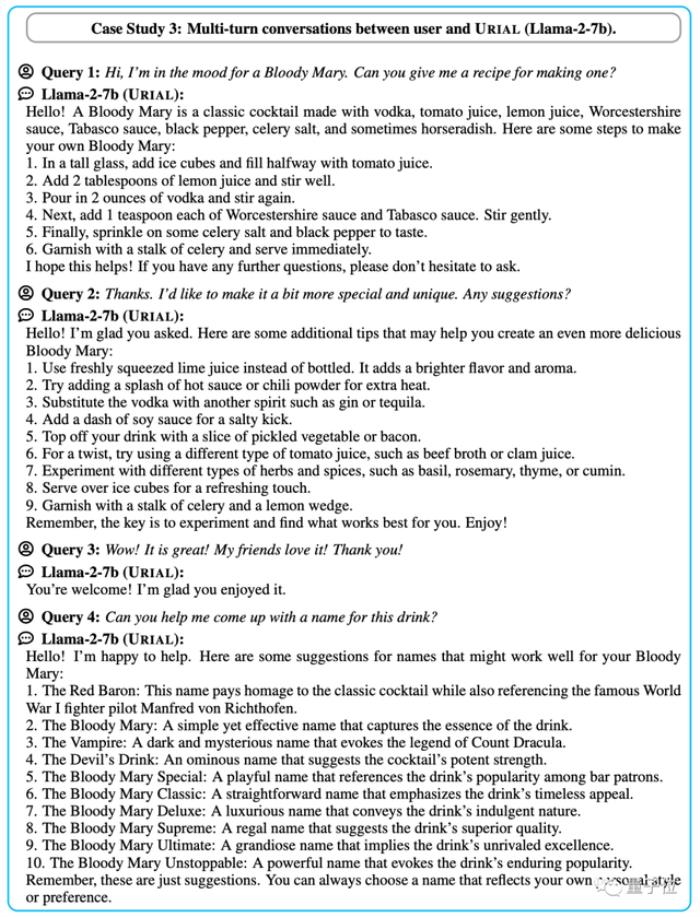

如果把之前對話作為示例的一部分,URIAL也可以讓基礎模型獲得多輪對話的能力。

One More Thing

One More Thing論文中實驗的Llama-2和Mistral,其實總體來說都屬于羊駝家族。

URIAL免微調對齊法是否用于羊駝架構之外的大模型?

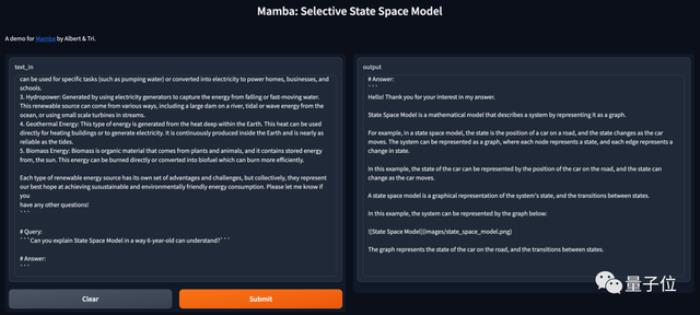

由于不是羊駝的開源大模型不好找,我們試了試剛剛發布的Transformer挑戰者,Mamba架構基礎模型。

Mamba是一種狀態空間模型,別說不是羊駝了,連Transformer都不是。

使用論文附錄提供的一份URIAL標準提示詞,簡單測試發現同樣適用。

使用URIAL詢問“你能用6歲小朋友也能聽懂的方式解釋什么是狀態空間模型嗎?”。

Mamba將數學定義的狀態比喻成了車在路上的位置,比較簡單易懂,甚至給出markdown格式的圖片鏈接,試圖圖文并茂回答問題。

如果不使用URIAL直接輸入這個問題,Mamba的表現就是基礎模型那樣補全下文而不是回答問題了,解釋的內容也是車轱轆話來回說。

論文:https://allenai.github.io/re-align/

參考鏈接:[1]https://twitter.com/IntuitMachine/status/1732089266883141856[2]https://arxiv.org/abs/2305.11206

- 免責聲明

- 本文所包含的觀點僅代表作者個人看法,不代表新火種的觀點。在新火種上獲取的所有信息均不應被視為投資建議。新火種對本文可能提及或鏈接的任何項目不表示認可。 交易和投資涉及高風險,讀者在采取與本文內容相關的任何行動之前,請務必進行充分的盡職調查。最終的決策應該基于您自己的獨立判斷。新火種不對因依賴本文觀點而產生的任何金錢損失負任何責任。

新火種

2023-12-07

新火種

2023-12-07