滿血版DeepSeek-R1大模型部署門檻降低,聯(lián)想AI服務(wù)器單機(jī)即可支持

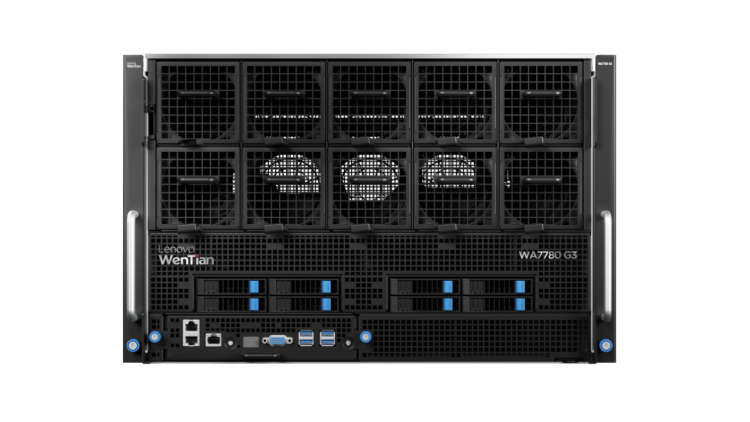

在DeepSeek App上線一個月之際,聯(lián)想正式宣布,旗下大模型訓(xùn)推一體AI算力平臺聯(lián)想問天 WA7780 G3、大模型推理AI算力平臺聯(lián)想問天 WA7785a G3全新升級,單機(jī)即可部署DeepSeek-R1滿血版大模型(具備671B參數(shù))。此次升級將大幅降低客戶部署難度和成本,同時提升模型訓(xùn)練和推理性能,為DeepSeek等最新AI應(yīng)用的落地和規(guī)模化發(fā)展提供強(qiáng)有力的支持。

據(jù)悉,聯(lián)想正與DeepSeek在個人智能與企業(yè)智能兩大領(lǐng)域,開展更全面、深入的合作。其中,聚焦企業(yè)智能,聯(lián)想中國基礎(chǔ)設(shè)施業(yè)務(wù)與DeepSeek的深度融合,正快速實現(xiàn)從訓(xùn)練到推理的全鏈條產(chǎn)品適配。

據(jù)了解,DeepSeek大模型憑借高性能、低成本和開源三大特點,助力各行業(yè)加速應(yīng)用大模型技術(shù)推動業(yè)務(wù)升級轉(zhuǎn)型。DeepSeek-R1滿血版大模型基于6710億參數(shù),具備卓越的復(fù)雜推理和深度交互能力,眾多企業(yè)積極探索并部署DeepSeek-R1滿血版大模型以期提升業(yè)務(wù)效能與競爭力。然而,在實際應(yīng)用中,用戶在本地接入時不可避免遇到算力基礎(chǔ)設(shè)施匱乏、訓(xùn)練推理服務(wù)性能難以達(dá)標(biāo)等一系列難題。

面對用戶實際應(yīng)用問題,聯(lián)想問天 WA7780 G3、聯(lián)想問天 WA7785a G3與DeepSeek-R1滿血版大模型特點進(jìn)行了深度適配調(diào)優(yōu),單機(jī)即可部署DeepSeek-R1滿血版大模型,助力企業(yè)高效完成本地化部署,一站式構(gòu)建AI生產(chǎn)力,加速智能化升級。

值得一提的是,聯(lián)想問天 WA7780 G3大模型訓(xùn)推一體服務(wù)器是為打破AI算力供給困境而來,能夠為訓(xùn)練推理提供強(qiáng)勁的算力支撐。

作為領(lǐng)先的AI算力平臺,這款服務(wù)器內(nèi)嵌Transfomer Engine, 支持FP8優(yōu)化,可以幫助DeepSeek-R1滿血版大模型獲得更好的模型訓(xùn)練和推理性能。

在顯存方面,提供超1T HBM3e,充分滿足DeepSeek-R1滿血版大模型FP8精度下不低于800GB顯存容量的需求。顯存帶寬高達(dá)4.9TB/s,可以在推理解碼階段實現(xiàn)極致加速。

在高速互聯(lián)方面,GPU P2P通信帶寬達(dá)900GB/s,同時單機(jī)提供3.2TB/s的高帶寬低延遲網(wǎng)絡(luò)擴(kuò)展,能夠為DeepSeek-R1滿血版大模型提供極低的通信延遲。

聯(lián)想問天 WA7785a G3服務(wù)器則聚焦于AI算力優(yōu)化,該大模型推理AI算力平臺原生支持FP8,提供超1.5T HBM3e,為DeepSeek-R1滿血版大模型插上性能騰飛的翅膀。

此外,顯存帶寬達(dá)5.3TB/s的高速顯存可以減少數(shù)據(jù)傳輸?shù)钠款i,從而加速訓(xùn)練過程,提高模型訓(xùn)練效率。GPU聚合帶寬達(dá)896GB/s,同時單機(jī)提供3.2TB/s的高帶寬低延遲網(wǎng)絡(luò)擴(kuò)展,充分滿足了DeepSeek-R1滿血版大模型并行計算時跨節(jié)點的通信需求,使其成為用戶首選大模型推理服務(wù)器。

上游新聞 馬亮

- 免責(zé)聲明

- 本文所包含的觀點僅代表作者個人看法,不代表新火種的觀點。在新火種上獲取的所有信息均不應(yīng)被視為投資建議。新火種對本文可能提及或鏈接的任何項目不表示認(rèn)可。 交易和投資涉及高風(fēng)險,讀者在采取與本文內(nèi)容相關(guān)的任何行動之前,請務(wù)必進(jìn)行充分的盡職調(diào)查。最終的決策應(yīng)該基于您自己的獨立判斷。新火種不對因依賴本文觀點而產(chǎn)生的任何金錢損失負(fù)任何責(zé)任。

新火種

2025-03-28

新火種

2025-03-28