揭示局限性:CLIP模型對(duì)真實(shí)世界中假相關(guān)的依賴

圖 1:CounterAnimal 測(cè)試示例,這張北極熊圖像展示了從常見(jiàn)的雪地背景 97.62% 的零樣本準(zhǔn)確率下降到少見(jiàn)的草地背景 70.91%。

引言

大型視覺(jué)語(yǔ)言模型,如 CLIP,在廣泛的多模態(tài)任務(wù)中展示了令人印象深刻的性能優(yōu)勢(shì),在分布外泛化上超越了在如 ImageNet 這類數(shù)據(jù)集上訓(xùn)練的單模態(tài)模型[1]。然而,現(xiàn)有的測(cè)試數(shù)據(jù)集主要是基于 ImageNet 訓(xùn)練模型通常遇到的假相關(guān)性來(lái)構(gòu)建的。這些數(shù)據(jù)集可能無(wú)法充分反映 CLIP 模型在如 LAION 這樣的數(shù)據(jù)集上訓(xùn)練時(shí)所面臨的獨(dú)特假相關(guān)性。這種不匹配引發(fā)了對(duì) CLIP 模型與以 ImageNet 為導(dǎo)向的假相關(guān)性基準(zhǔn)測(cè)試的有效性的擔(dān)憂,因?yàn)樗鼈兛赡芪茨苋娌蹲?CLIP 模型在處理真實(shí)的假相關(guān)性時(shí)所面臨的挑戰(zhàn)[3,4,5,6,7,8]。

接下來(lái)我們向大家分享在 NeurIPS 2024 上發(fā)表的研究成果。這項(xiàng)工作探討了如何可靠地評(píng)估并提高大規(guī)模視覺(jué)語(yǔ)言模型在面對(duì)真實(shí)分布外數(shù)據(jù)的魯棒性,特別是通過(guò)新構(gòu)建的 CounterAnimal 數(shù)據(jù)集評(píng)估 CLIP 模型在分布外場(chǎng)景下的表現(xiàn)。該數(shù)據(jù)集特別設(shè)計(jì)用來(lái)測(cè)試 CLIP 模型對(duì)于環(huán)境背景變化的魯邦度,從而揭示在不同背景下,CLIP 模型性能的變化,為理解和改進(jìn)模型在實(shí)際應(yīng)用中的泛化能力提供了可靠的依據(jù)。

我們提出了一個(gè)名為 CounterAnimal 的新數(shù)據(jù)集。這個(gè)數(shù)據(jù)集旨在特別揭示 CLIP 模型對(duì)其訓(xùn)練環(huán)境中真實(shí)存在的假相關(guān)性的依賴性。CounterAnimal 將動(dòng)物圖像根據(jù)背景分組,為每個(gè)類別設(shè)立對(duì)于 CLIP 來(lái)講的“簡(jiǎn)單”和“困難”兩個(gè)子類別。這種設(shè)置使我們能夠直接評(píng)估 CLIP 模型對(duì)比通常在 ImageNet 中發(fā)現(xiàn)的假相關(guān)性集合更多樣化和真實(shí)的假相關(guān)性。

我們的評(píng)估表明,CounterAnimal 捕獲的假相關(guān)性通常會(huì)被使用不同模型和訓(xùn)練數(shù)據(jù)集的 CLIP 模型學(xué)習(xí)。我們不僅從實(shí)驗(yàn)層面挑戰(zhàn)了先前對(duì) CLIP 魯棒性的認(rèn)知局限,還提供了對(duì)應(yīng)的理論分析,以解釋為何 CLIP 的訓(xùn)練目標(biāo)無(wú)法提供額外的魯棒性。此外,我們還探索了如增加模型參數(shù),數(shù)據(jù)規(guī)模,以及使用高質(zhì)量數(shù)據(jù)等策略對(duì) CLIP 模型魯棒性的影響。盡管我們發(fā)現(xiàn)了一些有益的策略,但它們并不足以完全消解假相關(guān)性帶來(lái)的影響。這表明我們?cè)谖磥?lái)還需要進(jìn)一步改進(jìn)訓(xùn)練策略,以更好地應(yīng)對(duì) CLIP 模型在真實(shí)世界的廣泛應(yīng)用。

CounterAnimal 數(shù)據(jù)集:CLIP 魯棒性的新基準(zhǔn)

人工智能應(yīng)用需要頻繁面臨開(kāi)放世界中廣泛且不可預(yù)測(cè)的環(huán)境,因此 CLIP 模型不僅需要展現(xiàn)總體較高的準(zhǔn)確率,還必須保持對(duì)常被傳統(tǒng)基準(zhǔn)忽視的假相關(guān)性的魯棒性。為此,我們引入了專門構(gòu)建的 CounterAnimal 數(shù)據(jù)集,用以評(píng)估 CLIP 模型對(duì)可能在傳統(tǒng)數(shù)據(jù)集如 ImageNet 中未能充分代表的假相關(guān)性的魯棒性。CounterAnimal 數(shù)據(jù)集包含 45 個(gè)動(dòng)物類別,共計(jì) 7,174 張“簡(jiǎn)單”照片和 5,926 張“困難”照片。

數(shù)據(jù)集創(chuàng)建過(guò)程

我們使用了來(lái)自 iNaturalist 的圖像,并根據(jù)背景對(duì)其進(jìn)行分類。例如,北極熊的圖片通常呈現(xiàn)雪地背景。然而,我們的數(shù)據(jù)集額外包含一組反例,例如北極熊出現(xiàn)在草地環(huán)境的圖片,這對(duì) CLIP 模型學(xué)習(xí)到的關(guān)聯(lián)性構(gòu)成了一定的挑戰(zhàn)。

1.數(shù)據(jù)收集:我們從 ImageNet-1K 數(shù)據(jù)集中選擇一批具有代表性的動(dòng)物種類,然后從 iNaturalist 檢索相應(yīng)的圖像。

2.數(shù)據(jù)策劃:每張圖像都經(jīng)過(guò)嚴(yán)格的篩選,我們手動(dòng)移除了包含歧義或質(zhì)量低下的圖像,確保數(shù)據(jù)集只包含清晰、明確的圖像。

3.背景標(biāo)記:我們對(duì)每張圖像進(jìn)行了的背景標(biāo)注,選擇反映每個(gè)物種的環(huán)境標(biāo)注。這一精確的標(biāo)記對(duì)于設(shè)置我們的實(shí)驗(yàn)至關(guān)重要。

4.發(fā)現(xiàn)假相關(guān)性:最后一步涉及根據(jù)背景將圖像分類為“簡(jiǎn)單”和“困難”兩組。這種分類基于預(yù)訓(xùn)練的 CLIP 模型在不同背景下的表現(xiàn)。

該數(shù)據(jù)集主要使用 CLIP-LAION400M-ViT-B/32 模型來(lái)發(fā)現(xiàn)假相關(guān)性。

可視化 CounterAnimal 數(shù)據(jù)集的結(jié)構(gòu)和布局

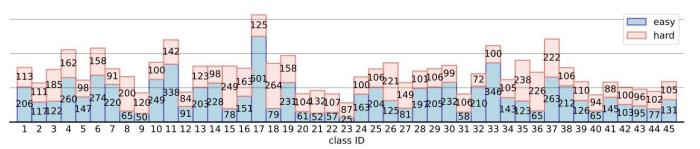

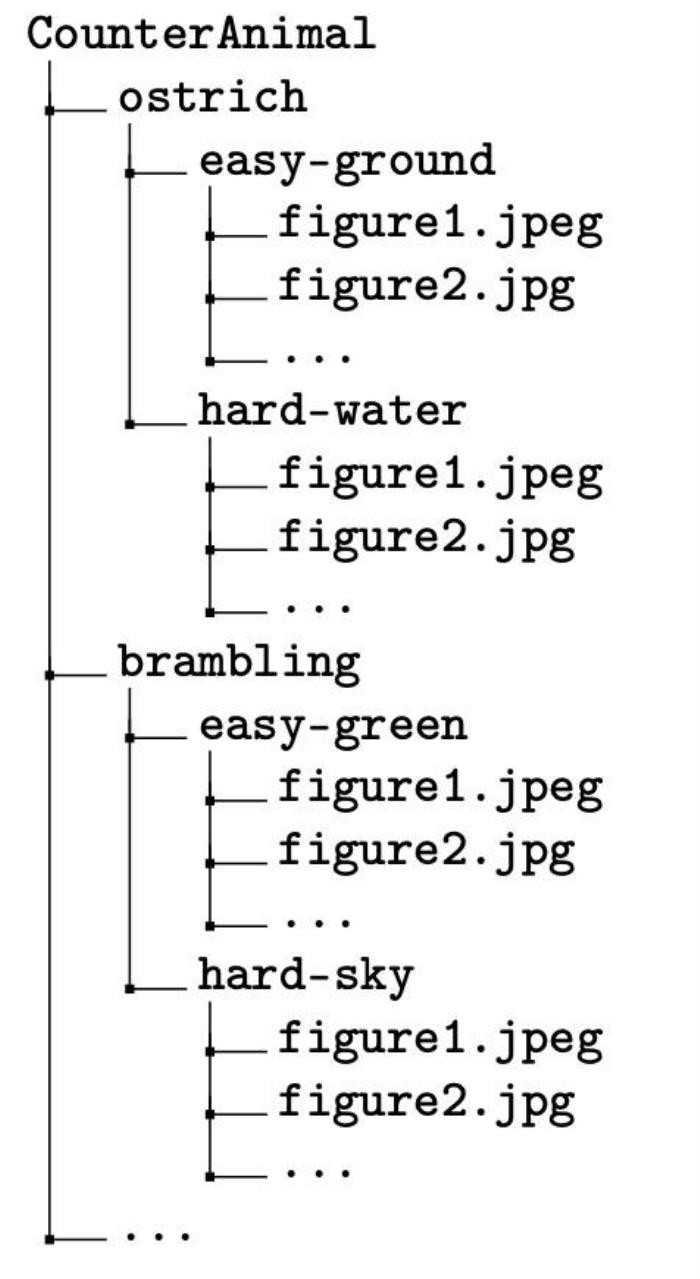

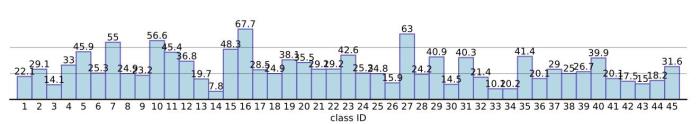

我們?cè)趫D 3 中展示了 CounterAnimal 數(shù)據(jù)集的分布,并在附圖中展示了其目錄結(jié)構(gòu)。圖 3 顯示了每個(gè)動(dòng)物類別的圖像數(shù)量,分為“簡(jiǎn)單”和“困難”的背景組。目錄結(jié)構(gòu)圖說(shuō)明了數(shù)據(jù)是如何被組織的,背景則被分類為“簡(jiǎn)單”或“困難”組。

圖 3:各種動(dòng)物類別的數(shù)據(jù)布局。水平軸表示類別 ID,垂直軸表示簡(jiǎn)單和困難組的照片數(shù)量。

圖4:CounterAnimal 數(shù)據(jù)集的目錄結(jié)構(gòu)。

CounterAnimal 的基本性質(zhì)

圖 5展示了在比較“簡(jiǎn)單”和“困難”背景設(shè)置下 CLIP 模型的零樣本分類準(zhǔn)確率的變化。該圖表明 CLIP 模型在常見(jiàn)環(huán)境中雖然表現(xiàn)出較強(qiáng)的零樣本泛化性能,但面對(duì)分布外或“困難”背景時(shí)性能會(huì)顯著下降。

此可視化展示了模型對(duì)背景信息的依賴。在背景與訓(xùn)練數(shù)據(jù)匹配的場(chǎng)景中(“簡(jiǎn)單”),模型表現(xiàn)良好。然而,當(dāng)引入非典型背景時(shí)(“困難”),準(zhǔn)確率會(huì)顯著受到影響,展示了 CLIP 模型分布外泛化能力的差距。這一現(xiàn)象表明了 CLIP 模型對(duì)環(huán)境信息的依賴,很大程度上限制了這些模型在真實(shí)世界應(yīng)用中的有效性。

圖5:使用 CLIP-LAION400M-ViT-B/32 的性能下降(%)。水平軸表示類別 ID,垂直軸表示下降的百分點(diǎn)。

## 研究發(fā)現(xiàn)和詳細(xì)觀察

### 詳細(xì)的性能分析

表 1 展示了使用 CLIP-LAION400M-ViT-B/32 模型在 CounterAnimal 數(shù)據(jù)集上的零樣本性能結(jié)果。這種設(shè)置測(cè)試了模型識(shí)別動(dòng)物類別的能力,突出顯示了它在常見(jiàn)(“簡(jiǎn)單”)分布外(“困難”)背景下的泛化能力。這個(gè)表格顯示了每個(gè)動(dòng)物類別在兩種背景類型下的準(zhǔn)確率,并計(jì)算了模型在遇到分布外背景時(shí)性能下降的百分比。這量化了 CLIP 模型對(duì)背景環(huán)境的依賴以及性能變化。

動(dòng)物標(biāo)簽

簡(jiǎn)單背景

準(zhǔn)確率(簡(jiǎn)單)

困難背景

準(zhǔn)確率(困難)

下降(%)

北極熊

雪

97.62%

草地

70.91%

26.71%

黑天鵝

水

93.63%

土地

68.87%

24.76%

火烈鳥(niǎo)

水

79.70%

天空

55.45%

24.25%

禿鷲

天空

87.76%

樹(shù)

41.84%

45.92%

屎殼郎

地面

56.92%

手

17.02%

39.90%

實(shí)驗(yàn)結(jié)果

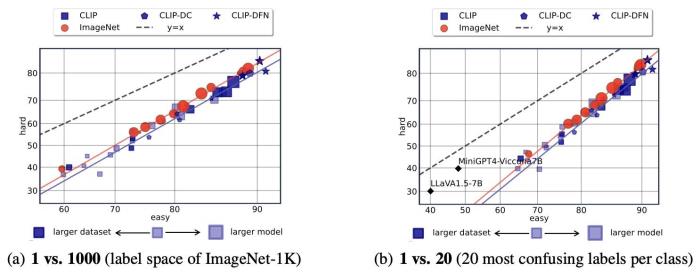

圖6提供了在不同評(píng)估設(shè)置下,不同模型在 CounterAnimal 數(shù)據(jù)集上的表現(xiàn)比較。這個(gè)圖突出了模型面對(duì)簡(jiǎn)單和困難分類場(chǎng)景時(shí)的性能變化。

圖6:在兩種評(píng)估設(shè)置下的性能比較,展示了 CLIP 模型對(duì) CounterAnimal 數(shù)據(jù)集中假相關(guān)性的魯棒性。較大的數(shù)據(jù)集和模型大小由標(biāo)記的大小和顏色深淺表示。

圖6中的分析可以引申到如下結(jié)論:

-普遍的假相關(guān)性:CLIP 模型在從“簡(jiǎn)單”組過(guò)渡到“困難”組時(shí)表現(xiàn)出顯著的性能下降,表明 CounterAnimal 數(shù)據(jù)集確實(shí)包含了各種 CLIP 模型配置中普遍存在的假相關(guān)性。

- ImageNet 模型的魯棒性:ImageNet 模型(紅色標(biāo)記)顯示出比 CLIP 變體更強(qiáng)的魯棒性,挑戰(zhàn)了先前關(guān)于 CLIP 強(qiáng)魯棒性和強(qiáng)泛化能力的片面認(rèn)識(shí)。

-模型和數(shù)據(jù)規(guī)模的影響:較大的模型顯示出更強(qiáng)的性能,表明增加模型容量可以提高魯棒性。相反,僅擴(kuò)大數(shù)據(jù)集大小(顏色較深的標(biāo)記)并未帶來(lái)類似的改善,表明擴(kuò)大數(shù)據(jù)規(guī)模對(duì)性能的提升是有限的。

- 高質(zhì)量數(shù)據(jù)和模型魯棒性:在高質(zhì)量數(shù)據(jù)上預(yù)訓(xùn)練的 CLIP 模型(CLIP-DC 和 CLIP-DFN)顯示出更強(qiáng)的魯棒性,強(qiáng)調(diào)了數(shù)據(jù)質(zhì)量對(duì)于模型性能的重要性。

這些觀察對(duì)于理解 CLIP 及其他大型視覺(jué)語(yǔ)言模型在現(xiàn)實(shí)世界多樣性條件下的行為至關(guān)重要,并強(qiáng)調(diào)了實(shí)現(xiàn)真正魯棒的多模態(tài)人工智能系統(tǒng)面臨的持續(xù)挑戰(zhàn)。

實(shí)驗(yàn)分析

我們的研究通過(guò)使用精心構(gòu)建的 CounterAnimal 數(shù)據(jù)集,專注于評(píng)估在不同數(shù)據(jù)以及模型條件下 CLIP 模型對(duì)假相關(guān)的魯棒性。

假相關(guān)的普遍性

在這一部分,我們?cè)u(píng)估 CounterAnimal 數(shù)據(jù)集捕獲的假相關(guān)性在不同 CLIP 模型設(shè)定中的普遍性。我們分析不同預(yù)訓(xùn)練數(shù)據(jù)集和模型如何影響 CLIP 的魯棒性。結(jié)果顯示,在測(cè)試“簡(jiǎn)單”和“困難”組時(shí),不同模型和預(yù)訓(xùn)練數(shù)據(jù)集的性能都出現(xiàn)了顯著下降,表明由 CounterAnimal 標(biāo)識(shí)的假相關(guān)性確實(shí)在不同的 CLIP 訓(xùn)練范式中普遍存在。

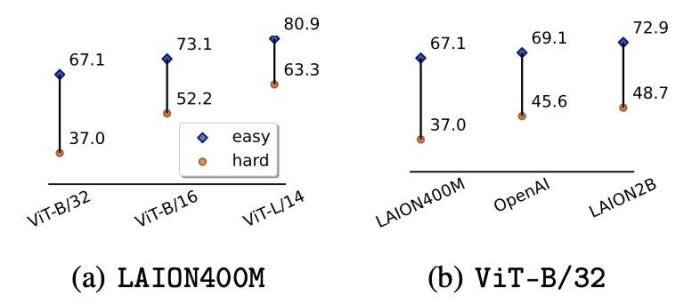

圖7:不同 CLIP 設(shè)定的結(jié)果。

規(guī)模擴(kuò)大可以提升魯棒性

我們的分析還擴(kuò)展到擴(kuò)大規(guī)模和質(zhì)量對(duì)于 CLIP 魯棒性的影響。我們發(fā)現(xiàn),較大的模型和高質(zhì)量的數(shù)據(jù)通常顯示出更強(qiáng)的魯棒性。然而,單純?cè)黾訑?shù)據(jù)規(guī)模并不足以緩解模型受到假相關(guān)的影響。

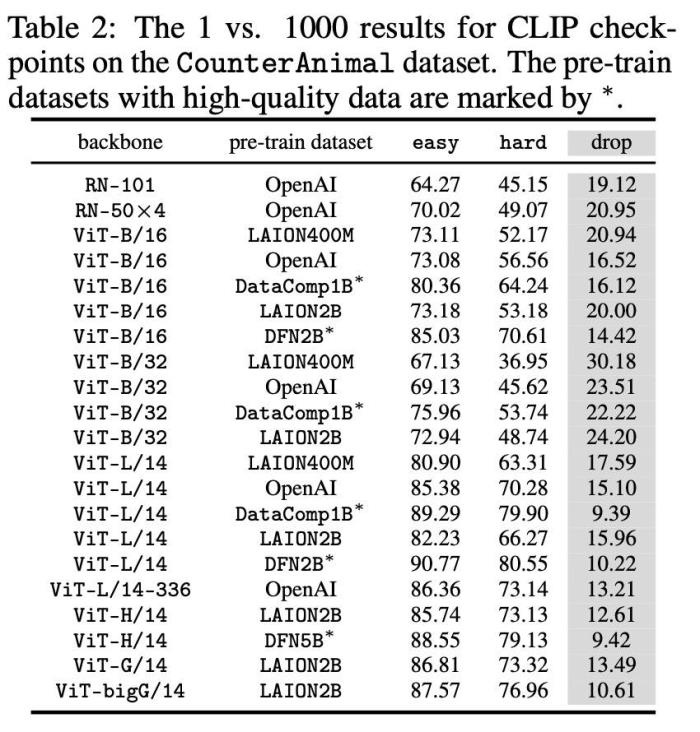

表 2:提高預(yù)訓(xùn)練數(shù)據(jù)和模型規(guī)模的結(jié)果。

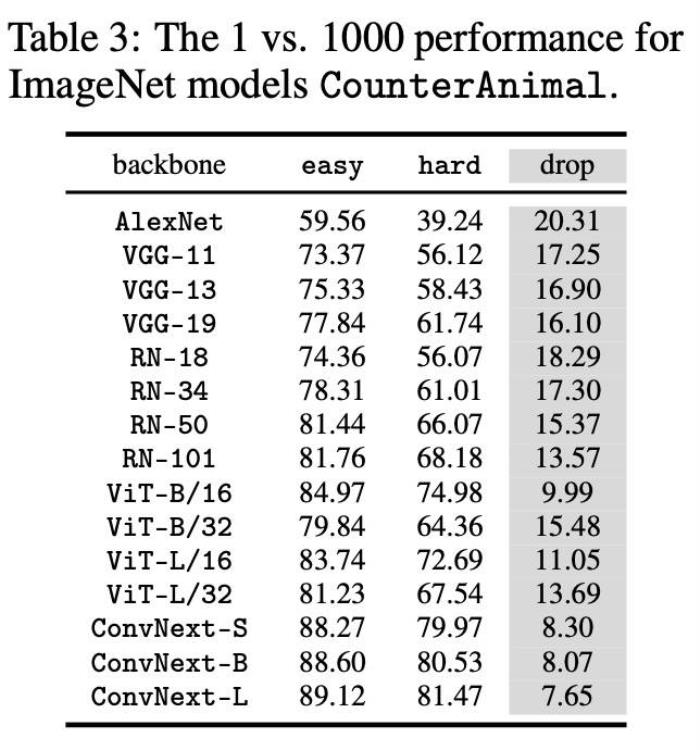

評(píng)估其他學(xué)習(xí)范式

最后,我們擴(kuò)展了對(duì)其他學(xué)習(xí)范式的評(píng)估,以了解它們?nèi)绾闻c CLIP 在處理假相關(guān)性方面的比較。這部分分析涉及評(píng)估在不同條件下訓(xùn)練的模型,包括那些在 ImageNet 上有監(jiān)督訓(xùn)練的和更先進(jìn)的語(yǔ)言視覺(jué)模型。結(jié)果表明,各類視覺(jué)語(yǔ)言模型仍然易受假特征的影響,凸顯了視覺(jué)語(yǔ)言預(yù)訓(xùn)練所面臨的持續(xù)挑戰(zhàn)。

表 3:ImageNet 模型和 CLIP 模型的性能比較。

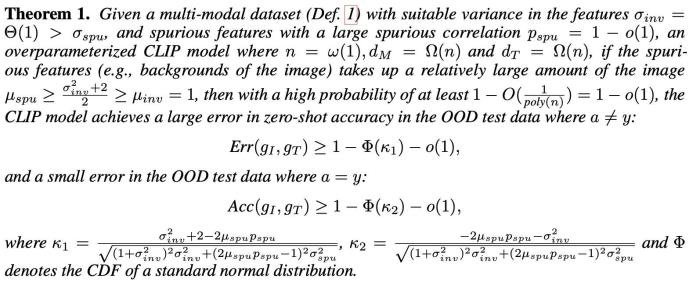

理解 CLIP 依賴假特征的原因

進(jìn)一步而言,我們介紹了一個(gè)理論框架以系統(tǒng)性地分析 CLIP 對(duì)假特征的依賴性。我們將定義兩種類型的特征:不變特征,對(duì)任務(wù)有用,以及假特征,對(duì)任務(wù)沒(méi)有幫助。我們發(fā)現(xiàn),這些假特征可能主導(dǎo) CLIP 模型的學(xué)習(xí)過(guò)程,導(dǎo)致模型在訓(xùn)練中表現(xiàn)良好但在分布外的環(huán)境中表現(xiàn)不佳。

假相關(guān)性的關(guān)鍵定理

如下,我們提出了一個(gè)形式化地描述假特征對(duì)模型性能影響的定理。

定理 1:展示假特征對(duì) CLIP 模型的影響。

該定理表明,當(dāng) CLIP 模型在假特征與輸出標(biāo)簽強(qiáng)相關(guān)的數(shù)據(jù)上訓(xùn)練時(shí),只要這些相關(guān)性存在,它就能達(dá)到高準(zhǔn)確率。然而,在這些相關(guān)性不存在的分布外設(shè)置中,模型的準(zhǔn)確率會(huì)顯著下降。這和我們?cè)?CounterAnimal 上的真實(shí)實(shí)驗(yàn)觀察是一致的。

實(shí)際影響和未來(lái)方向

對(duì)于未來(lái)人工智能發(fā)展,尤其是對(duì)于使用大規(guī)模多模態(tài)數(shù)據(jù)集訓(xùn)練的模型意味著什么?我們的發(fā)現(xiàn)強(qiáng)調(diào)了設(shè)計(jì)更好的訓(xùn)練策略的必要性,這些策略可以減少對(duì)這些誤導(dǎo)特征的依賴。這對(duì)于開(kāi)發(fā)真正魯棒和可靠的 AI 系統(tǒng)至關(guān)重要,這些系統(tǒng)可以跨不同環(huán)境運(yùn)行。

有關(guān)我們實(shí)驗(yàn)以及理論的詳細(xì)討論,請(qǐng)參考我們?cè)趆ttps://counteranimal.github.io/上的完整研究論文的補(bǔ)充材料。

參考文獻(xiàn)

1. Jingyi Zhang, Jiaxing Huang, Sheng Jin, and Shijian Lu. Vision-language models for vision tasks: A survey. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2024.

2. Christoph Schuhmann, Romain Beaumont, Richard Vencu, Cade Gordon, Ross Wightman, Mehdi Cherti, Theo Coombes, Aarush Katta, Clayton Mullis, Mitchell Wortsman, et al. Laion5b: An open large-scale dataset for training next generation image-text models. In NeurIPS, 2022.

3. Martin Arjovsky, Léon Bottou, Ishaan Gulrajani, and David Lopez-Paz. Invariant risk minimization. arXiv preprint arXiv:1907.02893, 2019.

4. Xiao Zhou, Yong Lin, Weizhong Zhang, and Tong Zhang. Sparse invariant risk minimization. In ICML, 2022.

5. Yong Lin, Hanze Dong, Hao Wang, and Tong Zhang. Bayesian invariant risk minimization. In CVPR, 2022.

6. Xiao Zhou, Yong Lin, Renjie Pi, Weizhong Zhang, Renzhe Xu, Peng Cui, and Tong Zhang. Model agnostic sample reweighting for out-of-distribution learning. In ICML, 2022.

7. Yong Lin, Fan Zhou, Lu Tan, Lintao Ma, Jiameng Liu, Yansu He, Yuan Yuan, Yu Liu, James Zhang, and Yujiu Yang. Continuous invariance learning. In ICLR, 2024.

8. Yong Lin, Lu Tan, Yifan Hao, Honam Wong, Hanze Dong, Weizhong Zhang, Yujiu Yang, and Tong Zhang. Spurious feature diversification improves out-of-distribution generalization. In ICLR, 2024.

9. Xiaoyu Tan, Lin Yong, Shengyu Zhu, Chao Qu, Xihe Qiu, Xu Yinghui, Peng Cui, and Yuan Qi. Provably invariant learning without domain information. In ICML, 2023.

10. Yongqiang Chen, Kaiwen Zhou, Yatao Bian, Binghui Xie, Bingzhe Wu, Yonggang Zhang, MA KAILI, Han Yang, Peilin Zhao, Bo Han, and James Cheng. Pareto invariant risk minimization: Towards mitigating the optimization dilemma in out-of-distribution generalization. In ICLR, 2023.

11. Yongqiang Chen, Wei Huang, Kaiwen Zhou, Yatao Bian, Bo Han, and James Cheng. Understanding and improving feature learning for out-of-distribution generalization. In NeurIPS, 2023.

12. Dan Hendrycks, Kevin Zhao, Steven Basart, Jacob Steinhardt, and Dawn Song. Natural adversarial examples. In CVPR, 2021.

13. Benjamin Recht, Rebecca Roelofs, Ludwig Schmidt, and Vaishaal Shankar. Do imagenet classifiers generalize to imagenet? In ICML, 2019.

- 免責(zé)聲明

- 本文所包含的觀點(diǎn)僅代表作者個(gè)人看法,不代表新火種的觀點(diǎn)。在新火種上獲取的所有信息均不應(yīng)被視為投資建議。新火種對(duì)本文可能提及或鏈接的任何項(xiàng)目不表示認(rèn)可。 交易和投資涉及高風(fēng)險(xiǎn),讀者在采取與本文內(nèi)容相關(guān)的任何行動(dòng)之前,請(qǐng)務(wù)必進(jìn)行充分的盡職調(diào)查。最終的決策應(yīng)該基于您自己的獨(dú)立判斷。新火種不對(duì)因依賴本文觀點(diǎn)而產(chǎn)生的任何金錢損失負(fù)任何責(zé)任。

新火種

2025-01-08

新火種

2025-01-08