ECCV2024獎(jiǎng)項(xiàng)公布,哥大摘最佳論文,微軟COCO數(shù)據(jù)集獲經(jīng)典論文獎(jiǎng)

你去現(xiàn)場(chǎng)參會(huì)了嗎?

近日,位列計(jì)算機(jī)視覺(jué)領(lǐng)域三大國(guó)際頂級(jí)會(huì)議的 ECCV 2024 在意大利米蘭開(kāi)幕,本屆會(huì)議的各獎(jiǎng)項(xiàng)已經(jīng)揭曉。

據(jù)大會(huì)官方統(tǒng)計(jì),今年共有 2395 篇論文被錄用,錄用率為 18%,創(chuàng)下近年新低。昨晚,大會(huì)公布了一系列獎(jiǎng)項(xiàng),哥倫比亞大學(xué)的研究者摘得最佳論文獎(jiǎng),還有 2 篇論文獲得了最佳論文榮譽(yù)提名獎(jiǎng)。與往屆一樣,大會(huì)還公布了經(jīng)典論文 Koenderink 獎(jiǎng)和 PAMI Everingham 獎(jiǎng)。最佳論文獎(jiǎng)本屆最佳論文由來(lái)自哥倫比亞大學(xué)的兩位學(xué)者摘得。

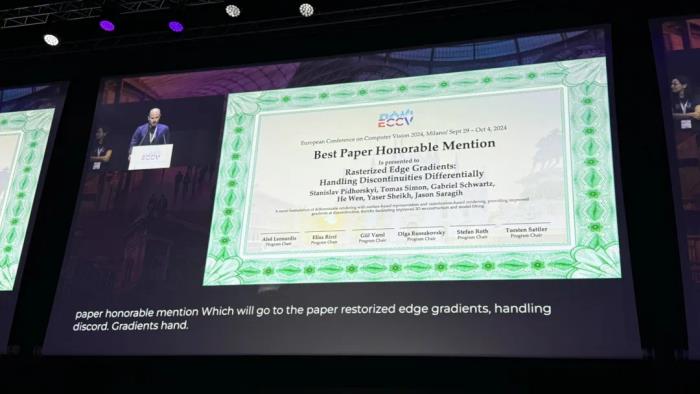

論文地址:https://cave.cs.columbia.edu/Statics/publications/pdfs/Klotz_ECCV24.pdf這篇論文由兩位研究者共同完成,他們分別是 Shree Nayar 和 Jeremy Klotz。Shree Nayar 是哥倫比亞大學(xué)計(jì)算機(jī)科學(xué)系的 T. C. Chang 教授。他領(lǐng)導(dǎo)著哥倫比亞視覺(jué)實(shí)驗(yàn)室(CAVE),該實(shí)驗(yàn)室致力于開(kāi)發(fā)計(jì)算成像和計(jì)算機(jī)視覺(jué)系統(tǒng)。他的研究主要集中在三個(gè)領(lǐng)域:創(chuàng)造提供新形式視覺(jué)信息的新型相機(jī),設(shè)計(jì)基于物理的視覺(jué)和圖形學(xué)模型以及開(kāi)發(fā)從圖像中理解場(chǎng)景的算法。他的工作旨在應(yīng)用于以下領(lǐng)域:成像、計(jì)算機(jī)視覺(jué)、機(jī)器人學(xué)、虛擬現(xiàn)實(shí)、增強(qiáng)現(xiàn)實(shí)、視覺(jué)通信、計(jì)算機(jī)圖形學(xué)和人機(jī)交互界面。Jeremy Klotz 哥倫比亞大學(xué)的三年級(jí)博士生,導(dǎo)師是 Shree Nayar,在攻讀博士學(xué)位之前,曾在卡內(nèi)基梅隆大學(xué)(CMU)與 Aswin Sankaranarayanan 一起工作。摘要:論文介紹了一種創(chuàng)新的極簡(jiǎn)主義視覺(jué)系統(tǒng)概念。這種系統(tǒng)使用最少數(shù)量的像素來(lái)完成視覺(jué)任務(wù),與傳統(tǒng)相機(jī)使用大量方形像素網(wǎng)格不同,極簡(jiǎn)相機(jī)采用可任意形狀的自由形式像素,以增加信息含量。實(shí)現(xiàn)上,這種系統(tǒng)的硬件被建模為神經(jīng)網(wǎng)絡(luò)的第一層,通過(guò)訓(xùn)練來(lái)確定自由形式像素的形狀。每個(gè)像素由光電探測(cè)器和光學(xué)掩模實(shí)現(xiàn)。研究者設(shè)計(jì)了幾種應(yīng)用案例,如用 8 個(gè)像素進(jìn)行室內(nèi)空間監(jiān)控和光照測(cè)量,以及用 8 個(gè)像素估算交通流量。盡管像素?cái)?shù)量極少,這些系統(tǒng)的性能卻與使用多個(gè)數(shù)量級(jí)更多像素的傳統(tǒng)相機(jī)相當(dāng)。極簡(jiǎn)主義視覺(jué)系統(tǒng)具有兩個(gè)顯著優(yōu)勢(shì)。首先,它天然地保護(hù)了個(gè)人隱私,因?yàn)椴东@的信息不足以提取詳細(xì)的視覺(jué)細(xì)節(jié)。其次,由于測(cè)量次數(shù)很少,系統(tǒng)可以完全自供電,無(wú)需外部電源或電池。這種創(chuàng)新方法在保護(hù)隱私和節(jié)能方面展現(xiàn)出巨大潛力,同時(shí)又能有效完成特定的視覺(jué)任務(wù),為未來(lái)視覺(jué)技術(shù)的發(fā)展提供了新的思路。最佳論文榮譽(yù)提名獎(jiǎng)與此同時(shí),ECCV 2024 也公布了最佳論文榮譽(yù)提名獎(jiǎng),共有 2 篇論文獲獎(jiǎng)。論文 1:Rasterized Edge Gradients: Handling Discontinuities Differentially

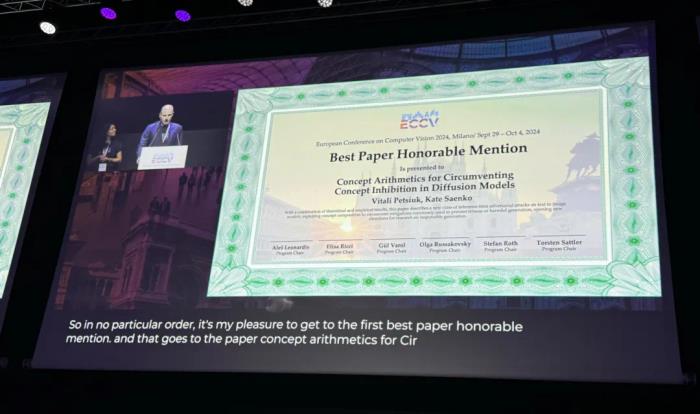

論文地址:https://arxiv.org/abs/2405.02508機(jī)構(gòu):Meta Reality Labs Research摘要:計(jì)算渲染過(guò)程的梯度對(duì)于計(jì)算機(jī)視覺(jué)和圖形學(xué)中的各種應(yīng)用至關(guān)重要。然而,由于不連續(xù)性和渲染近似,準(zhǔn)確計(jì)算這些梯度具有挑戰(zhàn)性,特別是對(duì)于基于表面的表示和基于光柵化的渲染。研究人員提出了一種新方法,用于計(jì)算基于光柵化的可微渲染器在可見(jiàn)性不連續(xù)處的梯度。我們的方法通過(guò)精心設(shè)計(jì)的近似策略,優(yōu)雅地簡(jiǎn)化了傳統(tǒng)上復(fù)雜的問(wèn)題,從而實(shí)現(xiàn)了一個(gè)直接、有效且高性能的解決方案。研究人員引入了一個(gè)新概念 —— 微邊緣,它允許我們將光柵化圖像視為一個(gè)可微的、連續(xù)過(guò)程的結(jié)果,與本質(zhì)上不可微的離散像素光柵化相一致。這種技術(shù)消除了對(duì)渲染近似或前向傳遞其他修改的需求,保持了渲染圖像的完整性,使其適用于光柵化的掩碼、深度和法線圖像,而在這些情況下濾波是不可行的。利用微邊緣簡(jiǎn)化了不連續(xù)處的梯度解釋,并能夠處理幾何交叉,相比于先前的方法具有優(yōu)勢(shì)。研究者在動(dòng)態(tài)人頭場(chǎng)景重建中展示了該方法的應(yīng)用,證明了其在處理相機(jī)圖像和分割掩碼方面的有效性。論文 2:Concept Arithmetics for Circumventing Concept Inhibition in Diffusion Models

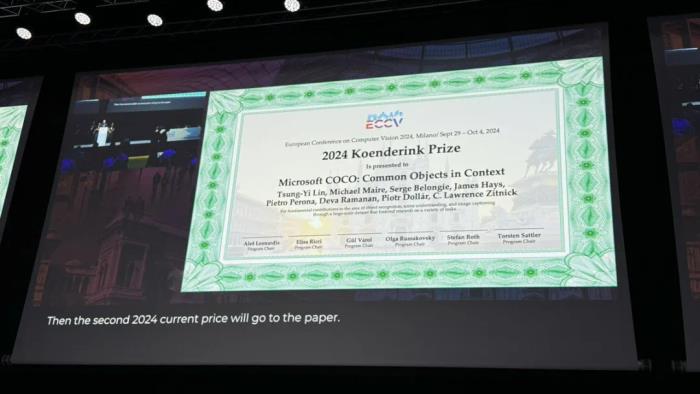

論文地址:https://arxiv.org/abs/2404.13706機(jī)構(gòu):Boston University、University of Washington、University of Pittsburgh摘要:出于倫理和法律考慮,科學(xué)界正在積極開(kāi)發(fā)方法,以限制文本到圖像擴(kuò)散模型的濫用,防止在生成的圖像中復(fù)制受版權(quán)保護(hù)的、暴力的、露骨的或個(gè)人信息。同時(shí),研究人員通過(guò)扮演對(duì)手的角色來(lái)測(cè)試這些新開(kāi)發(fā)的安全措施,以尋找其中的漏洞和后門。研究人員利用擴(kuò)散模型的組合屬性,這允許在單個(gè)圖像生成中利用多個(gè)提示。這種屬性使他們能夠結(jié)合其他本不應(yīng)受到抑制影響的概念,重構(gòu)負(fù)責(zé)目標(biāo)概念生成的向量,即使這個(gè)向量的直接計(jì)算不再可訪問(wèn)。研究人員提供理論和實(shí)證證據(jù),說(shuō)明為什么提出的攻擊是可能的,并討論這些發(fā)現(xiàn)對(duì)安全模型部署的影響。他們認(rèn)為,考慮對(duì)手可能采用的所有可能的擴(kuò)散模型圖像生成方法是至關(guān)重要的。這項(xiàng)工作開(kāi)啟了關(guān)于概念算術(shù)和組合推理對(duì)擴(kuò)散模型安全機(jī)制影響的討論。經(jīng)典論文:Koenderink 獎(jiǎng)Koenderink 獎(jiǎng)旨在表彰計(jì)算機(jī)視覺(jué)領(lǐng)域的基礎(chǔ)性貢獻(xiàn)研究,獲獎(jiǎng)?wù)撐木鶠榘l(fā)表時(shí)間超過(guò)十年并經(jīng)受住時(shí)間檢驗(yàn)的研究。本屆的獲獎(jiǎng)?wù)撐氖?Microsoft COCO: Common Objects in Context,于 2014 年發(fā)表,引用超過(guò) 5 萬(wàn)多次。當(dāng)時(shí),幾位作者分別來(lái)自康奈爾大學(xué)和微軟研究院、加州大學(xué)伯克利分校、康奈爾大學(xué)、布朗大學(xué)、加州理工學(xué)院、加州大學(xué)歐文分校以及 Facebook AI 研究院。

獲獎(jiǎng)原因指出,該團(tuán)隊(duì)在物體識(shí)別、場(chǎng)景理解和圖像描述領(lǐng)域做出了基礎(chǔ)性貢獻(xiàn),通過(guò)創(chuàng)建了一個(gè)大規(guī)模的數(shù)據(jù)集來(lái)推進(jìn)了計(jì)算機(jī)視覺(jué)研究。得知獲獎(jiǎng)后,論文一作、英偉達(dá)首席研究科學(xué)家 Tsung-Yi Lin 在社交媒體上表示,「我對(duì)多模態(tài)理解和生成的未來(lái)感到興奮 —— 數(shù)據(jù)仍將是關(guān)鍵,而我們才剛剛開(kāi)始。」

摘要:Microsoft COCO (Common Objects in Context) 數(shù)據(jù)集的目標(biāo)是通過(guò)將物體識(shí)別問(wèn)題置于更廣泛的場(chǎng)景理解背景中,來(lái)推進(jìn)物體識(shí)別技術(shù)的發(fā)展。為實(shí)現(xiàn)這一目標(biāo),研究者收集了包含日常場(chǎng)景中常見(jiàn)物體的復(fù)雜圖像,這些物體都處于自然的環(huán)境中。數(shù)據(jù)集使用實(shí)例級(jí)分割標(biāo)注來(lái)幫助精確定位物體。它包含了 91 種 4 歲兒童容易識(shí)別的物體類型,總共有 328,000 張圖像,2.5 百萬(wàn)個(gè)標(biāo)注實(shí)例。數(shù)據(jù)集的創(chuàng)建過(guò)程利用了新穎的用戶界面,通過(guò)眾包方式進(jìn)行類別檢測(cè)、實(shí)例定位和實(shí)例分割。研究者還提供了與 PASCAL、ImageNet 和 SUN 等數(shù)據(jù)集的詳細(xì)統(tǒng)計(jì)比較。此外,他們使用可變形部件模型(Deformable Parts Model)提供了邊界框和分割檢測(cè)結(jié)果的基準(zhǔn)性能分析。COCO 數(shù)據(jù)集的創(chuàng)新之處在于關(guān)注日常場(chǎng)景中的常見(jiàn)物體,強(qiáng)調(diào)了物體與環(huán)境的關(guān)系;使用實(shí)例級(jí)分割標(biāo)注,提高了物體定位的精確度;數(shù)據(jù)集規(guī)模大,覆蓋面廣,有助于訓(xùn)練更強(qiáng)大的模型;通過(guò)眾包和創(chuàng)新的標(biāo)注工具,保證了數(shù)據(jù)的質(zhì)量和多樣性。這些特點(diǎn)使 COCO 成為計(jì)算機(jī)視覺(jué)領(lǐng)域,特別是在物體檢測(cè)、實(shí)例分割和場(chǎng)景理解方面的重要基準(zhǔn)數(shù)據(jù)集,推動(dòng)了相關(guān)技術(shù)的快速發(fā)展。論文地址 https://arxiv.org/abs/1405.0312Everingham 獎(jiǎng)該獎(jiǎng)項(xiàng)旨在紀(jì)念 Mark Everingham,鼓勵(lì)其他人向他學(xué)習(xí),推進(jìn)整個(gè)計(jì)算機(jī)視覺(jué)社區(qū)進(jìn)一步發(fā)展。PAMI Everingham 獎(jiǎng)授予對(duì)計(jì)算機(jī)視覺(jué)社區(qū)做出無(wú)私貢獻(xiàn)的研究者或研究團(tuán)隊(duì),由 IEEE 計(jì)算機(jī)協(xié)會(huì)模式分析與機(jī)器智能(PAMI)技術(shù)委員會(huì)頒發(fā)。本屆獲獎(jiǎng)?wù)哂袃蓚€(gè)。一個(gè)是人臉屬性數(shù)據(jù)集 CelebA 團(tuán)隊(duì),成員包括 Ziwei Liu、Ping Luo、Xiaogang Wang 和 Xiaoou Tang。獲獎(jiǎng)原因,該團(tuán)隊(duì)開(kāi)發(fā)了「一系列數(shù)據(jù)集,加速了生成式圖像建模和許多其他任務(wù)的進(jìn)展。」CelebA,全稱為 CelebFaces Attributes Dataset,一個(gè)專為人臉屬性識(shí)別和分析設(shè)計(jì)的大規(guī)模數(shù)據(jù)集,由香港中文大學(xué)的研究團(tuán)隊(duì)開(kāi)放提供。它包含超過(guò) 20 萬(wàn)張名人圖像,每張圖像都附有 40 個(gè)二進(jìn)制屬性注釋。這些屬性包括但不限于性別、年齡、發(fā)型、是否佩戴眼鏡等,為研究者提供了豐富的數(shù)據(jù)樣本和詳細(xì)的標(biāo)注信息。

另一位本屆獲獎(jiǎng)?wù)呤?David Forsyth,因其持續(xù)在監(jiān)督計(jì)算機(jī)視覺(jué)界的會(huì)議和期刊方面提供建議和智慧。

David A. Forsyth,出生于南非的美國(guó)計(jì)算機(jī)科學(xué)家,是伊利諾伊大學(xué)厄巴納?香檳分校終身教授、計(jì)算機(jī)視覺(jué)領(lǐng)域頂級(jí)科學(xué)家。現(xiàn)任伊利諾伊州立大學(xué)香檳分校正教授、Fulton-Watson-Copp 計(jì)算機(jī)科學(xué)專業(yè)主席。

Forsyth 發(fā)表了 100 多篇關(guān)于計(jì)算機(jī)視覺(jué)、計(jì)算機(jī)圖形學(xué)和機(jī)器學(xué)習(xí)的論文。他于 2000 年擔(dān)任 IEEE 計(jì)算機(jī)視覺(jué)和模式識(shí)別項(xiàng)目聯(lián)合主席、IEEE CVPR 2006 項(xiàng)目聯(lián)合主席、ECCV 2008 項(xiàng)目聯(lián)合主席、IEEE CVPR 2011 項(xiàng)目聯(lián)合主席、IEEE CVPR 2015 項(xiàng)目聯(lián)合主席和 IEEE CVPR 2024 項(xiàng)目委員顧問(wèn)。他是所有主要計(jì)算機(jī)視覺(jué)國(guó)際會(huì)議的程序委員會(huì)的正式成員。他在國(guó)際計(jì)算機(jī)視覺(jué)會(huì)議和歐洲計(jì)算機(jī)視覺(jué)會(huì)議上獲得了最佳論文獎(jiǎng)。Forsyth 的研究興趣還包括圖形和機(jī)器學(xué)習(xí),他曾擔(dān)任 ICML 2008 的委員會(huì)成員。

- 免責(zé)聲明

- 本文所包含的觀點(diǎn)僅代表作者個(gè)人看法,不代表新火種的觀點(diǎn)。在新火種上獲取的所有信息均不應(yīng)被視為投資建議。新火種對(duì)本文可能提及或鏈接的任何項(xiàng)目不表示認(rèn)可。 交易和投資涉及高風(fēng)險(xiǎn),讀者在采取與本文內(nèi)容相關(guān)的任何行動(dòng)之前,請(qǐng)務(wù)必進(jìn)行充分的盡職調(diào)查。最終的決策應(yīng)該基于您自己的獨(dú)立判斷。新火種不對(duì)因依賴本文觀點(diǎn)而產(chǎn)生的任何金錢損失負(fù)任何責(zé)任。

新火種

2024-11-15

新火種

2024-11-15