決策過程是魔法還是科學(xué)?首個多模態(tài)大模型的可解釋性綜述全面深度剖析

AIxiv專欄是機(jī)器之心發(fā)布學(xué)術(shù)、技術(shù)內(nèi)容的欄目。過去數(shù)年,機(jī)器之心AIxiv專欄接收報(bào)道了2000多篇內(nèi)容,覆蓋全球各大高校與企業(yè)的頂級實(shí)驗(yàn)室,有效促進(jìn)了學(xué)術(shù)交流與傳播。如果您有優(yōu)秀的工作想要分享,歡迎投稿或者聯(lián)系報(bào)道。投稿郵箱:liyazhou@jiqizhixin.com;zhaoyunfeng@jiqizhixin.com

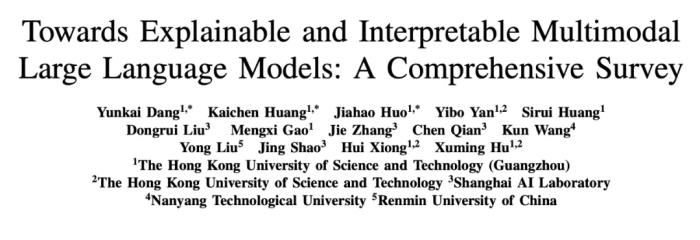

本文由香港科技大學(xué)(廣州)、上海人工智能實(shí)驗(yàn)室、中國人民大學(xué)及南洋理工大學(xué)聯(lián)合完成。主要作者包括香港科技大學(xué)(廣州)研究助理黨運(yùn)楷、黃楷宸、霍家灝(共同一作)、博士生嚴(yán)一博、訪學(xué)博士生黃思睿、上海AI Lab青年研究員劉東瑞等,通訊作者胡旭明為香港科技大學(xué)/香港科技大學(xué)(廣州)助理教授,研究方向?yàn)榭尚糯竽P汀⒍嗄B(tài)大模型等。

本文介紹了首個多模態(tài)大模型(MLLM)可解釋性綜述,由香港科技大學(xué)(廣州)、上海人工智能實(shí)驗(yàn)室、以及中國人民大學(xué)聯(lián)合發(fā)布。文章系統(tǒng)梳理了多模態(tài)大模型可解釋性的研究進(jìn)展,從數(shù)據(jù)層面(輸入輸出、數(shù)據(jù)集、更多模態(tài))、模型層面(詞元、特征、神經(jīng)元、網(wǎng)絡(luò)各層及結(jié)構(gòu))、以及訓(xùn)練與推理過程三個維度進(jìn)行了全面闡述。同時,深入分析了當(dāng)前研究所面臨的核心挑戰(zhàn),并展望了未來的發(fā)展方向。本文旨在揭示多模態(tài)大模型決策邏輯的透明性與可信度,助力讀者把握這一領(lǐng)域的最新前沿動態(tài)。

多模態(tài)大模型可解釋性

近年來,人工智能(AI)的迅猛發(fā)展深刻地改變了各個領(lǐng)域。其中,最具影響力的進(jìn)步之一是大型語言模型(LLM)的出現(xiàn),這些模型在文本生成、翻譯和對話等自然語言任務(wù)中展現(xiàn)出了卓越的理解和生成能力。與此同時,計(jì)算機(jī)視覺(CV)的進(jìn)步使得系統(tǒng)能夠高效地處理和解析復(fù)雜的視覺數(shù)據(jù),推動了目標(biāo)檢測、動作識別和語義分割等任務(wù)的高精度實(shí)現(xiàn)。這些技術(shù)的融合激發(fā)了人們對多模態(tài) AI 的興趣。多模態(tài) AI 旨在整合文本、視覺、音頻和視頻等多種模態(tài),提供更豐富、更全面的理解能力。通過整合多種數(shù)據(jù)源,多模態(tài)大模型在圖文生成、視覺問答、跨模態(tài)檢索和視頻理解等多模態(tài)任務(wù)中展現(xiàn)了先進(jìn)的理解、推理和生成能力。同時,多模態(tài)大模型已在自然語言處理、計(jì)算機(jī)視覺、視頻分析、自動駕駛、醫(yī)療影像和機(jī)器人等領(lǐng)域得到了廣泛應(yīng)用。

然而,隨著多模態(tài)大模型的不斷發(fā)展,一個關(guān)鍵挑戰(zhàn)浮現(xiàn):如何解讀多模態(tài)大模型的決策過程?

多模態(tài)大模型(MLLMs)的飛速發(fā)展引發(fā)了研究者和產(chǎn)業(yè)界對其透明性與可信度的強(qiáng)烈關(guān)注。理解和解釋這些模型的內(nèi)部機(jī)制,不僅關(guān)系到學(xué)術(shù)研究的深入推進(jìn),也直接影響其實(shí)際應(yīng)用的可靠性與安全性。本綜述聚焦于多模態(tài)大模型的可解釋性,從以下三個關(guān)鍵維度展開深入分析:

1. 數(shù)據(jù)的解釋性:數(shù)據(jù)作為模型的輸入,是模型決策的基礎(chǔ)。本部分探討不同模態(tài)的輸入數(shù)據(jù)如何預(yù)處理、對齊和表示,并研究通過擴(kuò)展數(shù)據(jù)集與模態(tài)來增強(qiáng)模型的可解釋性,增強(qiáng)對模型決策的理解。

2. 模型的解釋性:本部分分析模型的關(guān)鍵組成部分,包括詞元、特征、神經(jīng)元、網(wǎng)絡(luò)層次以及整體網(wǎng)絡(luò)結(jié)構(gòu),試圖揭示這些組件在模型決策中的具體作用,從而為模型的透明性提供新的視角。

3. 訓(xùn)練與推理的解釋性:本部分探討模型的訓(xùn)練和推理過程可能影響可解釋性的因素,旨在理解模型的訓(xùn)練和推理過程背后的邏輯。

多模態(tài)大模型可解釋性文章匯總

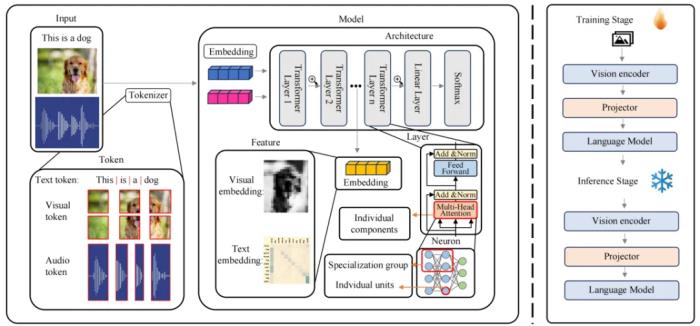

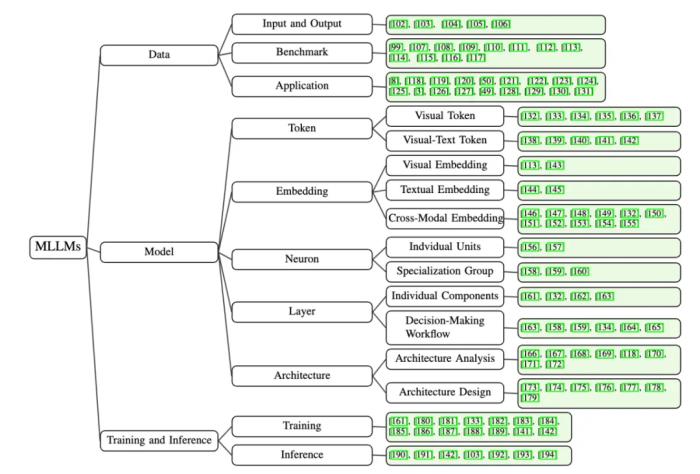

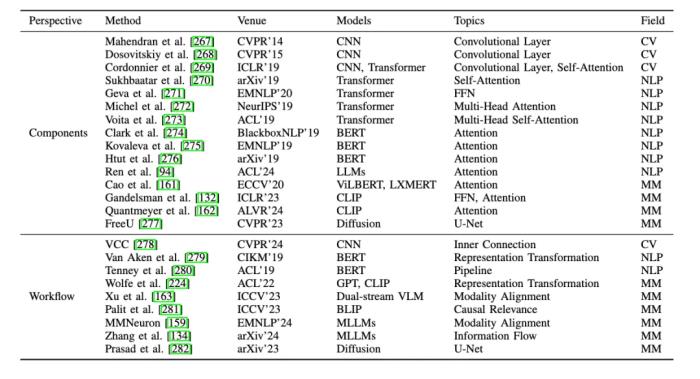

我們將現(xiàn)有的方法分類為三個視角:數(shù)據(jù)(Data)、模型(Model)和訓(xùn)練及推理(Traning & Inference)。具體如下:

1、數(shù)據(jù)視角的可解釋性:從輸入(Input)和輸出(Output)角度出發(fā),研究不同數(shù)據(jù)集(Benchmark)和更多模態(tài)的應(yīng)用(Application),探討如何影響模型的行為與決策透明性。

2、模型視角的可解釋性:我們深入分析了模型內(nèi)部的關(guān)鍵組成部分,重點(diǎn)關(guān)注以下五個維度:

Token:研究視覺詞元(Visual Token)或視覺文本詞元(Visual-textual Token)對模型決策的影響,揭示其在多模態(tài)交互中的作用。Embedding:評估多模態(tài)嵌入 (Visual Embedding, Textual Embedding, Cross-modal Embedding) 如何在模型中進(jìn)行信息融合,并影響決策透明度。Neuron:分析個體神經(jīng)元(Indvidual Units)和神經(jīng)元組 (Specialization Group) 對模型輸出的貢獻(xiàn)。Layer:探討單個網(wǎng)絡(luò)層(Individual Components)和不同網(wǎng)絡(luò)層(Decision-Making Workflow)在模型決策過程中的作用。Architecture:通過對網(wǎng)絡(luò)結(jié)構(gòu)分析(Architecture Analysis)和網(wǎng)絡(luò)結(jié)構(gòu)設(shè)計(jì)(Architecture Design),促進(jìn)模型架構(gòu)的透明度和可理解性。3、訓(xùn)練與推理的可解釋性:我們從訓(xùn)練和推理兩個階段研究多模態(tài)大模型的可解釋性:

訓(xùn)練階段:總結(jié)多模態(tài)大模型預(yù)訓(xùn)練機(jī)制或訓(xùn)練策略,重點(diǎn)討論如何增強(qiáng)多模態(tài)對齊、減少幻覺現(xiàn)象,對提高模型可解釋性。推理階段:研究無需重新訓(xùn)練的情況下,緩解幻覺等問題的方法,如過度信任懲罰機(jī)制和鏈?zhǔn)剿季S推理技術(shù),以提升模型在推理階段的透明性和魯棒性。解碼多模態(tài)大模型

從詞元到網(wǎng)絡(luò)結(jié)構(gòu)的可解釋性全面剖析

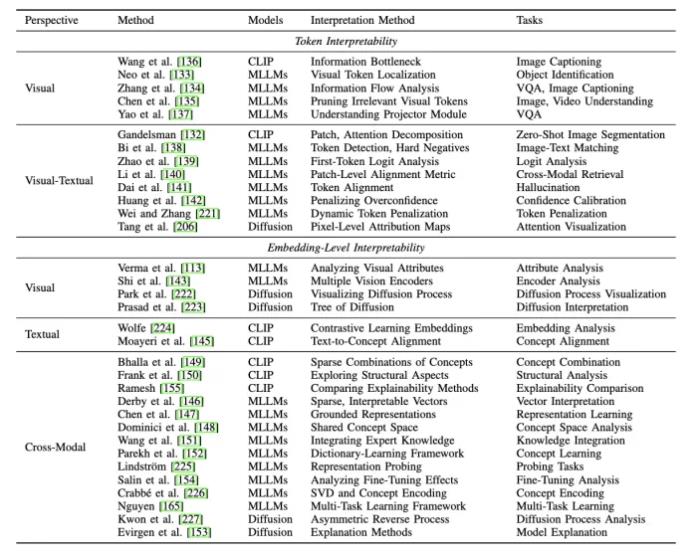

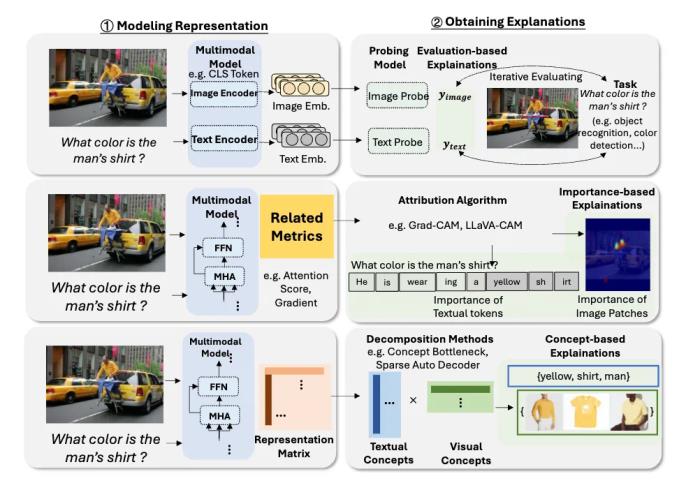

詞元與嵌入(Token and Embedding) 的可解釋性:詞元(Token)和嵌入(Embedding)作為模型處理和表示數(shù)據(jù)的關(guān)鍵單元,對于模型的可解釋性具有重要意義。

詞元研究:我們通過分析視覺詞元 (Visual Token),揭示了模型如何將圖像分解為基本視覺組件,從而理解單個詞元對預(yù)測的影響。同時,通過探索視覺 - 文本詞元 (Visual-Textual Token) 的對齊機(jī)制,揭示其在復(fù)雜任務(wù)(如視覺問答、活動識別)中的影響。嵌入研究:在特征嵌入 (Embedding) 方面,研究聚焦于多模態(tài)特征的表示方式,旨在提升模型的透明度和可解釋性。例如,通過生成稀疏、可解釋的向量,捕捉多模態(tài)的語義信息,進(jìn)一步揭示特征嵌入在多模態(tài)對齊中的作用。

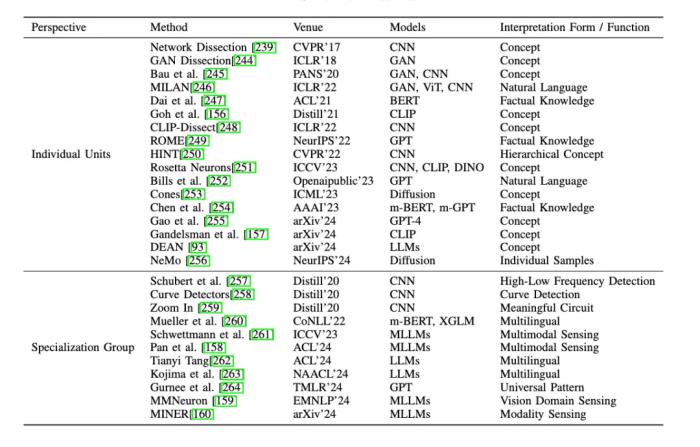

神經(jīng)元 (Neuron) 的可解釋性:神經(jīng)元是多模態(tài)大模型的核心組件,其功能和語義角色的研究對揭示模型內(nèi)部機(jī)制至關(guān)重要。

單個神經(jīng)元的研究:對于單個神經(jīng)元,一些研究通過將單個神經(jīng)元與特定的概念或功能關(guān)聯(lián)起來,發(fā)現(xiàn)能夠同時響應(yīng)視覺和文本概念的神經(jīng)元,為理解多模態(tài)信息整合提供新的視角。神經(jīng)元群體的研究:對于神經(jīng)元群體,研究表明某些神經(jīng)元組可以集體負(fù)責(zé)特定任務(wù),例如檢測圖像中的曲線、識別高低頻特征,或在語言模型中調(diào)節(jié)預(yù)測的不確定性。此外,在多模態(tài)任務(wù)中,神經(jīng)元群體被用來連接文本和圖像特征,提出了新的方法來檢測跨模態(tài)神經(jīng)元,為多模態(tài)信息處理的透明化提供了重要依據(jù)。

層級結(jié)構(gòu) (Layer) 的可解釋性:深度神經(jīng)網(wǎng)絡(luò)由多個層級組成,層級結(jié)構(gòu)的研究揭示了各層在模型決策過程中的作用。

單個層的研究:研究者探索了注意力頭(Attention Heads)、多層感知器(MLP)等層內(nèi)組件對于模型決策的影響。跨層研究:對跨層的整體決策過程進(jìn)行分析,增強(qiáng)跨模態(tài)信息的整合能力。

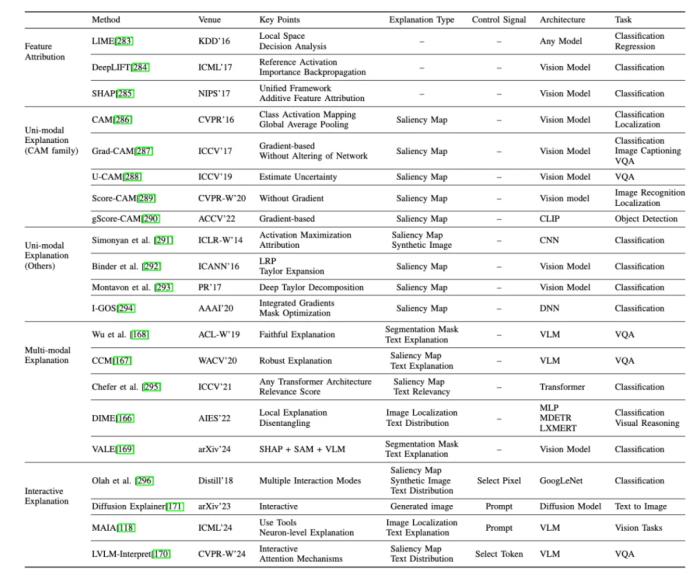

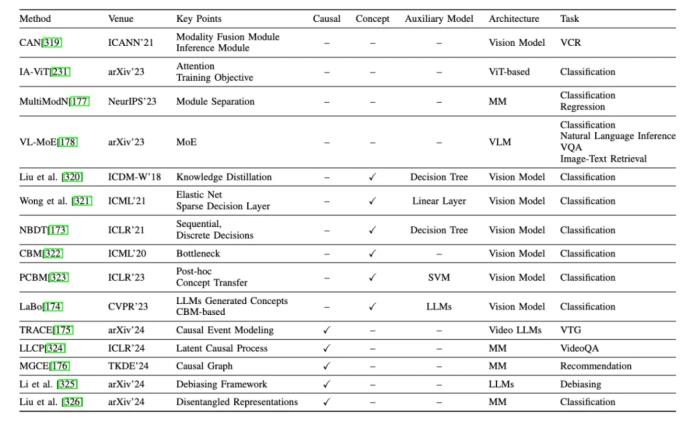

網(wǎng)絡(luò)結(jié)構(gòu)(Architecture)的可解釋性:除了在神經(jīng)元和層級層面探討多模態(tài)大模型的可解釋性外,一些研究還從更粗粒度的網(wǎng)絡(luò)結(jié)構(gòu)層面進(jìn)行探索。與之前聚焦于 MLLMs 具體組件的方法不同,這里從整體網(wǎng)絡(luò)結(jié)構(gòu)視角出發(fā),研究分為網(wǎng)絡(luò)結(jié)構(gòu)分析與設(shè)計(jì)兩大類:

1、網(wǎng)絡(luò)結(jié)構(gòu)分析:這種方法獨(dú)立于任何特定的模型結(jié)構(gòu)或內(nèi)部機(jī)制,包括:

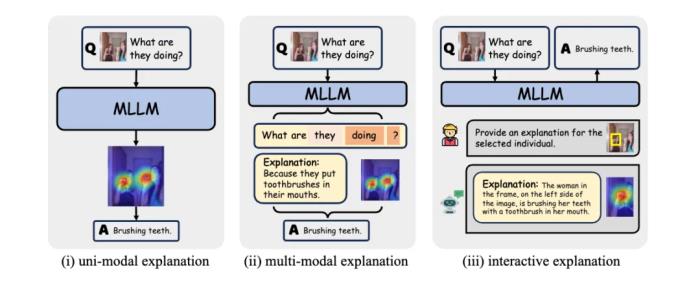

特征歸因:通過為特征分配重要性分?jǐn)?shù),提供基礎(chǔ)性解釋方法,。單模態(tài)解釋:提供單一模態(tài)(主要是圖像模態(tài))的解釋。多模態(tài)解釋:提供多模態(tài)(如圖像和文本結(jié)合)的解釋。交互式解釋:根據(jù)人類的指令或偏好提供解釋的方法。其他:包括通過模型比較提供探究的網(wǎng)絡(luò)結(jié)構(gòu)級模型分析方法等。2、網(wǎng)絡(luò)結(jié)構(gòu)設(shè)計(jì):這類方法通過在模型網(wǎng)絡(luò)結(jié)構(gòu)中引入高度可解釋的模塊來增強(qiáng)模型的可解釋性。專注于特定的模型類型,利用獨(dú)特的結(jié)構(gòu)或參數(shù)來探索內(nèi)部機(jī)制。這一類包括:

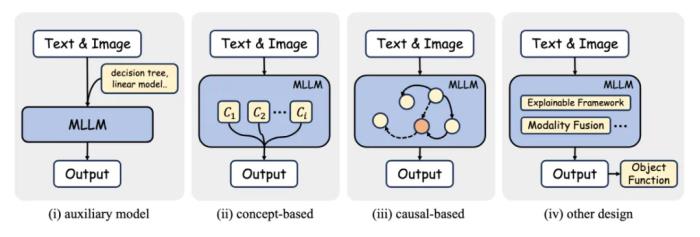

替代模型:使用更簡單的模型,如線性模型或決策樹,來近似復(fù)雜模型的性能。基于概念的方法:使模型能夠?qū)W習(xí)人類可理解的概念,然后使用這些概念進(jìn)行預(yù)測。基于因果的方法:在網(wǎng)絡(luò)結(jié)構(gòu)設(shè)計(jì)中融入因果學(xué)習(xí)的概念,如因果推理或因果框架。其他:包括網(wǎng)絡(luò)結(jié)構(gòu)中無法歸類到上述類別的其他模塊相關(guān)的方法。

訓(xùn)練和推理(Training & Inference)的可解釋性:在多模態(tài)大模型(MLLMs)的訓(xùn)練與推理中,通過優(yōu)化策略提升模型的透明性:

訓(xùn)練階段:通過合理的預(yù)訓(xùn)練策略優(yōu)化多模態(tài)對齊,揭示跨模態(tài)關(guān)系,同時減少生成過程中的偏差與幻覺現(xiàn)象,為模型魯棒性提供支持。推理階段:鏈?zhǔn)剿季S推理和上下文學(xué)習(xí)技術(shù)為實(shí)現(xiàn)結(jié)構(gòu)化、可解釋的輸出提供了新的可能性。這些方法有效緩解了模型在生成內(nèi)容中的幻覺問題,有效提升了模型輸出的可信度。挑戰(zhàn)與機(jī)遇并存

多模態(tài)大模型的可解釋性未來展望?

隨著多模態(tài)大模型(MLLMs)在學(xué)術(shù)與工業(yè)界的廣泛應(yīng)用,可解釋性領(lǐng)域迎來了機(jī)遇與挑戰(zhàn)并存的未來發(fā)展方向。以下是我們列出一些未來的展望:

數(shù)據(jù)集與更多模態(tài)的融合:改進(jìn)多模態(tài)數(shù)據(jù)的表示和基準(zhǔn)測試,開發(fā)標(biāo)準(zhǔn)化的預(yù)處理和標(biāo)注流程,確保文本、圖像、視頻和音頻的一致性表達(dá)。同時,建立多領(lǐng)域、多語言、多模態(tài)的評估標(biāo)準(zhǔn),全面測試模型的能力。多模態(tài)嵌入與特征表示:加強(qiáng)對模型預(yù)測結(jié)果的歸因,探索動態(tài)詞元重要性機(jī)制,確保結(jié)果與人類表達(dá)方式一致。通過優(yōu)化視覺與文本特征的對齊,構(gòu)建統(tǒng)一框架,揭示模型處理多模態(tài)信息的內(nèi)在機(jī)制。模型結(jié)構(gòu)的可解釋性:聚焦神經(jīng)元間的對齊機(jī)制和低成本的模型編輯方法,解析多模態(tài)信息處理中的關(guān)鍵內(nèi)部機(jī)制。同時,探索視覺、音頻等模態(tài)向文本嵌入空間對齊的過程,為跨模態(tài)理解提供支持。模型架構(gòu)的透明化:改進(jìn)架構(gòu)設(shè)計(jì),深入分析不同模塊在跨模態(tài)信息處理中的作用,揭示從模態(tài)輸入到集成表示的全流程信息流動。這將提升模型的魯棒性與信任度,并為實(shí)際應(yīng)用提供更可靠的支持。訓(xùn)練與推理的統(tǒng)一解釋框架:在訓(xùn)練階段優(yōu)先考慮可解釋性和與人類理解的對齊,推理階段提供實(shí)時、任務(wù)適配的可解釋結(jié)果。通過建立覆蓋訓(xùn)練與推理的統(tǒng)一評估基準(zhǔn),開發(fā)出透明、可靠且高性能的多模態(tài)系統(tǒng)。未來的研究不僅需要從技術(shù)層面推動多模態(tài)大模型的可解釋性,還需注重其在人類交互和實(shí)際應(yīng)用中的落地,為模型的透明性、可信性、魯棒性和公平性提供堅(jiān)實(shí)保障。

- 免責(zé)聲明

- 本文所包含的觀點(diǎn)僅代表作者個人看法,不代表新火種的觀點(diǎn)。在新火種上獲取的所有信息均不應(yīng)被視為投資建議。新火種對本文可能提及或鏈接的任何項(xiàng)目不表示認(rèn)可。 交易和投資涉及高風(fēng)險(xiǎn),讀者在采取與本文內(nèi)容相關(guān)的任何行動之前,請務(wù)必進(jìn)行充分的盡職調(diào)查。最終的決策應(yīng)該基于您自己的獨(dú)立判斷。新火種不對因依賴本文觀點(diǎn)而產(chǎn)生的任何金錢損失負(fù)任何責(zé)任。

新火種

2024-12-18

新火種

2024-12-18