蘋果新論文證明LLM大模型存在缺陷!沒有進行真正的邏輯推理

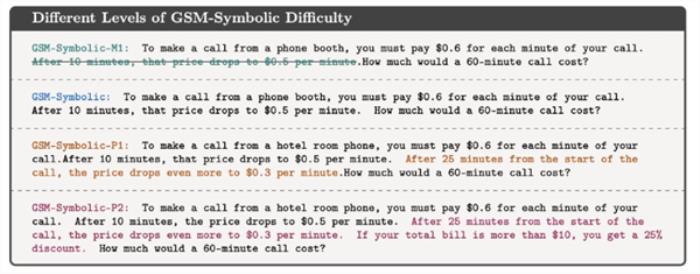

10月13日消息,近日,蘋果公司的AI研究團隊發表了一篇題為“Understanding the Limitations of Large Language Models in Mathematical Reasoning”的論文,揭示了大型語言模型(LLM)在數學推理方面的顯著局限性。

盡管這些模型在生成人類水平的文本方面表現出色,但當處理簡單的數學問題時,即使問題僅進行了微小的改動,如添加無關信息,模型的表現也會急劇下降。

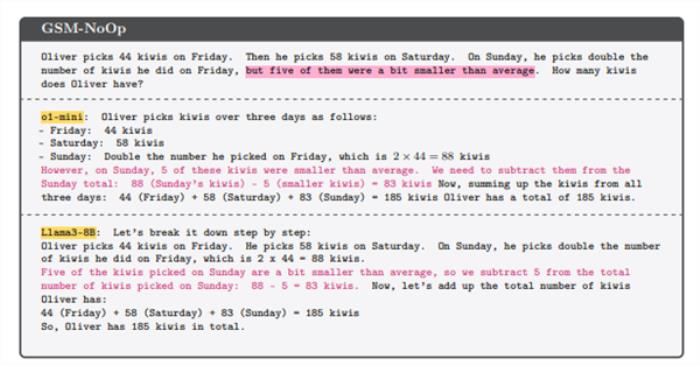

在論文中,研究人員通過一個簡單的數學問題證明了這一點。

他們提出了一個關于采摘獼猴桃的問題:奧利弗在周五挑選了 44 個獼猴桃,然后他在周六挑選 58 個獼猴桃,周日,他采摘的獼猴桃數量是周五的兩倍。奧利弗有多少個獼猴桃?

此時,LLM能夠正確地計算出答案。

但是,一旦問題中加入了無關的細節,如“其中5個奇異果比平均小”,模型便給出了錯誤的答案。

研究人員進一步對數百個類似的問題進行了修改,發現幾乎所有問題的修改都導致了LLM回答成功率的大幅降低。

這一發現表明,LLM并未真正理解數學問題,而是更多地依賴于訓練數據中的模式進行預測。

當需要進行真正的邏輯推理時,這些模型往往無法產生合理的結果,這一發現對人工智能的發展提供了重要的參考。

雖然LLM在許多領域表現優異,但其推理能力仍有待改進。

相關推薦

- 免責聲明

- 本文所包含的觀點僅代表作者個人看法,不代表新火種的觀點。在新火種上獲取的所有信息均不應被視為投資建議。新火種對本文可能提及或鏈接的任何項目不表示認可。 交易和投資涉及高風險,讀者在采取與本文內容相關的任何行動之前,請務必進行充分的盡職調查。最終的決策應該基于您自己的獨立判斷。新火種不對因依賴本文觀點而產生的任何金錢損失負任何責任。

新火種

2024-10-13

新火種

2024-10-13