GeminiPro還不如GPT-3.5,CMU深入對比研究:保證公平透明可重復

谷歌Gemini實力到底如何?卡耐基梅隆大學來了場專業客觀第三方比較。

為保證公平,所有模型使用相同的提示和生成參數,并且提供可重復的代碼和完全透明的結果。

不會像谷歌官方發布會那樣,用CoT@32對比5-shot了。

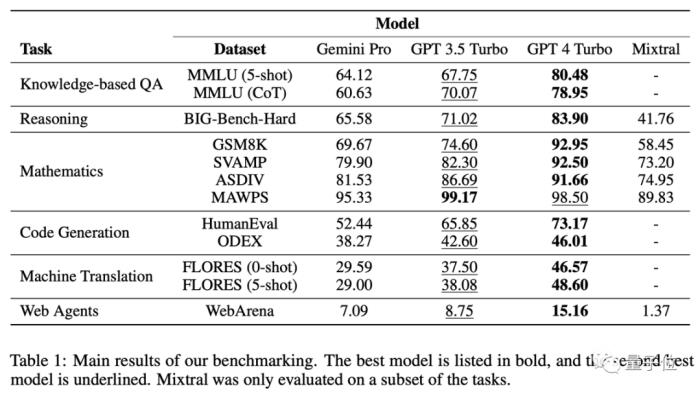

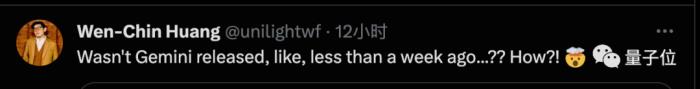

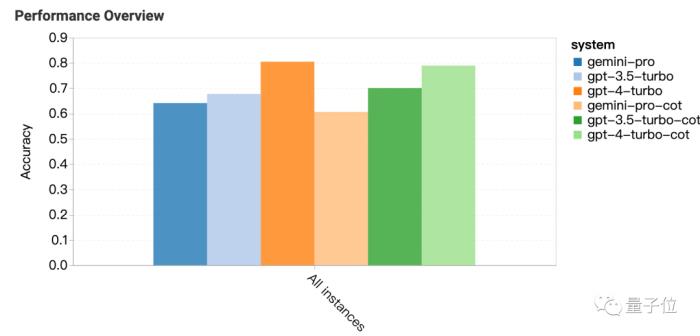

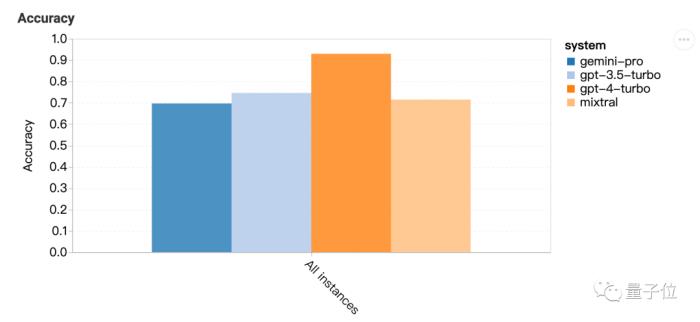

一句話結果:Gemini Pro版本接近但略遜于GPT-3.5 Turbo,GPT-4還是遙遙領先。

在深入分析中還發現Gemini一些奇怪特性,比如選擇題喜歡選D……

不少研究者表示,太卷了,Gemini剛發布沒幾天就搞出這么詳細的測試。

六大任務深入測試

這項測試具體比較了6大任務,分別選用相應的數據集:

知識問答:MMLU推理:BIG-Bench Hard數學:GSM8k、SVAMP、ASDIV、MAWPS代碼:HumanEval、ODEX翻譯:FLORES上網沖浪:WebArena知識問答:喜歡選D從結果可以看出,使用思維鏈提示在這類任務上不一定能帶來提升。

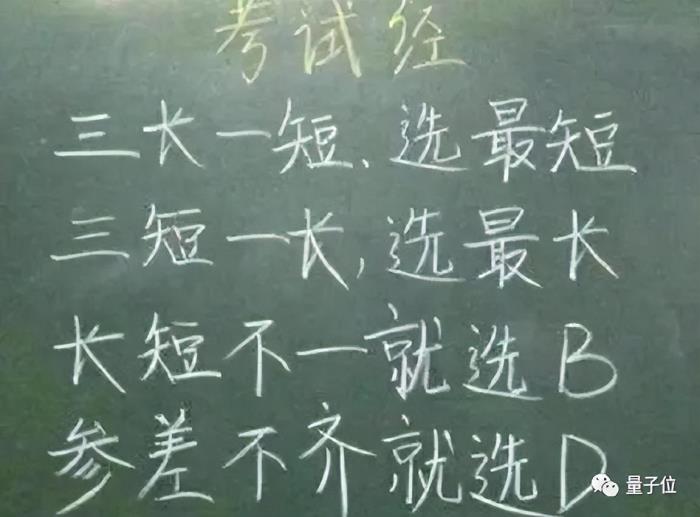

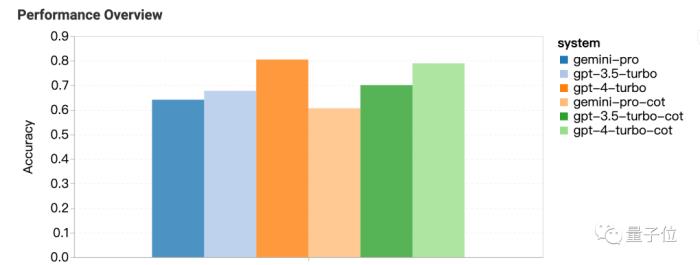

MMLU數據集里都是多選題,對結果進一步分析還發現奇怪現象:Gemini更喜歡選D。

GPT系列在4個選項上的分布就要平衡很多,團隊提出這可能是Gemini沒針對多選題做大量指令微調造成的。

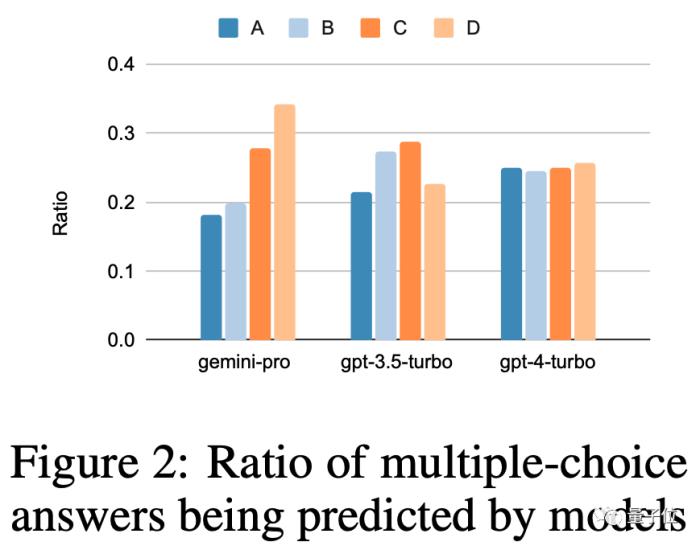

另外Gemini的安全過濾比較嚴重,涉及道德問題只回答了85%,到了人類性行為相關問題只回答了28%。

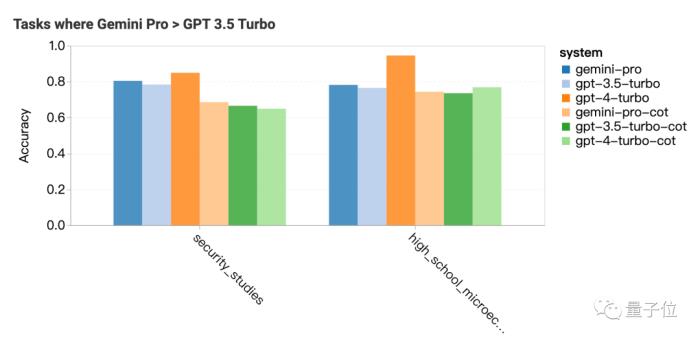

Gemini Pro表現超過GPT-3.5的兩個科目是安全研究和高中微觀經濟學,但差距也不大,團隊表示分析不出來什么特別的。

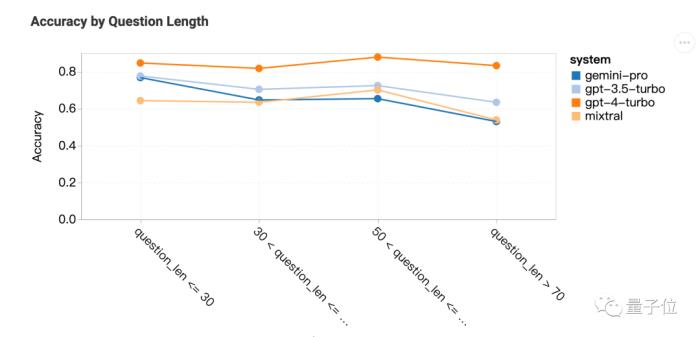

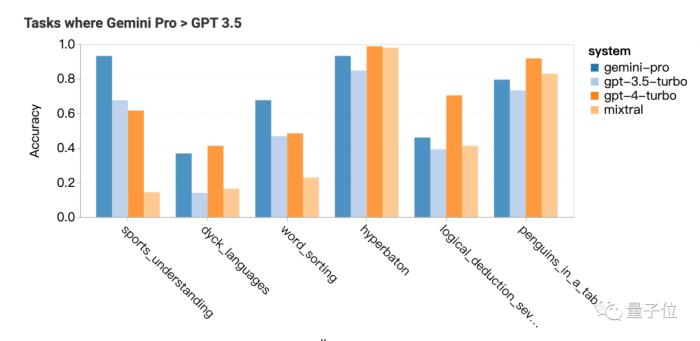

推理:長問題不擅長

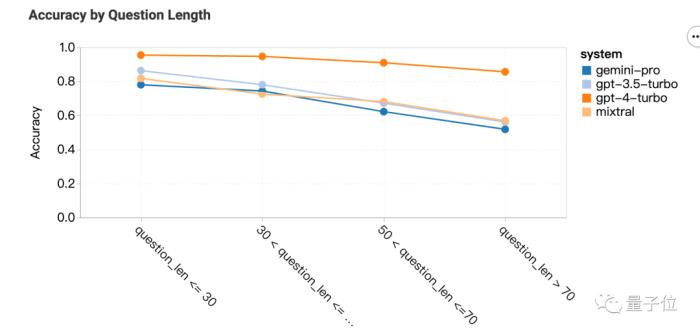

Gemini Pro在更長、更復雜的問題上表現不佳,而GPT系列對此更穩健。

GPT-4 Turbo尤其如此,即使在較長的問題上也幾乎沒有性能下降,表明它具有理解復雜問題的強大能力。

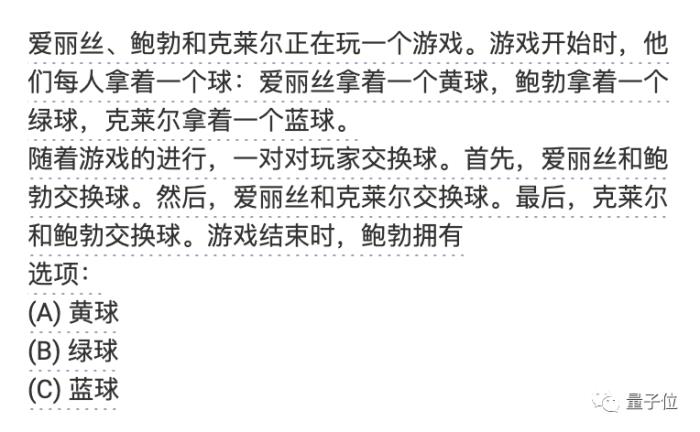

如果按問題類型來分析,Gemini特別不擅長“tracking_shuffled_objects”這類問題,也就人們交換物品,最后讓AI判斷誰擁有哪些物品。

Gemini比較擅長的任務是,需要世界知識的體育運動理解、操作符號堆棧、按字母順序排序單詞,解析表格。

數學:復雜任務反超

這一次問題本身太長Gemini Pro和GPT-3.5表現就一起下降,只有GPT-4還能保持一貫水準。

但使用的思維鏈提示長度最長時,Gemini反超GPT-3.5。

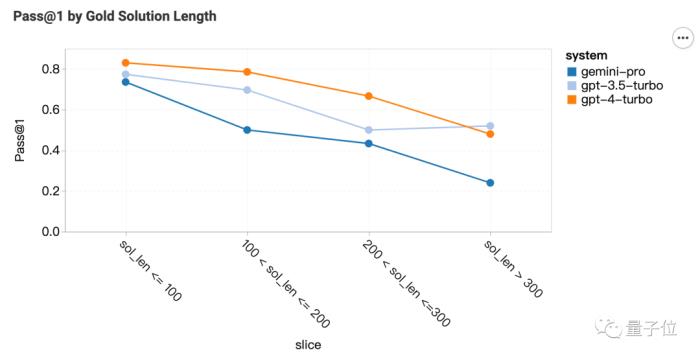

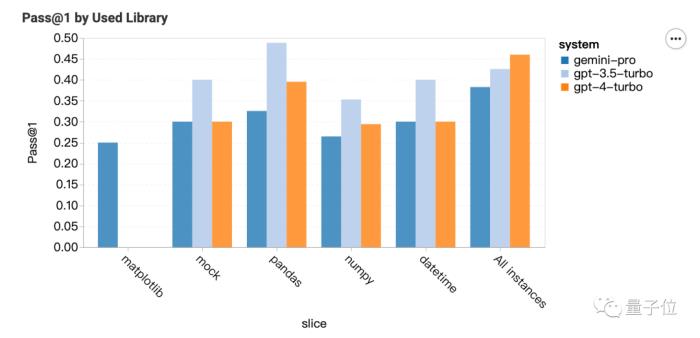

代碼:擅長matplotlib

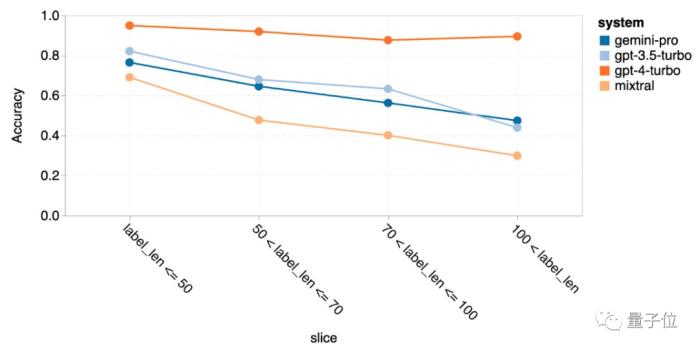

對于代碼問題,Gemini在參考答案長的問題上表現很差。

按調用的庫來分類,GPT系列在大多數類型更強,但matplotlib就完全不行。

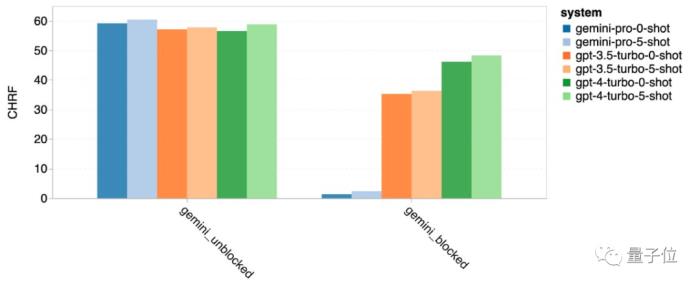

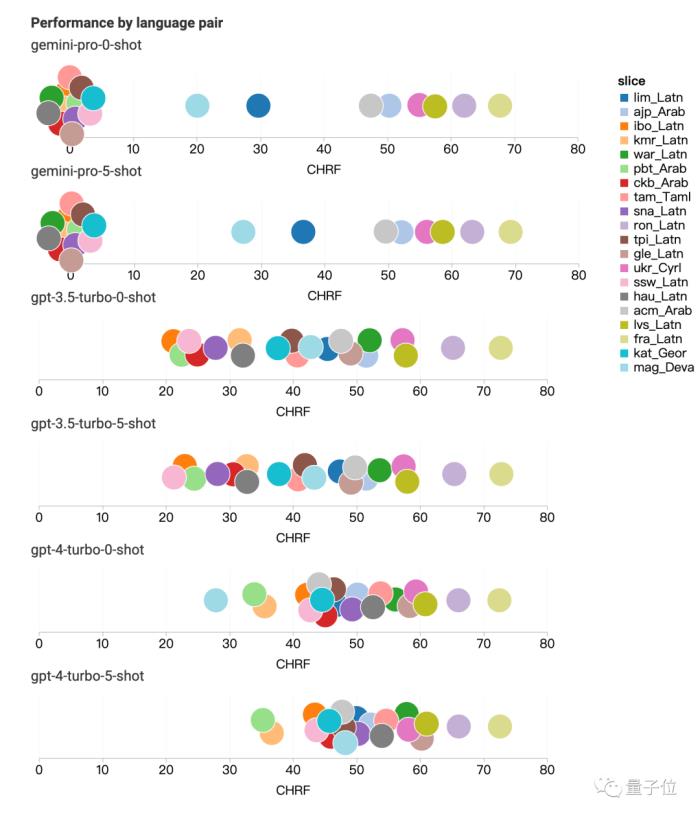

翻譯:只要回答了,質量就很高

翻譯任務上,有12種類型Gemini拒絕回答,但是只要回答了的翻譯質量都很高,整體表現超過GPT-4。

Gemini拒絕翻譯的類型主要涉及拉丁語、阿拉伯語。

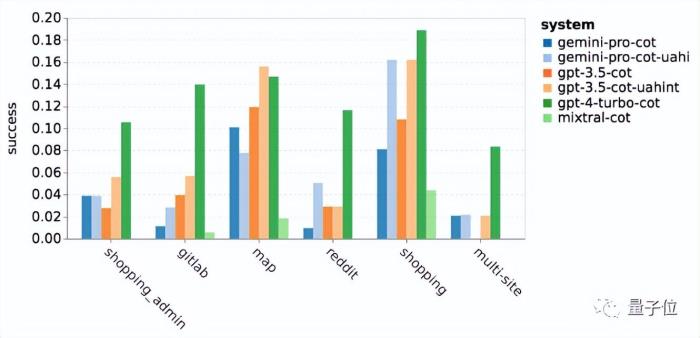

網絡導航:擅長跨站點沖浪

WebArena給AI模擬了一個互聯網環境,包括電子商務、社交論壇、GitLab協作開發、內容管理系統和在線地圖等,需要AI查找信息或跨站點完成任務。

Gemini在整體表現不如GPT-3.5 Turbo,但在跨多個站點的任務中表現稍好。

網友:但是它免費啊

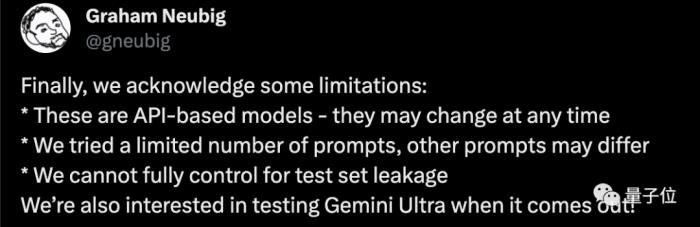

最后,CMU副教授Graham Neubig承認了這項研究的一些局限性。

基于API的模型行為可能隨時變化只嘗試了有限數量的提示,對不同模型來說適用的提示詞可能不一樣無法控制測試集是否泄露

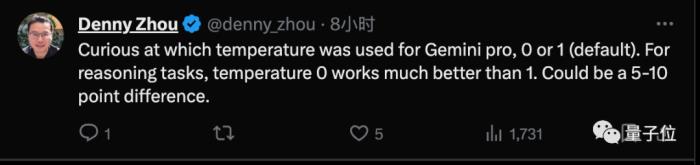

谷歌大模型推理團隊負責人周登勇指出,對于推理任務把Gemini的溫度設置為0可以提高5-10個百分點。

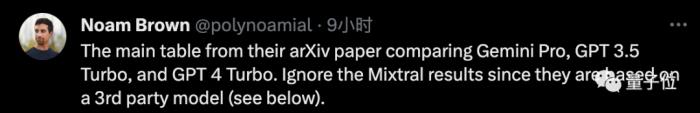

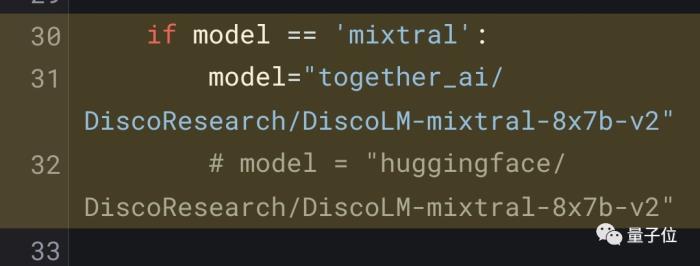

這項測試中除了Gemini與GPT系列,還搭上了最近很受關注的開源MoE模型Mixtral。

不過強化學習專家Noam Brown認為可以忽略其中Mixtral的結果,因為用的是第三方API而非官方實現。

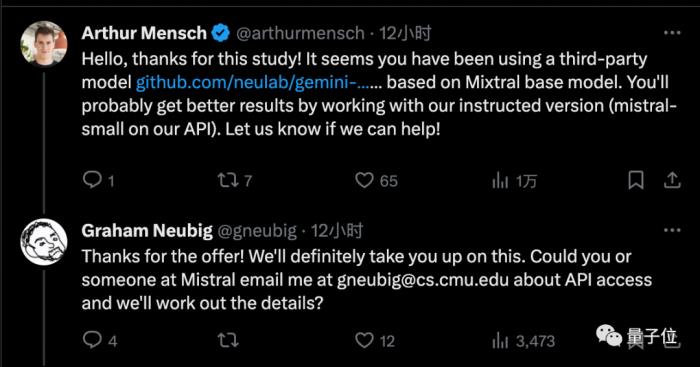

Mistral AI創始人也來給團隊提供了官方版調用權限,認為能得到一個更好的結果。

總得來,雖然Gemini Pro還是不如GPT-3.5,但是它勝在每分鐘調用不超過60次就免費。

所以還是有不少個人開發者已經轉換了陣營。

目前Gemini最高版本Ultra版尚未發布,到時CMU團隊也有意繼續這項研究。

你覺得Gemini Ultra能達到GPT-4水平么?

- 免責聲明

- 本文所包含的觀點僅代表作者個人看法,不代表新火種的觀點。在新火種上獲取的所有信息均不應被視為投資建議。新火種對本文可能提及或鏈接的任何項目不表示認可。 交易和投資涉及高風險,讀者在采取與本文內容相關的任何行動之前,請務必進行充分的盡職調查。最終的決策應該基于您自己的獨立判斷。新火種不對因依賴本文觀點而產生的任何金錢損失負任何責任。

新火種

2023-12-21

新火種

2023-12-21