Kimi視覺思考模型k1發布:數理化超越OpenAIo1、GPT-4o

12月16日消息,今日,月之暗面國產大模型Kimi發布視覺思考模型k1,k1基于強化學習技術打造,原生支持端到端圖像理解和思維鏈技術,并將能力擴展到數學之外的更多基礎科學領域。

k1已陸續上線最新版Kimi智能助手的Android和iPhoneAPP以及網頁版kimi.com。

在最新版手機APP或網頁版Kimi+頁面找到Kimi視覺思考版,即可拍照或傳圖體驗。

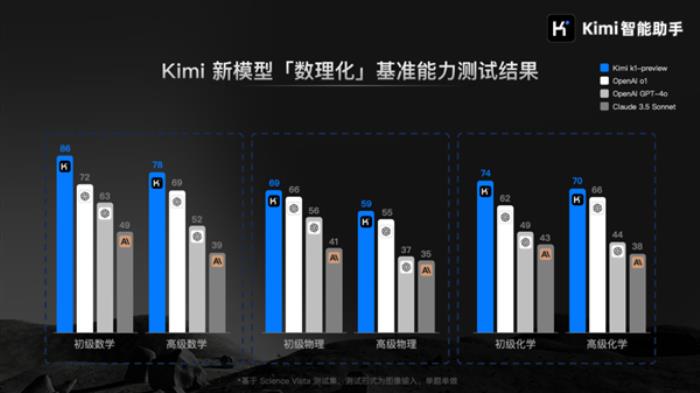

據了解,在數學、物理、化學等基礎科學學科的基準能力測試中,初代k1模型的表現超過了全球標桿模型OpenAI o1、GPT-4o以及Claude 3.5 Sonnet。

官方表示,K1模型真正意義上實現了端到端的圖像理解和思考能力,模型可以直接處理用戶輸入的圖像信息并進行思考得出答案,不需要借助外部的OCR或額外視覺模型進行信息處理。

從模型訓練的角度看,k1的訓練分為兩個階段,先通過預訓練得到基礎模型,再在基礎模型上進行強化學習后訓練。

k1的基礎模型重點優化了字符識別能力,在OCRBench上得到903分的當前最好(state-of-the-art)結果,在MathVista-testmini、MMMU-val 和DocVQA基準測試集上分數分別為69.1、66.7和96.9,處于全球第一梯隊水平。

據介紹,k1的強化學習后訓練在數據質量和學習效率方面做了進一步優化,在強化學習的規模化(scaling)上取得了新的突破,這是k1視覺推理模型在基準測試中取得行業領先成績的最關鍵原因。

月之暗面坦言,在內部測試中也發現了一些k1視覺思考模型存在的局限性,例如在分布外(out-of-distribution)的泛化、在更復雜問題上的成功率、在更多噪聲場景的準確率、多輪問答效果等方面,有很大提升空間。

在一些場景和泛化能力上,k1模型與OpenAI的o1系列模型相比仍有差距。

- 免責聲明

- 本文所包含的觀點僅代表作者個人看法,不代表新火種的觀點。在新火種上獲取的所有信息均不應被視為投資建議。新火種對本文可能提及或鏈接的任何項目不表示認可。 交易和投資涉及高風險,讀者在采取與本文內容相關的任何行動之前,請務必進行充分的盡職調查。最終的決策應該基于您自己的獨立判斷。新火種不對因依賴本文觀點而產生的任何金錢損失負任何責任。

新火種

2024-12-17

新火種

2024-12-17