GAN作者追憶往事:論文是DDL前一周開始寫的,最初在NeurIPS大會無人問津

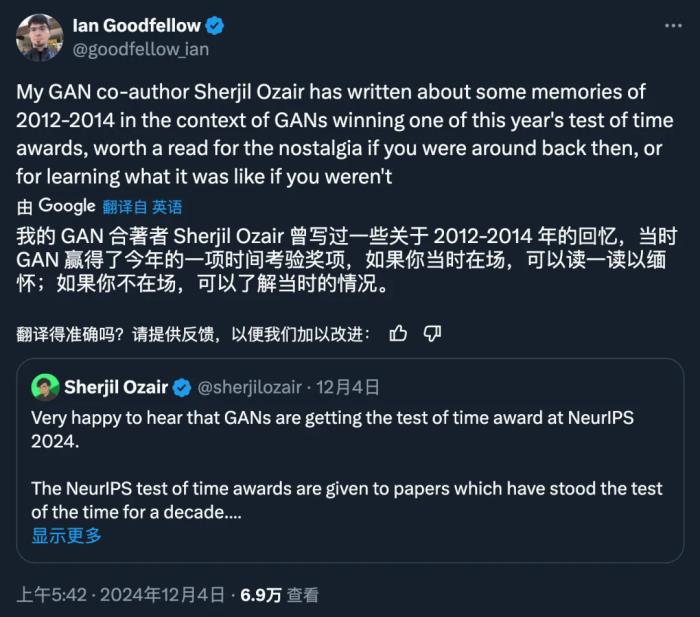

上個月底,NeurIPS 官方公布了 2024 年度時間檢驗獎,而且破天荒地同時頒給了兩篇論文。一篇是 Ilya Sutskever 的 Seq2Seq,另一篇是一篇是 Ian Goodfellow 的生成對抗網絡(GAN)。 論文地址:https://arxiv.org/pdf/1406.2661作者:Ian Goodfellow, Jean Pouget-Abadie, Mehdi Mirza, Bing Xu, David Warde-Farley, Sherjil Ozair, Aaron Courville, Yoshua Bengio機構:蒙特利爾大學彈指一揮間,距離 GAN 被提出竟然已經過了十年了。截至 NeurIPS 揭曉獎項時,「GAN」的論文已被引用超過 85000 次,這篇生成模型領域的奠基之作,在過去 10 年間推動了眾多研究進展。除了在學術界的影響,它還使生成模型在視覺數據及其他領域的應用中產生了深遠影響。《Generative Adversarial Nets》,作者陣容非常豪華,AI 圈知名大佬 Ian J. Goodfellow 、 Yoshua Bengio 等都在內。今天,GAN 作者之一 Sherjil Ozair 在 X 平臺發布長文,追憶了十年前的往事。

論文地址:https://arxiv.org/pdf/1406.2661作者:Ian Goodfellow, Jean Pouget-Abadie, Mehdi Mirza, Bing Xu, David Warde-Farley, Sherjil Ozair, Aaron Courville, Yoshua Bengio機構:蒙特利爾大學彈指一揮間,距離 GAN 被提出竟然已經過了十年了。截至 NeurIPS 揭曉獎項時,「GAN」的論文已被引用超過 85000 次,這篇生成模型領域的奠基之作,在過去 10 年間推動了眾多研究進展。除了在學術界的影響,它還使生成模型在視覺數據及其他領域的應用中產生了深遠影響。《Generative Adversarial Nets》,作者陣容非常豪華,AI 圈知名大佬 Ian J. Goodfellow 、 Yoshua Bengio 等都在內。今天,GAN 作者之一 Sherjil Ozair 在 X 平臺發布長文,追憶了十年前的往事。

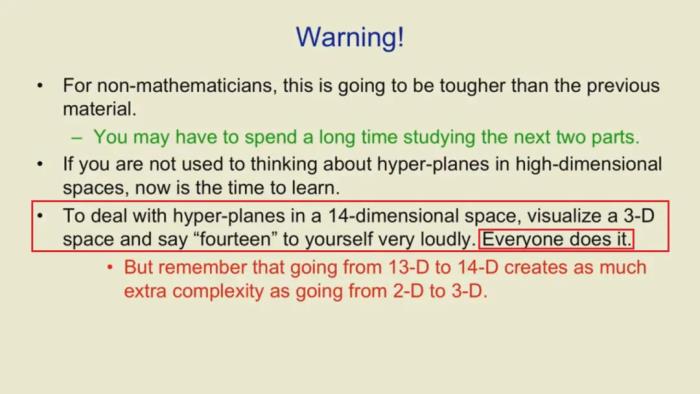

很高興聽到 GAN 在 NeurIPS 2024 上獲得時間檢驗獎。NeurIPS 時間檢驗獎授予那些經受住了十年時間考驗的論文。我花了一些時間來回憶 GAN 是如何誕生的,以及人工智能在過去十年中是如何發展的。2012 年初,當我還是印度理工學院德里分校的一名本科生時,我在 Coursera 上發現了一門深度學習課程,由 Geoffrey Hinton 講授。深度學習(在當時)是機器學習的一個邊緣和小眾子領域,它有望更加「端到端」并且更加受人腦啟發。課程非常棒。不僅很好地解釋了深度學習的原理,還充滿了 Hinton 古怪的英式幽默和標新立異的思維。例如,他建議我們把高維空間可視化。

出于對了解更多信息的好奇和興奮,我開始仔細閱讀我能找到的所有內容,當時這些都是由少數偉大研究人員發表的學術論文,例如 Yoshua Bengio,其中許多內容由他的實驗室網站 http://deeplearning.net 維護。

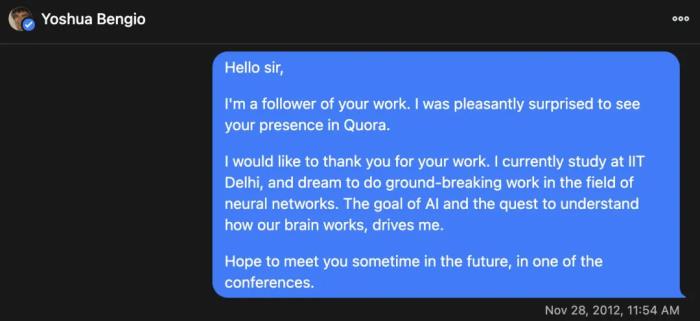

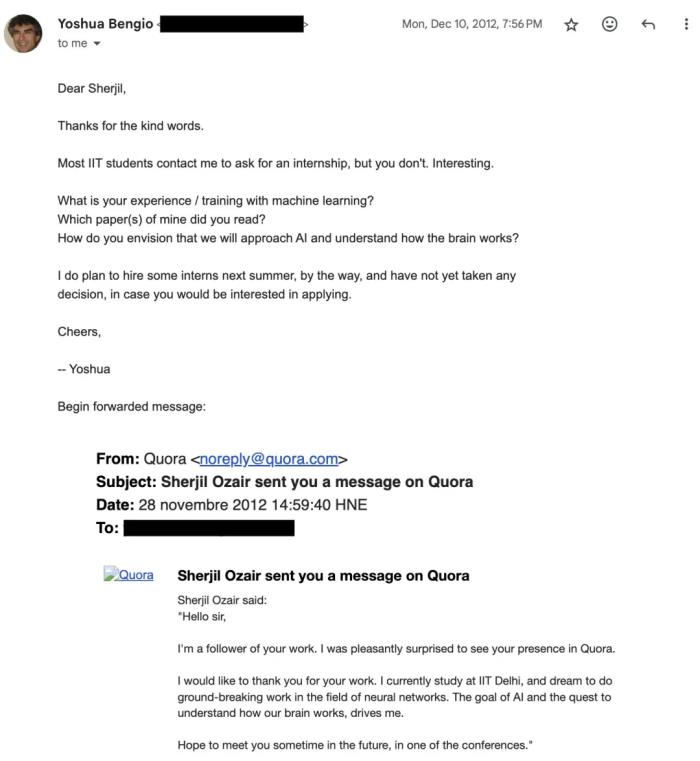

2012 年,Yoshua 經常在 Quora 上回答有關深度學習的問題。我衷心感謝他幫助像我這樣的年輕本科生理解深度學習。

我申請在他的實驗室實習,并且非常驚喜地收到了回復和邀請!這是一次「與命運的幽會」,當時我對這次即將展開的交流旅程的意義和影響只有一絲絲了解。我非常感謝并感謝 Yoshua Bengio 為世界和我所做的一切。

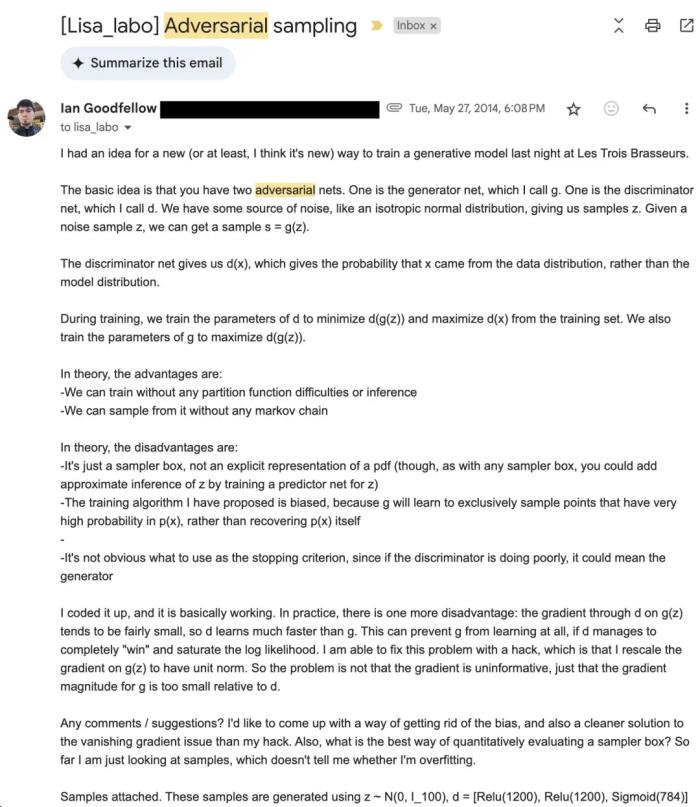

我參加面試并拿到了 offer。2014 年夏天,我原本打算在 Yoshua 的實驗室 (LISA) 實習。2014 年 5 月,我飛往蒙特利爾,并前往實驗室。Yoshua 一看到我,立刻就把我拉進了一個房間。房間里還有 Ian Goodfellow 和 Aaron Courville。Yoshua 繼續解釋他一直在思考的一個新想法。他設想了一個確定性生成器網絡 g,該網絡僅在輸入 z 中具有隨機噪聲。該網絡的輸出 x = g (z) 是某個分布 p (x) 的樣本,可以是任何東西:圖像、音頻、文本。他強調這就是我們需要訓練的。但怎么做呢?在這種「隱式」網絡中,概率 p (x) 在任何地方都不是顯式的。他說,我們應該對生成器的輸出(生成的分布)和某個樣本數據集(也可以是圖像、音頻等)進行「雙樣本分布匹配」。但如何進行分布匹配仍不清楚。作為一名年輕幼稚的本科生,我提出了矩匹配(moment matching),但我們知道矩匹配很可能無法擴展到高維數據。小組里還討論了其他想法,但都不太樂觀。但是,Yoshua 對于訓練一個確定性噪聲消耗采樣生成器神經網絡的愿景和熱情是明確的,也是鼓舞人心的。小組決定進一步思考這個問題。就在 Les Trois Brasseurs 實驗室的一次晚宴上,Ian Goodfellow 被一個在當時看來近乎無稽之談的想法打動了:「如果你能讓另一個神經網絡充當判別器呢?」在這一刻,新的前沿被開拓出來了。當時,神經網絡的訓練非常「普通」:你建立一個主神經網絡,輸入數據,得到預測結果,應用數學損失函數,然后使用梯度下降法優化這個網絡。Ian 的想法是將損失函數設想為一個學習型神經網絡。另一個判別器神經網絡提供損失和梯度來訓練生成器神經網絡,而不是優化一個固定的方法損失。懷疑是很自然的:怎么不會全部崩潰為退化輸出?雞生蛋蛋生雞的困境比比皆是。判別器從何而來?但 Ian 對此也有自己的想法。判別器和生成器要進行零和博弈,生成器要努力做到與數據無差別,而判別器要努力弄清顯示的是生成樣本還是真實樣本。或許,這可行?第二天,實驗室的每個人都收到了這封郵件:

在一個晚上的編碼和運行實驗中,Ian 使第一個生成式對抗網開始工作。這些是 MNIST 上的第一批樣本。

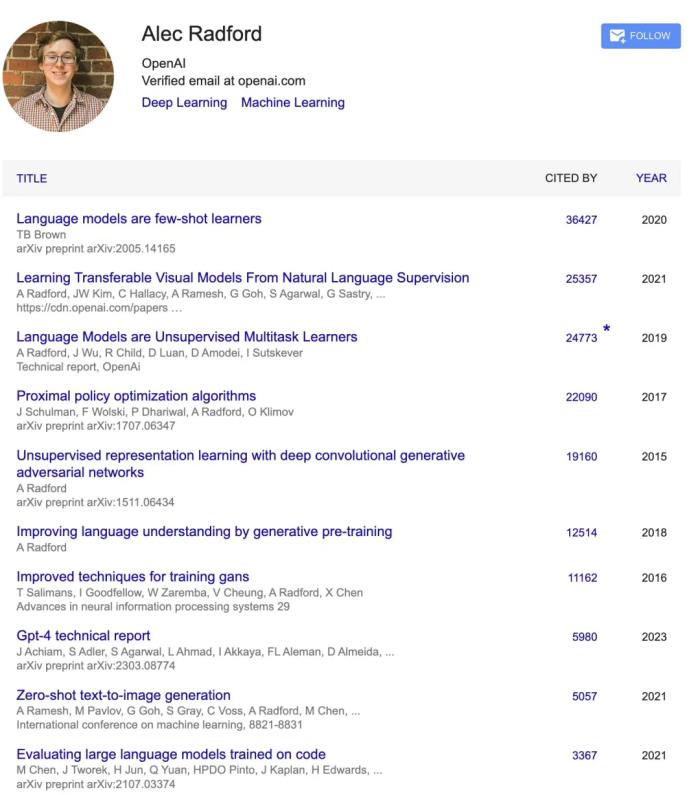

我當時正在研究類似的東西,用非神經判別器進行訓練,但效果遠遠不夠。我決定幫助 Ian 開發 GAN。當時,NeurIPS 2014 的提交截止日期只剩一周了。我們決定,如果我們能抓緊時間,我們就能提交一篇論文。在接下來的幾天里,我們設立了評估標準來與現有的生成模型進行比較,嘗試了不同的架構、噪聲函數和博弈公式。Jean、Yoshua 和我發現了生成對抗網絡(GAN)的博弈是收斂的,并且在均衡狀態下最小化了 JS 散度(Jensen-Shannon Divergence)。我們克服了重重困難,向 NeurIPS 提交了一篇論文,其中包含了我們上一周完成的所有工作。GAN 作為 posted presentation 被接受。我記得,在我們興奮不已的同時,也知道 GAN 的訓練動態是出了名的不穩定。大多數合著者開始研究其他模型架構,試圖解決我們在 GAN 上發現的問題。GAN 論文在 12 月份進行了展示,但大部分時間都是被忽視的。幾個月后的 2015 年 8 月,Alec Radford 開始發布他一直在玩的卷積 GAN 的樣本。沒錯,這就是幾乎是 OpenAI 所有突破的幕后功臣 Alec Radford。2015 年,他正在搗鼓卷積網絡、BatchNorm 和 GAN。

我無法客觀地描述 DCGAN 之后人們對 GAN 興趣的激增。但我想強調的是,GAN 的發展如何被恰當地用作人工智能整體進步的象征。以前,大家會用下面這張圖表達圖像生成領域的突破性演變,但現在已經過時了,因為現在的圖像生成模型已經能夠生成百萬像素的圖片,甚至電影。

至于我的個人經歷,GAN 作為我的第一篇學術論文既是福音也是詛咒。一位 DeepMind 研究員曾開玩笑說,我可能已經完成了我最偉大的工作,所以我還不如退休。人們常常誤以為當前的技術突破是最終的創新,我們總是傾向于認為「就是這樣,這是最后的發明」。但事實并非如此。CNN 感覺像是最后的發明,但事實并非如此。GAN 感覺像是最后的發明,也非如此。LSTM 同樣也是。還有 ResNets、DQN、AlphaGo、AlphaZero、MuZero 等等,這些都不是最后的發明。事后看來,「這是最后的發明」總是有點滑稽。想想現在,Transformer 和大型語言模型現在被認為是最后一項發明,但并不是。我最近離開了前沿人工智能實驗室,創辦了一家公司,打造一些非常棒的東西。我將很快分享更多關于這方面的信息。敬請期待。對于獲得 NeurIPS 時間檢驗獎的那篇論文《Generative Adversarial Nets》,我非常感謝 Ian Goodfellow, Jean Pouget-Abadie, Mehdi Mirza, Bing Xu, David Warde-Farley, Aaron Courville, Yoshua Bengio。

參考鏈接:https://x.com/sherjilozair/status/1864013618721001710

- 免責聲明

- 本文所包含的觀點僅代表作者個人看法,不代表新火種的觀點。在新火種上獲取的所有信息均不應被視為投資建議。新火種對本文可能提及或鏈接的任何項目不表示認可。 交易和投資涉及高風險,讀者在采取與本文內容相關的任何行動之前,請務必進行充分的盡職調查。最終的決策應該基于您自己的獨立判斷。新火種不對因依賴本文觀點而產生的任何金錢損失負任何責任。

新火種

2024-12-10

新火種

2024-12-10