外媒評測GPT-4:較上一代脫胎換骨,但依然有缺陷存在誤導性

10:23

視頻加載中...

GPT-4 AI能力精華版 澎湃新聞編輯 李垚瑞(10:23)

“GPT3或3.5像一個六年級學生,而GPT-4像一個聰明的十年級學生。” 對于最新發布的GPT-4模型,有美國初創企業人士這樣評價。

當地時間3月14日,OpenAI推出了“深度學習的最新里程碑”GPT-4。據介紹,這是一款大型多模態模型,與ChatGPT所用的模型GPT-3.5相比,它的文本處理量擴大至2.5萬個單詞,還增加了圖片處理功能。

在一直被外界詬病的準確性方面,GPT-4也有所改進。據OpenAI的介紹,在公司內部的對抗性真實性評估中,GPT-4的得分比GPT-3.5高40%,相應的“不允許內容請求的傾向”降低了 82%,根據政策響應敏感請求(如醫療建議和自我傷害)的頻率提高了29%。

OpenAI將GPT-4稱為“里程碑”式的模型,它是否如宣傳的那般智能?與此前的GPT系列模型相比,它到底在哪些方面有所改進?

準確性更高、專業性更強

根據《紐約時報》3月14日發布的GPT-4測評報道,與ChatGPT相比,這款模型的準確性更高、專業性更強。

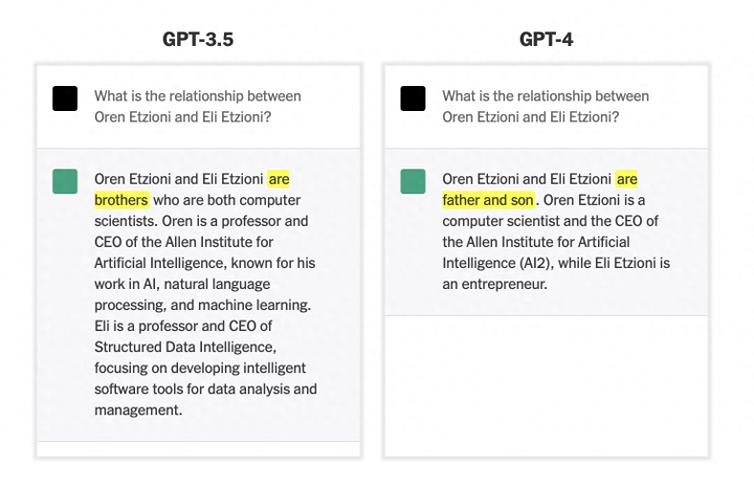

一位AI研究員分別詢問ChatGPT和GPT-4“艾倫人工智能研究所前CEO Oren Etzioni以及企業家Eli Etzioni是什么關系”,GPT-4準確回答出他們是父子關系,而ChatGPT錯誤地將他們說成兄弟。

不過,在解釋了上述兩名人士的身份時,GPT-4和ChatGPT都犯了一些錯誤——這兩個機器人均將Oren解釋為艾倫人工智能研究所的CEO,但事實上,Oren已經于2022年宣布卸任CEO一職。

但考慮到ChatGPT的數據庫僅更新至2021年,而GPT-4的訓練數據也只追蹤到2021年9月,這一錯誤顯得情有可原。

來源:《紐約時報》

專業性方面,北卡羅來納大學教堂山分校(University of North Carolina at Chapel Hill)的醫學副教授兼心臟病學家Anil Gehi通過詢問醫學領域的專業問題,發現GPT-4具有一定的專業知識。

Gehi向GPT-4描述了一名患者的病史以及其入院后經歷的并發癥,并在對話中使用了較為專業的醫學術語。當他詢問GPT-4應該如何治療病人時,它給了完美的答案,Gehi評價稱“這正是我們對待病人的方式”。他還補充道,在嘗試其他場景時,GPT-4給出了同樣令人印象深刻的答案。

這似乎也對應了OpenAI所說的,與GPT-3.5相比,GPT-4在響應醫療建議和自我傷害等敏感請求方面,頻率提高了29%。

不過,Gehi認為GPT-4并不會每次都能回答專業知識,因此仍然需要專業人士對其內容進行判斷并執行相應的醫療程序。

能夠處理復雜圖片、更具幽默感

與此前發布的GPT系列模型相比,GPT-4最大的突破之一是能夠處理圖像內容。《紐約時報》的測試顯示,它能夠識別較為復雜的圖片信息,并對其進行解讀。

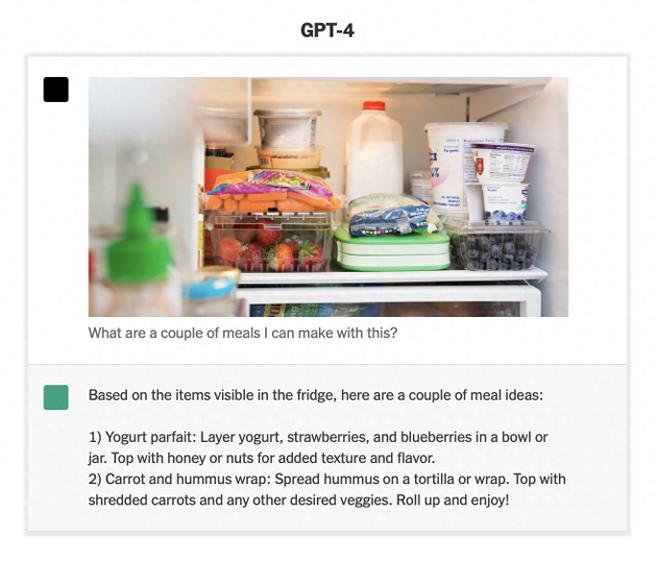

向GPT-4發送塞滿食物的冰箱的圖片,并詢問圖中食材能夠做幾頓飯,它給出了兩種菜譜的具體制作方法——食物的搭配相當豐富,還考慮到了口感和風味。

它的回答為,“根據冰箱里可見的物品,有以下食譜:1)酸奶凍糕:將酸奶、草莓和藍莓分層放在碗或罐子里,頂部撒上蜂蜜或堅果以增加口感和風味。2)胡蘿卜和鷹嘴豆泥卷:將鷹嘴豆泥涂在玉米餅或卷上,上面放上切碎的胡蘿卜和任何其他想要的蔬菜。”

來源:《紐約時報》

值得注意的是,OpenAI目前尚未對外開放圖片識別分析,因為擔心這項功能會被濫用。

此外,《紐約時報》還發現,GPT-4的幽默感有所提高。

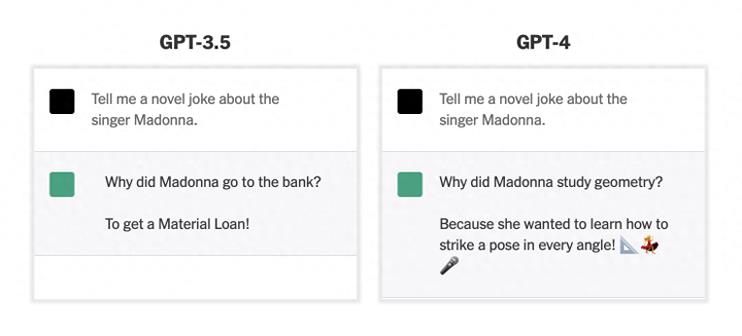

當被要求提供“關于歌手麥當娜的新鮮笑話”時,GPT-4回答“麥當娜為什么要學習幾何?因為她想學會如何擺出各個角度的姿勢!”在回答的最后,它還“俏皮”地附上了三角尺、跳舞和麥克風的表情符號。相比而言,GPT3.5的回答就顯得平平無奇,并不那么好笑了。

業內人士稱警惕AI存在的潛在風險

自OpenAI去年發布其圖像生成技術Dall-E 2以來,科技公司一直在炒作生成式AI(人工智能)的可能性;去年11月發布的ChatGPT更像一顆火種,迅速點燃各界對AI的熱情。

不過,自發布以來,ChatGPT及其競爭對手的準確性一直為外界詬病,微軟和谷歌在展示其聊天機器人相關新技術時,均出現過大大小小的失誤。因此,OpenAI花費了6個月的時間,利用對抗性測試程序和ChatGPT的經驗教訓,迭代調整GPT-4。

OpenAI總裁兼聯合創始人Greg Brockman說道,“GPT-4比GPT 3.5犯的錯誤更少,不過要達到最佳效果仍需輔以人工檢查。……它并不完美,但你也不完美,它是讓你達到新高度的工具。”Brockman還表示,OpenAI計劃把這些通用知識技能推廣到各個不同的領域。

雖然OpenAI一直在聲稱努力改進GPT系列并取得了進展,但該公司也坦然承認,GPT-4還存在一定缺陷。

“它有時會犯簡單的推理錯誤……或者過于輕信用戶的錯誤陳述。有時它會像人類一樣在難題上失敗,例如在它生成的代碼中可能會引入安全漏洞。”OpenAI表示。

目前對于生成式AI,不少業內人士仍然充滿擔憂。科技媒體CNET表示,大型語言模型的回復有時令人印象深刻,似乎它們真的可以理解大量的問題,并且能夠用聽起來有點生硬的語言進行交流。不過,從根本上說,大型語言模型以及AI并不能真的了解某樣東西,它們只是以精確的統計方式將單詞串在一起。

對此,不少研究人員發出警告,希望用戶警惕大型語言模型帶來的“隨機鸚鵡(stochastic parrots)”風險。“隨機鸚鵡”指用隨機概率信息將語言形式的序列隨意拼接在一起的實體,但不涉及任何含義,是對機器學習和人工智能模型在實際應用中可能出現的誤導性表現的一種戲謔稱呼。

《華爾街日報》援引人工智能分析師的話稱,生成式AI仍然存在潛在問題,雖然ChatGPT和其他文本生成器在面對高質量提問時,能給出準確回復,但在其他主題方面可能會給出帶有種族主義和性別歧視的答案。

專門研究國際商務和信息安全的加州大學伯克利分校教授Steven Weber 表示,現在判斷這項技術還為時過早,因為它尚未在現實世界中得到廣泛測試。

目前OpenAI沒有公開GPT-4的參數數量及運行成本,不過《紐約時報》指出,由于OpenAI新的聊天機器人接受了更多數據訓練,其成本將會增加。OpenAI首席技術官Mira Murati稱,如果服務器過載,公司可能會限制用戶使用。

- 免責聲明

- 本文所包含的觀點僅代表作者個人看法,不代表新火種的觀點。在新火種上獲取的所有信息均不應被視為投資建議。新火種對本文可能提及或鏈接的任何項目不表示認可。 交易和投資涉及高風險,讀者在采取與本文內容相關的任何行動之前,請務必進行充分的盡職調查。最終的決策應該基于您自己的獨立判斷。新火種不對因依賴本文觀點而產生的任何金錢損失負任何責任。

新火種

2023-10-07

新火種

2023-10-07