上線文生視頻功能騰訊大模型再追趕

11月底就被“劇透”的騰訊混元大模型文生視頻功能,在12月3日正式上線。目前該模型已上線騰訊元寶App,用戶可在AI應用中的“AI視頻”板塊申請試用,企業客戶通過騰訊云提供服務接入,目前API(應用程序編程接口)同步開放內測申請。自OpenAI發布Sora,國內外的視頻生成式大模型輪番搶鏡,在國內快手和字節跳動正面交鋒,阿里云、MiniMax、美圖等也有備而來,和同行相比,騰訊混元不算快節奏。

在提示框輸入一段描述,就可以生成一段視頻,從使用流程看,騰訊混元大模型的文生視頻功能和類似產品無異。在這部分,混元給用戶提供了轉場視頻、多動作視頻、超寫實視頻三種靈感提示。

北京商報記者體驗發現,用戶可以選擇寫實、動畫、電影、黑白、賽博朋克五種視頻風格及五種比例。高級指令部分的選擇更多,包括景別、光線、鏡頭運動等,其中景別包括特寫、近景等五種,鏡頭運動包括固定鏡頭、手持攝影、拉近鏡頭等14種。

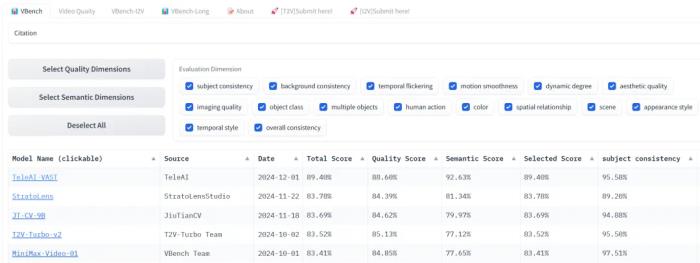

根據騰訊提供的評測報告,騰訊混元視頻生成模型與國內兩個同類模型的持續時間都是5秒,在文本對齊方面的得分分別是61.8%、62.6%、60.1%,運動質量方面分別是66.5%、61.7%、62.9%,視覺質量方面分別是95.7%、95.6%、97.7%。和GENN-3 alpha(Web)相比,騰訊混元視頻生成模型的持續時間少一秒,文本對齊高14.1個百分點,運動質量高11.8個百分點,視覺質量持平。

騰訊混元多模態生成技術負責人凱撒介紹,混元基于跟Sora類似的DiT架構,在架構設計上進行了升級。混元視頻生成模型適配新一代文本編碼器提升語義遵循,其語義跟隨能力可以更好地應對多個主體描繪,實現更細致的指令和畫面呈現;采用統一的全注意力機制,使每幀視頻的銜接更流暢,實現主體一致的多視角鏡頭切換;通過圖像視頻混合VAE(3D變分編碼器),讓模型在細節表現有明顯提升,特別是小人臉、高速鏡頭等場景。

當天,騰訊宣布開源該視頻生成大模型,該模型已在Hugging Face平臺及Github上發布,包含模型權重、推理代碼、模型算法等完整模型,企業與個人開發者可免費使用和開發生態插件。目前,騰訊混元已開源旗下文生文、文生圖和3D生成大模型。

對于為何選在此時上線文生視頻功能,凱撒的回答是:“內部一直在進行視頻生成能力的打磨,現在上線水到渠成。”業內人士更關心的是,該功能和同行相差的幾個月時間差對騰訊的壓力,“視頻生成的成熟度還沒有到外界想象得那么高,現階段還是要自己做技術打磨”,凱撒說。

在和北京商報記者交流時,比達分析師李錦清表示,“文生視頻的實現難度更高,但商業空間更大,短期內競爭門檻不會馬上建立,行業和企業有共性或特性的問題要解決,比如數據就是個檻”。

根據GIR(GlobalInfo Research)調研,2023年全球文生視頻大模型收入大約720萬美元,預計2030年達到22.19億美元,2024-2030年期間,年復合增長率CAGR有望達到56.6%。

(文章來源:北京商報)

- 免責聲明

- 本文所包含的觀點僅代表作者個人看法,不代表新火種的觀點。在新火種上獲取的所有信息均不應被視為投資建議。新火種對本文可能提及或鏈接的任何項目不表示認可。 交易和投資涉及高風險,讀者在采取與本文內容相關的任何行動之前,請務必進行充分的盡職調查。最終的決策應該基于您自己的獨立判斷。新火種不對因依賴本文觀點而產生的任何金錢損失負任何責任。

北京商報

2024-12-04

北京商報

2024-12-04