我的語音數據去哪了?三問智能家居語音采集

早晨起床,說一聲“打開窗簾”,就能享受明媚陽光;晚上回家,道一句“開燈,播放音樂”,溫馨燈光亮起,開始播放你喜歡的歌曲……語音識別與控制是智能家居的核心功能之一,隨著產品不斷升級,“聽懂人話”的智能家居,可以根據人們的習慣和偏好,提供更加個性化的服務。

不過,此前曾有國外科技巨頭的智能語音助手被指“竊聽”用戶隱私,并將語音數據用于模型訓練,引發公眾憂慮。智能家居APP采集的用戶語音信息將用于何處?是否存在泄露個人信息風險?如何保障個人權益?南方都市報記者近日調查國內多款知名智能家居APP發現,部分APP隱私條款表述模糊,用戶語音數據去向未作明確說明,存在用于大模型訓練的可能;此外,部分平臺強制用戶語音信息用于“功能優化”,不同意就不能使用語音控制。

多位受訪專家認為,智能家居APP數據處理目的需進一步明確,如果采集個人語音數據用于模型訓練需提供單獨授權選項,否則涉嫌違規。

采集個人語音用于哪里?

平臺:隱私條款指向模糊

隨著科技進步,智能音箱、智能電視等語音控制設備正在加速進入家庭,語音識別和控制功能日益普及。這類設備通常要求開啟麥克風權限,采集用戶語音數據。而實現語音識別、控制功能通常依托于聲學模型、語言模型、自然語言處理、深度學習等技術,這些技術都依賴大量的語音和文本數據來學習和優化算法及模型。

根據《中華人民共和國個人信息保護法》,處理個人信息需遵循“告知-同意”規則,因此用戶在注冊使用智能家居APP前,都需勾選同意公司提供的隱私政策,并授權APP調用設備權限。但隱私條款往往冗長復雜,少有用戶會注意到,除去采集相關語音數據外,部分公司還將用戶語音數據用于模型訓練也寫入了隱私條款。

南都記者實測華為智慧生活、小米小愛音箱、海爾智家、美的美居、格力+、京東小家六個智能家居APP的個人隱私政策,發現它們的語音數據相關條款中均提到了需要收集用戶語音數據,且數據將會用于語音識別、功能的“優化”。不過,部分APP對于具體優化什么,語焉不詳。

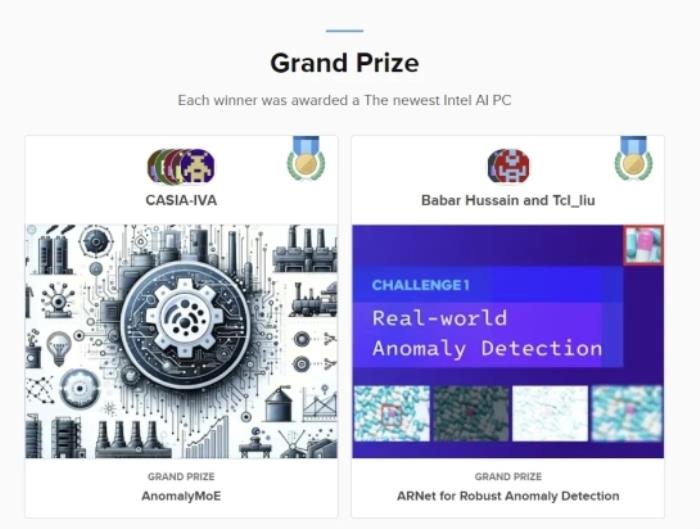

部分智能家居APP隱私政策“優化”相關表述截圖

華為智慧生活APP、小米小愛音箱APP的隱私政策中,均明確“優化”的方式和目的,即將用戶的語音數據進行語音模型訓練,從而優化語音識別結果和語音喚醒效果。京東小家APP的隱私政策稱,“我們可能會使用您的語音素材進行模型訓練”,且說明了模型訓練使用數據的大致環節,即依托數據進行模型構建、驗證、測試,包括數據標注、構建數據集等必要環節。

但海爾、美的和格力的隱私條款,對“優化”的描述就比較模糊。美的美居APP隱私政策中只寫了“優化”功能的目的,表述為“優化智能設別系統對您表達內容的理解能力”;格力+APP表述為“進行語音識別、語音控制功能,并進行優化”,既未說明所謂“優化”的方法,也沒說明“優化”的目的;海爾智家APP中的表述是“您的語音數據(包括轉換后的文本)僅用于實現上述產品功能,并對其進行優化”,同樣未能寫清“優化”所需數據的范圍、具體處理方法和必要性。

針對指向不明的“優化”條款,南都記者以消費者身份咨詢客服。格力售后技術人員答復,“優化”指去除語音背景雜音,不涉及模型訓練等。美的技術人員也表示,用戶語音數據“不會用于模型訓練”。值得一提的是,在南都記者咨詢過后,《美的美居隱私協議》語音數據部分新增說明:“請放心,您的語音內容不會用于AI訓練。”不過,南都記者發現《美的美居隱私協議》中的“個人信息使用規則”提到,美的會在加密處理和嚴格去標識化的前提下,將所收集的數據用于機器學習、算法模型訓練。

海爾智家用戶數據中心則解釋,“優化”功能是為了提高問題識別的準確性,用戶語音信息不會直接用于語音助手的模型算法,海爾會將用戶語音轉化為文字,并去除用戶信息,僅使用文本信息進行語義分析。

隱私條款中類似“優化”的模糊表述較為普遍,這會使個人用戶處于較為被動的地位。“因為對于后臺的數據使用情況,用戶缺乏感知,很大程度上依賴的是企業的披露和定期的技術審計結合外部監督”,上海資深數據合規律師劉律師認為,從監管趨勢來看,《網絡數據安全管理條例》對數據處理者提出了更具體的要求,網絡數據處理者按照前款規定向個人告知收集和向其他網絡數據處理者提供個人信息的目的、方式、種類以及網絡數據接收方信息的,應當以清單等形式予以列明。

未經用戶授權訓練大模型?

專家:應獲得用戶單獨授權

對于不少智能家居APP在隱私政策中的采集個人信息數據用于“優化”功能表述,上海資深數據合規律師劉律師認為,可能涉及兩種數據采集情況,一種是為正常使用產品功能采集所需的用戶語音記錄,如為糾正功能錯誤進行的迭代升級等;另一種是模型或者產品進一步優化所需要的數據采集,比如讓模型更“聰明”。劉律師指出,前者屬于功能實現所必需,后者是優化服務需要,對于用戶數據的采集和使用需區分開二者。

根據《App違法違規收集使用個人信息行為認定方法》,僅以改善服務質量、提升用戶體驗、定向推送信息、研發新產品等為由,強制要求用戶同意收集個人信息,可被認定為“違反必要原則,收集與其提供的服務無關的個人信息”。

例如在京東小家的隱私政策中,把迭代產品功能和優化模型兩個目的綁定在一起,要求用戶在使用產品的時候就同時授權了模型優化目的所進行的數據收集,或存在合規問題。

6款智能家居APP語音數據有關隱私政策測評結果。

而在美的、格力和海爾三款智能家居的隱私條款中,“優化”功能同樣與語音識別、控制功能綁定,若用戶拒絕授權該功能使用語音數據,將無法使用該設備的語音控制功能,且APP中也不提供單獨關閉“優化”功能的選項。但因隱私條款中“優化”功能表述模糊,用戶無法判斷該功能使用語音數據是否必要。

根據《App違法違規收集使用個人信息自評估指南》,當App運營者收集的個人信息超出必要信息范圍時,應向用戶明示所收集個人信息目的并經用戶自主選擇同意。劉律師解釋,“具體到語音數據相關的隱私政策場景中,以優化模型的目的去收集用戶信息,需向用戶提供選項,由用戶自主決定是否授權提供。當用戶拒絕授權模型優化的用途,不應該影響用戶原本功能的正常使用。”例如在華為、小米兩款智能家居APP中均提供了針對相關“優化”功能的單獨關閉選項,且關閉模型優化不會影響智能設備基礎語音識別、控制功能的使用。對此,美的和海爾相關部門均回復記者,用戶可以通過隱私郵箱要求單獨關閉“優化”功能,并承諾關閉后會將用戶數據從后臺刪除,不用于后續的“優化”用途。

訓練大模型中的隱私安全風險在哪?

專家:聲紋特征有唯一性

使用用戶語音數據訓練、優化模型是否必要?風險在哪里?一般來說,模型訓練是為了完善產品服務和質量,真實用戶數據能夠提供豐富的上下文和多樣性,從而提高模型的預測能力和準確性。模型訓練涉及到用戶個人數據的采集、傳輸、儲存和分析,一般會采用數據加密和去標識化處理等方式保障個人信息安全,但隱私泄露的風險仍然存在。

在中國電子技術標準化研究院網安中心測評實驗室副主任何延哲看來,真實用戶語音數據訓練有助技術進步,但采集使用每個用戶家庭數據并非完全必要。模型訓練涉及用戶日常談話內容、說話習慣,涉及到聲紋特征等敏感個人信息,需確保用戶明確同意并尊重其選擇權。

何延哲解釋,在個人數據分析和處理過程中,一般采取去標識處理,將個人標識去除得較為徹底,便可以達到匿名化效果。但語音信息中包含的聲紋特征等本身就具有唯一性,如果徹底匿名化,唯一性消失,又會影響到模型訓練所需數據信息的真實性。

科技進步需求與隱私泄露風險同時存在,何延哲坦言,“如何在其中尋求平衡,在個人信息保護措施更加充分的情況之下,去推動個人信息發揮更大價值,讓個人信息價值在陽光下發揮作用,需要社會各界擺平心態,以發展的視角來權衡利弊,達成共識”。

(文章來源:南方都市報)

- 免責聲明

- 本文所包含的觀點僅代表作者個人看法,不代表新火種的觀點。在新火種上獲取的所有信息均不應被視為投資建議。新火種對本文可能提及或鏈接的任何項目不表示認可。 交易和投資涉及高風險,讀者在采取與本文內容相關的任何行動之前,請務必進行充分的盡職調查。最終的決策應該基于您自己的獨立判斷。新火種不對因依賴本文觀點而產生的任何金錢損失負任何責任。

南方都市報

2024-11-15

南方都市報

2024-11-15