摩爾線程開源音頻理解大模型MooER:38小時訓練5000小時數據

8月23日消息,摩爾線程官方宣布,音頻理解大模型“MooER”(摩耳)已經正式開源,并公布在GitHub上:https://github.com/MooreThreads/MooER

目前開源的內容包括推理代碼,以及5000小時數據訓練的模型,后續還將開源訓練代碼,以及基于8萬小時數據訓練的模型。

摩爾線程希望,能夠在語音大模型的方法演進和技術落地方面為社區做出貢獻。

MooER是業界首個基于國產全功能GPU進行訓練和推理的大型開源語音模型,依托摩爾線程的夸娥(KUAE)智算平臺,并得益于自研的創新算法和高效計算資源的結合,僅用38個小時,就完成了5000小時音頻數據和偽標簽的訓練。

MooER不僅支持中文和英文的語音識別,還具備中譯英的語音翻譯能力,并在多個語音識別領域的測試集中,展現出了領先或至少持平的優異表現。

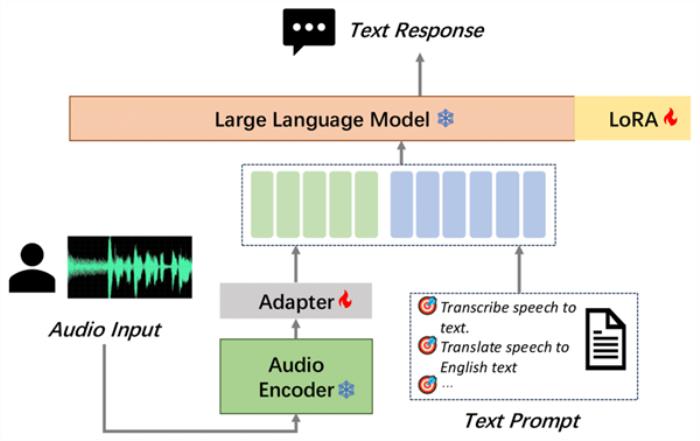

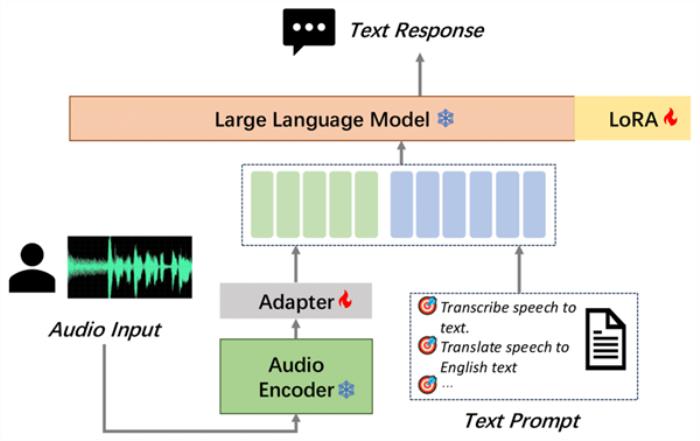

MooER的模型結構包括Encoder、Adapter、Decoder(LLM)三個部分。

其中,Encoder對輸入的原始音頻進行建模,提取特征并獲取表征向量。

Encoder的輸出會送到Adapter進一步下采樣,使得每120ms音頻輸出一組音頻Embedding。

音頻Embedding和文本的Prompt Embedding拼接后,再送進LLM進行對應的下游任務,如語音識別(ASR)、語音翻譯(AST)等。

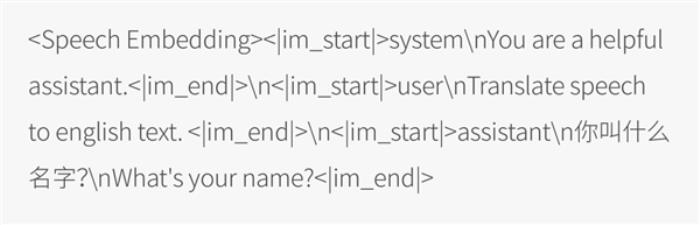

在模型訓練階段,融合了語音模態和文本模態的數據會按以下形式輸入到LLM:

摩爾線程使用開源的Paraformer語音編碼器、Qwen2-7B-instruct大語言模型,初始化Encoder和LLM模塊,并隨機初始化Adapter模塊。

訓練過程中,Encoder始終固定參數,Adapter和LLM會參與訓練和梯度更新。

利用自研的夸娥智算平臺,摩爾線程使用DeepSpeed框架和Zero2策略,基于BF16精度進行訓練和推理。

經實驗發現,訓練過程中更新LLM參數能夠提升最終音頻理解任務的效果。

為了提升訓練效率,摩爾線程采用了LoRA技術,僅更新2%的LLM參數。具體的模型參數規模如下:

該模型的訓練數據MT5K(MT 5000h)由部分開源數據和內部數據構成,內部數據的語音識別標簽均是由第三方云服務得到的偽標簽。

語音識別的偽標簽經過一個文本翻譯模型后,得到語音翻譯的偽標簽,且沒有對這些偽標簽數據做任何的人工篩選。

具體數據來源和對應的規模如下:

摩爾線程將MooER與多個開源的音頻理解大模型進行了對比,包括Paraformer、SenseVoice、Qwen-audio、Whisper-large-v3、SeamlessM4T-v2等。這些模型的訓練規模從幾萬小時到上百萬小時不等。

對比結果顯示,開源模型MooER-5K在六個中文測試集上的CER(字錯誤率)達到4.21%,在六個英文測試集的WER(詞錯誤率)為17.98%,與其它開源模型相比,效果更優或幾乎持平。

特別是在Covost2 zh2en中譯英測試集上,MooER的BLEU分數達到了25.2,顯著優于其他開源模型,取得了可與工業水平相媲美的效果。

基于內部8萬小時數據訓練的MooER-80k模型,在上述中文測試集上的CER達到了3.50%,在英文測試集上的WER到達了12.66%。

與此同時,摩爾線程還得到一些有趣的結論,可以為數據資源和計算資源有限的開發者提供一些建議:

▼Encoder的選擇。

分別對比無監督(Self-Supervised Learning)訓練的W2v-bert 2.0、半監督(Semi-Supervised Learning)訓練的Whisper v3、有監督(Supervised Learning)訓練的Paraformer。

采用無監督訓練得到的Encoder必須參與到訓練過程中,否則模型很難收斂。

綜合考慮模型效果、參數量以及訓練和推理的效率,選擇Paraformer作為Encoder。

▼音頻建模粒度很關鍵。

嘗試使用240ms、180ms和120ms的粒度進行建模,并發現這一參數對音頻與文本的融合效果具有重要影響,同時會影響模型的最終效果和訓練的收斂速度。

經過評估,最終選擇每120ms輸出一個音頻Embedding。

▼快速適應到目標垂類。

僅使用了140h~150h的英文數據進行訓練,可以在6個不同來源的英文的測試集上取得一定效果。

同時嘗試將任務遷移到語音翻譯(AST)領域,取得了很好的效果。

相信這個方法同樣也適用于小語種、方言或其它低資源的音頻理解任務。

▼LLM對音頻理解任務的影響。

在模型訓練過程中采用LoRA技術對LLM參數進行更新,可以使訓練更快收斂,并且最終取得更好的效果。

同時,音頻理解任務上的效果也會隨著基礎LLM效果提升而提升。

更多技術細節,請參考技術文檔:

https://arxiv.org/pdf/2408.05101

- 免責聲明

- 本文所包含的觀點僅代表作者個人看法,不代表新火種的觀點。在新火種上獲取的所有信息均不應被視為投資建議。新火種對本文可能提及或鏈接的任何項目不表示認可。 交易和投資涉及高風險,讀者在采取與本文內容相關的任何行動之前,請務必進行充分的盡職調查。最終的決策應該基于您自己的獨立判斷。新火種不對因依賴本文觀點而產生的任何金錢損失負任何責任。

新火種

2024-08-23

新火種

2024-08-23