開創全新通用3D大模型,VAST將3D生成帶入「秒級」時代

原文來源:機器之心

圖片來源:由無界 AI生成

生成式 AI 在 3D 領域在很長一段時間內都在等待自己的「ChatGPT」時刻。

傳統 3D 建模涉及游戲、影視、建筑等多個行業,普遍依賴專業人員手動操作,生產周期短則幾天,多則以月為單位,單個 3D 模型的創建成本至少需要幾千元。生成式 AI 技術在 2D 圖像生成領域的成功經驗,讓人們看到了 AI 在變革 3D 建模這件事上的潛力。一個萬億美元級別的賽道似乎從此開啟,但當前市面上的 3D 生成類的 AI 技術仍然存在各種不足,大家都在期待出現一個讓自己眼前一亮的產品。

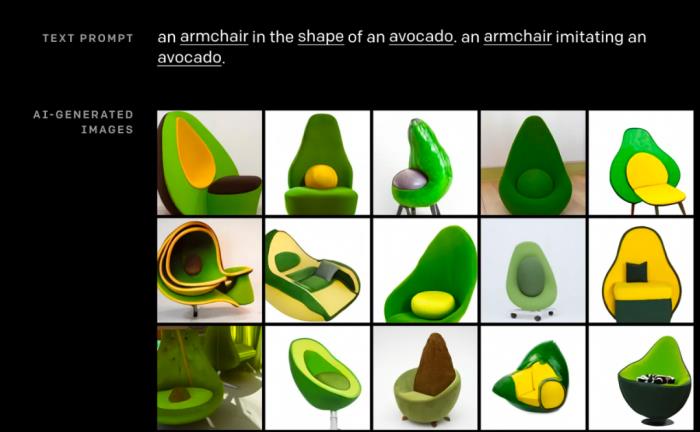

2021 年 1 月初,OpenAI 發布 DALL?E,并以輸入文字 prompt「一把牛油果形狀的扶手椅」,豐富的形象、清晰的結構標志著文字生成圖片的技術走向成熟。

MIT 科技評價道:「這把牛油果扶手椅可能是 AI 的未來(This avocado armchair could be the future of AI)」

Prompt(提示詞):an armchair in the shape of an avocado. 圖源:OpenAI

2023 年 12 月,機器之心體驗了 VAST 自研的 3D 大模型 Tripo,當經典的「牛油果手扶椅」以精致的形態快速絲滑地在眼前生成,我們立刻意識到,生成式 AI 迎來了又一個里程碑時刻。

Prompt(提示詞):avocado chair. ?圖源 TripoAI

VAST 是誰?

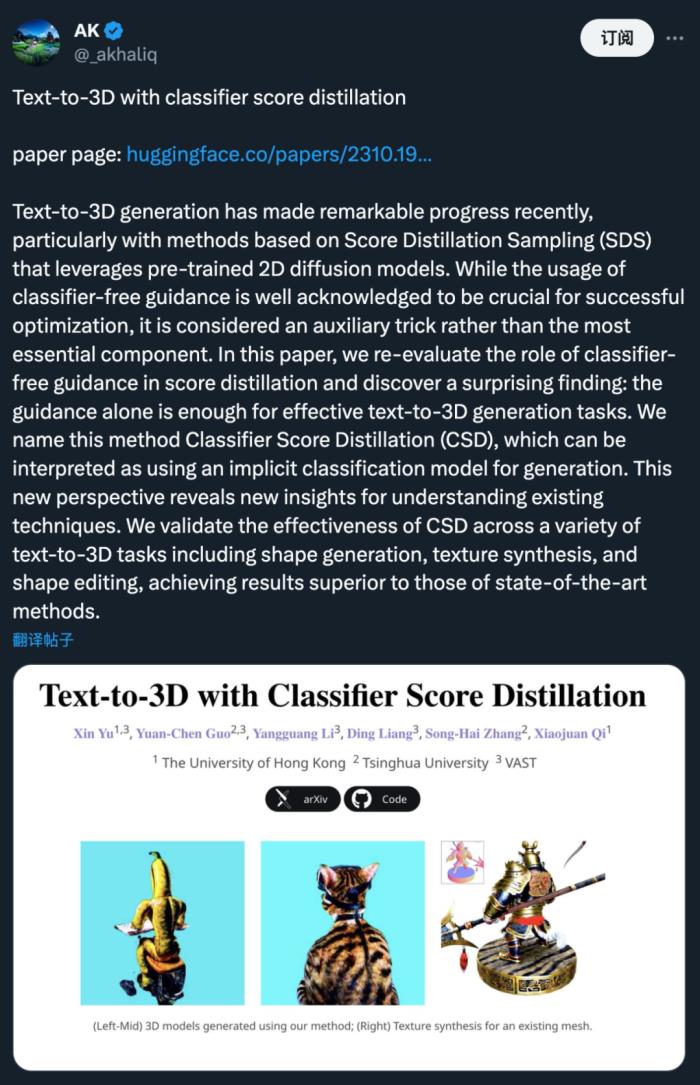

經過一番搜索,我們發現,最近走紅的兩項 3D 生成技術 Wonder3D 和 CSD 都與這家公司有關。

不久前,一個名為 Wonder3D 的開源項目被開發者發掘,它能夠在 3 分鐘內從單個圖像重建高保真紋理網格。在開源平臺 GitHub 上,這個項目短時間內就斬獲了 3.3K Github Star:

體驗鏈接:https://huggingface.co/spaces/flamehaze1115/Wonder3D-demo

與此同時,一項利用圖像擴散模型實現 3D 生成的理論突破成果「CSD 」也引發了眾人關注:

VAST 此前僅有的公開亮相是創始人在圖形學盛會 SIGGRAPH 五十周年慶典中進行的 Keynote 演講。通過當時的報道可以了解到,VAST 是一家專注于通用 3D 大模型的技術研發及產品落地的初創公司。

作為首位在 SIGGRAPH 發表主題演講的中國創業者,VAST 創始人宋亞宸提到,VAST 的目標是減少制作高質量 3D 資產和環境所需的專業知識和成本,讓 3D 內容生成變成一件更容易的事。

「3D 技術代表了下一個前沿方向,開啟了沉浸式表達的新維度,我們相信 AI 可以讓任何人創造出令人驚嘆的 3D 內容,且不受制于想象力之外的任何因素。」

作為一家初創公司,VAST 的創始人為何能夠與業內巨頭英偉達、索尼、Unity 的掌門人同臺演講?它們又是如何推動了 Wonder3D 和 CSD 這樣的技術突破?

帶著這份好奇心,機器之心拜訪了 VAST 在北京的辦公室。

了解過團隊情況后,我們發現 VAST 可以說是「臥虎藏龍」:

算法團隊成員清一色來自海內外的頂尖高校和技術大廠,具有豐富的人工智能及圖形學經驗。

CTO 梁鼎師從戴瓊海院士,曾擔任商湯通用視覺和語言大模型發起人和垂類語言大模型負責人,著有論文 40 多篇,引用 7000 次,國內專利 100 多項,海外專利 14 項。

首席科學家曹炎培師從胡事民院士,前騰訊 ARC Lab 和 AI Lab 3D 方向專家,擁有論文 40 多篇,近期在 3D 生成方向的相關成果包括 Dream3D、DreamAvatar、 Sparse3D、HiFi-123、TGS 等。

還有一位出生于 97 年的青年科學家郭元晨,他是清華大學博士生,師從張松海副教授,也是知名 3D 生成開源項目 threestudio 的發起者、核心貢獻者。該項目已經在 GitHub 社區收獲了 4.4K 星標,是目前為止功能最完整、使用最廣泛的 3D 生成代碼框架。

threestudio 地址:https://github.com/threestudio-project/threestudio/

隨后,VAST 和機器之心聊了聊他們正在進行的技術探索。

AI 在 3D 生成領域的壁壘,如何打破?

我們聊到的第一個問題是:在 3D 內容的生成上,AI 還面臨著哪些挑戰?

要理解這個問題,首先需要理解 3D 內容制作的特殊性。

數字 3D 內容起源于 20 世紀 60 年代的計算機圖形學,迄今已衍生出眾多細分領域。一般來說,完整的 3D 生產管線涵蓋概念設計、3D 建模、紋理 / 材質、動畫和渲染等多個環節。

傳統流程中,3D 數字內容的生成均由積累?時間學習和?作經驗的專業藝術家進行創作,加?了?量的??經驗設計,且不同藝術家?作流程不同,沒有絕對統一的標準。對于這些資深的專業 3D 創作者來說,3D 內容生成也是一項非常復雜且耗時的工作。

此外,3D 數字內容表達的多樣性,也為 AI 的學習過程增添了更多挑戰。多邊形?格、細分曲?、?骼動畫、頂點動畫、物理模擬動畫,不同的材質涉及不同的渲染管線。表達方式的不統一,導致 3D 內容的制作本身比 2D 更具挑戰性。

以我們熟悉的視覺模型和語言模型為例,它們會通過對預訓練數據的「學習」來摸索規律,最終展現出一種非常接近「創造」的能力。實現這種學習能力的前提是圖像、視頻、語音、文字均有比較通用的表示形式。

對于現有的生成式大模型來說,3D 數字內容就像是一種很新的「語言」體系。因此,想讓 AI「學會」生成媲美人類水準的 3D 模型,同時保證速度,并不是一件容易的事。

已取得階段性突破的研究大多遵循 2D 優化路線:利用已有生成模型的 2D 生成能力,通過多視角優化將生成維度提升到三維。

斬獲了 ECCV 2020 最佳論文榮譽提名的 NeRF(Neural Radiance Fields,神經輻射場渲染)在多視圖重建靜態三維場景方面獲得了重要進展。這項基礎理論的突破開啟了新的一波 3D x AI 熱潮,在此基礎上,有研究者引入了擅長文本到圖像生成的擴散模型,比如 Google 去年發布的 DreamFusion 算法,提出采用「Score Distillation Sampling」實現從文本到 3D 的生成。DreamFusion 的優點是幾乎不需要事先訓練,實現了在沒有 3D 數據的情況下生成物體 3D 表示,缺點是速度慢(長達數個小時)。

OpenAI 在去年同期發布的 Point-E 則采用了在 3D 數據集訓練的方案,還強調了「可以用單塊 NVIDIA V100 GPU 在一到兩分鐘內生成 3D 模型」,但它在從文字到 3D 的轉換過程中偶爾還是無法理解文本敘述的內容,導致生成的形狀與文本提示不匹配,而且生成結果的精細度不足。

總之,沿襲此路線的后續研究很多,但始終沒有一個方案能兼顧模型的生成質量、速度、多樣性和可控性。

「通用 3D 大模型」的探索之路

知名計算機科學家 Rich Sutton 教授曾在 2019 年的《The Bitter Lesson》文章中給出過一個論斷:對于 AI 模型的訓練來說,要在短期內有所提升,研究人員可以利用專門領域的人類知識。但如果想要長期地獲得提升,更好地利用計算能力才是王道。

正如早期的 CV 領域,普遍認為只要設計出更好的特征描述就可以持續進步,但后來大獲成功的深度學習方法僅使用卷積或注意力機制就能得到更好的效果。其中 ImageNet 等海量圖像數據集、GPU 提供的強大計算能力,以及 CNN、Transformer 等高可擴展性的模型架構起到了至關重要的作用。

VAST 認為,AI 要想在 3D 生成領域獲得長足發展,同樣需要跳出對人類知識的依賴,憑借更龐大的數據和更多的計算「學習」一種「通用方法」。

具體到 3D 領域,讓 AI 突破瓶頸獲得「通用能力」的方法論又是什么呢?

在 VAST 看來,這個目標可以從三個方向的工作入手:表示、模型和數據。

充分利?算?的關鍵,最重要正是在于找到合適的「表示」。?如 3D 內容制作中常用三??格來模擬復雜物體的表面,這種表示對 GPU 渲染算?友好,但是對深度學習算法來說并不夠友好。

VAST 希望尋找一種更加靈活、利于計算的 3D 統一表示,同時兼容現有的圖形管線。

在最近的論文《SC-GS: Sparse-Controlled Gaussian Splatting for Editable Dynamic Scenes》,他們提出了一種新的動態場景表示方法,通過將場景運動和外觀分解為稀疏控制點和稠密的 3D Gaussians,顯著提高了動態場景的可編輯性和渲染質量,在新視角合成和保持外觀的運動編輯方面均顯著優于現有方法。

另外一項研究《Triplane Meets Gaussian Splatting: Fast and Generalizable Single-View 3D Reconstruction with Transformers》則探索了基于三平面(triplane)和高斯潑濺(3D Gaussian Splatting)融合的 3D 表示,利用高度可擴展的 Transformer 架構即可實現 2 秒內的高質量圖生 3D。

此外,探索「3D tokenizer」也是一種不錯的思路。此前的一項研究表明,在相同的訓練數據、模型大小和訓練預算條件下,如果利用良好的視覺 tokenizer,掩碼語言模型在圖像和視頻基準的生成保真度和效率方面同樣可達到與擴散模型相同的水準。對于 3D 生成任務來說,將 3D 表示轉化為與語言 token 相近形式的 token 表示,或許有助于將現有的理解和生成大模型應用在 3D 領域。

在「模型」層面,VAST 近期的多項研究都探索了如何充分利用大模型在其他模態下的先驗、設計準則、訓練經驗,以提升模型對 3D 數據的學習能力。

比如近段時間爆火的 Wonder3D 就創新地提出了復用強大的 2D 圖像生成模型同步生成多視角一致法向和 RGB 圖,實現了 2 分鐘高質量圖生 3D。他們利用多視角法向圖表示 3D 幾何信息,從而可以有效利用大量 2D 數據先驗。

此外,VAST 還在最新的一項研究「UniDream」中提出了可輸出具有高質量 PBR 材質、可重光照 3D 模型的多階段文生 3D 框架。這一框架分為三個組成部分:1. 復用強大的 2D 圖像生成模型,以文字為條件,同步生成解耦的多視角一致的法向和基礎色;2. 結合在大量 3D 數據訓練的可泛化 3D 重建模型,從多視角圖片生成基礎 3D 先驗;3. 利用材質解耦的 SDS 優化方法,得到最終具有高質量幾何和 PBR 材質的 3D 模型。

「數據」層面的挑戰同樣不容忽視。由于優質、原生、多樣化的 3D 數據集資源的稀缺,模型的最終表現受限,導致可以生成的 3D 內容有限,泛化能力不足。這也是為什么一部分研究者嘗試過直接用 3D 數據集進行訓練和微調模型,但都沒能取得太理想的效果的原因。

針對這個問題,VAST 自 2023 年初成立以來一直不斷積累在 3D 數據上的優勢,目前已擁有全世界最大的 3D 高質量原生數據庫(千萬級別)。

基于千萬 3D 原生數據訓練的大模型

已有落地產品

經歷了近一年的探索,VAST 在今年 12 月已經完成了通用 3D 大模型 Tripo 的研發。

VASTAI,贊 11Tripo AI Fantasy: Launched,與藝術家Rui Huang共創Tripo 基于海量 3D 高質量原生數據庫訓練,是一個數十億參數級別的 3D 大模型。得益于 VAST 在「通用 3D 大模型」路線上的技術探索,Tripo 在生成的質量、速度、成功率上行業領先。目前,已經實現 8 秒鐘生成帶紋理 3D 網格模型,可以進入傳統管線進行二次編輯和調整。在此基礎上,可以再用5分鐘的時間進行優化,優化后的 3D 模型可以接近人類手工制作的 3D 模型質量,成功率超過 95%。Tripo 也已經在 12 月 21 日正式上線,目前支持「文生 3D」和「圖生 3D」兩種能力。前往 VAST 官網免費體驗?Tripo 3D 生成能力:www.tripo3d.ai我們可以觀察到, Tripo 有著較強的泛化能力,不管是寫實、風格化任務,還是結構復雜的幻想生物,也能在短時間內完成,展現出了在 3D 創意內容方面的巨大潛力。

隨著對高質量數據集的更深入利用和算法的不斷進步,Tripo 未來有望在極短時間內創造出質量媲美人工建模水準的作品。3D 生成,何時迎來「ChatGPT 時刻」?在與 VAST 技術團隊的交流中,我們發現,在領先業界進行通用 3D 大模型的探索之外,這家公司在產業化探索上同樣做到了「快人一步」。不到一年時間內,VAST 已經搭建起了針對國內外 B 端和 C 端用戶的端到端產品矩陣,并與數十家海內外游戲、動畫、工業、云計算等行業領軍企業在 3D 數據及 3D 內容生成等領域建立了戰略合作關系。放眼未來,VAST 的「野心」不止于此。成立之初,這個團隊已經定下目標:讓任何人都可以成為「超級創作者」,充分實現自己的創意。需要承認的是,目前的 AIGC 3D 技術距離目標還需要一段探索期。但在這次技術浪潮中,VAST 已經成為了從 0 到 1 的推動者之一。下一步,VAST 將攻克來自真實世界的更多難題。在與 VAST 團隊的交流中,我們充分感受到了這種堅定的技術熱情:「VAST 相信,當通用 3D 大模型的能力逐漸增強,用戶進行 3D 創作的門檻將不斷降低,真正的 3D 內容大爆發時代必然會到來,這就是屬于 VAST 這群年輕人的『OnePiece』。」CEO 宋亞宸表示。目前,VAST 還在構建一個交互式 3D 內容平臺,希望為全世界的專業人士和業余愛好者打造一個共享創作、發現作品和訪問定制 3D 資產的交流中心。或許在不久之后,3D 賽道也會出現像「ChatGPT」這樣的現象級產品,而 VAST 這家年輕的中國初創公司格外值得期待。

- 免責聲明

- 本文所包含的觀點僅代表作者個人看法,不代表新火種的觀點。在新火種上獲取的所有信息均不應被視為投資建議。新火種對本文可能提及或鏈接的任何項目不表示認可。 交易和投資涉及高風險,讀者在采取與本文內容相關的任何行動之前,請務必進行充分的盡職調查。最終的決策應該基于您自己的獨立判斷。新火種不對因依賴本文觀點而產生的任何金錢損失負任何責任。

新火種

2023-12-23

新火種

2023-12-23