中國學者拿下“半壁江山”!ICCV2021開幕,SwinTransformer摘得馬爾獎

:

作者 | 蔣寶尚、琰琰

剛剛,計算機視覺三大頂會之一的 ICCV 2021于線上拉開序幕。

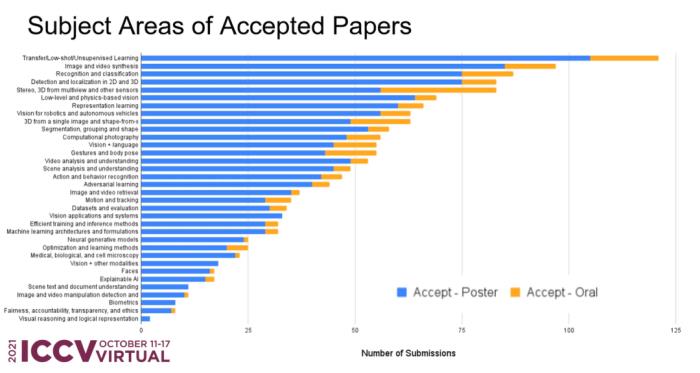

今年 ICCV收到有效投稿6236篇,1617篇被收錄,接收率為25.9%,其中210篇論文為oral。就總數來看,相比ICCV 2019,接收數量增加了1800篇。

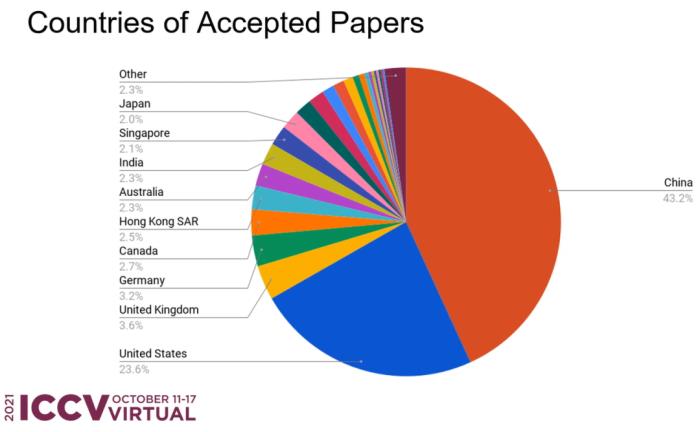

在這些論文中,中國學者幾乎拿下了“半壁江山”,占比45.7%,超過第二名美國近一倍,是第三名英國的近13倍。

而在優秀論文評選中,中國科學技術大學劉澤、西安交通大學的林宇桐、微軟的曹越合作的Swin Transformer拿下了馬爾獎(最佳論文)。

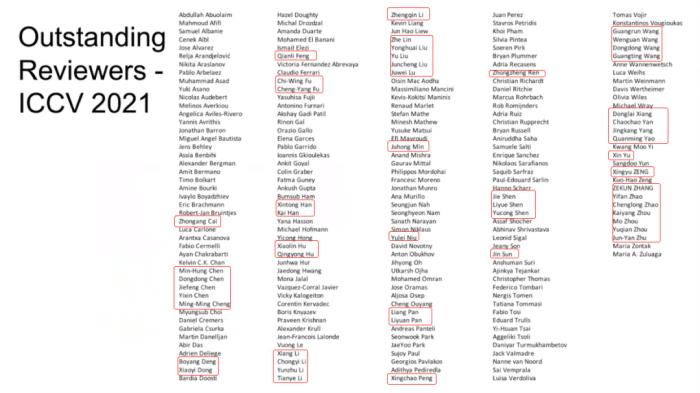

此外,在杰出評審名單中,中國學者至少上榜50位,占比23%。

據悉,為了選出這一千六百多篇論文,共有233位領域主席(AC)、4216位評審為之付出努力。為了保障論文質量,每篇論文至少接受3位評審的審閱,而能否拒稿是由“一對兒”領域主席決定的。

以下是馬爾獎、最佳學生論文的貢獻:

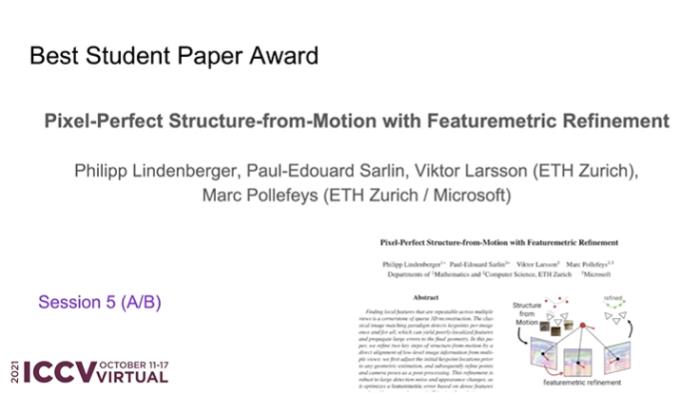

最佳學生論文:“Pixel-Perfect Structure-From-Motion With Featuremetric Refinement”

貢獻:提供了一種用于優化 SFM 建圖精度的方案,能夠大幅度提升建圖精度與后續的視覺定位精度。

馬爾獎:“Swin Transformer: Hierarchical Vision Transformer Using Shifted Windows”

貢獻:提出了名為Swin Transformer的新型視覺Transformer,它可以用作計算機視覺的通用骨干網絡。

獲獎論文之馬爾獎

論文題目:Swin Transformer: Hierarchical Vision Transformer Using Shifted Windows”

論文地址:https://arxiv.org/pdf/2103.14030.pdf

對于這篇文章的貢獻,作者曹越介紹:

1.之前的ViT(Vision Transformer)中,由于self-attention是全局計算的,所以在圖像分辨率較大時不太經濟。由于locality一直是視覺建模里非常有效的一種inductive bias,所以我們將圖片切分為無重合的window,然后在local window內部進行self-attention計算。為了讓window之間有信息交換,我們在相鄰兩層使用不同的window劃分(shifted window)。

2. 圖片中的物體大小不一,而ViT中使用固定的scale進行建模或許對下游任務例如目標檢測而言不是最優的。在這里我們還是follow傳統CNN構建了一個層次化的transformer模型,從4x逐漸降分辨率到32x,這樣也可以在任意框架中無縫替代之前的CNN模型。

Swin Transformer的這些特性使其可直接用于多種視覺任務,包括圖像分類(ImageNet-1K中取得86.4 top-1 acc)、目標檢測(COCO test-dev 58.7 box AP和51.1 mask AP)和語義分割(ADE20K 53.5 val mIoU,并在其公開benchmark中排名第一),其中在COCO目標檢測與ADE20K語義分割中均為state-of-the-art。

獲獎論文之最佳學生論文

論文標題:Pixel-Perfect Structure-From-Motion With Featuremetric Refinement

論文地址:https://arxiv.org/pdf/2108.08291.pdf

我們在幾何估計之前調整初始關鍵點位置,隨后作為后處理完善點和攝像機的位置。因為優化了基于神經網絡預測的密集特征的測量誤差,所以對噪聲檢測和外觀變化是穩健的。這也顯著提高了各種關鍵點檢測器算法、具有挑戰性的觀察條件和現成深度特征的相機pose和場景幾何體的準確性。該系統可以輕松擴展到大型圖像集,實現大規模像素完美密集定位。

目前,代碼已經開源:https://github.com/cvg/pixel-perfect-sfm

獲獎論文之榮譽提名論文

1.論文題目:“Mip-NeRF: A Multiscale Representation for Anti-Aliasing Neural Radiance Fields”

論文地址:https://arxiv.org/pdf/2103.13415.pdf

摘要:對于NeRF來說,通過每個像素渲染多條光線進行采樣是不切實際的,因為每條光線的渲染都需要查詢多層感知器上百次。在這項研究中,我們提出了一種名為“mip-NeRF”的擴展解決方案,它以連續值的比例表示場景。通過高效渲染消除反鋸齒圓錐錐體( anti-aliased conical frustums)取代光線,mip NeRF減少了混疊瑕疵,顯著提高了NeRF表示精細細節的能力,在速度上比NeRF 快了7%,大小僅為NeRF的一半。

此外,與NeRF相比,mip NeRF在數據集上降低了17%的平均錯誤率,在具有挑戰性的多尺度變體上降低了60%的平均錯誤率。Mip NeRF還能夠在多尺度數據集上與強力超采樣NeRF的精度相匹配,同時速度快22倍。

2.論文題目:OpenGAN: Open-Set Recognition via Open Data Generation

論文地址:https://arxiv.org/pdf/2104.02939.pdf

摘要:現實世界的機器學習系統需要分析與訓練數據不同的測試數據。在K-way分類中,這通常被表述為開集(open-set)識別,以區分 K閉集(closed-set)數據集。關于開集識別通常有兩種處理方案:1)使用一些離群數據作為開集,對開-閉二進制判別器分別進行判別學習(discriminatively learning an open-vs-closed binary discriminator by exploiting some outlier data as the open-set,);2)使用GAN,對閉集數據分布進行無監督學習,并使用其判別器作為開集似然函數。

然而,由于過度擬合訓練離散值,前者不能很好地推廣到不同的開放測試數據,而后者由于GANs訓練不穩定,效果也不好。基于以上問題,我們提出了一種新的解決方案OpenGAN,它解決了現有技術存在的局限,首先,在一些真實的離群數據上經過挑選的GAN鑒別器已經達到最先進的水平。第二,可用敵對合成的“假”數據來擴充可用的真實開集示例集。第三,也是最重要的一點,它可以在 K-way網絡計算的特征上構建鑒別器。大量實驗表明,OpenGAN的性能明顯優于以前的開集方法。

值得一提的是,該論文的第一作者Shu Kong也是一位華人學者。

3.論文標題:Viewing Graph Solvability via Cycle Consistency

論文鏈接:https://openaccess.thecvf.com/content/ICCV2021/papers/Arrigoni_Viewing_Graph_Solvability_via_Cycle_Consistency_ICCV_2021_paper.pdf

摘要:在SfM(Structure from motion)中,視圖的頂點代表相機,邊代表矩陣。我們在論文中設計了一組算法,能夠讓解算視圖,即確定唯一的投影相機(projective cameras)減少未知數的數量.

當前,已有的理論完全描述所有視圖的可解性,或者計算有難度,畢竟其涉及包含大量未知數的多項式方程組。本文的主要思想是:通過利用循環一致性(cycle consistency)。具體而言:

1.完成對所有先前未定最小圖(undecided minimal graphs)的分類,所謂最小是指:最多9個節點。

2.將實際的可解性測試擴展到最多90個節點的最小圖

3.明確回答了一個公開的研究問題,證明了有限可解性與可解性不等價。

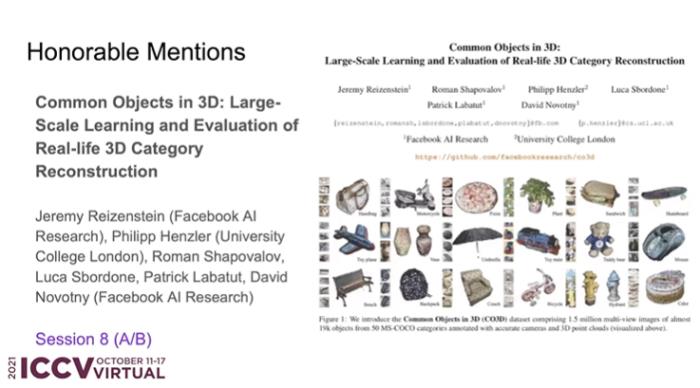

4.論文題目:Common Objects in 3D: Large-Scale Learning and Evaluation of Real-Life 3D Category Reconstruction

論文鏈接:https://arxiv.org/pdf/2109.00512.pdf

摘要:在過去,識別3D對象類別需要在合成數據集上進行訓練和評估,這是因為真實的3D注釋類別的中心數據不可用。為了促進相關研究的推進,我們收集了與現有合成數據相似的真實數據。在這項工作中,我們最主要貢獻是創建了 3D公共對象數據集(Common Objects in 3D),它全部來自真實世界,包含了對象類別的多視圖圖像,并使用攝影機姿勢和地面真實3D點云進行了注釋。

具體而言,該數據集包含近19000個視頻的150萬幀,這些視頻捕獲了50個MS-COCO類別的對象,因此,就類別和對象的數量而言,該數據集遠遠大于現有數據集。利用這個新數據集,我們對幾種新的視圖合成和以類別為中心的三維重建方法進行了一次大規模的“野外”評估。最后,我們還提出了一種新的神經渲染方法NerFormer,實驗證明,它利用強大的轉換器在給定少量視圖的情況下也能夠重建對象。

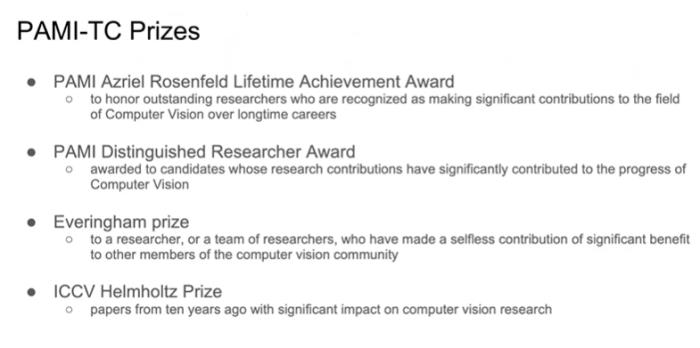

PAMI-TC 獎

ICCV 2021 組委會還頒布了過往杰出研究類獎項 PAMI-TC 獎,包括四個獎項:Azriel Rosenfeld終身成就獎、杰出學者獎,Everingham 獎和ICCV Helmholtz 獎。

其中,Azriel Rosenfeld終身成就獎頒發給了加州大學Berkeley 分校電氣工程與計算機科學系教授 RUzena Bajcsy,以表彰其長期以來在計算機視覺領域所作出的重大貢獻。

Bajcsy 博士是美國國家工程院 (1997) 和美國國家醫學科學院 (1995) 的成員,也是計算機協會 (ACM) 和美國人工智能協會 (AAAI) 成員。曾獲得了ACM/AAAI 艾倫紐厄爾獎,本杰明富蘭克林計算機和認知科學獎、 IEEE 機器人和自動化獎。2002 年,她還被《探索》雜志評為 50 位最重要的女性之一。主要從事機器人研究,包括計算機視覺、觸覺感知以及系統識別。

個人主頁:https://people.eecs.berkeley.edu/~bajcsy/?_ga=2.102438914.2095164583.1634049418-1623552618.1634049418)

PAMI杰出學者獎項頒發給了加州理工學院教授Pietro Perona和法國國家信息與自動化研究所(INRIA)研究員Cordelia Schmid。

Everingham獎頒發給了KITTI 視覺基準團隊和Detectron對象檢測和分割軟件團隊,其成員分別包括:

Andreas Geiger ,philip Lenz,Christoph Stiller,Raquel Urtasun and other contributors

RossGirshick,Yuxin Wu,llijiaRadosavovic,Alexander Kirllov ,GeorgiaGkioxari,Francisco Massa ,Wan-Yen Lo,Piotr Dollar,Kaiming He

ICCV Helmholtz 獎在獎勵對計算機視覺領域做出重要貢獻的工作,頒發對象是十年前對計算機視覺領域產生重大影響的論文。今年的 Helmholtz 獎頒給了三篇論文:

ORB:An efficient alternative to SIFT or SURF

HMDB:A large video datebase for human motion recognition

DTAM;Dense tracking and mapping in real-time

ICCV 2021投稿趨勢一覽

就接收論文分布領域而言,遷移\小樣本\無監督學習、圖像視頻合成、識別和分類位列前三甲,接收數量都超過了80篇。而新出現的領域,例如可解釋AI、公平、負責、透明和道德等研究主題的論文,其接收數量一直“上漲”。

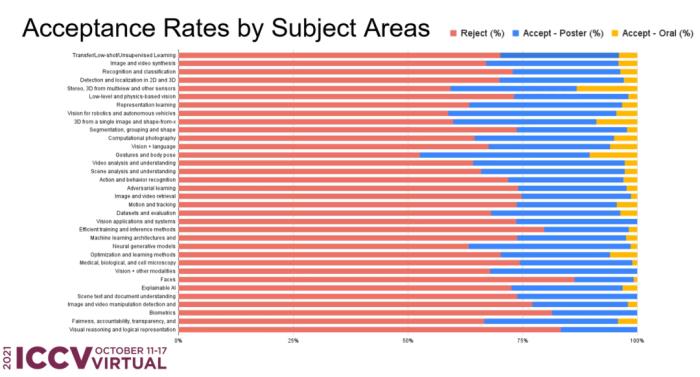

拋卻“論文的絕對數量”,通過比例觀察,可以明顯看出:手和身的姿態、機器和自動駕駛視覺、視頻分析和理解、倫理等領域接受率相差不大;視覺推理和邏輯表達領域接受率最低。

在國家層面,中國論文數量幾乎占據了“半壁江山”(43.2%+2.5%=45.7%),超過美國(23.6%)接近一半,超過第三名英國(3.6%)12倍.....

中國力量的另一個體現是杰出評審的數量,本屆ICCV總共評出了220位,粗略估計華人學者52位。

另外,據大會主席james clark介紹,本屆ICCV會維持三天,共有82個workshops,12個tutorial進行展示,研究主題涵蓋各個領域。

Clark特別點出了兩場特邀報告和三場討論。其中,麻省理工學院的Judith Donath和來自工業界的Caroline Sinders將會呈現計算機視覺和AI在社會中的應用,以及技術對社會的影響。

Clark特別點出了兩場特邀報告和三場討論。其中,麻省理工學院的Judith Donath和來自工業界的Caroline Sinders將會呈現計算機視覺和AI在社會中的應用,以及技術對社會的影響。

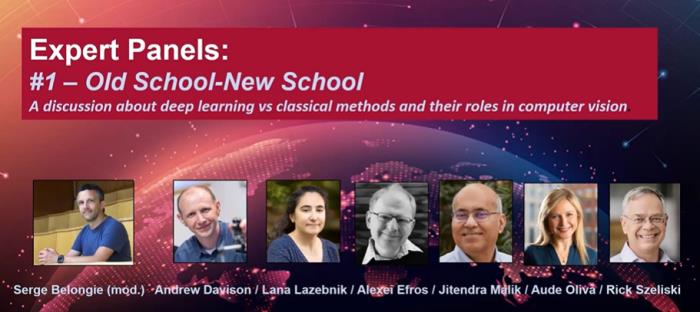

另外三場專家論壇將討論研究熱點,分別是:深度學習和傳統技法在計算機視覺中的比較;Deepfake和數據安全;計算機視覺和工業應用。

相關鏈接:

https://www.zhihu.com/question/437495132/answer/1800881612

雷鋒網雷鋒網

- 免責聲明

- 本文所包含的觀點僅代表作者個人看法,不代表新火種的觀點。在新火種上獲取的所有信息均不應被視為投資建議。新火種對本文可能提及或鏈接的任何項目不表示認可。 交易和投資涉及高風險,讀者在采取與本文內容相關的任何行動之前,請務必進行充分的盡職調查。最終的決策應該基于您自己的獨立判斷。新火種不對因依賴本文觀點而產生的任何金錢損失負任何責任。

新火種

2023-11-01

新火種

2023-11-01