又來:Hinton、Bengio等300余大佬、名人聯名警告AI滅世風險

人工智能存在「滅絕」級別的風險,未來的系統可能像核武器一樣致命。本周二,著名的人工智能學者、科技公司創始人團結了起來,發出呼吁。

公開信地址:https://www.safe.ai/statement-on-ai-risk

前有馬斯克、Bengio 等人發出公開信,叫停 GPT-4 后續 AI 大模型的研發,近期又有 OpenAI 高層發文探討「超級智能」監管問題,并表示像監管核武器一樣監管 AI。AI 可能引發的一系列風險問題正在得到大家越來越多的關注。

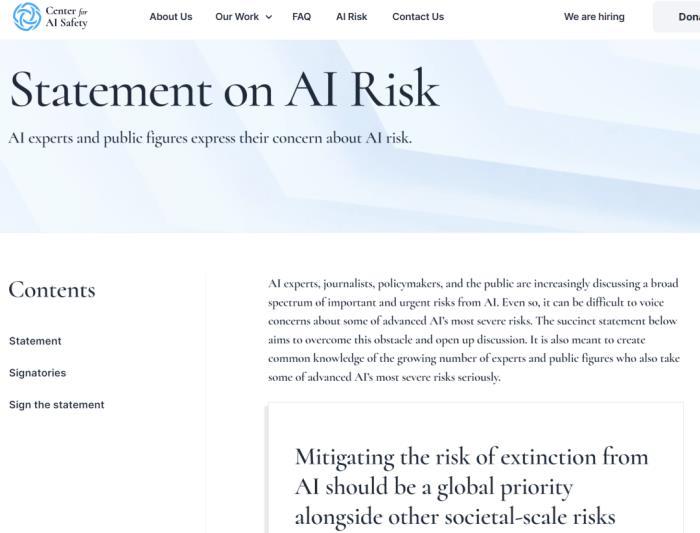

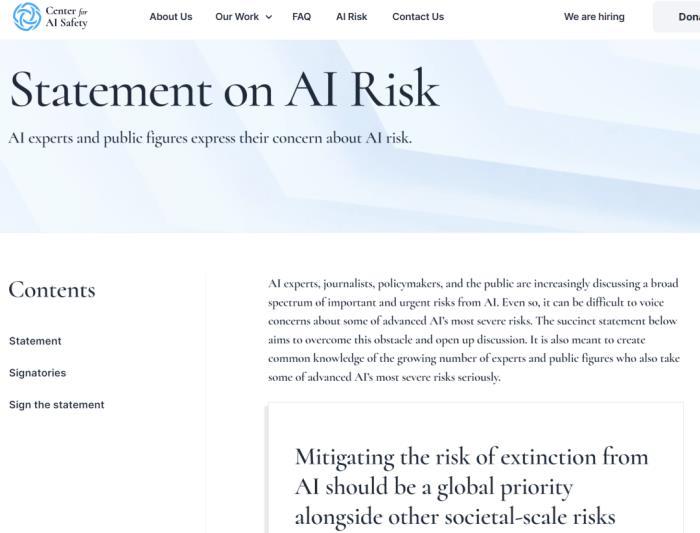

本周二,一封重要公開信《AI 風險聲明》引發了大量的議論。

這封信由非營利組織人工智能安全中心(CAIS)發布,370 多名 AI 專家在信上簽名,信中警告稱如果對先進人工智能的發展監管不當,可能會對人類構成生存威脅。

本公開信與以往不同,因為其中許多重要簽署者在 AI 實驗室、大型科技公司擔任要職。其中包括圖靈獎得主 Geoffrey Hinton、Yoshua Bengio,OpenAI 首席執行官 Sam Altman,Google DeepMind 聯合創始人兼 CEO Demis Hassabis,微軟首席技術官 Kevin Scott,谷歌副總裁 James Manyika,OpenAI 首席科學家 Ilya Sutskever,GAN 之父 Ian Goodfellow 等都已簽名。

部分公開信簽署人。

部分公開信簽署人。

公開信只有一句聲明:「減輕人工智能引發的滅絕風險應當與其他社會規模的風險(如大流行病和核戰爭)一樣成為全球的優先事項。」

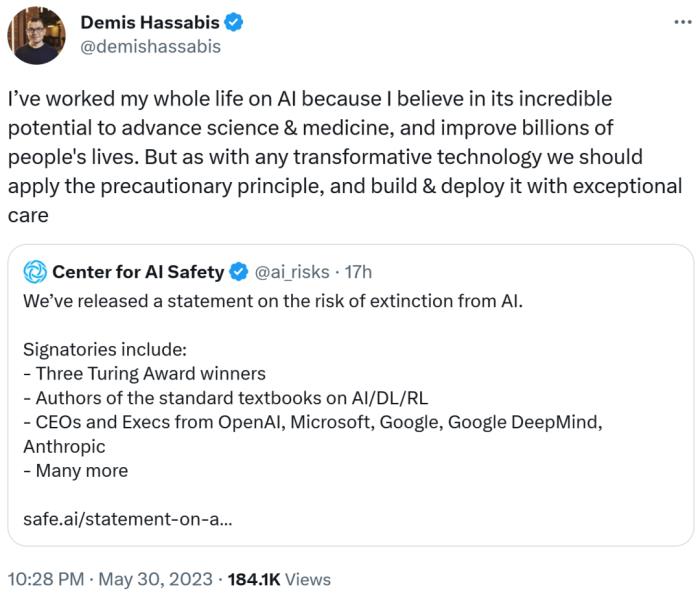

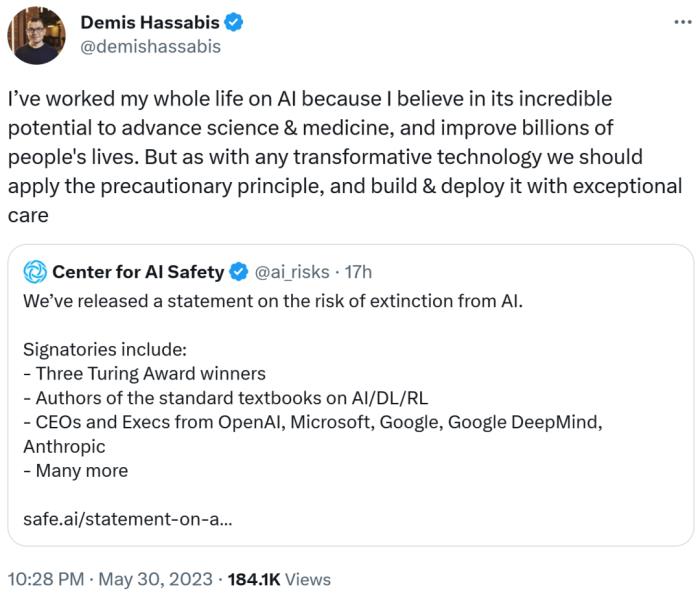

Demis Hassabis 還發表了自己的看法,「我一生都在研究人工智能,相信它在推動科學和醫學發展以及改善數十億人的生活方面具有不可思議的潛力。但與任何變革技術一樣,我們應該采取預防原則,并格外小心地構建和部署 AI。」

如今人們越來越擔心 ChatGPT 等 AI 模型的發展可能給人類帶來的潛在威脅。AI 在不斷發展的同時,但相應的監管卻遲遲沒有跟上。

不過一些 AI 研究者們已經意識到這一點,就在上個月,Hinton 離開谷歌,并表示希望不受公司隸屬關系的限制,就人工智能的潛在風險進行坦誠的討論。

針對 AI 風險的呼吁行動一直進行中

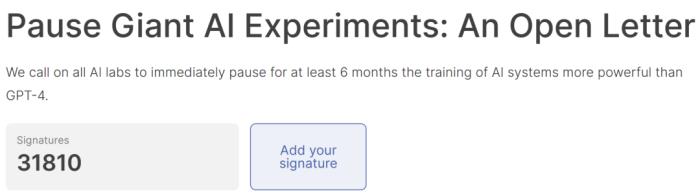

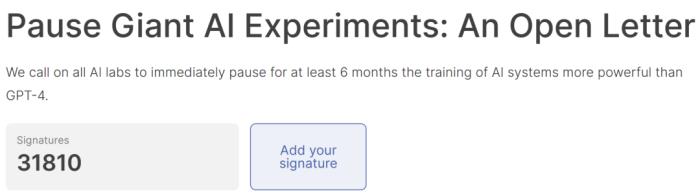

這份聯合聲明之前也有類似的倡議,3 月底上千名行業領袖和專家簽署公開信呼吁至少 6 個月內暫停開發比 GPT-4 更強大的 AI 系統,并警告 AI 的發展對社會和人類構成的潛在風險。當時,馬斯克、史蒂芬?沃茲尼克、Bengio 和 Gary Marcus 都在公開信中簽名。目前,這份公開信的署名人數已經超過了 31000 人。

公開信地址:https://futureoflife.org/open-letter/pause-giant-ai-experiments/

盡管已經有很多人呼吁對 AI 采取謹慎態度,但行業領導者和政策制定者對負責任地監管和開發人工智能的最佳方法幾乎沒有達成共識。

本月早些時候,包括 OpenAI CEO Sam Altman、Google DeepMind 聯合創始人兼 CEO Demis Hassabis 在內的科技領袖會見了美國總統拜登,討論了潛在的監管問題。在之后的參議院聽證上,Sam Altman 主張政府干預,并強調了先進 AI 系統帶來的嚴重風險以及對解決潛在危害進行監管的必要性。

Sam Altman

Sam Altman

在前幾天的一篇 OpenAI 博客中,該公司高管概述了負責任地管理 AI 系統的幾項建議,包括加強頂級 AI 研究者之間的合作、對大語言模型進行更加深入的技術研究以及建立國際 AI 安全組織等。該聲明進一步呼吁采取行動,敦促更廣泛的社區就 AI 未來及其對社會的潛在影響展開有意義的對話。

原文地址:https://openai.com/blog/democratic-inputs-to-ai

AI 倫理專家不以為然,不必過分關注假想中的風險

關于對假想中導致世界末日的 AI 風險采取行動,并不是所有人都對這些行業領袖和專家的觀點表示贊同,來自機器學習社區的質疑聲也是有的。其中,經常關注 AI 倫理的專家對這些不斷出現的公開信并不「感冒」。

Hugging Face 的機器學習研究科學家 Sasha Luccioni 將 CAIS 的新公開信看作是耍弄花招。首先將 AI 假設存在風險與流行病和氣候變化等非常切實的風險相提并論,這對公眾來說非常新鮮且能直達內心。但這也是一種誤導,將公眾的注意力吸引到未來風險上,這樣他們就不會過多地思考偏見、法律問題和許可等當前的有形風險。

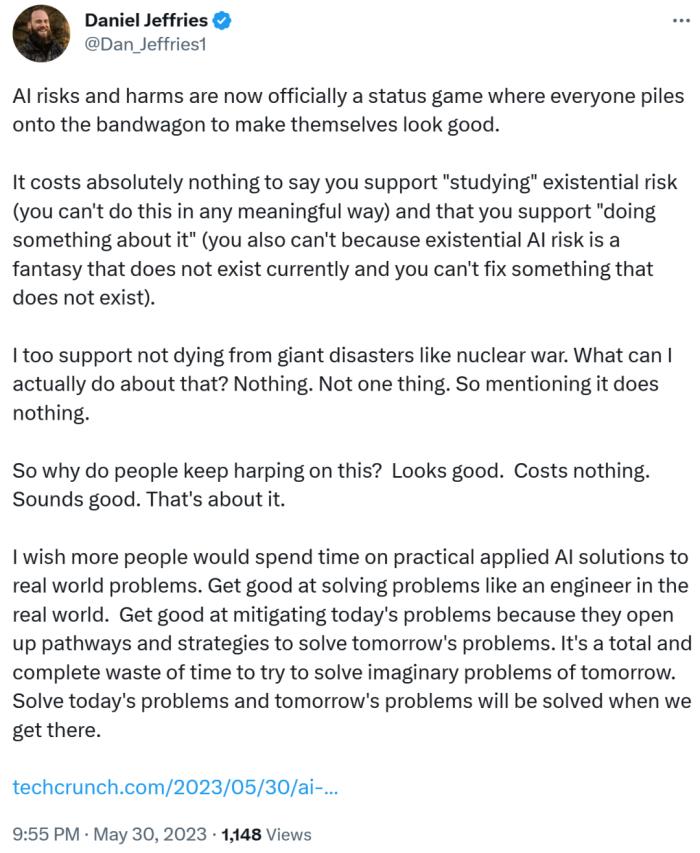

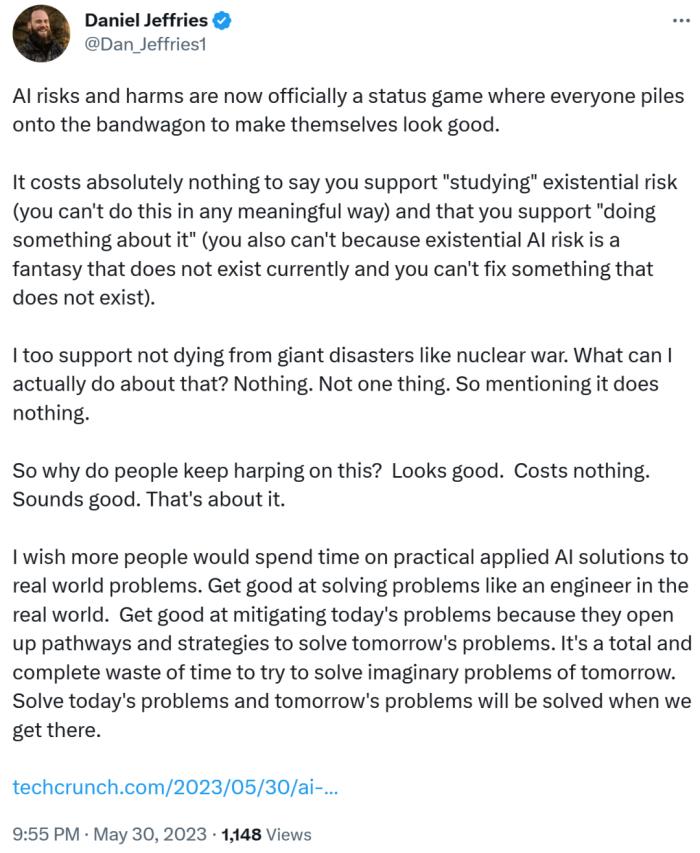

作家、未來學家 Daniel Jeffries 發推表示,「AI 的風險和危害現在正成為一種地位游戲,每個人都擠在這波潮流中讓自己看起來不錯…… 人們為什么一直在喋喋不休呢?或許是這些呼吁看起來不錯、也不花錢。就是這樣。」

因此,盡管有朝一日或許有一種先進的人工智能威脅到了人類,但將注意力集中在假想中的不清不楚的世界末日場景上并不富有建設性,也不會產生助益。人們不能老是將精力放在不存在的事情上。

正如 Daniel Jeffries 所言,「試圖解決明天想象中的問題完全是浪費時間。解決好今天的問題,明天的問題到時自然而然地就會解決。」

參考鏈接:https://venturebeat.com/ai/top-ai-researchers-and-ceos-warn-against-risk-of-extinction-in-joint-statement/https://arstechnica.com/information-technology/2023/05/openai-execs-warn-of-risk-of-extinction-from-artificial-intelligence-in-new-open-letter/https://www.nytimes.com/2023/05/30/technology/ai-threat-warning.html

公開信地址:https://www.safe.ai/statement-on-ai-risk

前有馬斯克、Bengio 等人發出公開信,叫停 GPT-4 后續 AI 大模型的研發,近期又有 OpenAI 高層發文探討「超級智能」監管問題,并表示像監管核武器一樣監管 AI。AI 可能引發的一系列風險問題正在得到大家越來越多的關注。

本周二,一封重要公開信《AI 風險聲明》引發了大量的議論。

這封信由非營利組織人工智能安全中心(CAIS)發布,370 多名 AI 專家在信上簽名,信中警告稱如果對先進人工智能的發展監管不當,可能會對人類構成生存威脅。

本公開信與以往不同,因為其中許多重要簽署者在 AI 實驗室、大型科技公司擔任要職。其中包括圖靈獎得主 Geoffrey Hinton、Yoshua Bengio,OpenAI 首席執行官 Sam Altman,Google DeepMind 聯合創始人兼 CEO Demis Hassabis,微軟首席技術官 Kevin Scott,谷歌副總裁 James Manyika,OpenAI 首席科學家 Ilya Sutskever,GAN 之父 Ian Goodfellow 等都已簽名。

部分公開信簽署人。

部分公開信簽署人。公開信只有一句聲明:「減輕人工智能引發的滅絕風險應當與其他社會規模的風險(如大流行病和核戰爭)一樣成為全球的優先事項。」

Demis Hassabis 還發表了自己的看法,「我一生都在研究人工智能,相信它在推動科學和醫學發展以及改善數十億人的生活方面具有不可思議的潛力。但與任何變革技術一樣,我們應該采取預防原則,并格外小心地構建和部署 AI。」

如今人們越來越擔心 ChatGPT 等 AI 模型的發展可能給人類帶來的潛在威脅。AI 在不斷發展的同時,但相應的監管卻遲遲沒有跟上。

不過一些 AI 研究者們已經意識到這一點,就在上個月,Hinton 離開谷歌,并表示希望不受公司隸屬關系的限制,就人工智能的潛在風險進行坦誠的討論。

針對 AI 風險的呼吁行動一直進行中

這份聯合聲明之前也有類似的倡議,3 月底上千名行業領袖和專家簽署公開信呼吁至少 6 個月內暫停開發比 GPT-4 更強大的 AI 系統,并警告 AI 的發展對社會和人類構成的潛在風險。當時,馬斯克、史蒂芬?沃茲尼克、Bengio 和 Gary Marcus 都在公開信中簽名。目前,這份公開信的署名人數已經超過了 31000 人。

公開信地址:https://futureoflife.org/open-letter/pause-giant-ai-experiments/

盡管已經有很多人呼吁對 AI 采取謹慎態度,但行業領導者和政策制定者對負責任地監管和開發人工智能的最佳方法幾乎沒有達成共識。

本月早些時候,包括 OpenAI CEO Sam Altman、Google DeepMind 聯合創始人兼 CEO Demis Hassabis 在內的科技領袖會見了美國總統拜登,討論了潛在的監管問題。在之后的參議院聽證上,Sam Altman 主張政府干預,并強調了先進 AI 系統帶來的嚴重風險以及對解決潛在危害進行監管的必要性。

Sam Altman

Sam Altman在前幾天的一篇 OpenAI 博客中,該公司高管概述了負責任地管理 AI 系統的幾項建議,包括加強頂級 AI 研究者之間的合作、對大語言模型進行更加深入的技術研究以及建立國際 AI 安全組織等。該聲明進一步呼吁采取行動,敦促更廣泛的社區就 AI 未來及其對社會的潛在影響展開有意義的對話。

原文地址:https://openai.com/blog/democratic-inputs-to-ai

AI 倫理專家不以為然,不必過分關注假想中的風險

關于對假想中導致世界末日的 AI 風險采取行動,并不是所有人都對這些行業領袖和專家的觀點表示贊同,來自機器學習社區的質疑聲也是有的。其中,經常關注 AI 倫理的專家對這些不斷出現的公開信并不「感冒」。

Hugging Face 的機器學習研究科學家 Sasha Luccioni 將 CAIS 的新公開信看作是耍弄花招。首先將 AI 假設存在風險與流行病和氣候變化等非常切實的風險相提并論,這對公眾來說非常新鮮且能直達內心。但這也是一種誤導,將公眾的注意力吸引到未來風險上,這樣他們就不會過多地思考偏見、法律問題和許可等當前的有形風險。

作家、未來學家 Daniel Jeffries 發推表示,「AI 的風險和危害現在正成為一種地位游戲,每個人都擠在這波潮流中讓自己看起來不錯…… 人們為什么一直在喋喋不休呢?或許是這些呼吁看起來不錯、也不花錢。就是這樣。」

因此,盡管有朝一日或許有一種先進的人工智能威脅到了人類,但將注意力集中在假想中的不清不楚的世界末日場景上并不富有建設性,也不會產生助益。人們不能老是將精力放在不存在的事情上。

正如 Daniel Jeffries 所言,「試圖解決明天想象中的問題完全是浪費時間。解決好今天的問題,明天的問題到時自然而然地就會解決。」

參考鏈接:https://venturebeat.com/ai/top-ai-researchers-and-ceos-warn-against-risk-of-extinction-in-joint-statement/https://arstechnica.com/information-technology/2023/05/openai-execs-warn-of-risk-of-extinction-from-artificial-intelligence-in-new-open-letter/https://www.nytimes.com/2023/05/30/technology/ai-threat-warning.html

相關推薦

- 免責聲明

- 本文所包含的觀點僅代表作者個人看法,不代表新火種的觀點。在新火種上獲取的所有信息均不應被視為投資建議。新火種對本文可能提及或鏈接的任何項目不表示認可。 交易和投資涉及高風險,讀者在采取與本文內容相關的任何行動之前,請務必進行充分的盡職調查。最終的決策應該基于您自己的獨立判斷。新火種不對因依賴本文觀點而產生的任何金錢損失負任何責任。

新火種

2023-10-29

新火種

2023-10-29