昨晚的「云計算春晚」,大模型、芯片連發(fā),比OpenAI、谷歌上新都猛

機器之心報道

機器之心編輯部

亞馬遜云科技上演了一場生成式 AI 能力的「王者歸來」。

今天凌晨,有「云計算春晚」之稱的 re:Invent 大會在美國拉斯維加斯開幕。亞馬遜云科技一下子搬出了全新大模型 Nova 系列,性能比肩英偉達旗艦的 AI 訓(xùn)練芯片,與之對應(yīng)的算力服務(wù),并對 Amazon Bedrock 進行了一番從頭到腳的升級。

登臺演講之前,亞馬遜云科技新任 CEO Matt Garman 提出了一個發(fā)人深省的觀點:人工智能是一場沒有終點的競賽,它將永遠持續(xù)下去。

這場競賽其實還處在開始階段,經(jīng)歷了「All in 大模型」的瘋狂之后,大家確實在思考:面對這場持久戰(zhàn),接下來要重點關(guān)注「細水長流」了。

對于各行各業(yè)的用戶來說,可持續(xù)發(fā)展問題首先是成本問題。如果說去年的我們還在摸索如何適應(yīng)新的生成式 AI 技術(shù),那么到了 2024 年的末尾,更重要的是:如何持續(xù)降低生成式 AI 的應(yīng)用成本,換言之,提升生成式 AI 技術(shù)應(yīng)用的性價比。

在今天凌晨的 Keynote 中,Matt Garman 分享了亞馬遜云科技在人工智能和計算等領(lǐng)域的「新技術(shù)、新產(chǎn)品、新服務(wù)」,生成式 AI 技術(shù)棧再次煥新。

我們看到了相當前沿的一波技術(shù)能力,源源不斷地震撼發(fā)布。與此同時,技術(shù)落地成本降低到了難以置信的程度。

這一切升級,的確稱得上「真正革命性的變化」。風(fēng)云變幻的生成式 AI 時代,亞馬遜云科技又一次「Hold 住全場」。

成本直降 75%

全模態(tài) Amazon Nova 將「性價比」做到極致

去年 4 月,亞馬遜云科技剛剛加入生成式 AI 大模型之戰(zhàn),發(fā)布的 Amazon Titan 系列模型當時僅支持文本內(nèi)容生成和創(chuàng)建高效搜索。一年多過去,亞馬遜云科技已經(jīng)在基礎(chǔ)模型層完成了全面的布局,向覆蓋文本、圖像、視頻和語音的全模態(tài)體系發(fā)起沖擊,在與 OpenAI、谷歌、Anthropic 等主流大模型廠商的競爭中,絲毫不落下風(fēng)。

本次 re:Invent 大會上,全新自研生成式 AI 多模態(tài) Amazon Nova 系列模型正式亮相,不僅在多種任務(wù)中達到了 SOTA 智能水平,更在性價比層面實現(xiàn)了業(yè)界領(lǐng)先。

亞馬遜總裁兼 CEO 安迪?賈西(Andy Jassy)。

此次發(fā)布的 Amazon Nova 系列模型共四個版本:純文本模型 Amazon Nova Micro,支持 128k 上下文,能夠以極低成本實現(xiàn)最低延遲響應(yīng);成本極低的多模態(tài)模型 Amazon Nova Lite,支持 300k 上下文或 30 分鐘視頻輸入,可以快速處理圖像、視頻和文本;功能強大的多模態(tài)模型 Amazon Nova Pro,同樣支持 300k 上下文或 30 分鐘視頻輸入,兼顧準確性、速度和成本,適用于各種任務(wù);功能最強的多模態(tài)模型 Amazon Nova Premier,可用于復(fù)雜推理任務(wù),并用作自定義蒸餾模型的最佳教師模型。

模型好不好,先跑個分。從打榜結(jié)果來看,Amazon Nova 系列模型經(jīng)受住了各種行業(yè)基準測試,直接挑戰(zhàn)了 GPT-4o、Gemini 1.5 Pro 和 Claude 3.5 Sonnet V2 這樣的頂級選手。

Amazon Nova Pro 與 GPT-4o、Gemini 1.5 Pro 和 Claude 3.5 Sonnet V2 的比較。

一方面,純文本 Amazon Nova Micro 在與 LLaMa 3.1 8B、Gemini 1.5 Flash-8B 的較量中取得了相當或者更優(yōu)的表現(xiàn)。Micro 210 tokens/s 的輸出速度實現(xiàn)了業(yè)界領(lǐng)先,對于需要快速響應(yīng)的應(yīng)用程序而言,Micro 是最佳選擇。

另一方面,多模態(tài) Amazon Nova Lite 和 Amazon Nova Pro 與 OpenAI、谷歌和 Anthropic 等主流廠商相比,在絕大多數(shù)基準上表現(xiàn)相當甚至更好。尤其在處理輕量級任務(wù)時,Lite 是當前成本最低的多模態(tài)模型。

目前,Amazon Nova Micro、Lite、Pro 三款模型均已推出,并集成到了 Amazon Bedrock 中,支持自定義微調(diào)和蒸餾。Amazon Nova Premier 則將于 2025 年第一季度問世。

在性能全方位加強之外,Amazon Nova 系列模型中 Micro、Lite 和 Pro 的價格至少比 Amazon Bedrock 中各個智能類別中的最強模型要便宜 75%。對于有大模型服務(wù)調(diào)用需求、預(yù)算不高但又不想在模型效果上打折扣的客戶來說,Nova 系列無疑是一個性價比極高的選擇。

另外,在圖像和視頻生成模型百花競艷的當下,亞馬遜云科技也秀了一把內(nèi)容創(chuàng)作實力。獨立的圖像生成模型 Amazon Nova Canvas 和視頻生成模型 Amazon Nova Reel 悉數(shù)登場:Canvas 支持圖像生成和編輯,提供豐富的配色方案和布局控件;Reel 可根據(jù)關(guān)鍵提示詞和參考圖像生成 6 秒視頻,支持用戶調(diào)整攝像頭運動以進行平移、360 旋轉(zhuǎn)和縮放,未來還會支持 2 分鐘視頻生成。

提示詞:一只狗在很開心地兜風(fēng)。狗的嘴巴張開時要注意舌頭的位置。

最后,安迪?賈西還預(yù)告了另外兩款 Amazon Nova 模型,分別是 Amazon Nova Speech-to-Speech 和 Amazon Nova Any-to-Any。前者要實現(xiàn)自然、類人的口頭交互,后者旨在用同一個模型解決多種任務(wù),包括多模態(tài)轉(zhuǎn)換、內(nèi)容編輯以及 AI 智能體操作。這兩款模型預(yù)計將先后于 2025 年第一季度和中期與大家見面。

從文本到視頻的 Amazon Nova 模型一次性全部上線,下一步計劃也直接對標最新方向。亞馬遜云科技自研大模型的進化速度,著實讓全場觀眾都震撼了一下。

自動蒸餾,多智能體協(xié)作,還能搞定 LLM 幻覺

Amazon Bedrock 又變強了

自生成式 AI 爆發(fā)兩年多以來,亞馬遜云科技的人工智能戰(zhàn)略一直沒有改變,那就是希望作為一個中立且有能力的平臺,為企業(yè)、開發(fā)者們提供靈活的、領(lǐng)先的 AI 模型選擇。

除了聚合一批頂尖模型,在工具層,亞馬遜云科技也一直在確保用戶能夠擁有最先進的技術(shù)。

這次大會,亞馬遜云科技基礎(chǔ)模型托管服務(wù) Amazon Bedrock 的更新直指企業(yè)用戶當下急需的技術(shù)能力。

首先是幫助對大模型進行蒸餾的 Amazon Bedrock Model Distillation,它通過從大型基礎(chǔ)模型(被稱為教師模型)生成響應(yīng),并用生成結(jié)果來微調(diào)較小的基礎(chǔ)模型(被稱為學(xué)生模型),可以自動為特定用例創(chuàng)建優(yōu)化版模型。

有了這項功能,用戶可以快速構(gòu)建實用化的生成式 AI 模型,并提高小模型的準確性,通過知識轉(zhuǎn)移過程獲得大體量模型的大部分能力,或是針對特定用例提煉專有模型。據(jù)亞馬遜云科技介紹,經(jīng)過優(yōu)化的模型比原始大型模型快五倍,計算成本低 75%,對于檢索增強生成 (RAG) 等用例,準確度損失不到 2%。

另外一項新推出的服務(wù) Automated Reasoning checks,賦予用戶通過自動推理減少大模型幻覺、檢查提高對話式 AI 準確性。這意味著,可以通過交叉引用提供的信息來驗證大模型響應(yīng)是否準確,自動推理檢查是消除幻覺的「第一個」也是「唯一」的保障。

具體來說,當大模型生成響應(yīng)時,自動推理檢查會對其進行驗證,使用「邏輯準確」和「可驗證的推理」得出結(jié)論。如果可能出現(xiàn)幻覺,則系統(tǒng)根據(jù)基本事實得出正確答案。該答案與可能的錯誤信息一起呈現(xiàn),人們可以直觀地看到模型偏離了多遠。

基礎(chǔ)模型之上,大模型領(lǐng)域的競爭已經(jīng)升級到「智能體」(Agent)階段,Anthropic、微軟等公司紛紛推出了桌面級的智能體應(yīng)用,它們大大擴展了大模型執(zhí)行任務(wù)的范圍,比如網(wǎng)購、發(fā)郵件、訂票,就像是打通了大模型落地的最后一關(guān)。

亞馬遜云科技同樣加重了對 Agent 的投入。現(xiàn)在,Amazon Bedrock 已經(jīng)上新了實現(xiàn)大模型多智能體協(xié)作的工具。

構(gòu)建有效多智能體協(xié)作系統(tǒng)的關(guān)鍵在于管理大規(guī)模協(xié)調(diào)多個專業(yè)智能體的復(fù)雜性和開銷。Amazon Bedrock 簡化了其過程,幫助人們將復(fù)雜任務(wù)分解為多個子任務(wù),利用專業(yè) AI 能力進行解決,提高了多智能體協(xié)作框架在解決復(fù)雜的現(xiàn)實問題方面的協(xié)調(diào)能力、通信速度和整體有效性。

至此,我們能夠很清晰地看出:Amazon Bedrock 的進化對應(yīng)了用戶在應(yīng)用生成式 AI 過程中所面臨的幾大挑戰(zhàn) —— 大模型推理的算力需求、大模型的準確性,以及多智能體操作。

當技術(shù)飛速進化時,用戶需求的變化速度往往超出需求。不過這些艱難的關(guān)卡,已經(jīng)被 Amazon Bedrock 逐個擊破了。

新一代 AI 芯片 Trainium 面世

算力革命正在路上

如果你需要運行科學(xué)計算或大型 AI 模型,那就需要大范圍、低延遲的網(wǎng)絡(luò)來連接所有 GPU 節(jié)點,亞馬遜云科技可以提供迄今為止業(yè)內(nèi)最快、最易擴展的算力。

十年來,AI 行業(yè)已經(jīng)形成了一個共識:模型之所以能夠?qū)崿F(xiàn)參數(shù)量規(guī)模和計算復(fù)雜度的持續(xù)增長,得益于強大算力的支撐。

此前,我們可以從兩個較為簡單的維度來理解這個結(jié)論:要么向上擴展,使用更大的計算機;要么向外擴展,使用更多的計算機。

但在生成式 AI 時代,由于涉及數(shù)十億甚至上千億的參數(shù),設(shè)計、訓(xùn)練和部署模型都需要消耗大量的計算資源。比如,每次訓(xùn)練都需要對海量數(shù)據(jù)進行復(fù)雜的矩陣運算和梯度計算,對算力基礎(chǔ)設(shè)施的要求已不可同日而語。

對于想要應(yīng)用生成式 AI 的企業(yè)來說,想要保持對 OpenAI、谷歌等頂尖公司的追趕,這意味著要購買越來越多的高端芯片和云服務(wù),支出的計算成本因此顯著上漲。Gartner 分析稱,到 2025 年,隨著 AI 技術(shù)基礎(chǔ)設(shè)施的不斷升級,各個云支出領(lǐng)域的增長率都將達到兩位數(shù)。

現(xiàn)在,核心問題已經(jīng)變成了:如何在算力資源供應(yīng)短缺的大環(huán)境下擴大算力來源,以及如何在大模型產(chǎn)生高昂計算成本壓力下極致高效地利用算力。

對于眾多企業(yè)用戶來說,亞馬遜云科技的自研 AI 芯片提供了一個速度更快、能耗更低的優(yōu)質(zhì)選項。

Trainium 是亞馬遜云科技自研的 AI 芯片,2020 年首次推出,曾一度被認為是訓(xùn)練 AI 模型最具效率的芯片。

在這次的 re:Invent 大會上,亞馬遜云科技宣布 Trainium2 芯片全面正式可用,幫助行業(yè)訓(xùn)練和部署大型語言模型。Trainium2 在一年前首次發(fā)布,速度是其上一代產(chǎn)品的四倍。

單個 Trainium2 驅(qū)動的 EC2 實例配有 16 個 Trainium2 芯片,可提供高達 20.8 PetaFLOPS 的計算性能。在測試中,與其他云服務(wù)商的類似產(chǎn)品相比,使用 Amazon Bedrock Trn2 EC2 實例的 Llama 3.1 405B 模型 token 生成吞吐量提高了三倍以上。

另一個非常值得關(guān)注的消息是:亞馬遜云科技和 Anthropic 正在合作構(gòu)建一個名為 Project Rainier 的 Trn2 UltraServer 集群。

生成式 AI 爆發(fā)后,Anthropic 就大量使用了亞馬遜云科技的算力設(shè)施。在大模型賽道上,Anthropic 始終是對 OpenAI 追趕得最緊的一位玩家。今年 11 月底,亞馬遜宣布向 Anthropic 追加 40 億美元投資,這筆交易后,對 Anthropic 的投資總額達到 80 億美元。基于深厚的合作關(guān)系,Anthropic 后續(xù)將用亞馬遜云科技的 Trainium AI 芯片來訓(xùn)練和運行其 AI 模型。

Project Rainier 這個集群會包含數(shù)十萬個 Trainium2 芯片,為 Anthropic 提供了足夠的可擴展分布式計算能力訓(xùn)練下一代大模型。與 Anthropic 用于訓(xùn)練其當前一代模型的集群相比,新集群的計算能力達到其 5 倍,并將成為迄今為止全球最大的 AI 計算集群。

對于規(guī)模更大的萬億級參數(shù) LLM,亞馬遜發(fā)布了第二層 Trianium2 實例 Trn2 UltraServer,同時提供 64 個 Trainium2 芯片用于 AI 模型訓(xùn)練或推理。它將允許用戶超越單個 Trn2 服務(wù)器的限制,可以提供高達 83.2 PetaFLOPS 峰值計算能力。

與此同時,亞馬遜云科技的下一代自研 AI 芯片也在路上了:Trainium3 是這家科技公司第一款采用 3nm 工藝制造的芯片,將提供兩倍于 Trainium2 的性能,能耗降低為 40%。它的性能將比肩英偉達的新一代 AI 芯片。

首批基于 Trainium3 的實例預(yù)計將于 2025 年上市。亞馬遜云科技表示,搭載 Trainium3 的 UltraServer 預(yù)計性能會比搭載 Trainium2 芯片的 UltraServer 高出四倍。

在生成式 AI 技術(shù)突飛猛進的情況下,不斷進化的亞馬遜云科技為用戶提供了一個安心的「算力」選項。當人們熱議「追逐 Scaling Law 還有沒有意義」的時候,至少不斷進化的 Trainium 系列和亞馬遜云科技長期以來構(gòu)建的一整套 AI 基礎(chǔ)設(shè)施,能讓千行百業(yè)的用戶在這場浪潮中找到「船槳」。

生成式 AI 走向應(yīng)用的「底層邏輯」

此外,亞馬遜云科技還在新版本的 Amazon SageMaker 上簡化了數(shù)據(jù)和 AI 資產(chǎn)管理的功能,并為 Amazon Aurora 云數(shù)據(jù)庫大幅提升了吞吐速度。

從新一代大模型,到開發(fā)工具、管理平臺、芯片,再到數(shù)據(jù)處理模塊。從今天的發(fā)布會上我們可以看出,亞馬遜云科技一直在強調(diào)大模型全鏈路技術(shù)在新一代應(yīng)用中將要起到的關(guān)鍵作用。

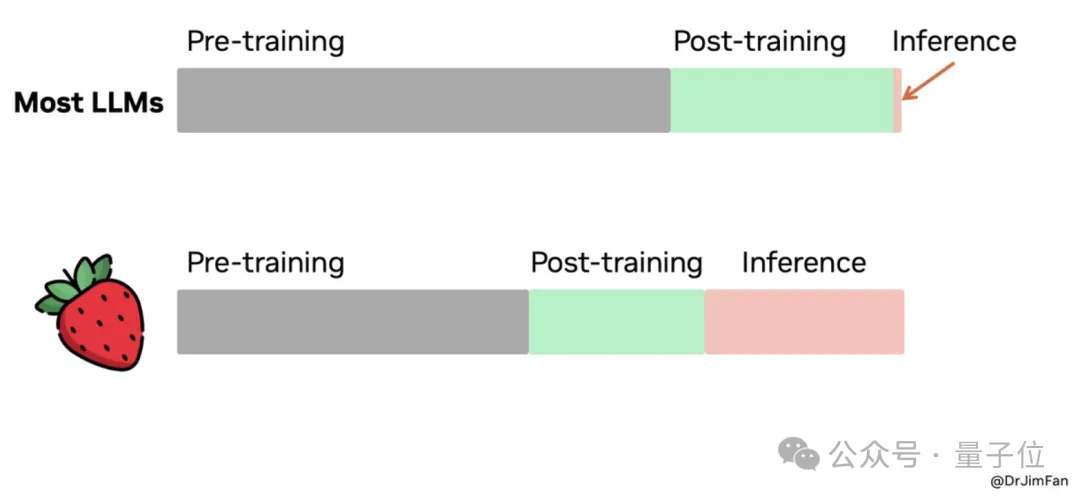

與讓大模型學(xué)會新技能的「訓(xùn)練」相對應(yīng)的是,推理是 AI 模型生成預(yù)測或輸出的過程,代表著模型的應(yīng)用。從行業(yè)角度看:隨著 AI 技術(shù)的成熟,生成式 AI 的一次次推理最終會推動很多行業(yè)發(fā)生變革。而從技術(shù)的角度看:在開發(fā)者調(diào)用 AI 能力時,其背后從硬件到算法、應(yīng)用,計算的全流程,僅僅優(yōu)化兩個字,卻包含著無數(shù)的技術(shù)實踐的努力。

在生成式 AI 技術(shù)落地的過程中,不斷整合先進的 AI 能力,并將基礎(chǔ)設(shè)施無縫集成,保證易于使用,是亞馬遜云科技的目標。

亞馬遜云科技正在全流程降低生成式 AI 構(gòu)建的門檻。從某種層面上來說,如果 OpenAI 是在為大模型通向 AGI 探索方向,亞馬遜云科技就是在為生成式 AI 技術(shù)應(yīng)用落地鋪路。

這其中的一系列工作,重要性不言而喻,而且和競爭者相比,亞馬遜云科技已經(jīng)全方位拉開了代差。

- 免責(zé)聲明

- 本文所包含的觀點僅代表作者個人看法,不代表新火種的觀點。在新火種上獲取的所有信息均不應(yīng)被視為投資建議。新火種對本文可能提及或鏈接的任何項目不表示認可。 交易和投資涉及高風(fēng)險,讀者在采取與本文內(nèi)容相關(guān)的任何行動之前,請務(wù)必進行充分的盡職調(diào)查。最終的決策應(yīng)該基于您自己的獨立判斷。新火種不對因依賴本文觀點而產(chǎn)生的任何金錢損失負任何責(zé)任。

機器之心

2024-12-05

機器之心

2024-12-05