能聽懂口音的開源語音系統(tǒng)來了:OpenAI出品,支持99種語言

羿閣 發(fā)自 凹非寺量子位 | 公眾號 QbitAI

逼近人類水平的語音識別系統(tǒng)來了?

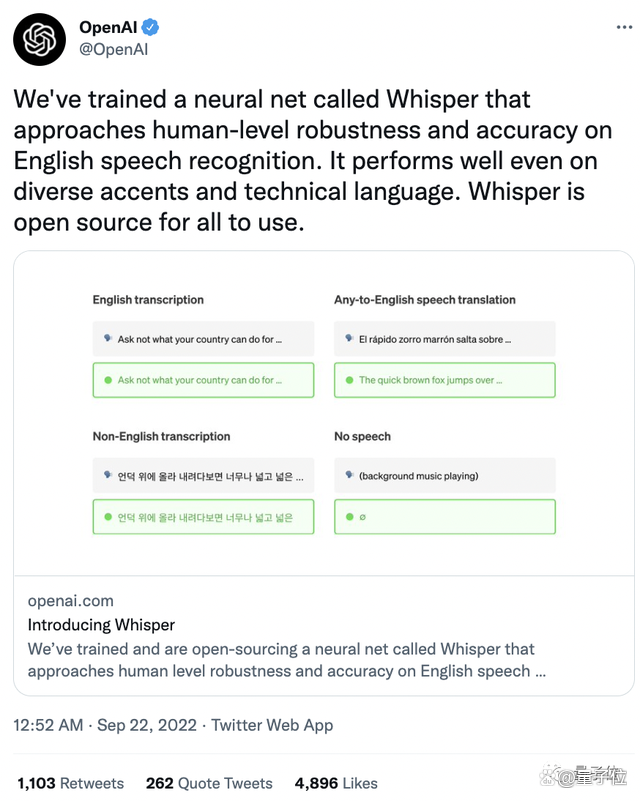

沒錯,OpenAI新開源了一個名為「Whisper」的新語音識別系統(tǒng),據(jù)稱在英文語音識別方面擁有接近人類水平的魯棒性和準(zhǔn)確性!

不僅如此,對于不同口音、專業(yè)術(shù)語的識別效果也是杠杠的!

一經(jīng)發(fā)布就在推特上收獲4800+點贊,1000+轉(zhuǎn)發(fā)。

網(wǎng)友們紛紛對它意料之外的強大功能表示驚訝。

不僅是英文,有人用法國詩人波德萊爾的《惡之花》進(jìn)行了語音測試,得到的文本幾乎與原文一致。

OpenAI聯(lián)合創(chuàng)始人&首席科學(xué)家Ilya Sutskever就表示:

終于有一個靠譜的語音識別系統(tǒng)能聽懂我的口音了。

前任特斯拉人工智能總監(jiān)Andrej Karpathy甚至轉(zhuǎn)發(fā)評論:OpenAI正處于最好的狀態(tài)中。

話不多說,讓我們看看這個被“好評如潮”的語音系統(tǒng)究竟是怎么回事。

逼近人類水平的語音識別系統(tǒng)

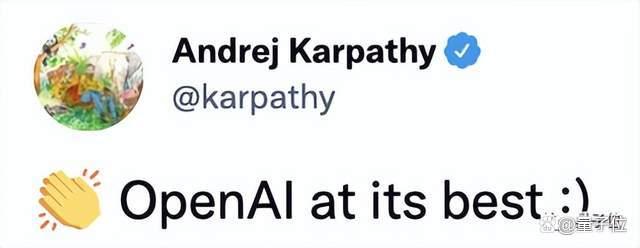

首先,Whisper最大特點是它使用的超大規(guī)模訓(xùn)練集:

它使用從網(wǎng)絡(luò)上收集的68萬小時的多語言、多任務(wù)監(jiān)督數(shù)據(jù)進(jìn)行訓(xùn)練。

這導(dǎo)致數(shù)據(jù)集的內(nèi)容非常多元化,涵蓋了許多不同環(huán)境、不同錄音設(shè)備下、不同語言的音頻。

具體而言,65%(438218小時)是英語音頻和匹配的英語文本,大約18%(125739小時)是非英語音頻和英語文本,而最后17%(117113小時)則是非英語音頻和相應(yīng)的文本。

其中,非英語部分共包含98種不同語言。

不過,雖然音頻質(zhì)量的多樣性可以幫助提高訓(xùn)練模型的魯棒性,但轉(zhuǎn)錄文本質(zhì)量的多樣性并不是同樣有益的。

初步檢查顯示,原始數(shù)據(jù)集中有大量不合格的、現(xiàn)有自動語音識別(ASR)系統(tǒng)生成的轉(zhuǎn)錄文本。

而以往的研究表明,在人工和機器混合生成的數(shù)據(jù)集上進(jìn)行訓(xùn)練,會顯著損害翻譯系統(tǒng)的性能。

為了解決這個問題,研究團隊開發(fā)了幾種自動過濾方法來識別和刪除低質(zhì)量的數(shù)據(jù)源。

但值得一提的是,沒有說話內(nèi)容的片段會被留下,作為語音活動檢測的訓(xùn)練數(shù)據(jù)。

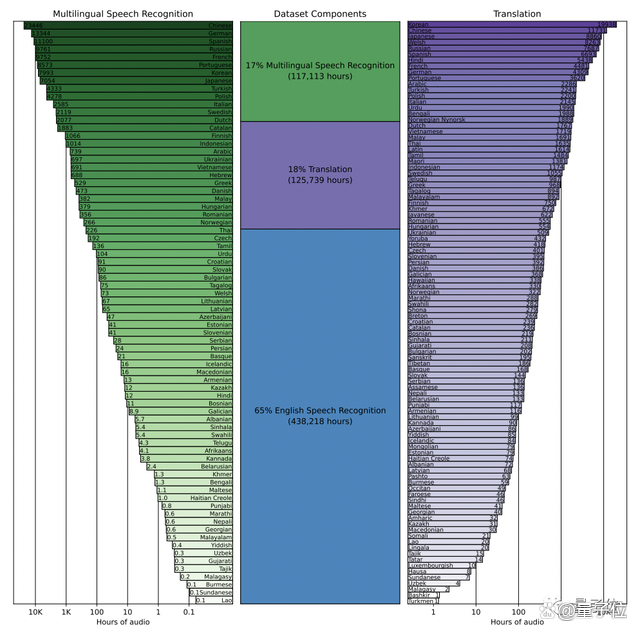

其次,Whisper體系結(jié)構(gòu)是一種簡單的端到端方法,具體來說就是Transformer的編碼器-解碼器格式。

輸入音頻被分成30秒的片段,再轉(zhuǎn)換成log-Mel譜圖,然后傳入編碼器。

解碼器被訓(xùn)練來預(yù)測相應(yīng)的文本標(biāo)題,并混合特殊標(biāo)記,指示單一模型執(zhí)行諸如語言識別、多語言語音轉(zhuǎn)錄和英語語音翻譯等任務(wù)。

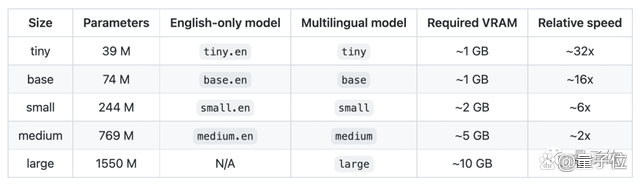

除此之外,研究人員還為Whisper設(shè)置了5種不同的型號,以下是各模型大致的內(nèi)存需求和相對速度,使用者可以自行選擇。

但需要注意的是,只有“l(fā)arge”型號支持多語言,前4個模型都只支持英語。

不過不需要擔(dān)心,與其他模型相比,英文語音識別正是Whisper的核心競爭力。

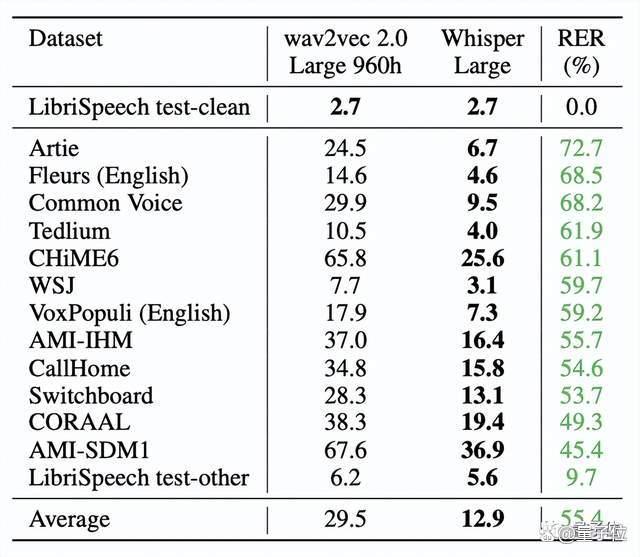

實驗結(jié)果證明,Whisper在Librispeech test-clean測試的錯誤率達(dá)到2.7%。

雖然這一數(shù)值與Wav2vec 2.0一樣,但在零樣本性能上,Whisper明顯更穩(wěn)健,平均誤差減少了55%。

甚至零樣本W(wǎng)hisper模型還縮小了與人類魯棒性之間的差距。

可以看出,與人類Alec相比,LibriSpeech模型的錯誤率大約是人類的兩倍,而Whisper模型的魯棒性邊界則包括Alec95%的置信區(qū)間。

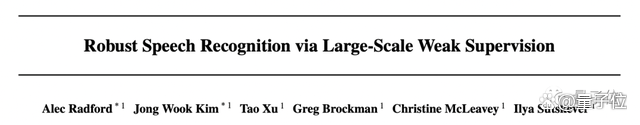

研究團隊

Whisper的研究團隊來自O(shè)penAI,共同一作有兩位:Alec Radford、Jong Wook Kim。

Alec Radford,OpenAI的機器學(xué)習(xí)研究員,也是indico.io的聯(lián)合創(chuàng)始人。

Jong Wook Kim,在紐約大學(xué)獲得了音樂技術(shù)專業(yè)的博士學(xué)位,研究方向包括多模態(tài)深度學(xué)習(xí)和音樂理解,目前是OpenAI的研究人員。

值得一提的是,研究團隊指出,雖然目前Whisper還沒有實時功能,但它的運行速度和內(nèi)存大小表明,在這一基礎(chǔ)上搭建實時語音識別和翻譯功能是可行的。

他們希望Whisper的高精度和易用性,將允許開發(fā)人員將語音接口添加到更廣泛的應(yīng)用程序中。

論文和GitHub鏈接附在文末,感興趣的小伙伴們可以自取~

論文鏈接:https://cdn.openai.com/papers/whisper.pdf

GitHub鏈接:https://github.com/openai/whisper#approach

參考鏈接:[1]https://colab.research.google.com/github/openai/whisper/blob/master/notebooks/LibriSpeech.ipynb[2]https://techcrunch.com/2022/09/21/openai-open-sources-whisper-a-multilingual-speech-recognition-system/?guccounter[3]https://news.ycombinator.com/item?id=32927360[4]https://twitter.com/alecrad[5]https://jongwook.kim/

- 免責(zé)聲明

- 本文所包含的觀點僅代表作者個人看法,不代表新火種的觀點。在新火種上獲取的所有信息均不應(yīng)被視為投資建議。新火種對本文可能提及或鏈接的任何項目不表示認(rèn)可。 交易和投資涉及高風(fēng)險,讀者在采取與本文內(nèi)容相關(guān)的任何行動之前,請務(wù)必進(jìn)行充分的盡職調(diào)查。最終的決策應(yīng)該基于您自己的獨立判斷。新火種不對因依賴本文觀點而產(chǎn)生的任何金錢損失負(fù)任何責(zé)任。

新火種

2023-09-06

新火種

2023-09-06