比擴散模型快50倍!OpenAI發(fā)布多模態(tài)模型實時生成進展,作者還是清華校友,把休假總裁Greg都炸出來了

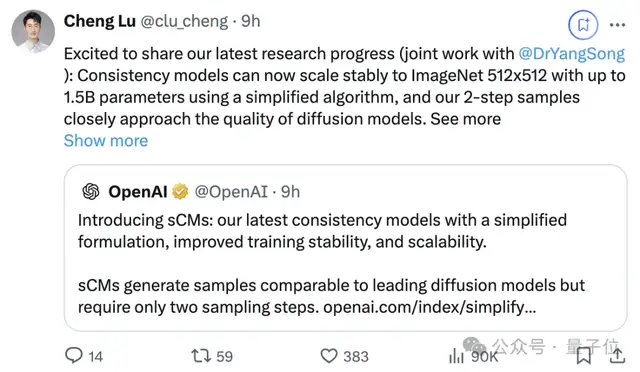

兩位清華校友,在OpenAI發(fā)布最新研究——

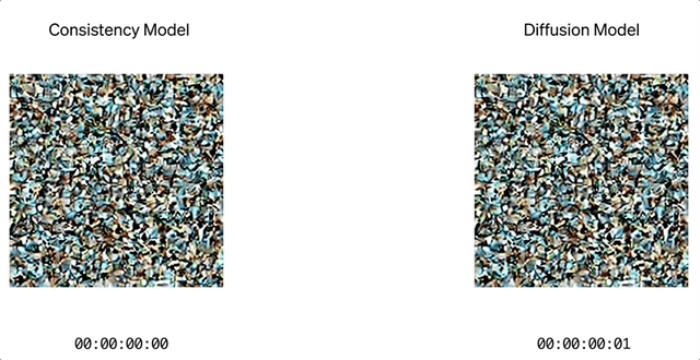

生成圖像,但速度是擴散模型的50倍。

路橙、宋飏再次簡化了一致性模型,僅用兩步采樣,就能使生成質(zhì)量與擴散模型相媲美。

他們成功將連續(xù)時間一致性模型的訓練規(guī)模擴展到了前所未有的15億參數(shù),并實現(xiàn)了在512×512分辨率的ImageNet數(shù)據(jù)集上的訓練。

參數(shù)15億模型在單張A100 GPU上無需任何推理優(yōu)化即可在0.11秒內(nèi)生成一個樣本。

團隊還表示通過定制系統(tǒng)優(yōu)化,可以進一步加速,為實時生成圖像、音頻和視頻提供新的可能。

值得一提的是,論文僅有的兩位作者還都是清華校友。

該項研究發(fā)布后得到大量網(wǎng)友點贊轉(zhuǎn)發(fā)。

把正在休假的Openai總裁Greg Brockman都炸出來了:

那么,sCM是如何實現(xiàn)的?

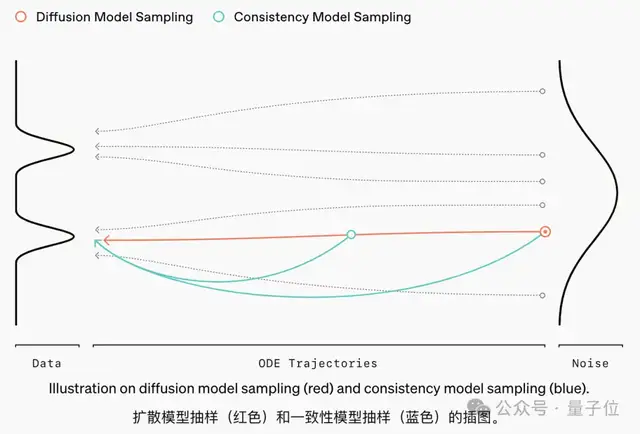

兩步采樣,50倍加速一致性模型是一種快速的擴散模型替代方案。

當前擴散模型的采樣方法通常需要數(shù)十到數(shù)百個連續(xù)步驟才能生成單個樣本,這限制了其實時應用的效率和可擴展性。

與逐步通過大量去噪步驟生成樣本的擴散模型不同,它旨在一步直接將噪聲轉(zhuǎn)換為無噪聲樣本。

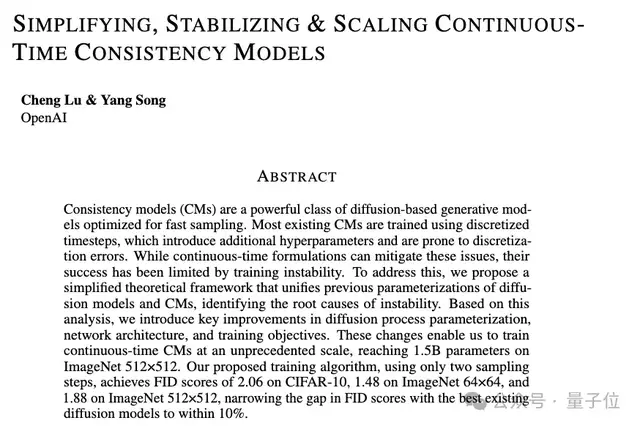

OpenAI最新這項研究提出了一種改進連續(xù)時間一致性模型(Continuous-time Consistency Models)的綜合方法,主要包含題目中提到的三個關鍵點:簡化、穩(wěn)定和擴展。

論文指出,現(xiàn)有一致性模型主要采用離散時間步訓練,這種方法會引入額外的超參數(shù)并容易產(chǎn)生離散化誤差。盡管連續(xù)時間公式可以避免這些問題,但之前的工作中連續(xù)時間一致性模型始終面臨訓練不穩(wěn)定的挑戰(zhàn)。

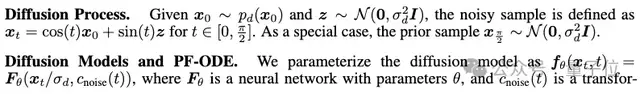

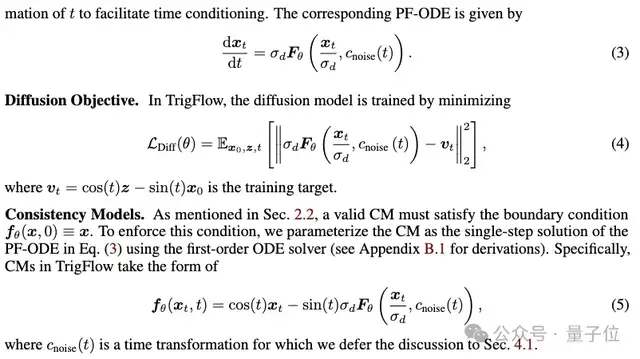

為此,論文首先提出了TrigFlow,巧妙地統(tǒng)一了EDM(Exponential Diffusion Model)和Flow Matching兩種方法。

TrigFlow使擴散過程、擴散模型參數(shù)化、PF-ODE、擴散訓練目標和一致性模型參數(shù)化都能夠擁有簡潔的表達式,如下所示。

在此基礎上,研究人員深入分析了導致訓練連續(xù)時間一致性模型不穩(wěn)定的原因。

在TrigFlow框架的基礎上引入了幾項理論上的改進,重點是參數(shù)化、網(wǎng)絡架構和訓練目標。

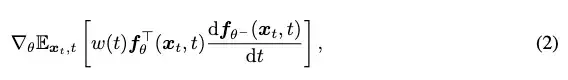

連續(xù)時間一致性模型訓練的關鍵是:

取決于:

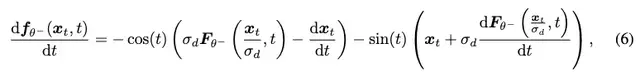

經(jīng)過進一步分析,研究人員發(fā)現(xiàn)不穩(wěn)定源自于時間導數(shù):

并據(jù)此提出了三個關鍵改進:

采用恒等時間變換c_noise(t)=t代替原有的對數(shù)正切變換,避免了t接近π/2時的數(shù)值不穩(wěn)定性;使用位置時間嵌入替代傅里葉嵌入,減少了導數(shù)震蕩;引入自適應雙重歸一化層替代AdaGN,在保持模型表達能力的同時提高了訓練穩(wěn)定性。此外,論文還改進了訓練目標,包括切向量歸一化和自適應權重等技術。

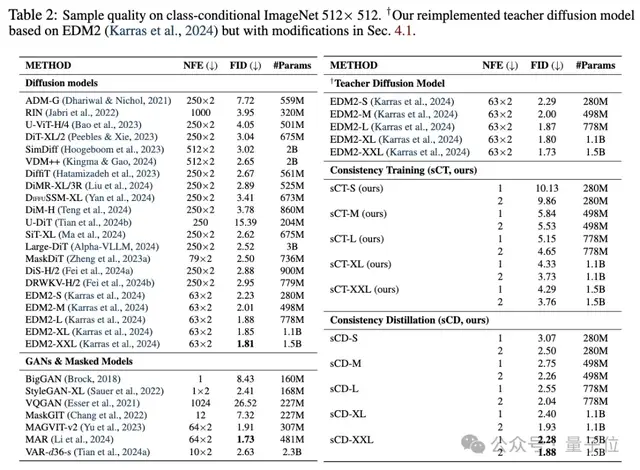

以上種種改進使得研究人員成功將時間一致性模型的訓練規(guī)模擴展到15億參數(shù),并在多個基準數(shù)據(jù)集上表現(xiàn)優(yōu)異。

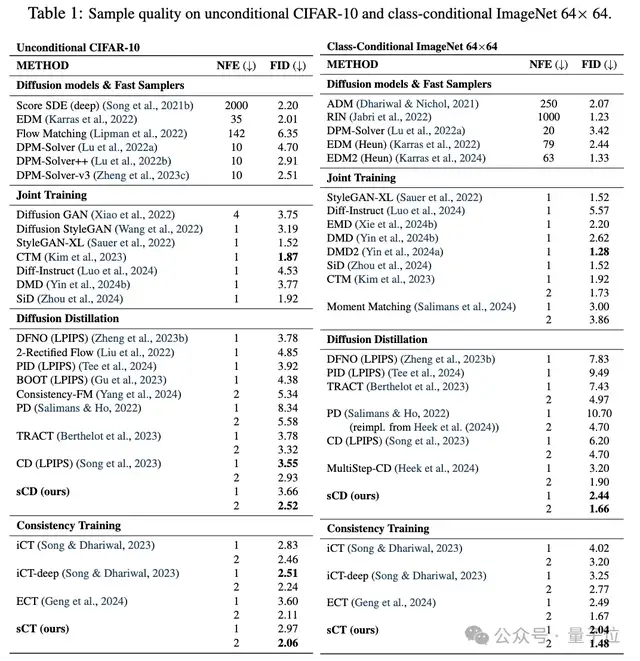

CIFAR-10上的FID(越低越好)為2.06,ImageNet 64×64上為1.48,ImageNet 512×512上為1.88。

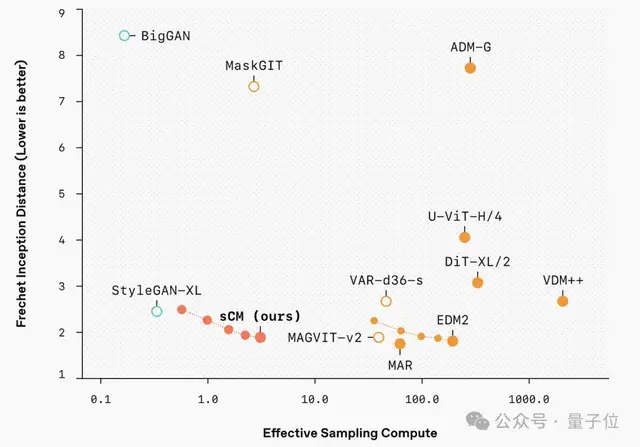

特別值得注意的是,這些模型只需要兩步采樣就能達到接近最好的擴散模型的生成質(zhì)量(FID差距在10%以內(nèi)),而計算開銷僅為后者的10%。

研究人員還比較了改進后的一致性模型與變分分數(shù)蒸餾(VSD)方法的區(qū)別,發(fā)現(xiàn)一致性模型能產(chǎn)生更多樣的樣本,并且在更高的引導水平下表現(xiàn)更好。

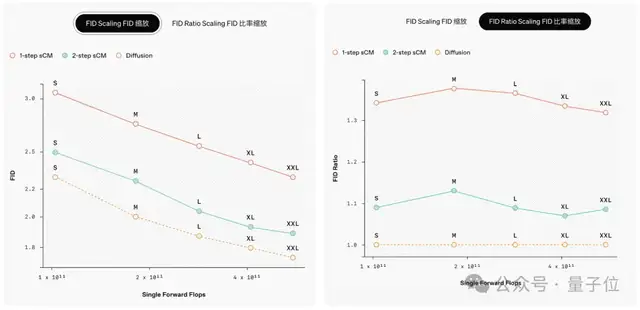

他們還有一個關鍵發(fā)現(xiàn),隨著teacher擴散模型的規(guī)模擴大,sCM的改進也呈比例增加。

用FID分數(shù)的比率來衡量樣本質(zhì)量的相對差異在模型大小不同的規(guī)模上是一致的,這意味著當模型規(guī)模增加時,樣本質(zhì)量的絕對差異會減小。

此外,增加sCM的采樣步驟可以進一步減少質(zhì)量差距。

作者簡介

作者簡介路橙

去年在清華大學TSAIL實驗室,在朱軍教授指導下獲得博士學位;2019年獲清華大學計算機科學與技術系學士學位。

現(xiàn)在他是OpenAI研究科學家,對大規(guī)模深度生成模型和強化學習算法感興趣。

他對一致性模型、擴散模型、歸一化流和基于能量的模型及其在圖像生成、3D 生成和強化學習中的應用有豐富的研究經(jīng)驗。

宋飏

宋飏在清華大學獲數(shù)學和物理學士學位后,在斯坦福大學獲得了計算機科學博士學位,導師Stefano Ermon。

其研究目標是開發(fā)能夠理解、生成并處理多種形態(tài)高維數(shù)據(jù)的強大AI模型。

目前,宋飏專注于改進生成模型,包括它們的訓練方法、架構設計、對齊、魯棒性、評估技巧及推理效率。

他對探索生成模型作為科學發(fā)現(xiàn)工具的潛力也很感興趣。

參考鏈接:

- 免責聲明

- 本文所包含的觀點僅代表作者個人看法,不代表新火種的觀點。在新火種上獲取的所有信息均不應被視為投資建議。新火種對本文可能提及或鏈接的任何項目不表示認可。 交易和投資涉及高風險,讀者在采取與本文內(nèi)容相關的任何行動之前,請務必進行充分的盡職調(diào)查。最終的決策應該基于您自己的獨立判斷。新火種不對因依賴本文觀點而產(chǎn)生的任何金錢損失負任何責任。

新火種

2024-10-25

新火種

2024-10-25