GPT-4勁敵谷歌進入高能+高產模式

在這場爭奪AIGC話語權與領導力的追逐戰里,谷歌與微軟爭相拼臂力秀肌肉。Gemini1.5Pro的橫空出世,將多模態大模型的標準提到了一個新高度。

一、極致性能背后的模型架構

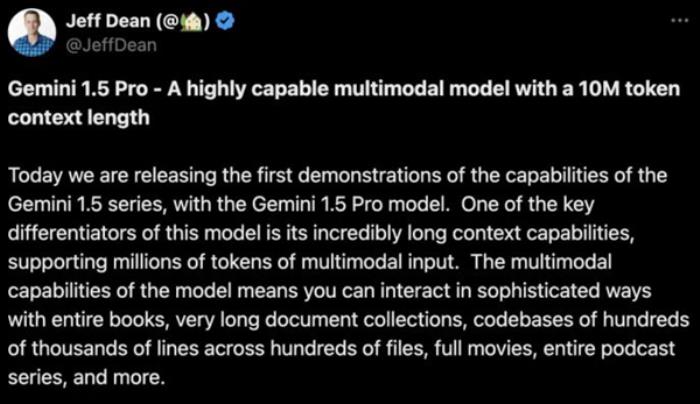

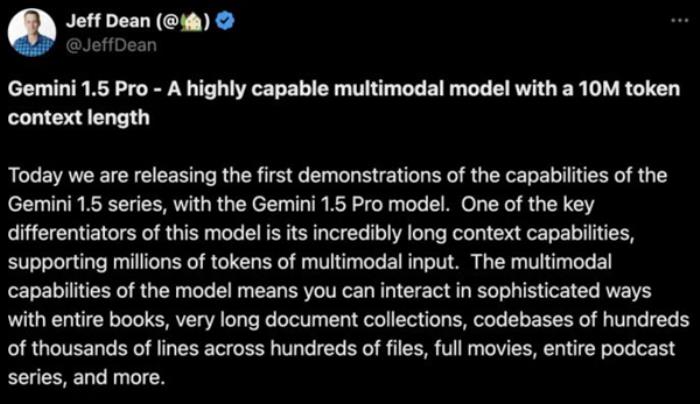

當地時間2月15日,Alphabet與Google公司首席執行官SundarPichai攜首席科學家JeffDean等眾高管在X平臺發布了多模態模型Gemini1.5Pro。這是繼2月7日的Gemini1.0Ultra后,谷歌在多模態大模型賽道的又一力作。

圖源:X平臺Alphabet與Google公司首席科學家JeffDean推文

“巧合”的是,OpenAI在Gemini1.5Pro官宣兩小時發布Sora這枚重磅炸彈,頗有“一較高下”的勁頭。只是由于當下大家的視線焦點集中在視頻領域,Sora又是OpenAI首次發布文生視頻模型,所以無奈被搶了頭條。

圖源:微博評論

Gemini1.5Pro建立在谷歌對Transformer和MoE架構的領先研究之上。傳統Transformer充當一個大型神經網絡,而MoE(MixtureofExperts混合專家模型)模型則分為更小的“專家”神經網絡。在這一結構之下,通過將模型參數劃分為多個組別而實現的計算的稀疏化,即每次執行推理任務時,根據對輸入類型的判斷,MoE模型會通過門控網絡選擇性地激活神經網絡中最契合指令的專家參與計算。

這種專業化、模塊化的劃分可以在提升預訓練計算效率的同時提升大模型處理復雜任務的性能,更快地學習復雜任務的同時保證準確性。與稠密模型相比,MoE模型的預訓練速度更快;使用MoE層代替transformer中的前饋網絡(FFN)層。因而對的采用可以彌補Transformer架構運算效率的問題。

在Switch-Transformer、M4等領域,Google一直是深度學習MoE技術的早期采用者。目前大部分大語言模型開源和學術工作都沒有使用MoE架構。有消息稱,GPT-4也采用了由8個專家模型組成的集成系統。2023年12月8日MistralAI發布的Mixtral8x7B同樣采用了這種架構。就國內的大模型而言,只有Minimax采用了MoE架構。

二、擴容的上下文窗口意味著什么?

雖然Gemini1.5Pro是Gemini1.5系列的初代版本,但初代便表現不俗。擴大上下文窗口后的高水平性能是Gemini1.5Pro的一大亮點。

多模態大模型卷到今日,上下文窗口容量已然成為提升其理解能力的關鍵掣肘。此前的SOTA模型將上下文窗口容量卷到了20萬token。而谷歌的Gemini1.5Pro直接將上下文窗口容量提到了100萬token(極限為1000萬token),遠遠超出了Gemini1.0最初的32,000個token,創下了最長上下文窗口的紀錄。

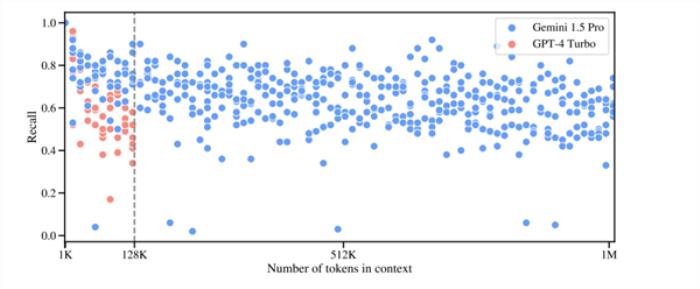

對于文本處理,Gemini1.5Pro在處理高達530,000token的文本時,能夠實現100%的檢索完整性,在處理1,000,000token的文本時達到99.7%的檢索完整性。甚至在處理高達10,000,000token的文本時,檢索準確性仍然高達99.2%。在音頻處理方面,Gemini1.5Pro能夠在大約11小時的音頻資料中,100%成功檢索到各種隱藏的音頻片段。在視頻處理方面,Gemini1.5Pro能夠在大約3小時的視頻內容中,100%成功檢索到各種隱藏的視覺元素。

圖源:Gemini1.5Pro官方測試數據

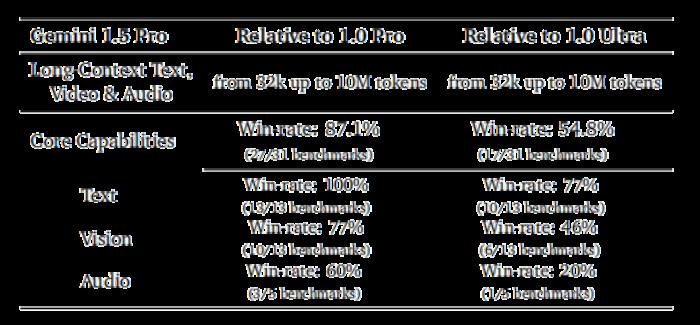

Gemini1.5Pro大大超過Gemini1.0Pro,在27項基準(共31項)上表現更好,特別是在數學、科學和推理(+28.9%),多語言(+22.3%),視頻理解(+11.2%)和代碼(+8.9%)等領域。即使是對比Gemini系列的高端產品Gemini1.0Ultra,Gemini1.5Pro也在超過一半的基準(16/31)上表現更好,特別是在文本基準(10/13)和許多視覺基準(6/13)上。在NIAH測試中,Gemini1.5Pro能夠在長達100萬token的文本塊中,以99%的準確率找出隱藏有特定信息的文本片段。

圖源:Gemini1.5Pro官方測試數據

這個上下文長度使Gemini1.5Pro可以自如地處理22小時的錄音、超過十倍的完整的1440頁的書(587,287字)“戰爭與和平”,以及四萬多行代碼、三小時的視頻。

三、機器腦有多好使

除高效架構和強上下文處理能力之外,Gemini1.5Pro的優秀品質還在于“情境學習”技能,它可以根據長提示,從以前從未見過的信息中學習新技能,而不需要額外的微調。強學習能力、信息檢索與數據分析能力使得在知識海洋中“海底撈針”由想象映照進了現實。

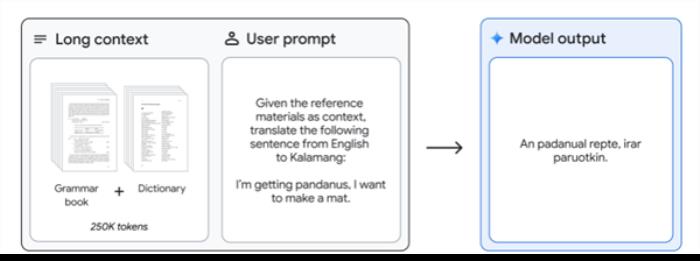

根據官方發布的測試報告,當給定卡拉曼語(一種全球使用人數不足200人的語言)的語法手冊時(500頁的語言文獻,一本詞典和400個平行句子),Gemini1.5Pro模型可以學習將英語翻譯成卡拉曼語,其水平與學習相同內容的人相似。

圖源:Gemini1.5Pro官方演示樣本

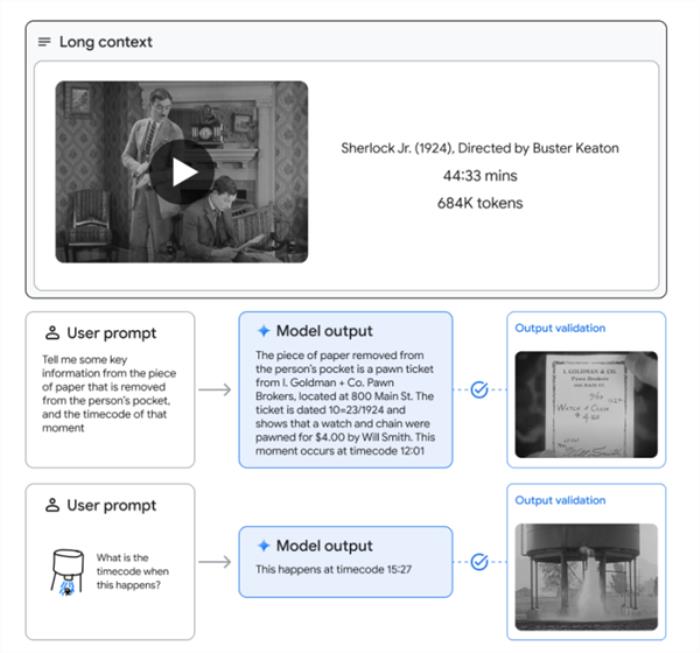

當被一個45分鐘的Buster基頓電影“小神探夏洛克”(1924年)(2674幀,1FPS,684k token)提示時,Gemini1.5Pro可以從其中的特定幀中檢索和提取文本信息,并提供相應的時間戳。此外還可以從一張手繪素描中識別電影中的一個場景。與側重于衡量模型檢索能力的特定事實或細節的任務不同,這些問題通常需要了解跨越大量文本的信息片段之間的關系。

圖源:Gemini1.5Pro官方演示樣本

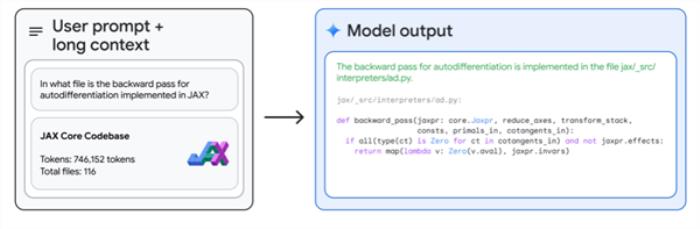

Gemini1.5Pro在處理長達超過100,000行的代碼時,還具備極強的問題解決能力。面對龐大的代碼量,它能夠深入分析各個示例,提出實用的修改建議,還能詳細解釋代碼的條例框架。給出了整個746,152個令牌JAX代碼庫,Gemini1.5Pro可以識別核心自動微分方法的具體位置。開發者可以直接上傳新的代碼庫,利用這個模型快速熟悉、理解代碼結構。

圖源:Gemini1.5Pro官方演示樣本

正如NVIDIA高級科學家JimFan所言,Gemini1.5Pro意味著LLM能力的大幅躍升,這對于做個體戶的小公司而言可謂一騎絕塵。

在人機協同的探索過程中,單一的文本交互很難滿足多場景多樣態的內容生產訴求。多模態的信息處理與生成能力顯然是技術變革的發力點。紐約大學計算機助理教授謝賽寧說,人才第一,數據第二,算力第三,其他都沒有什么是不可替代的。Gemini1.5Pro是谷歌與巔峰對決的又一利器,或許AGI時代正加快到來。

- 免責聲明

- 本文所包含的觀點僅代表作者個人看法,不代表新火種的觀點。在新火種上獲取的所有信息均不應被視為投資建議。新火種對本文可能提及或鏈接的任何項目不表示認可。 交易和投資涉及高風險,讀者在采取與本文內容相關的任何行動之前,請務必進行充分的盡職調查。最終的決策應該基于您自己的獨立判斷。新火種不對因依賴本文觀點而產生的任何金錢損失負任何責任。

新火種

2024-02-22

新火種

2024-02-22