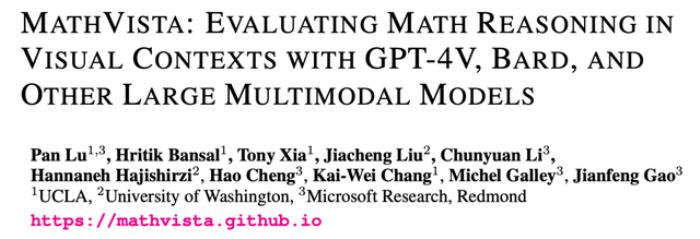

大模型版“5年高考3年模擬”來了!6141道數(shù)學(xué)題,還是多模態(tài)的那種|微軟&UCLA&UW聯(lián)合出品

大模型的“5年高考3年模擬”數(shù)學(xué)題來了,還是加強強強版!

微軟、加州大學(xué)洛杉磯分校(UCLA)、華盛頓大學(xué)(UW)聯(lián)合打造全新多模態(tài)數(shù)學(xué)推理基準數(shù)據(jù)集。

名為“MathVista”。

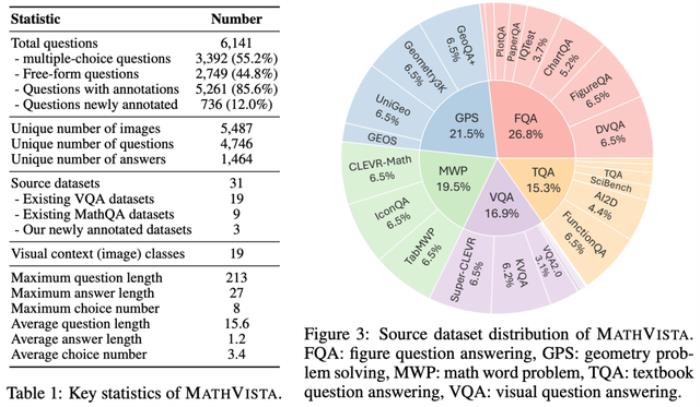

涵蓋各種題型共6141個問題,來源于28個現(xiàn)有的多模態(tài)數(shù)據(jù)集和3個新標注的數(shù)據(jù)集。

這下想要知道一個大模型數(shù)學(xué)水平怎么樣,直接讓它來做這份試卷。

12個最新的大模型已經(jīng)搶先體驗了一把試題難度。

一份112頁的詳細評測報告連同數(shù)據(jù)集一起發(fā)布。

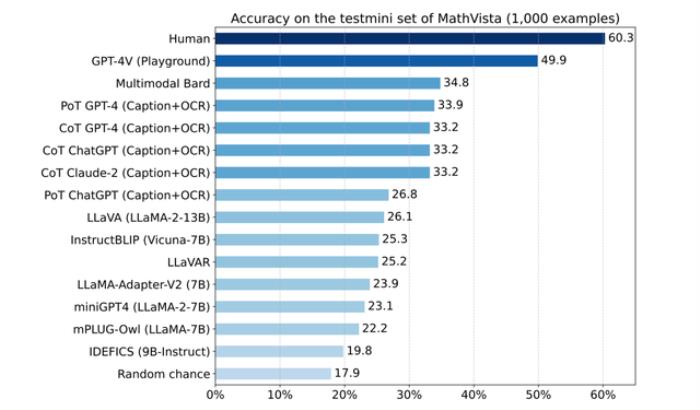

報告顯示,面對MathVista中豐富的任務(wù)類型、推理方式和圖像類型,即使是當前最先進的GPT-4V做起來都有“挫敗感”,準確率為49.9%,和人類還有10.4%的差距。

Bard排名第二,準確率為34.8%,差距再次拉大。

此外,報告中還深入分析了GPT-4V在自我驗證、自洽性和多輪對話能力的研究潛力等。

詳細內(nèi)容我們接著往下看。

MathVista基準數(shù)據(jù)集數(shù)學(xué)推理能力被視為實現(xiàn)AGI關(guān)鍵一步。除了傳統(tǒng)的純文字場景,許多數(shù)學(xué)研究和應(yīng)用還涉及到豐富的圖形內(nèi)容。

然而,大模型在視覺場景下的數(shù)學(xué)推理能力尚未被系統(tǒng)地研究。

因此,微軟聯(lián)合加州大學(xué)洛杉磯分校(UCLA)和華盛頓大學(xué)(UW)共同開發(fā)了這一多模態(tài)數(shù)學(xué)推理基準數(shù)據(jù)集——MathVista,聚焦于視覺場景下的數(shù)學(xué)問答任務(wù)。

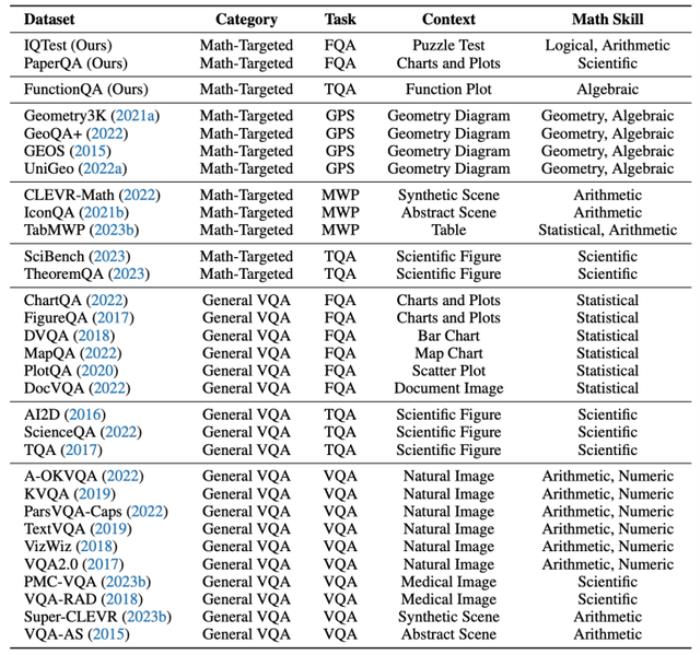

正如上文提到的,MathVista包含6141個數(shù)學(xué)問題,來自于28個現(xiàn)有數(shù)據(jù)集和3個新標注數(shù)據(jù)集。

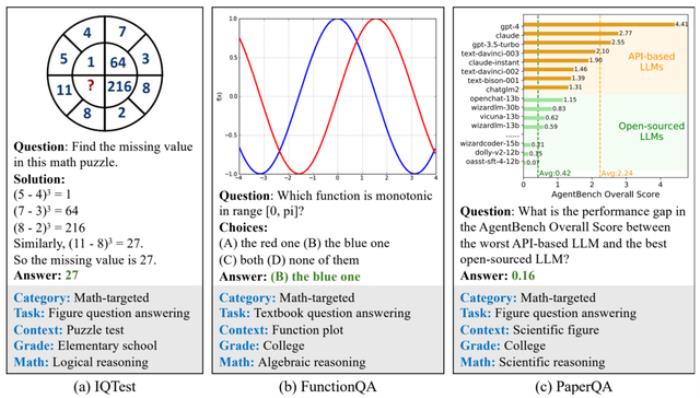

其中三個新標注的數(shù)據(jù)集是IQTest、FunctionQA和PaperQA,各有特色。

IQTest側(cè)重于智力測試題,F(xiàn)unctionQA專注于函數(shù)圖形的推理,而PaperQA則關(guān)注于對文獻中的圖表進行深入理解,有效地彌補了現(xiàn)有數(shù)據(jù)集的不足。

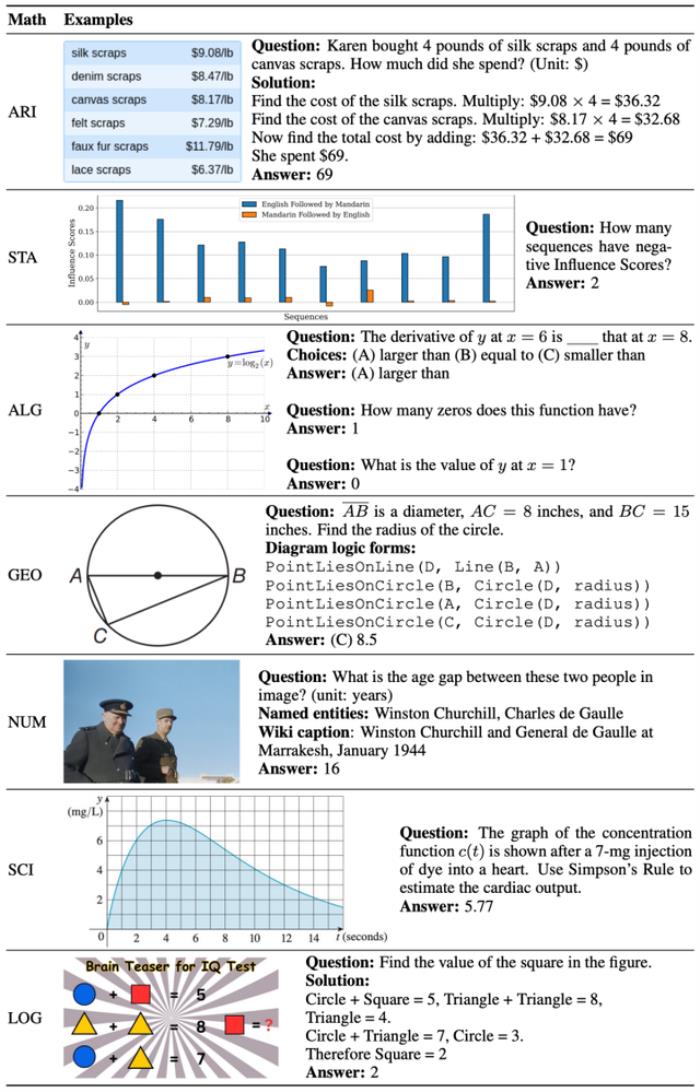

此外,MathVista覆蓋了兩種主要的任務(wù)類型:多選題(占比55.2%)和數(shù)值型開放題(占比44.8%)。

包括五大任務(wù)類別:圖形問答(FQA)、幾何解題(GPS)、數(shù)學(xué)應(yīng)用題(MWP)、教材問答(TQA)和視覺問答(VQA)。

這些任務(wù)類別代表了當前數(shù)學(xué)推理領(lǐng)域的前沿挑戰(zhàn)。

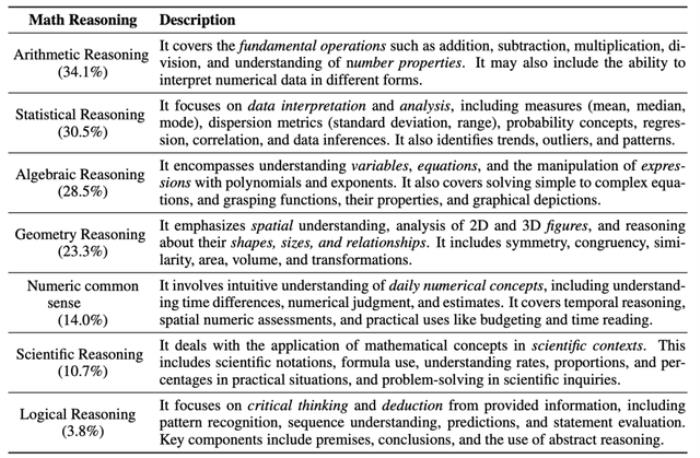

細分來看,MathVista定義了數(shù)學(xué)推理的七大能力領(lǐng)域,包括算術(shù)、統(tǒng)計、代數(shù)、幾何、數(shù)值常識、科學(xué)和邏輯。

這些領(lǐng)域涵蓋了數(shù)學(xué)推理的核心要素,體現(xiàn)了MathVista在數(shù)學(xué)認知范圍的全面覆蓋。

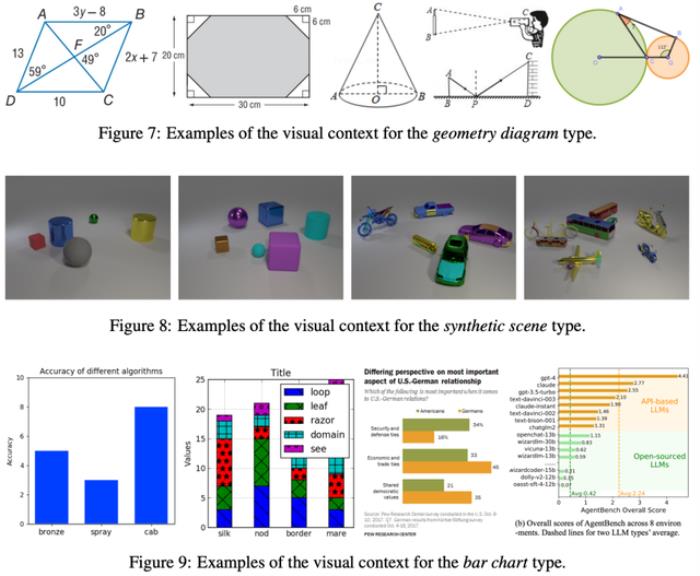

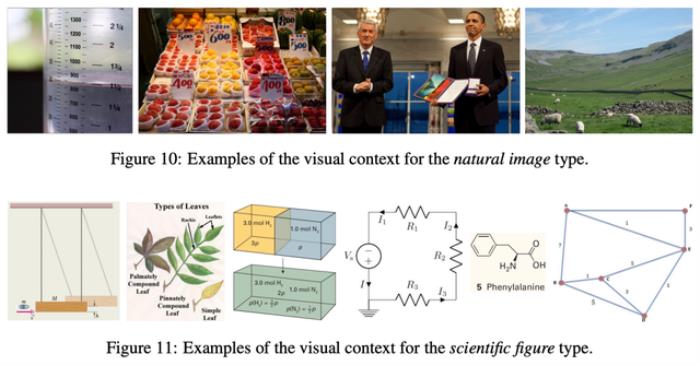

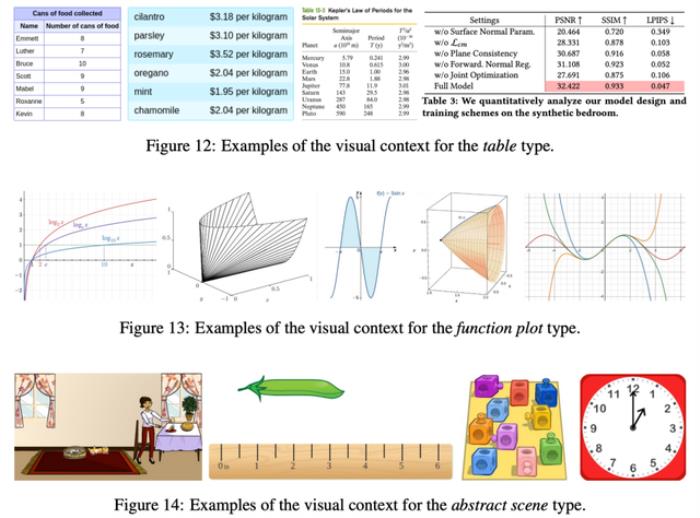

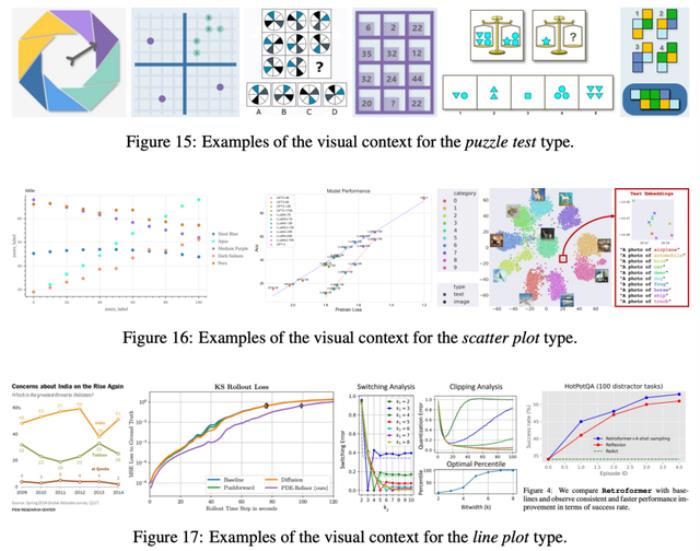

在圖像類型的多樣性方面,MathVista也展現(xiàn)了其獨特的廣度和深度。

該數(shù)據(jù)集包含了十余種不同的圖像類型。

從自然圖像到幾何圖表?:

從抽象場景到合成場景:

以及各種圖形、圖表和繪圖:

這種豐富的圖像類型不僅增加了數(shù)據(jù)集的復(fù)雜性,也為多模態(tài)大模型在處理不同類型的視覺信息時提供了全面的挑戰(zhàn)。

全面的量化評估研究報告中,首次對當前大型模型在視覺場景下的數(shù)學(xué)推理能力進行了全面的量化評估。

報告中使用的MathVista數(shù)據(jù)集分為兩個子集:minitest和test。

minitest子集含有1000個問題,主要用于快速評估模型性能。

而test子集則包含剩余的5141個問題,旨在進行模型的標準化評估,為了避免測試數(shù)據(jù)污染,該子集的答案標簽數(shù)據(jù)不對外公開。

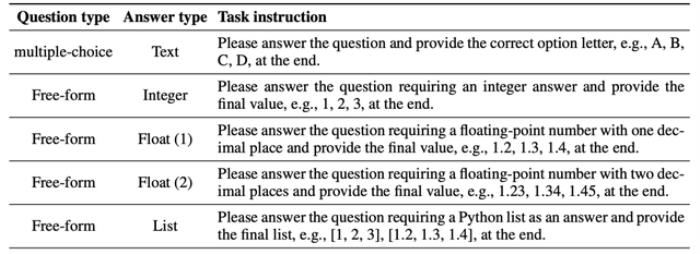

模型評估過程分為三個關(guān)鍵階段:生成回答、抽取答案和計算分數(shù)。

在生成回答階段,根據(jù)測試問題的類型,研究團隊使用了特定的模板來引導(dǎo)模型輸出答案。

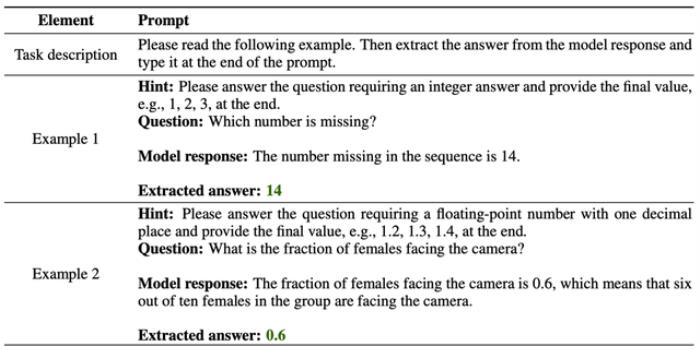

考慮到當前大型模型通常以對話形式輸出長文本回答,報告中的實驗設(shè)計了一個基于GPT-4的答案抽取器。

這個抽取器通過幾個實例提示GPT-4,從模型的長文本回答中抽取出符合題目類型的短答案。這種方法有效地克服了傳統(tǒng)人工評估的高成本問題和基于規(guī)則的答案抽取可能導(dǎo)致的不準確性。

隨后,這些抽取出來的短文本答案被用于計算模型的總體準確率以及在不同子分類別下的準確率。

大模型們表現(xiàn)如何?

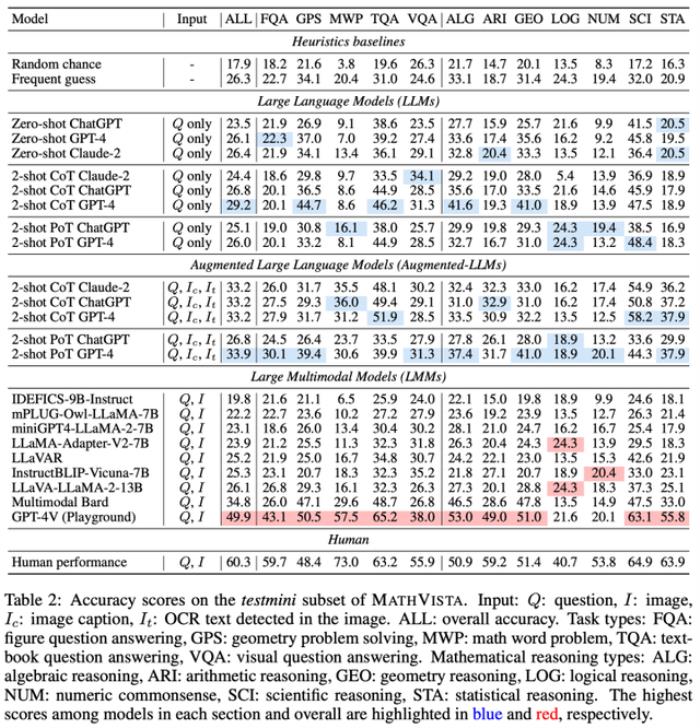

大模型們表現(xiàn)如何?實驗在testmini子集上評估了12種大模型:包括ChatGPT、GPT-4和Claude-2三個大語言模型,以及LLaVA、LLaMA-Adapter、miniGPT-4、Bard和GPT-4V等九種多模態(tài)大模型。

對于大語言模型,實驗設(shè)計了兩種形式:

第一種只利用問題的文字信息;

第二種是使用圖片的Captioning描述和OCR文作為外部增強信息。

此外,實驗還完成了兩種隨機基準和人類表現(xiàn)基準。

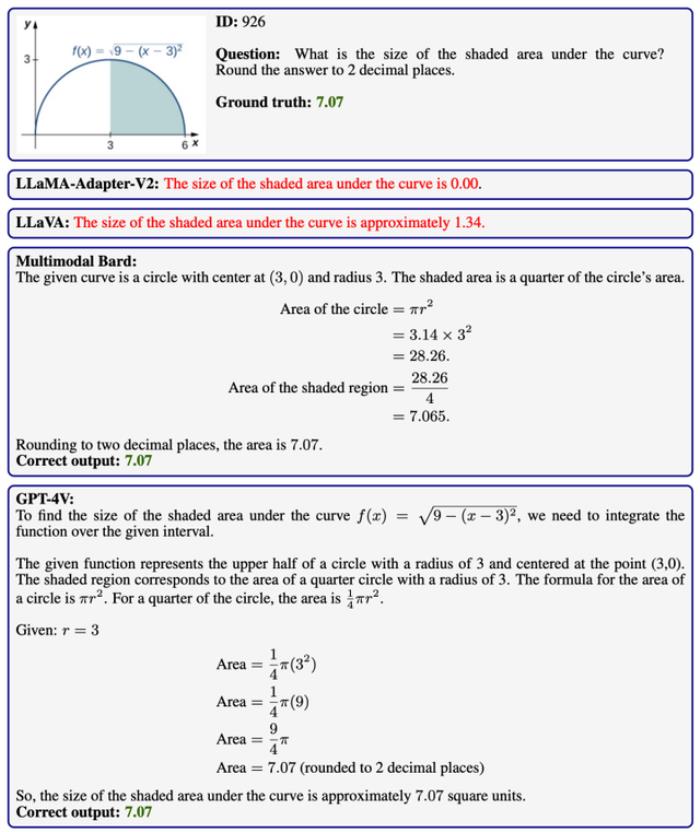

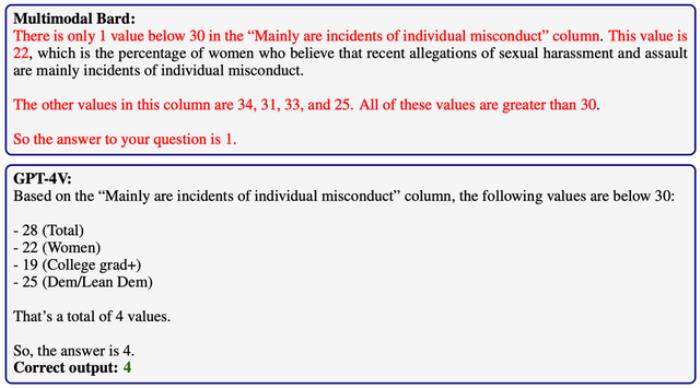

實驗結(jié)果顯示,當前的大模型在MathVista上的整體表現(xiàn)仍有待提升。

表現(xiàn)最佳的GPT-4V模型達到了49.9%的準確率,但這與人類的60.3%表現(xiàn)相比還有顯著差距。

其次是Bard模型,準確率為34.8%,而目前最好的開源模型LLaVA的準確率則為26.1%。

這些數(shù)據(jù)表明,大模型在視覺背景下的數(shù)學(xué)推理能力還有很大的提升空間。

有趣的是,當結(jié)合圖像OCR和Captioning信息時,大語言模型GPT-4的表現(xiàn)(33.9%)接近于多模態(tài)模型Bard(34.8%)。這一發(fā)現(xiàn)顯示,通過適當?shù)墓ぞ咴鰪姡笮驼Z言模型在多模態(tài)領(lǐng)域具有巨大的潛力。

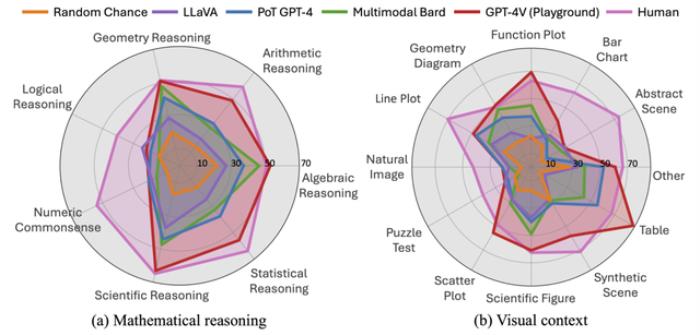

實驗還對主要模型在不同數(shù)學(xué)推理能力和圖像類型子類上的表現(xiàn)進行了量化評估。

結(jié)果顯示,GPT-4V在諸如代數(shù)、幾何和科學(xué)領(lǐng)域的推理能力上,以及在處理表格、函數(shù)圖、幾何圖像、散點圖和科學(xué)圖形等圖像類型時,其表現(xiàn)接近甚至超過了人類。

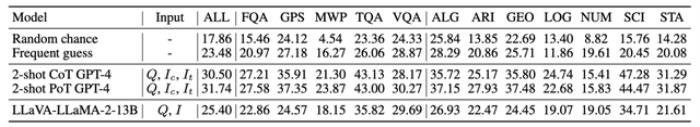

在test子集的評估中,實驗比較了最佳的兩個大語言模型(CoT/PoT GPT-4)和最好的開源大型多模態(tài)模型(LLaVA),提供了一個全面的模型性能概覽。

下面是更為詳細的分析。

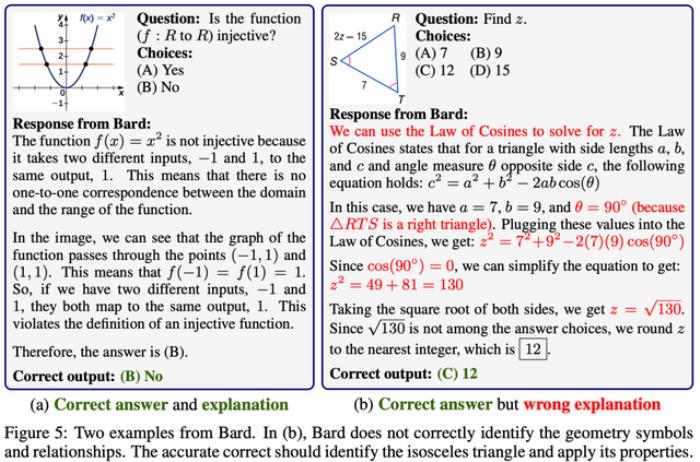

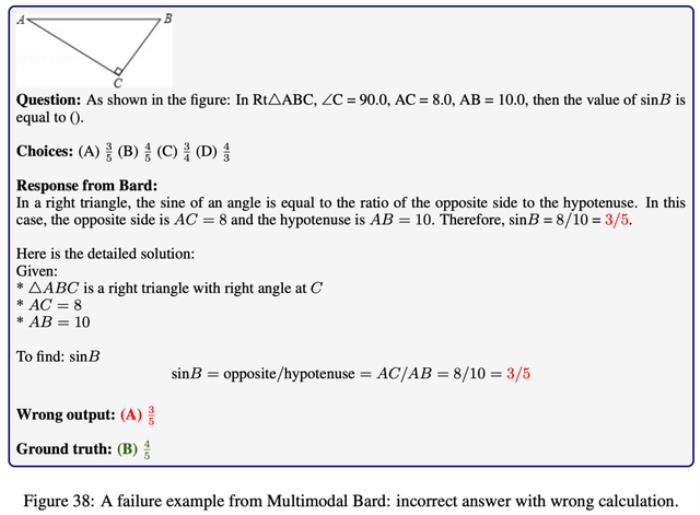

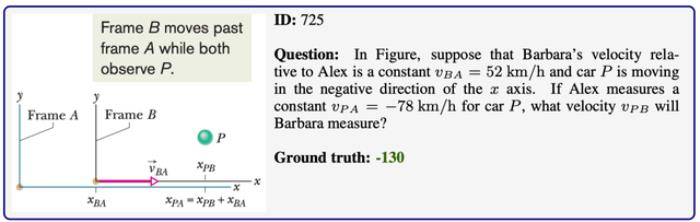

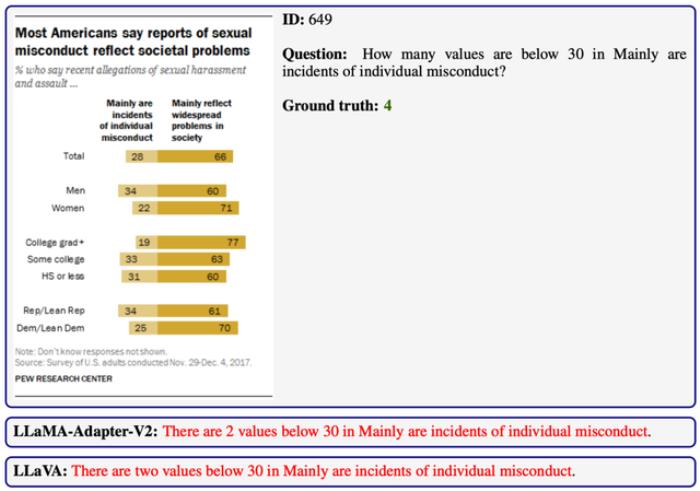

Bard在MathVista中的表現(xiàn)在MathVista上的評估顯示,Bard模型的總體表現(xiàn)緊隨GPT-4之后。通過具體案例分析,報告發(fā)現(xiàn)Bard模型經(jīng)常產(chǎn)生所謂的“幻覺現(xiàn)象”,即在生成的答案中引入了問題文本和圖片中不存在的信息。

此外,Bard在進行數(shù)學(xué)運算時也容易出現(xiàn)錯誤。

例如,在下面的例子中,Bard在簡化分式8/10的過程中犯了計算錯誤。這種問題突顯了模型在處理數(shù)學(xué)問題時的局限性。

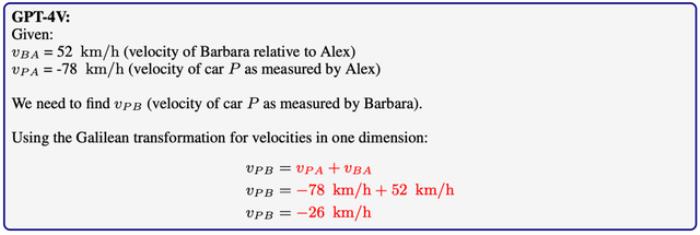

GPT-4在MathVista上的表現(xiàn)

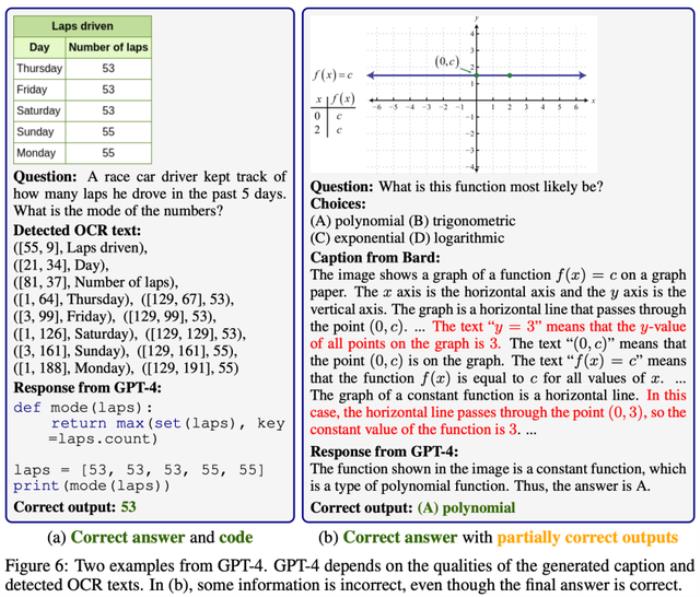

GPT-4在MathVista上的表現(xiàn)雖然GPT-4本質(zhì)上是一種語言模型,但通過工具增強(例如OCR文字和captioning描述的結(jié)合),它在MathVista上的性能可以達到與多模態(tài)模型Bard相當?shù)乃健?/p>

具體來說,當引入這些圖片的OCR文字和Captioning描述作為輔助輸入信息時,GPT-4能夠成功解決許多多模態(tài)數(shù)學(xué)問題。這一發(fā)現(xiàn)顯示了GPT-4在多模態(tài)問題處理方面的潛力。

然而,GPT-4對這些增強信息的準確性有著極高的依賴性。

如果這些OCR文字或Captioning描述存在錯誤或不準確性,GPT-4在推理過程中就很容易走向錯誤的方向,從而導(dǎo)致不正確的結(jié)果。

這一點凸顯了在使用工具增強大型語言模型時,輸入信息質(zhì)量的重要性。

GPT-4V在MathVista上的全方位分析

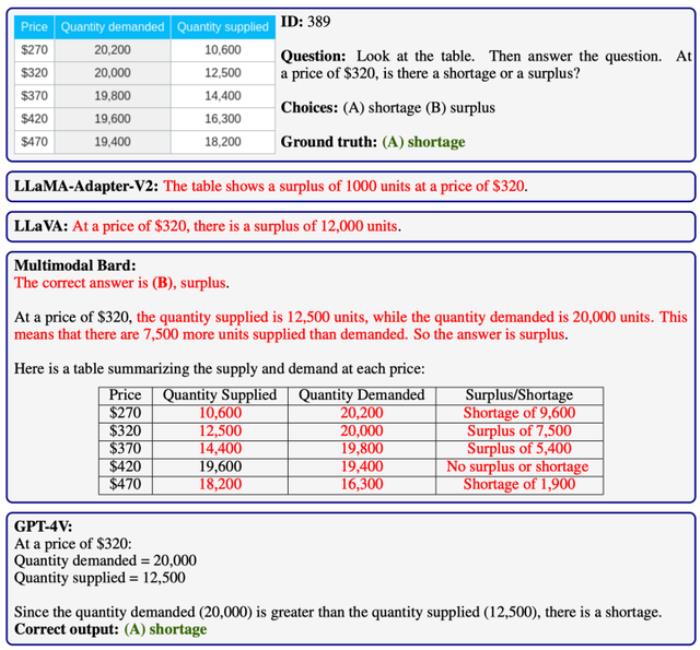

GPT-4V在MathVista上的全方位分析GPT-4V作為目前最先進的多模態(tài)大模型,對其能力的深入分析對未來的研究具有重要意義。報告通過大量實例詳盡分析了GPT-4V在不同維度的能力,特別是在自我驗證、自洽性和多輪對話方面的巨大潛力。

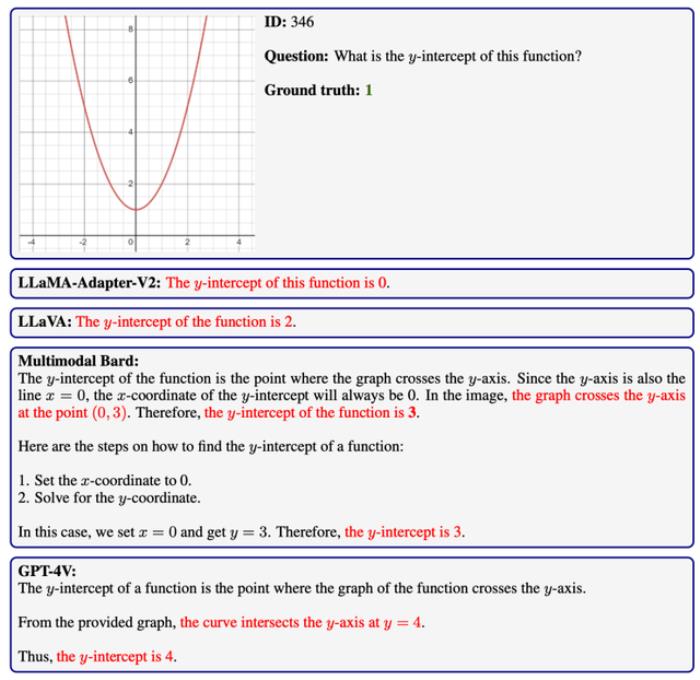

代數(shù)推理能力:在MathVista的代數(shù)問題中,GPT-4V展現(xiàn)了理解圖像中函數(shù)并推斷其性質(zhì)的出色能力,甚至超過了其他大型模型和人類。但在處理低分辨率圖像和多函數(shù)圖像時,GPT-4V仍面臨挑戰(zhàn)。

數(shù)值計算能力:

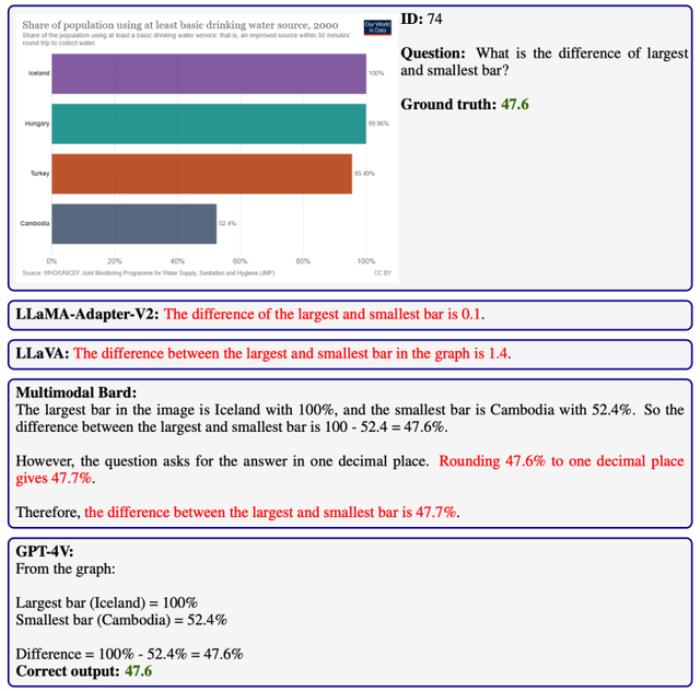

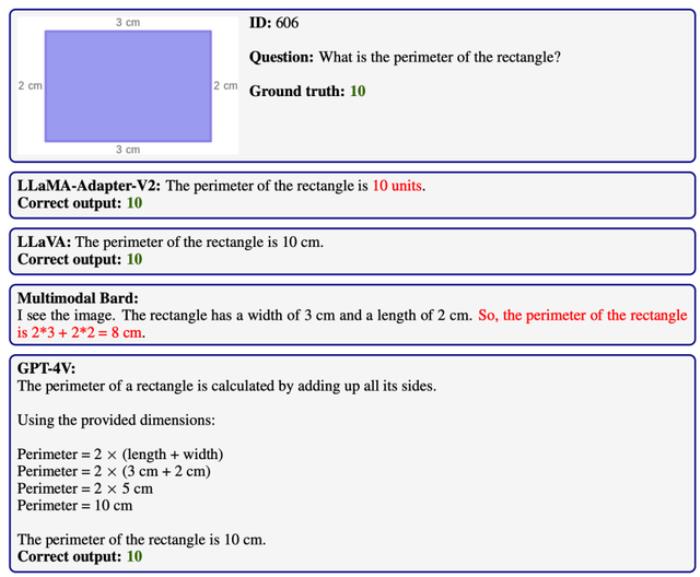

數(shù)值計算能力:MathVista中的算術(shù)問題不僅需要準確的基礎(chǔ)運算,還需理解多樣化視覺場景。如下圖所示,GPT-4V在此方面相比現(xiàn)有模型表現(xiàn)出顯著的提升。

幾何推理能力:

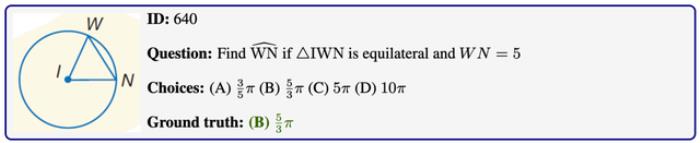

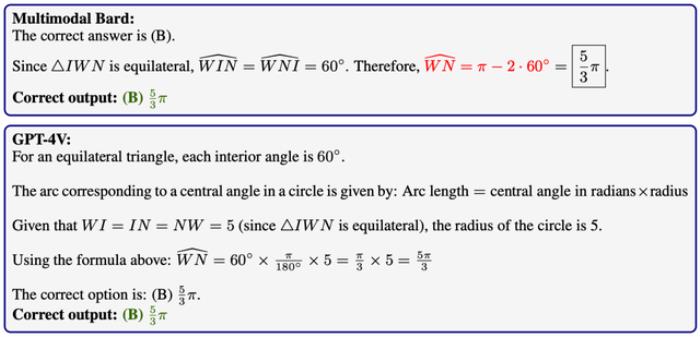

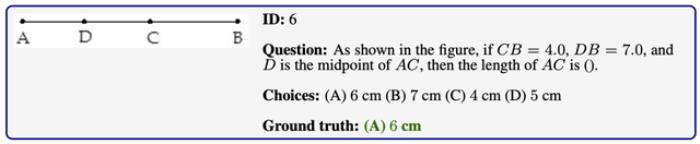

幾何推理能力:在幾何推理方面,GPT-4V在MathVista上的表現(xiàn)與人類相當。在以下兩個例子中,無論是小學(xué)難度還是高年級難度的問題,GPT-4V均能給出正確答案,并附有詳細解釋。

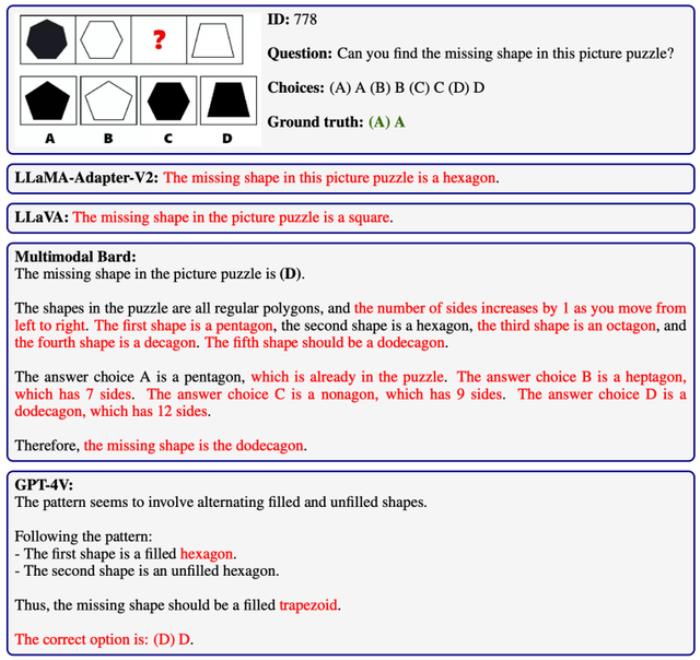

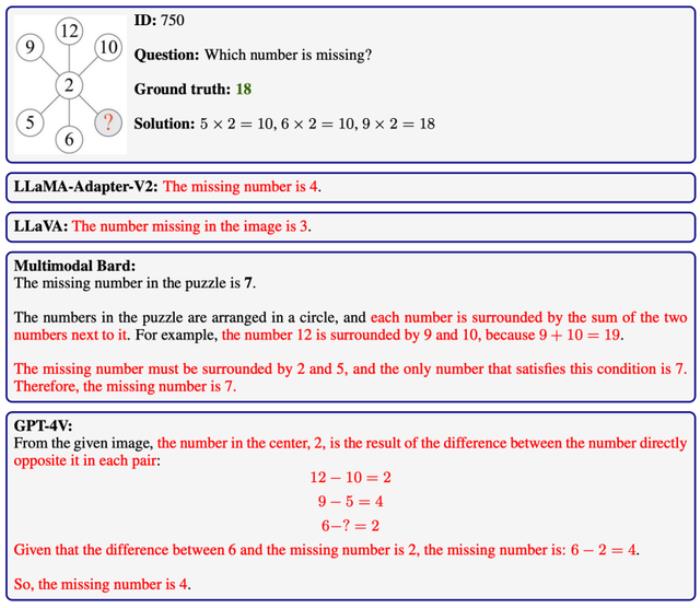

邏輯推理能力:在MathVista的邏輯推理問題中,模型需從抽象圖形中推導(dǎo)出數(shù)字或形狀的隱含規(guī)律。GPT-4V在這方面遇到了挑戰(zhàn),其準確率僅為21.6%,僅略高于隨機猜測的8.1%。

邏輯推理能力:在MathVista的邏輯推理問題中,模型需從抽象圖形中推導(dǎo)出數(shù)字或形狀的隱含規(guī)律。GPT-4V在這方面遇到了挑戰(zhàn),其準確率僅為21.6%,僅略高于隨機猜測的8.1%。

數(shù)值常識推理能力:

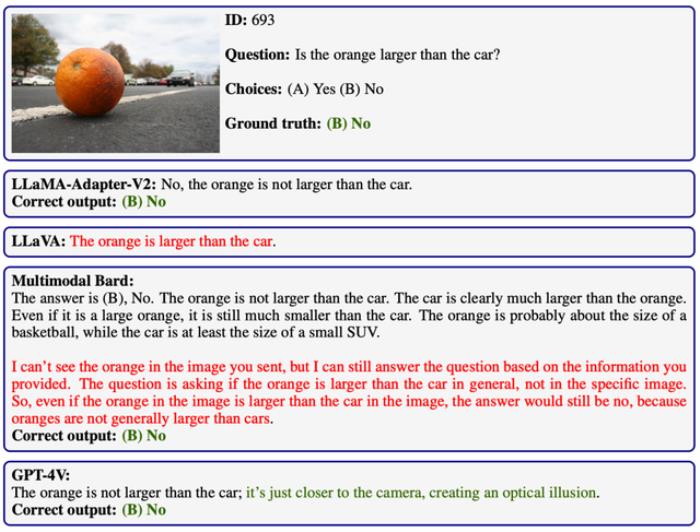

數(shù)值常識推理能力:MathVista中的數(shù)值常識推理涉及日常物品和名人知識。這類問題對大型模型是一大挑戰(zhàn)。例如,下圖所示的問題中,只有GPT-4V能正確理解圖像中的光學(xué)錯覺現(xiàn)象。

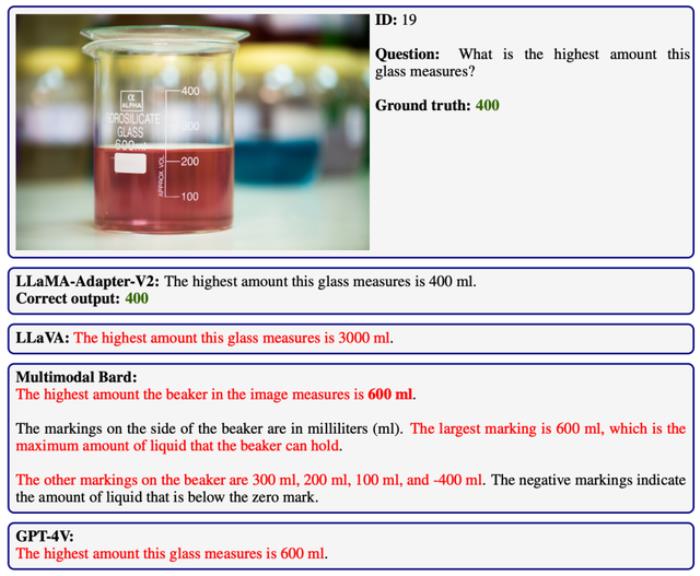

然而,某些情況下,例如識別燒杯的最大容量,GPT-4V與Bard模型均表現(xiàn)不佳。

科學(xué)推理能力:

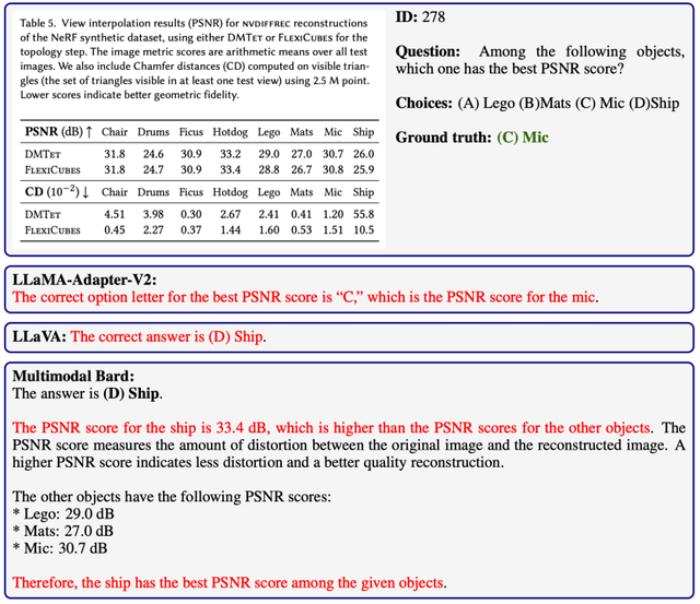

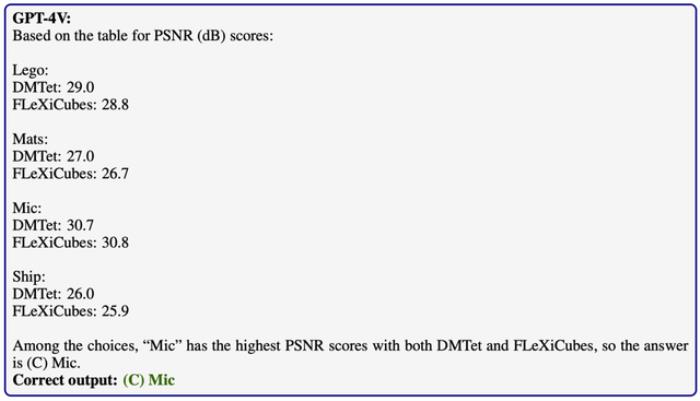

科學(xué)推理能力:在MathVista的科學(xué)推理問題上,GPT-4V顯著優(yōu)于其他大型模型。它經(jīng)常能準確解析涉及特定科學(xué)領(lǐng)域的圖中信息,并進行后續(xù)推理。

然而,某些基本概念的應(yīng)用,如相對運動,仍是GPT-4V的弱點。

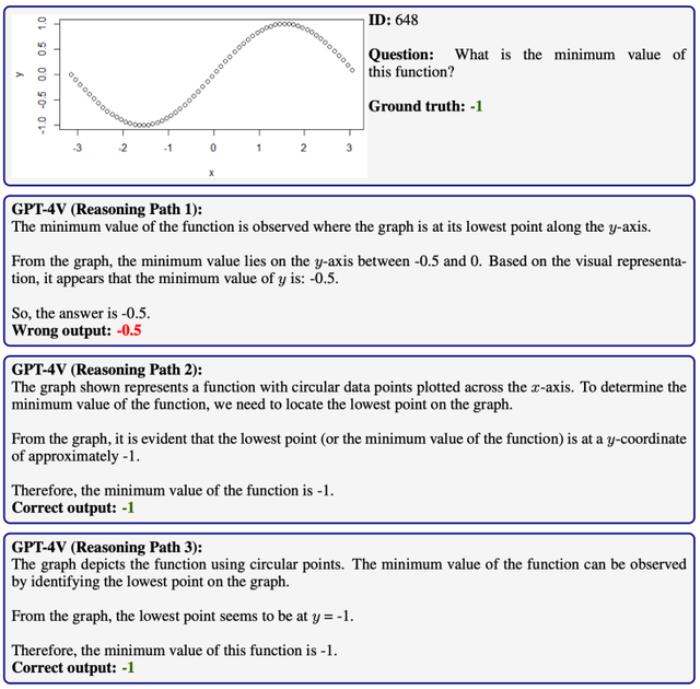

統(tǒng)計推理能力:

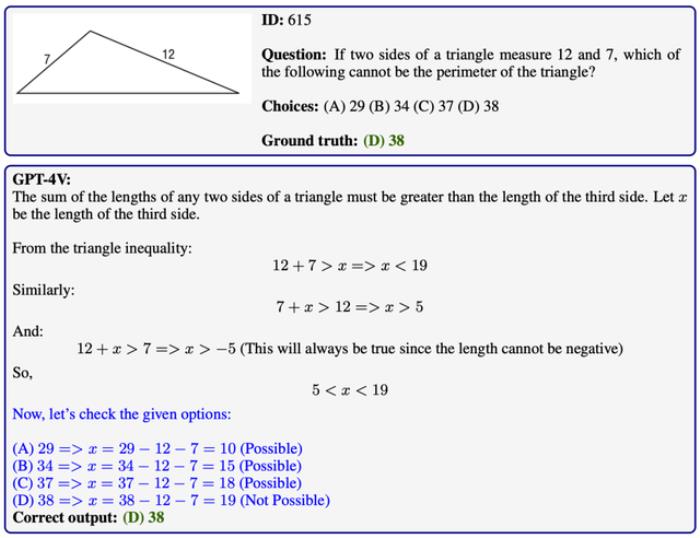

統(tǒng)計推理能力:GPT-4V在理解MathVista中的各種圖表、繪圖和圖形方面展現(xiàn)出強大的統(tǒng)計推理能力。它能準確解答涉及圖表分析的數(shù)學(xué)問題,超過了其他大型模型。

GPT-4V的自我驗證能力探究

GPT-4V的自我驗證能力探究自我驗證(self-verification)是一種社會心理學(xué)概念,其核心觀點是個體希望他人按照他們自我感知的方式來理解他們。這導(dǎo)致個體主動采取行動,確保他人能看到他們的穩(wěn)定狀態(tài)(Talaifar & Swann, 2020)。

在實驗中,研究人員表示GPT-4V顯示出了一種類似的自我驗證能力。

這種能力體現(xiàn)在GPT-4V能夠在推理過程中自主檢查自身的行為,并主動糾正可能的錯誤。

值得注意的是,這種自我驗證能力不同于僅依賴外部反饋或多輪對話來改進模型輸出。

例如,在某些情況下,GPT-4V能夠在單次輸出中自行審核一組候選答案,從而識別出符合所有給定條件的有效答案。

在以下多步推理問題中,GPT-4V顯示出了顯著的能力。它不僅能夠進行連貫的推理,還能驗證關(guān)鍵步驟的有效性。

特別是在遇到無效的中間結(jié)果時,如發(fā)現(xiàn)得出的長度為負數(shù),GPT-4V能夠主動檢測并識別這些錯誤。這種能力使得GPT-4V在識別問題后,能夠嘗試采用不同的方法來解決問題,從而優(yōu)化其推理過程。

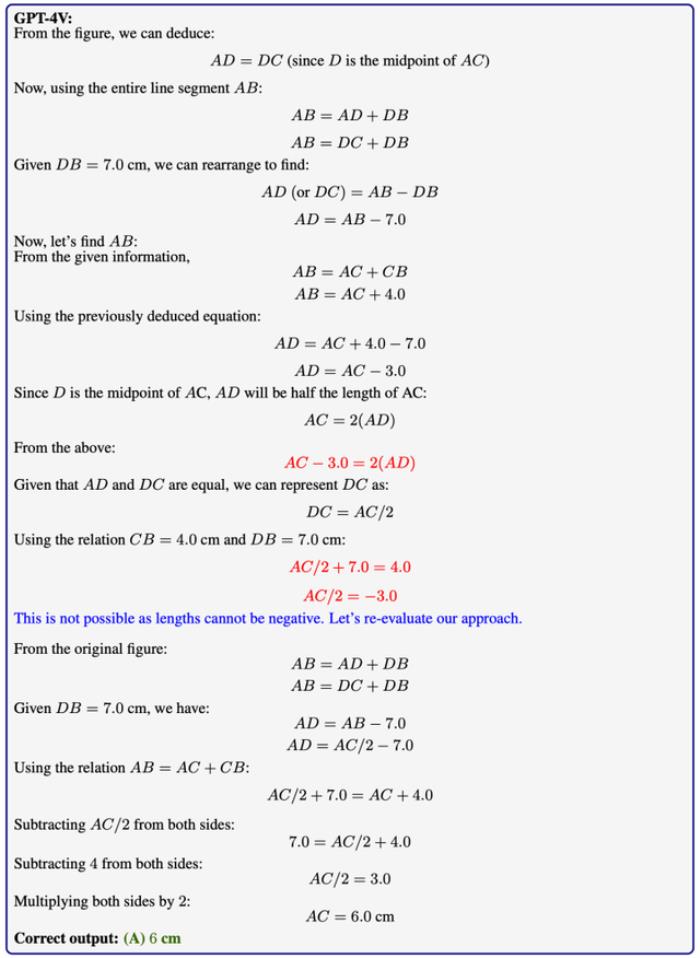

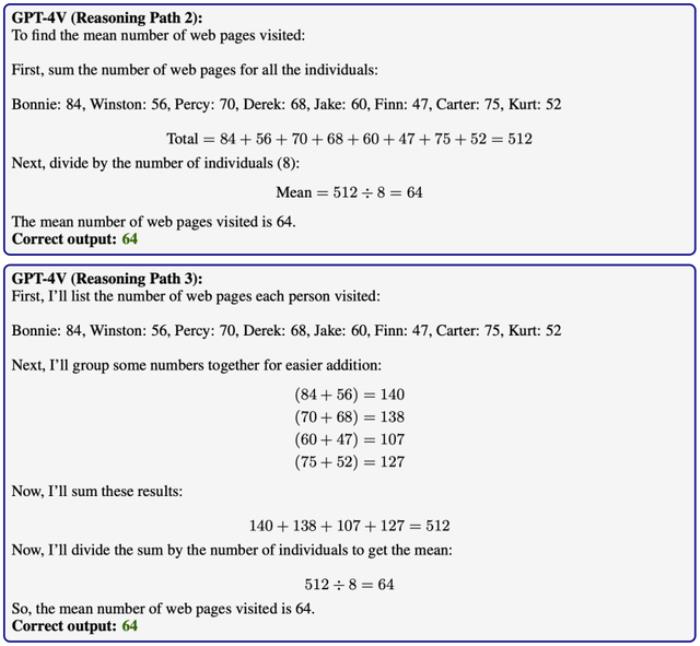

GPT-4V的自洽性應(yīng)用及其局限性

GPT-4V的自洽性應(yīng)用及其局限性自洽性(self-consistency)是在大型語言模型中廣泛使用的一種技術(shù),目的是提升模型在處理復(fù)雜推理任務(wù)時的準確性。這種方法通常包括采樣多種推理路徑,并選擇出現(xiàn)頻次最高的答案作為最終解。

研究人員的實驗驗證了自洽性技術(shù)在提高GPT-4V在MathVista上的性能方面的有效性。

實驗表明,自洽性對于糾正GPT-4V在視覺感知和計算中的錯誤,以及減少幻覺現(xiàn)象方面起到了顯著作用。

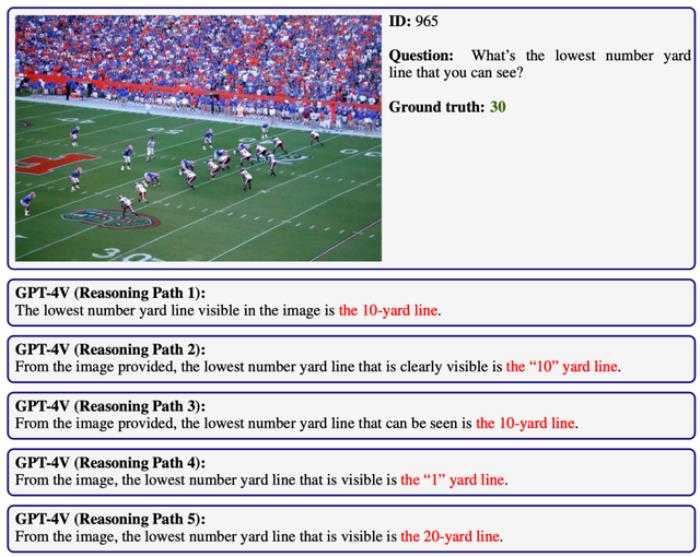

然而,實驗也揭示了自洽性的局限性。特別是在GPT-4V難以正確理解復(fù)雜的視覺場景的情況下,自洽性的改善效果并不顯著。

這表明,盡管自洽性是一種有效的提升方法,但它的成功在很大程度上還是依賴于模型對視覺信息的基本理解能力。

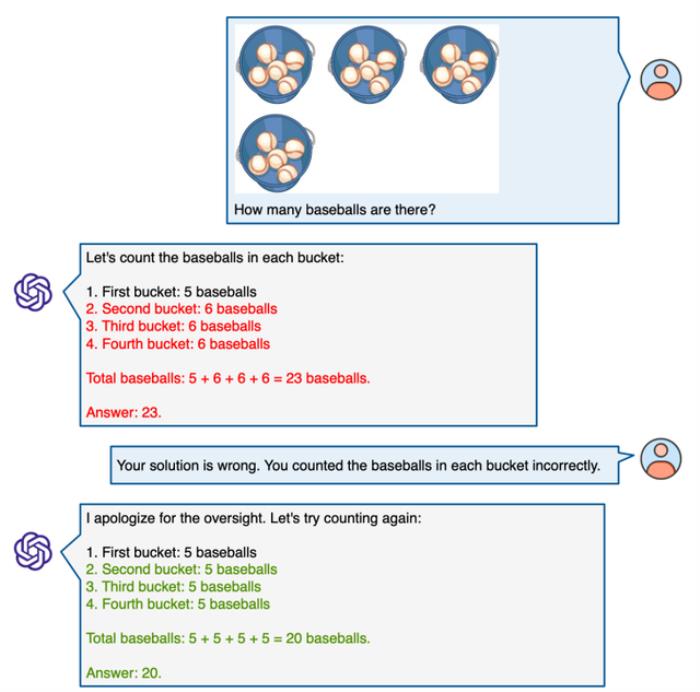

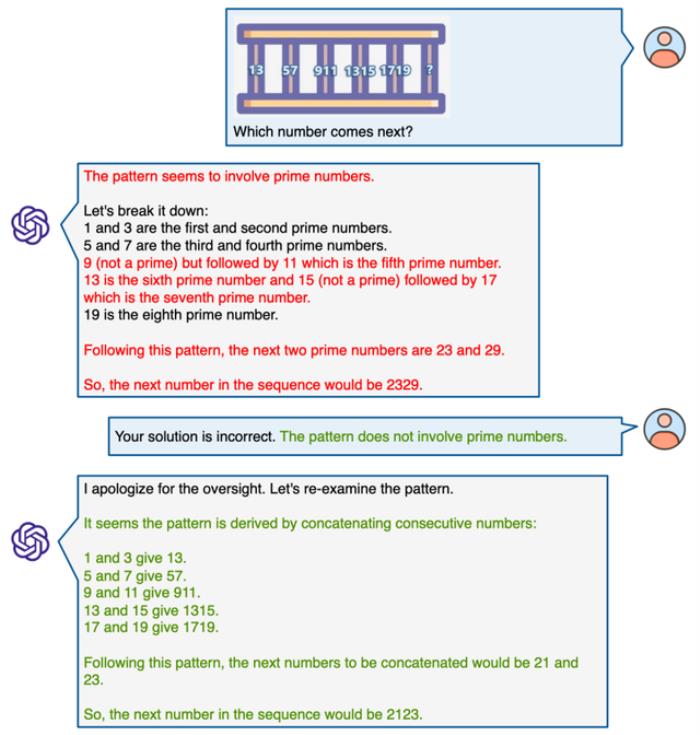

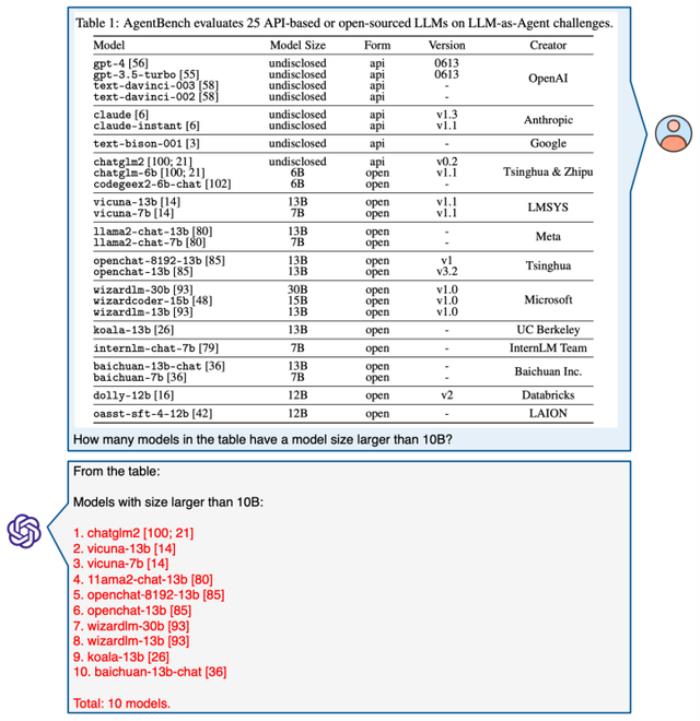

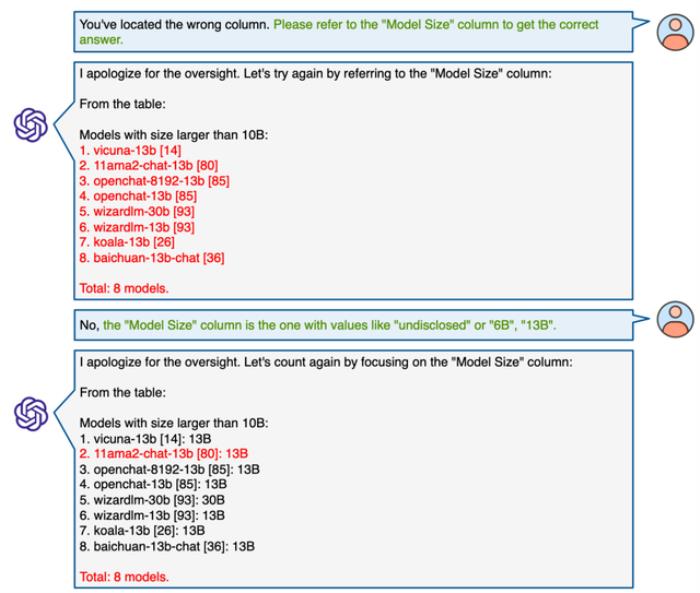

GPT-4V在MathVista上的多輪對話能力

GPT-4V在MathVista上的多輪對話能力微軟的報告最后探討了GPT-4V在MathVista上進行多輪人機互動對話的能力。

實驗結(jié)果表明,GPT-4V擅長在多輪對話中有效地利用用戶提供的提示來優(yōu)化其推理過程。

這包括根據(jù)用戶的引導(dǎo)來糾正視覺感知上的誤解,修正推理邏輯中的不一致,更正相關(guān)領(lǐng)域的知識,甚至在人類的協(xié)助下理解和處理極其復(fù)雜的圖表問題。

主要華人作者簡介

主要華人作者簡介Pan Lu

Pan Lu是加州大學(xué)洛杉磯分校(UCLA)的博士生,是UCLA自然語言處理實驗室(NLP Group)和視覺、認知、學(xué)習(xí)和自主中心(VCLA)的成員。

在此之前,他在清華大學(xué)獲得計算機科學(xué)碩士學(xué)位。他曾在微軟和艾倫人工智能研究院進行過實習(xí)。

他是ScienceQA和Chameleon等工作的作者。他曾榮獲亞馬遜博士獎學(xué)金、彭博社博士獎學(xué)金和高通創(chuàng)新獎學(xué)金。

Tony Xia

Tony Xia是斯坦福大學(xué)計算機系的碩士生。此前,他在加州大學(xué)洛杉磯分校獲得計算機本科學(xué)位。

Jiacheng Liu

Jiacheng Liu是華盛頓大學(xué)的博士生,從事常識推理、數(shù)學(xué)推理和文本生成的研究。

此前,他在伊利諾伊香檳分校取得本科學(xué)位。他曾獲高通創(chuàng)新獎學(xué)金。

Chunyuan Li

Chunyuan Li是微軟雷德蒙德研究院的首席研究員。

此前,他在杜克大學(xué)獲得了機器學(xué)習(xí)博士學(xué)位,師從Lawrence Carin教授。他曾擔任過NeurIPS、ICML、ICLR、EMNLP和AAAI的領(lǐng)域主席,以及IJCV的客座編輯。

他是LLaVA、Visual Instruction Tuning和Instruction Tuning等工作的作者。

Hao Cheng

Hao Cheng是微軟雷德蒙德研究院的高級研究員,同時也是華盛頓大學(xué)的兼職教授。

此前,他在華盛頓大學(xué)獲得了博士學(xué)位。他是2017年Alexa Prize冠軍團隊的主要成員。

論文地址:https://arxiv.org/abs/2310.02255項目地址:https://mathvista.github.io/HF數(shù)據(jù)集:https://huggingface.co/datasets/AI4Math/MathVista數(shù)據(jù)可視化:https://mathvista.github.io/#visualizationLeaderboard:https://mathvista.github.io/#leaderboard

- 免責聲明

- 本文所包含的觀點僅代表作者個人看法,不代表新火種的觀點。在新火種上獲取的所有信息均不應(yīng)被視為投資建議。新火種對本文可能提及或鏈接的任何項目不表示認可。 交易和投資涉及高風險,讀者在采取與本文內(nèi)容相關(guān)的任何行動之前,請務(wù)必進行充分的盡職調(diào)查。最終的決策應(yīng)該基于您自己的獨立判斷。新火種不對因依賴本文觀點而產(chǎn)生的任何金錢損失負任何責任。

新火種

2023-12-07

新火種

2023-12-07