微軟深夜放大招:GPT-4、DALL·E3、GPTs免費用,自研大模型專用AI芯片

原文來源:機器之心

圖片來源:由無界 AI生成

今天凌晨,微軟公司召開最新一場 Ignite 大會,CEO 薩提亞?納德拉在大會上介紹了 100 多項產品和技術的發布與更新,涉及范圍非常廣泛,包括應用、生產力以及安全性等多個方面。

Microsoft Ignite 是該公司為開發人員和 IT 專業人士舉辦的年度會議,而生成式 AI 的一切無疑是本年度的最大熱點。不出意外,在本次大會上,我們看到了來自 Bing Chat、專用 AI 芯片、Windows、Microsoft 365 和 Azure 等業務的最新動態。

大會現場還請來了英偉達創始人黃仁勛,之后微軟會將 AMD 、英偉達最新的處理器納入 Azure 云服務。

大會有哪些值得關注的亮點,我們繼續往下看。

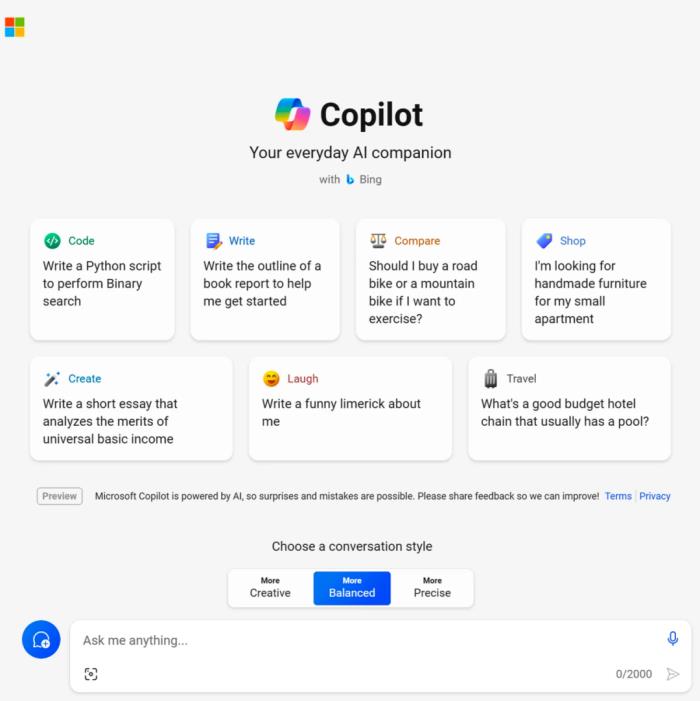

Bing Chat 更名為「Copilot」,GPT-4 、DALL?E 3、GPTs 免費用

大會上,微軟宣布了將 Bing Chat 和 Bing Chat Enterprise 全部更名為「Copilot」。

品牌重塑的動作意味著 Copilot 正在變成更獨立的一種體驗,用戶無需先導航到 Bing 即可訪問。Copilot 的免費版本仍然可以在 Bing 和 Windows 中訪問,但也會擁有專用域名「copilot.microsoft.com」。

在此之前,在微軟內部有十幾種產品共享「Copilot」這一品牌,一度讓人感到迷茫。該品牌標識始于 2021 年的 GitHub Copilot,今年 微軟又推出 Dynamics 365 Copilot、Windows 中的 Copilot、Microsoft Security Copilot 和 Microsoft 365 Copilot,似乎每一項業務都有自己的「Copilot」。

至于為什么要在這個 Copilot 矩陣中再加兩名成員,微軟解釋說是希望為消費者和企業客戶創造統一的 Copilot 體驗。

所以現在,Bing Chat 變成了微軟的第六個「Copilot」,但也可以理解為最通用的一個 Copilot。

今后,Bing 將是為其提供支持的一部分。此外,Copilot 基于最新的 OpenAI 模型,包括 GPT-4 和 DALL?E 3,在統一的體驗中提供文本和圖像生成功能。

但也有可能是,Bing Chat 并沒有為 Bing 本身帶來太多收益,因此微軟希望將這一產品從搜索引擎中剝離出來。

此時剝離是一件有趣的事情,因為微軟曾經投入了大量精力在自家的搜索引擎中推出 AI 產品,并將其視為從谷歌手中搶奪市場份額的一種方式。就比如今年初,微軟 CEO 納德拉曾稱「谷歌是搜索領域 800 磅重的大猩猩」,而微軟會讓它「跳舞」。

但后來的谷歌并沒有像微軟那樣急于將生成式 AI 產品整合到其搜索結果中。從目前來看,這種「不變」沒有帶來什么壞影響:根據 StatCounter 的數據,在 Bing Chat 推出近 10 個月后,Google 搜索引擎的市場份額仍然超過 91% 。

微軟特別提到,從 12 月 1 日起,使用 Microsoft Entra ID 登錄時,在 Bing、Edge 和 Windows 中使用 Copilot 的客戶將享受商業數據保護功能。Copilot 不會保存用戶使用過程中的 prompt 和回復,微軟無法直接訪問,也不會將其用于訓練底層模型。

此外,微軟還推出了另外一些「Copilot」:Microsoft Copilot Studio、Copilot for Azure、Copilot for Service 和 Copilot in Dynamics 365 Guides。

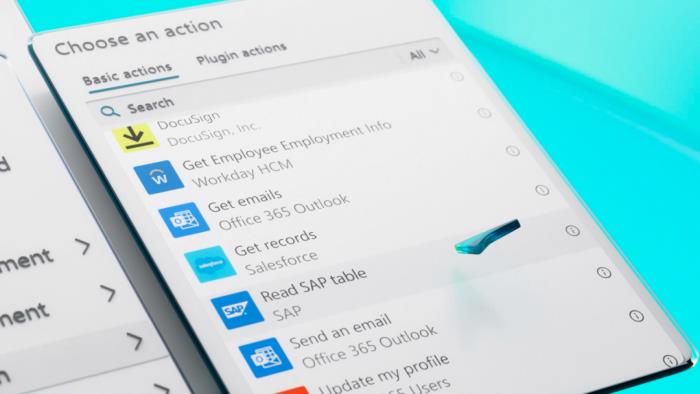

其中,Microsoft Copilot Studio 這一產品對標的是上周 OpenAI 推出的 GPTs,這個新平臺提供將微軟所發布 AI 應用與第三方數據連接起來的工具,同樣可以讓企業創建自定義 Copilot 或集成自定義 ChatGPT AI 聊天機器人。該產品已向現有 Copilot for Microsoft 365 訂閱者提供公測版本。

借助基于 Web 的 Copilot Studio,企業可以讓 Copilot for Microsoft 365 和 Copilot for Service 訪問其 CRM、企業資源管理系統和其他數據庫中的數據,使用預構建的連接器或它自己構建的連接器進行數據存儲。

「作為 OpenAI 和 Microsoft 戰略合作伙伴關系的一部分,我們可以輕松地將 OpenAI 的服務無縫集成到 Microsoft 現有的生態系統中,」微軟副總裁 Jared Spataro 說道。

首款 5nm AI 芯片,面向 LLM 訓練和推理

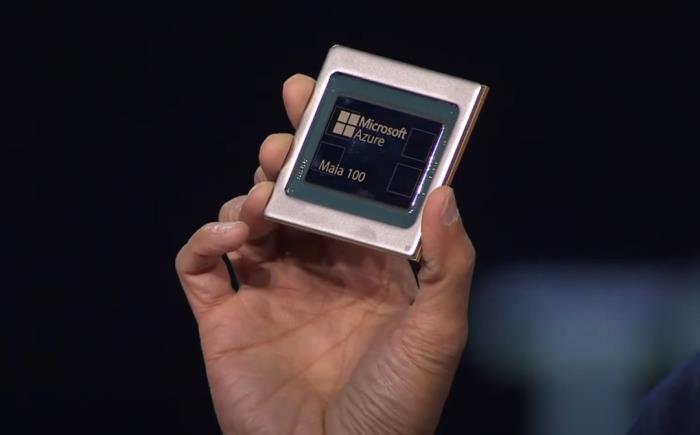

在將 Bing Chat 更名 Copilot 之外,微軟備受觀眾的自研芯片也終于露出廬山真面目了。

微軟發布了兩款為其云基礎設施設計的高端定制芯片,分別是 Azure Maia 100 AI 芯片和 Cobalt 100 CPU。這兩款芯片均由微軟內部構建,并面向整個云服務器堆棧進行了深度改造以優化性能、功耗和成本,預計將于 2024 年推出。

先看 Maia 100,這是微軟首個定制的內部 AI 加速器系列的首款產品,以一顆明亮的藍星命名,專為運行和優化云 AI 工作負載而設計,例如 GPT 3.5 Turbo 和 GPT-4 等大型語言模型的訓練和推理。

Maia 100 將為微軟 Azure 上最大的 AI 工作負載提供支持,包括為 OpenAI 所有工作負載提供支持的部分。微軟表示其在 Maia 的設計和測試階段一直與 OpenAI 展開合作。

在具體規格上,Maia 100 采用臺積電 5nm 制程工藝,擁有 1050 億個晶體管,只比 AMD MI300 AI GPU 芯片的 1530 億晶體管少了約 30%。Maia 100 首次支持實現 8-bit 以下的數據類型(MX 數據類型),以便共同設計軟硬件。這有助于支持更快的模型訓練和推理時間。

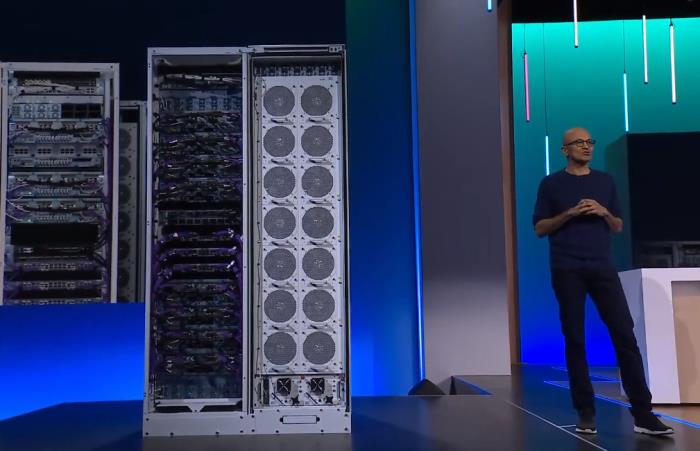

納德拉展示 Maia 100 的服務器機架和冷卻系統

Cobalt 100 以藍色顏料命名,是一款 128 核芯片,基于 Arm Neoverse CSS 設計構建,為微軟定制。Cobalt 100 旨在為微軟 Azure 上的通用云服務提供支持。關于這款芯片,微軟不僅保證它具有高性能,還特別注意電源管理。同時在芯片設計時有意控制每個核心以及每個虛擬機的性能和功耗。

微軟目前正在 Microsoft Teams 和 SQL Server 等工作負載上測試 Cobalt 100,并計劃明年為客戶提供虛擬機以處理各種工作負載。與微軟 Azure 目前使用的 Arm 服務器相比,Cobalt 100 有一些明顯的性能提升。

微軟初步測試表明,Cobalt 100 的性能比目前使用商用 Arm 服務器的數據中心的性能提升了 40%。不過微軟沒有透露完整的系統規格或基準測試。

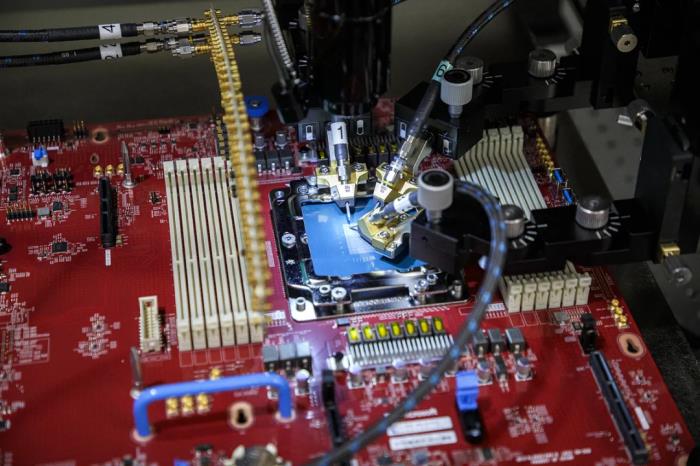

用于測試微軟 Azure Cobalt 片上系統的探針臺

不過,微軟也表示,Maia 100 和 Cobalt 100 兩者都將優先滿足自用,支持自己的 Azure 云服務。

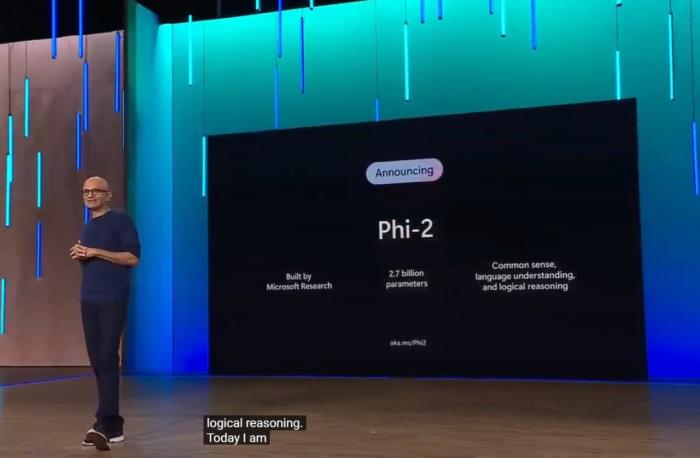

Phi-2 模型發布,在 Azure AI 服務中可以使用

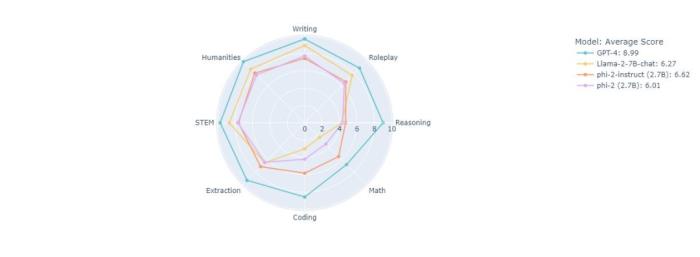

微軟宣布新的 Phi-2 模型將完全開源,該模型具有 27 億參數,與 Phi-1-5 相比,其推理能力和安全措施有了顯著提高,但與業內其他 Transformer 相比,它仍然相對較小。

Phi-2 更加穩健,數學推理能力提高了 50%,不僅如此,在其他任務上的推理能力提高也非常大,微調起來很方便。現在可以在 Azure AI 服務中使用。

今年 6 月,微軟在一篇題為《Textbooks Are All You Need》的論文中,用規模僅為 7B token 的「教科書質量」數據訓練了一個 1.3B 參數的模型 ——phi-1。盡管在數據集和模型大小方面比競品模型小幾個數量級,但 phi-1 在 HumanEval 的 pass@1 上達到了 50.6% 的準確率,在 MBPP 上達到了 55.5%。phi-1 證明高質量的「小數據」能夠讓模型具備良好的性能。

隨后,今年 9 月,微軟又發表了論文《Textbooks Are All You Need II: phi-1.5 technical report》,對高質量「小數據」的潛力做了進一步研究。文中提出了 Phi-1.5,參數 13 億,適用于 QA 問答、代碼等場景。

直到今天,Phi-2 正式發布,可以看出微軟對模型的更新迭代速度還是非常快的。

前面我們已經提到 Phi-2 在 Azure AI 服務中可用。不僅如此,OpenAI 的語音識別模型 Whisper-Large-V3 ;Salesforce 的能夠執行各種多模態任務的 BLIP 系列模型;OpenAI 的 CLIP 系列模型;Meta 的 Code Llama、SAM ;阿布扎比技術創新研究所(TII)開發的大型開源語言模型 Falcon;Stability AI 的 Stable Diffusion 等新模型都已經被收錄進來。

- 免責聲明

- 本文所包含的觀點僅代表作者個人看法,不代表新火種的觀點。在新火種上獲取的所有信息均不應被視為投資建議。新火種對本文可能提及或鏈接的任何項目不表示認可。 交易和投資涉及高風險,讀者在采取與本文內容相關的任何行動之前,請務必進行充分的盡職調查。最終的決策應該基于您自己的獨立判斷。新火種不對因依賴本文觀點而產生的任何金錢損失負任何責任。

新火種

2023-11-17

新火種

2023-11-17