OpenAI救了StableDiffusion!開源Dall·E3同款解碼器,來自Ilya宋飏等

來源:量子位

圖片來源:由無界 AI生成

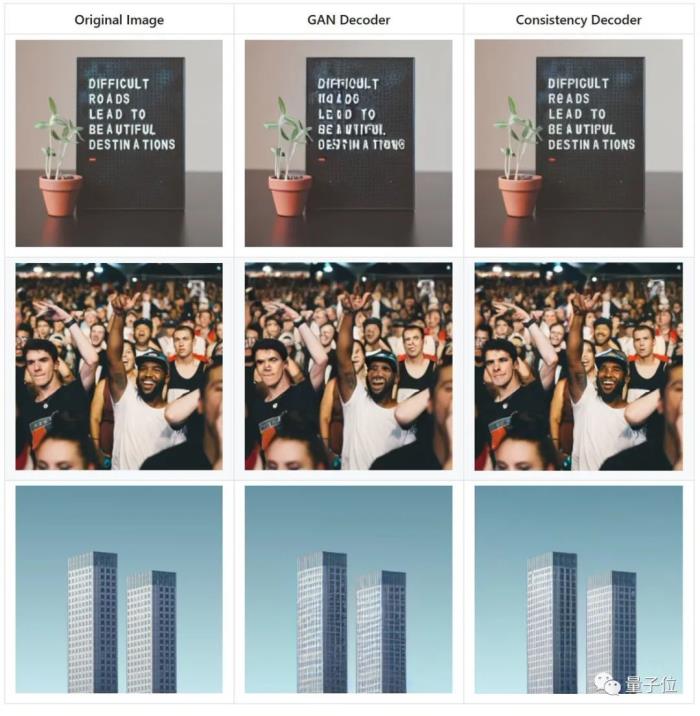

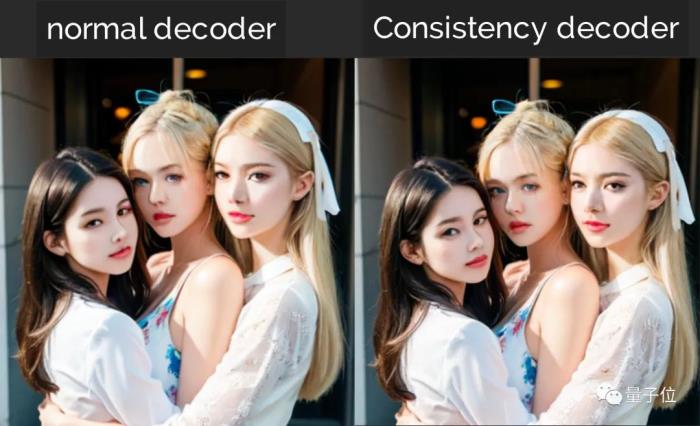

沒想到,OpenAI撈了“競對”Stable Diffusion一把。在熱火朝天的“AI春晚”上,OpenAI一口氣開源兩項工作,其中之一一致性解碼器,專門面向SD的VAE模型。

它能讓圖像生成質(zhì)量更高、更穩(wěn)定,比如多人臉、帶文字圖像以及線條控制方面。

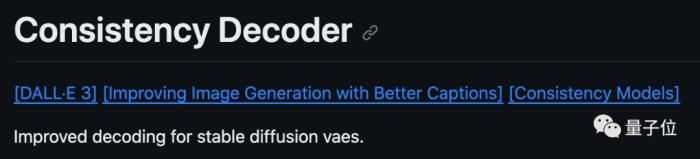

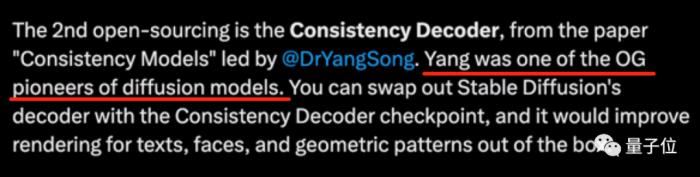

大V博主分析這個解碼器應(yīng)該是Dall·E 3同款,在GitHub項目頁上OpenAI也提供了Dall·E 3論文。

它具體支持的版本是Stable Diffusion 1.4/1.5。

項目頁上只放了一個例子,具體怎么訓(xùn)練沒有寫,被網(wǎng)友稱為“人狠話不多式開源”。

你們直接加載使用就好。

而且這個一致性解碼器頗有淵源。

它來自O(shè)penAI聯(lián)創(chuàng)及首席科學(xué)家Ilya、OpenAI華人新星宋飏等人提出的一致性模型(Consistency Models)。

上半年這個模型開源時就引發(fā)業(yè)內(nèi)震動,被評為能“終結(jié)擴(kuò)散模型”。

就在前不久,宋飏等人還對模型訓(xùn)練方法做了優(yōu)化,能進(jìn)一步提升圖像生成質(zhì)量。

開發(fā)者日的另一項重磅開源是語音大模型Whisper 3。它同樣出自傳奇人物之手,一作Alec Radford對GPT系列的構(gòu)建起到了重要作用。

網(wǎng)友們不禁感慨:還是愛看OpenAI開源啊,期待繼續(xù)開放更多模型。

一致性模型完成再進(jìn)化

先來看最初名震江湖的第一版一致性模型(Consistency Models)。

它旨在解決擴(kuò)散模型通過逐步迭代、導(dǎo)致圖像生成緩慢的問題。僅需3.5秒即可生成64張左右256×256的圖像。

相比擴(kuò)散模型,它主要有兩大優(yōu)勢:

其一,無需對抗訓(xùn)練(adversarial training),就能直接生成高質(zhì)量的圖像樣本。

其二,相比擴(kuò)散模型可能需要幾百甚至上千次迭代,一致性模型只需要一兩步就能搞定多種圖像任務(wù)——

包括上色、去噪、超分等,都可以在幾步之內(nèi)搞定,而不需要對這些任務(wù)進(jìn)行明確訓(xùn)練。(當(dāng)然,如果進(jìn)行少樣本學(xué)習(xí)的話,生成效果也會更好)

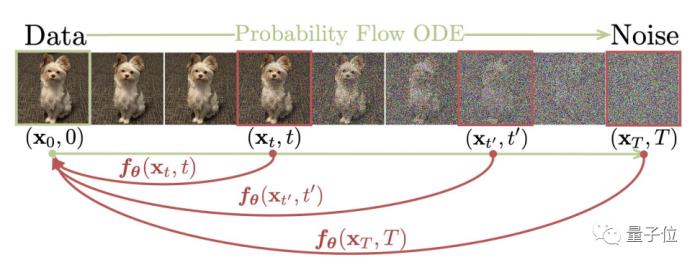

原理上,一致性模型直接把隨機(jī)的噪聲映射到復(fù)雜圖像上,輸出都是同一軌跡上的同一點(diǎn),所以實(shí)現(xiàn)了一步生成。

論文提出兩種訓(xùn)練方法,一種是基于一致性蒸餾,利用預(yù)訓(xùn)練的擴(kuò)散模型生成相鄰數(shù)據(jù)對,通過最小化模型輸出之間的差異,來訓(xùn)練一致性模型。

另一種方法是獨(dú)立訓(xùn)練,將一致性模型作為獨(dú)立生成模型訓(xùn)練。

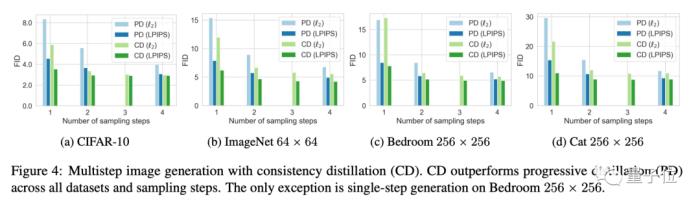

實(shí)驗(yàn)結(jié)果表明,一致性模型在一步和少步采樣方面優(yōu)于現(xiàn)有的蒸餾技術(shù),如漸進(jìn)式蒸餾。

當(dāng)作為獨(dú)立的生成模型進(jìn)行訓(xùn)練時,一致性模型可以與現(xiàn)有的一步非對抗生成模型在標(biāo)準(zhǔn)基準(zhǔn)測試匯總媲美,如CIFAR-10、ImageNet 64×64和LSUN 256×256。

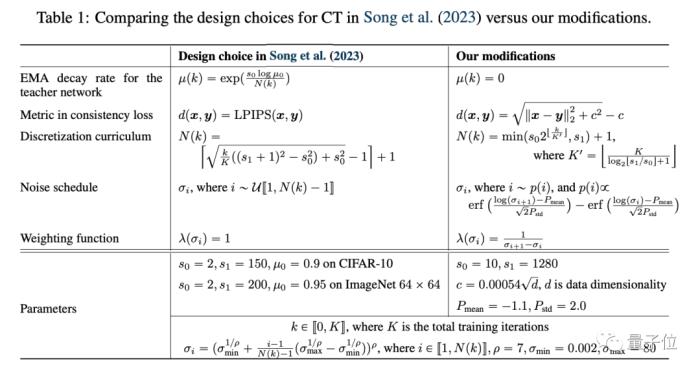

半年后發(fā)布的第二版論文,對訓(xùn)練方法進(jìn)行了優(yōu)化。

它通過優(yōu)化權(quán)重函數(shù)、噪聲嵌入和dropout,使得一致性模型在不需要依賴學(xué)習(xí)過的特征,也能達(dá)到很好的生成質(zhì)量。

它改進(jìn)了權(quán)重函數(shù)的選擇,使其隨著噪聲水平的增加而減小,這使得在較小噪聲水平處的一致性損失權(quán)重更大,從而提升樣本質(zhì)量。

同時調(diào)整了噪聲嵌入層的敏感性,使其降低對微小噪聲差異的敏感性,有助于提高連續(xù)時間一致性訓(xùn)練的穩(wěn)定性。

并且發(fā)現(xiàn)了在一致性模型中使用較大dropout、移除teacher network中的EMA、將學(xué)習(xí)過的特征距離(如LPIPS)替換Pseudo-Huber損失函數(shù),都能能進(jìn)一步提高圖像質(zhì)量。

One More Thing

回到這次最新開源的解碼器,第一波實(shí)測體驗(yàn)已經(jīng)來了。

目前看到的一些效果,提升不算明顯,而且不少人反映運(yùn)行速度慢。

但這還是最早期的測試,后續(xù)或許會有更多提升。

值得一提的是,領(lǐng)銜推出一致性模型的宋飏,年紀(jì)輕輕但是已被評為擴(kuò)散模型圈OG(元老)了。

△來自英偉達(dá)AI科學(xué)家Jim Fan推特

今年,憑借一致性模型,宋飏也名震江湖。這位大佬16歲就當(dāng)理科狀元上清華了,關(guān)于他的更多故事可戳:OpenAI當(dāng)紅新星宋飏:最新研究獲評「終結(jié)擴(kuò)散模型」,16歲上清華

論文地址:[1]https://arxiv.org/abs/2310.14189[2]https://arxiv.org/abs/2303.01469

- 免責(zé)聲明

- 本文所包含的觀點(diǎn)僅代表作者個人看法,不代表新火種的觀點(diǎn)。在新火種上獲取的所有信息均不應(yīng)被視為投資建議。新火種對本文可能提及或鏈接的任何項目不表示認(rèn)可。 交易和投資涉及高風(fēng)險,讀者在采取與本文內(nèi)容相關(guān)的任何行動之前,請務(wù)必進(jìn)行充分的盡職調(diào)查。最終的決策應(yīng)該基于您自己的獨(dú)立判斷。新火種不對因依賴本文觀點(diǎn)而產(chǎn)生的任何金錢損失負(fù)任何責(zé)任。

新火種

2023-11-12

新火種

2023-11-12