OpenAI:強化學習確實可顯著提高LLM性能,DeepSeekR1、Kimik1.5發(fā)現(xiàn)o1的秘密

最近,OpenAI 發(fā)了一篇論文,宣稱 o3 模型在 2024 IOI 上達到了金牌水平,并且在 CodeForces 上獲得了與精英級人類相當?shù)牡梅帧?/p>

他們是怎么做到的呢?OpenAI 在論文開篇就用一句話進行了總結(jié):「將強化學習應(yīng)用于大型語言模型(LLM)可顯著提高在復雜編程和推理任務(wù)上的性能。」

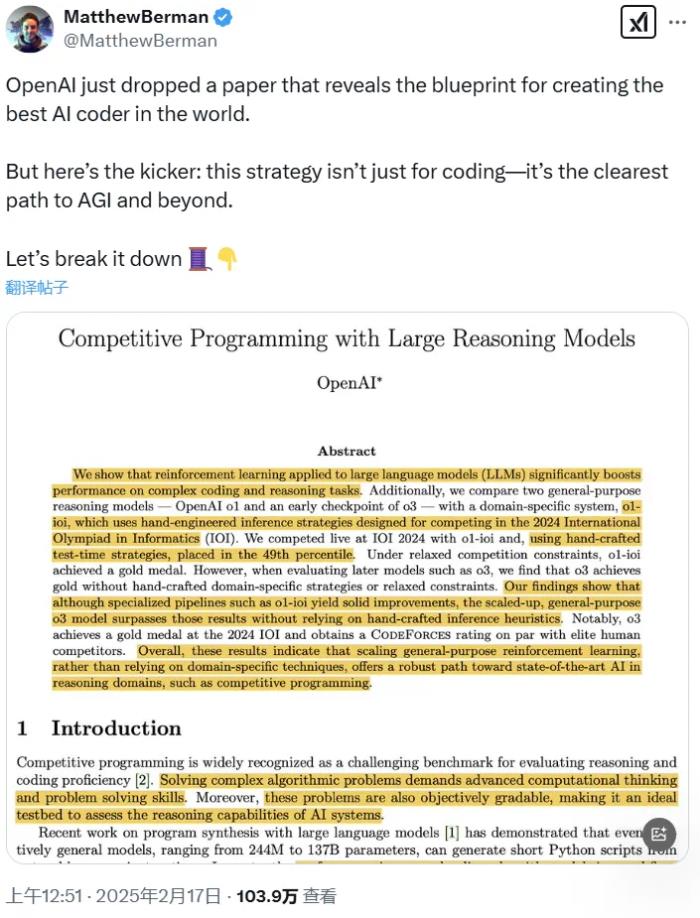

這兩天,這篇論文又引起了廣泛熱議,尤其是其中被博主 Matthew Berman 指出的關(guān)鍵:這種策略不僅適用于編程,它還是通往 AGI 及更遠未來的最清晰路徑。

也就是說,這篇論文不僅僅是展示了 AI 編程的新成績,更是給出了一份創(chuàng)造世界最佳 AI 程序員乃至 AGI 的藍圖。正如 OpenAI 在論文中寫到的那樣:「這些結(jié)果表明,擴展通用強化學習,而不是依賴特定領(lǐng)域的技術(shù),能為在推理領(lǐng)域(例如競技編程)實現(xiàn) SOTA AI 提供一條穩(wěn)健的路徑。」

此外,這篇論文還特別提到,中國的 DeepSeek-R1 和 Kimi k1.5 通過獨立研究顯示,利用思維鏈(CoT)學習方法可顯著提升模型在數(shù)學解題與編程挑戰(zhàn)中的綜合表現(xiàn),這也是 o1 此前沒有公開過的「配方」—— 直到前些天才半遮半掩地揭示一些,參閱機器之心報道《感謝 DeepSeek,ChatGPT 開始公開 o3 思維鏈,但不完整》。(1 月 20 日,DeepSeek 和 Kimi 在同一天發(fā)布推理模型 R1 和 k1.5,兩個模型均有超越 OpenAI o1 的表現(xiàn)。)

下面,我們先看看這篇論文的核心內(nèi)容,然后再看看 Matthew Berman 為什么說擴展通用強化學習是「通往 AGI 及更遠未來的最清晰路徑」。

OpenAI 從自家的三個模型入手,這三個模型分別是 o1 、 o1-ioi 以及 o3。

OpenAI o1 :

在競爭性編程任務(wù)上的性能大幅提升

o1 是一個通過強化學習訓練的大型語言模型,旨在解決復雜的推理任務(wù)。

在回答問題之前,o1 會先生成一個內(nèi)部思維鏈,并且用強化學習完善這種思維鏈過程,幫助模型識別和糾正錯誤,將復雜任務(wù)分解為可管理的部分,并在一種方法失敗時探索替代的解決方案路徑。這些上下文推理能力顯著提升了 o1 在廣泛任務(wù)上的整體表現(xiàn)。

Kimi 研究員 Flood Sung 也談到了推理模型 Kimi k1.5 的研發(fā)過程也有類似的發(fā)現(xiàn),他指出:「長思維鏈的有效性曾在 Kimi 內(nèi)部得到驗證,使用很小的模型,訓練模型做幾十位的加減乘除運算,將細粒度的運算過程合成出來變成很長的 CoT 數(shù)據(jù)做 SFT,就可以獲得非常好的效果。」他說,「依然記得當時看到那個效果的震撼。」

除此之外,o1 還可調(diào)用外部工具驗證代碼。

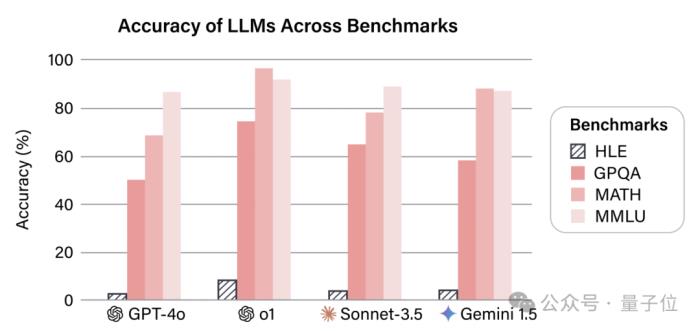

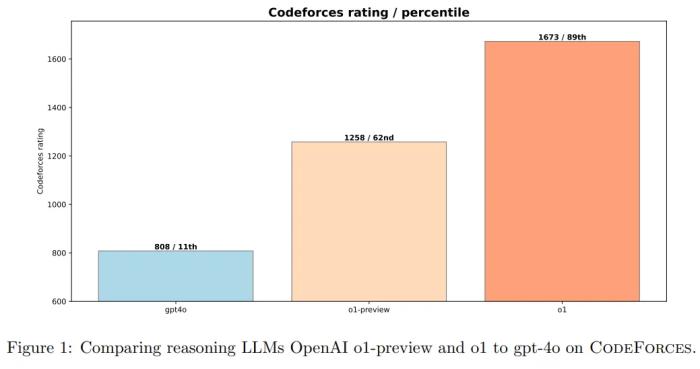

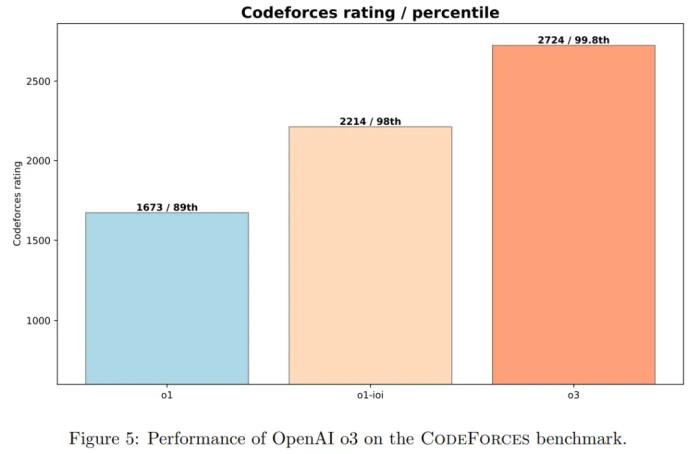

不同模型在 CodeForces 基準上的表現(xiàn)。

OpenAI 將 o1 與非推理型大語言模型(gpt-4o)以及早期的推理模型(o1-preview)進行了對比。

圖 1 展示了 o1-preview 和 o1 都顯著優(yōu)于 gpt-4o,這凸顯了強化學習在復雜推理任務(wù)中的有效性。

o1-preview 模型在 CodeForces 上的評分達到了 1258 分,相比 gpt-4o 的 808 分有了顯著提升。進一步的訓練將 o1 的評分提升至 1673,為 AI 在競爭性編程中的表現(xiàn)樹立了新的里程碑。

OpenAI o1-ioi:

增加強化學習和測試時推理就能帶來大幅提升

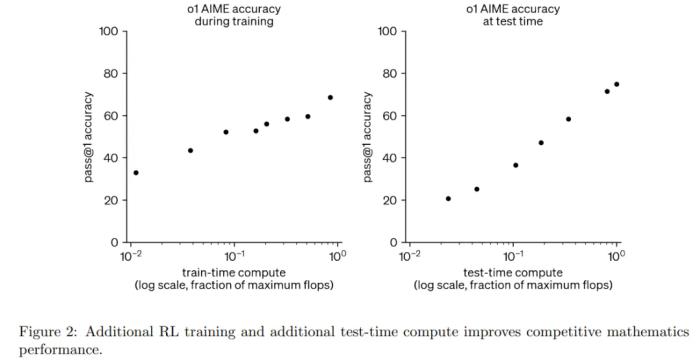

OpenAI 在開發(fā)和評估 OpenAI o1 的過程中,他們發(fā)現(xiàn)增加 RL 計算量和測試時推理計算量都能持續(xù)提升模型性能。

如圖 2 所示,擴展 RL 訓練和延長測試時推理可以顯著提升模型性能。基于這些洞見,OpenAI 創(chuàng)建了 o1-ioi 系統(tǒng)。

他們從以下方面來實現(xiàn)。

第一步是擴展 OpenAI o1 的強化學習階段,重點關(guān)注編碼任務(wù)。具體如下:

從 OpenAI o1 檢查點開始繼續(xù)強化學習訓練;特別強調(diào)了具有挑戰(zhàn)性的編程問題,幫助模型改進 C++ 生成和運行時檢查。指導模型以 IOI 提交格式生成輸出。在高層次上,OpenAI 將每個 IOI 問題分解為子任務(wù),并為每個子任務(wù)從 o1-ioi 中采樣了 10,000 個解決方案,然后采用基于聚類和重新排名的方法來決定從這些解決方案中提交哪些。

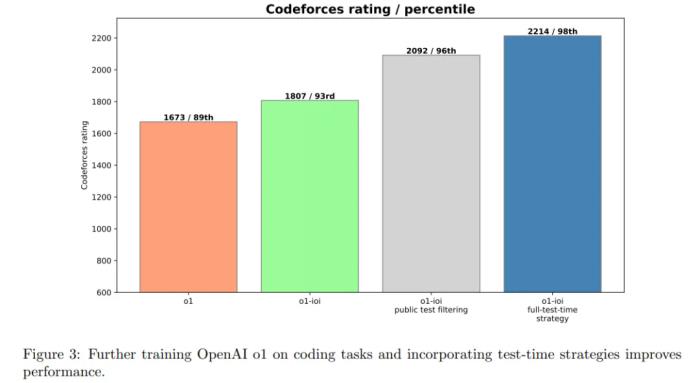

圖 3 顯示,o1-ioi 的 CodeForces 評分達到 1807,超過 93% 的競爭對手 —— 這證明了在編碼任務(wù)上進行額外的 RL 訓練可以帶來明顯的改進。

這些結(jié)果證實,特定領(lǐng)域的 RL 微調(diào)與高級選擇啟發(fā)式相結(jié)合可以顯著提高編程結(jié)果。

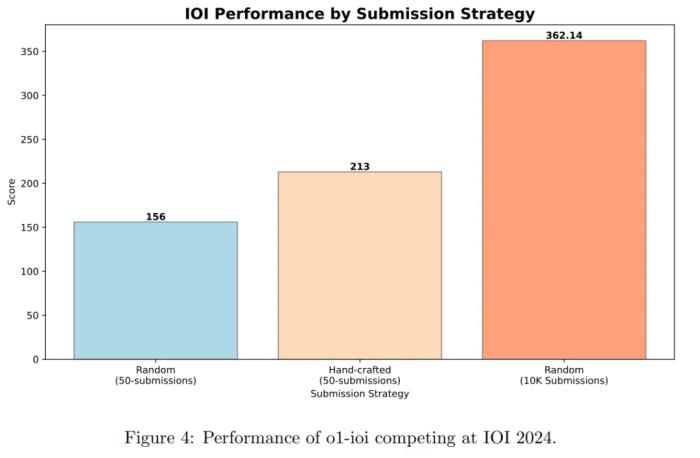

圖 4 為 IOI 比賽結(jié)果。在比賽期間,系統(tǒng)為每道問題生成了 10,000 個候選解決方案,并使用測試時選擇策略從中篩選出 50 次提交。最終,模型獲得了 213 分,排名位于前 49 % 。

OpenAI o3:

無需人類的強化學習效果卓越

基于從 o1 和 o1-ioi 獲得的洞見,OpenAI 又探索了僅依賴強化學習(RL)結(jié)果如何,而不依賴于人為設(shè)計的測試時策略。

甚至 OpenAI 試圖探索進一步的 RL 訓練,模型是否能夠自主開發(fā)和執(zhí)行自己的測試時推理策略。

為此,OpenAI 使用了 o3 的早期檢查點,以評估其在競技編程任務(wù)上的表現(xiàn)。

如圖 5 所示,進一步的強化學習(RL)訓練顯著提升了 o1 和完整 o1-ioi 系統(tǒng)的表現(xiàn)。o3 能夠以更高的可靠性解決更廣泛的復雜算法問題,使其能力更接近 CodeForces 上的頂級人類程序員。

圖 7 為模型在 IOI 2024 上的最終得分。2024 年比賽的總分上限為 600 分,金牌的分數(shù)線約為 360 分。

以下是關(guān)鍵結(jié)果:

o1-ioi 在 50 次提交的限制下獲得了 213 分,而在 10,000 次提交的限制下提升至 362.14 分,略高于金牌分數(shù)線。

o3 在 50 次提交的限制下獲得了 395.64 分,超過了金牌分數(shù)線。

這些結(jié)果表明,o3 在不依賴針對 IOI 手工設(shè)計的測試時策略的情況下,表現(xiàn)優(yōu)于 o1-ioi。相反,o3 在訓練過程中自然涌現(xiàn)的復雜測試時技術(shù)(例如生成暴力解法以驗證輸出)足以替代 o1-ioi 所需的手工設(shè)計的聚類和選擇流程。

總體而言,在 IOI 2024 上的結(jié)果證實,僅通過大規(guī)模強化學習訓練即可實現(xiàn)最先進的編程和推理性能。通過獨立學習生成、評估和優(yōu)化解決方案,o3 超越了 o1-ioi,而無需依賴領(lǐng)域特定的啟發(fā)式方法或基于聚類的方法。

另外,在 CodeForces 上,如前圖 5 所示,o3 的成績達到了 2724 分,已經(jīng)進入了全球前 200 名。

該論文的作者之一 Ahmed El-Kishky 在

- 免責聲明

- 本文所包含的觀點僅代表作者個人看法,不代表新火種的觀點。在新火種上獲取的所有信息均不應(yīng)被視為投資建議。新火種對本文可能提及或鏈接的任何項目不表示認可。 交易和投資涉及高風險,讀者在采取與本文內(nèi)容相關(guān)的任何行動之前,請務(wù)必進行充分的盡職調(diào)查。最終的決策應(yīng)該基于您自己的獨立判斷。新火種不對因依賴本文觀點而產(chǎn)生的任何金錢損失負任何責任。

新火種

2025-02-20

新火種

2025-02-20