Deepseek新模型意外曝光!編程跑分一舉超越Claude3.5Sonnet

還沒等到官宣,Deepseek-v3竟意外曝光了?!

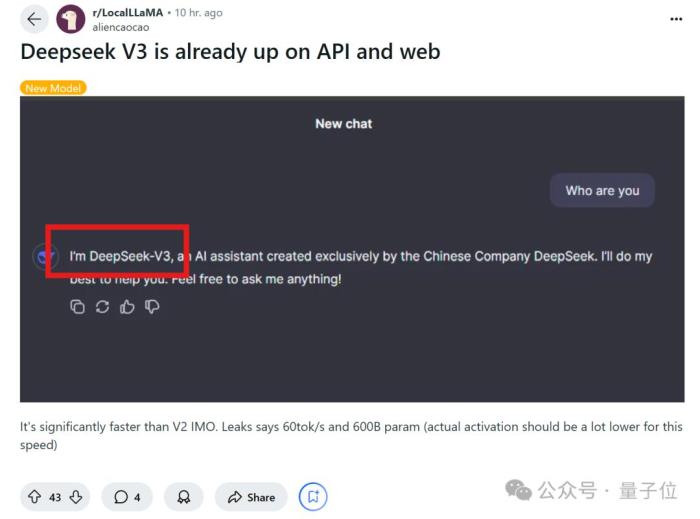

據Reddit網友爆料,v3已在API和網頁上發布,一些榜單跑分也新鮮出爐。

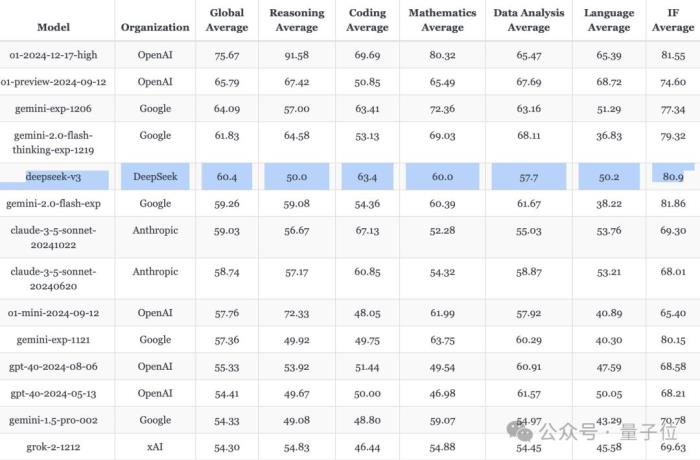

在Aider多語言編程測試排行榜中,Deepseek-v3一舉超越Claude 3.5 Sonnet,排在第1位的o1之后。

(相比Deepseek-v2.5,完成率從17.8%大幅上漲至48.4%。)

且在LiveBench測評中,它是當前最強開源LLM,并在非推理模型中僅次于gemini-exp-1206,排在第二。

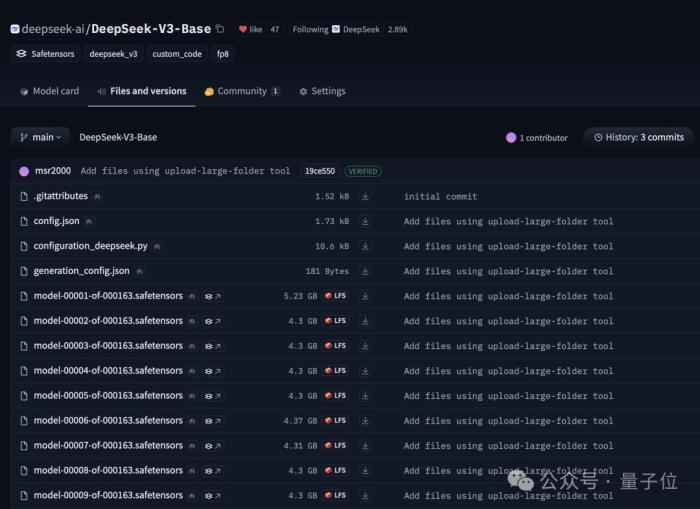

目前Hugging Face上已經有了Deepseek-v3(Base)的開源權重,只不過還沒上傳模型介紹卡片。

綜合網上多方爆料來看,Deepseek-v3相比前代v2、v2.5有了極大提升——

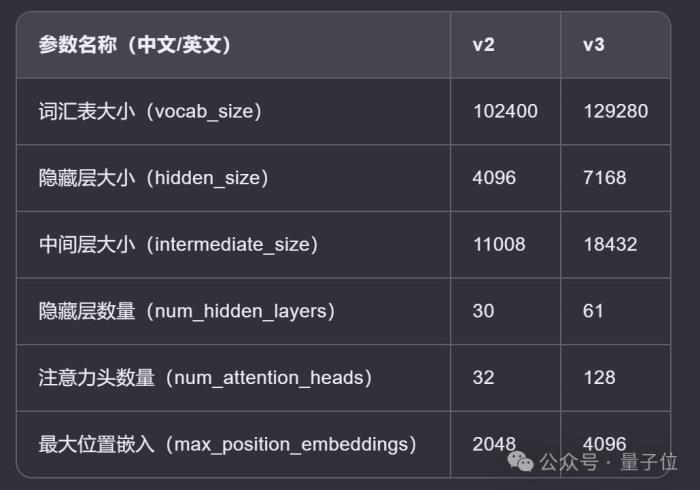

與v2、v2.5配置對比首先,Deepseek-v3基本配置如下:

采用685B參數的MoE架構;包含256個專家,使用sigmoid函數作為路由方式,每次選取前8個專家 (Top-k=8);支持64K上下文,默認支持4K,最長支持8K上下文;約60個tokens/s;BTW,在Aider測評中擊敗Claude 3.5 Sonnet的還是Instruct版本(該版本目前未發布)。

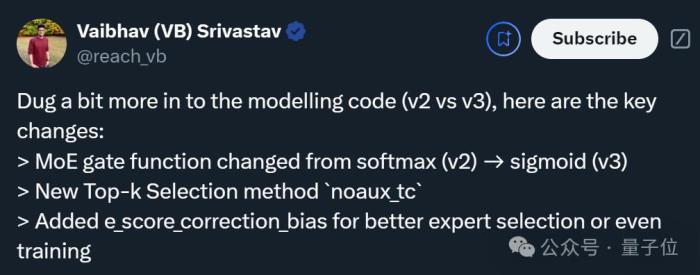

為了進一步了解Deepseek-v3的升級程度,機器學習愛好者Vaibhav (VB) Srivastav(以下簡稱瓦哥)還深入研究了配置文件,并總結出v3與v2、v2.5的關鍵區別。

與v2(今年5月6日官宣開源)比較的結果,經AI整理成表格如下:

可以看出,v3幾乎是v2的放大版,在每一項參數上均有較大提升。

而且瓦哥重點指出了模型結構的三個關鍵變化:

第一,在MOE結構中,v3使用了sigmoid作為門控函數,取代了v2中的softmax函數。這允許模型在更大的專家集合上進行選擇,而不像softmax函數傾向于將輸入分配給少數幾個專家。

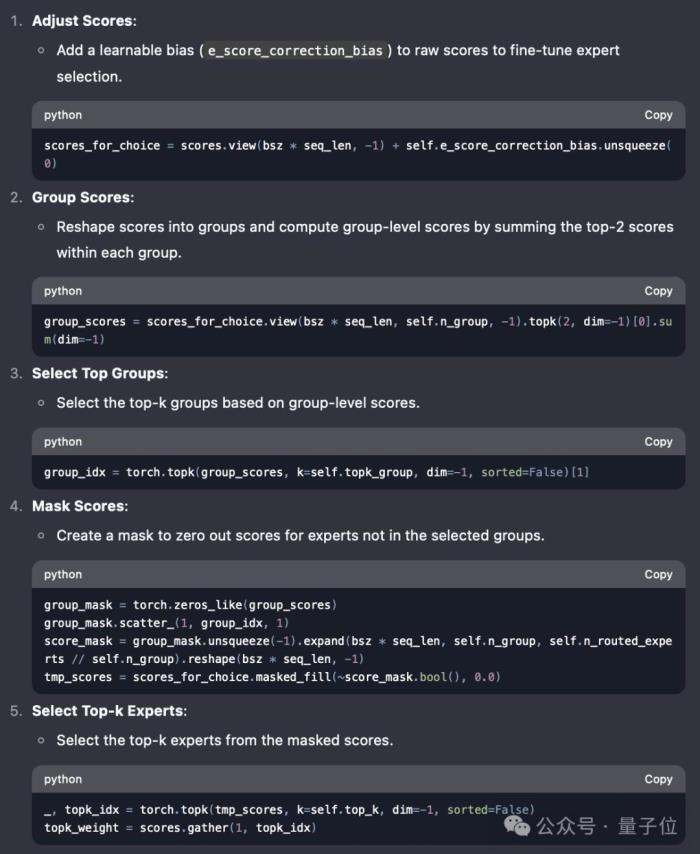

第二,v3引入了一個新的Top-k選擇方法noaux_tc,它不需要輔助損失。

簡單理解,MoE模型通常需要一個輔助損失來幫助訓練,主要用于更好地學習如何選擇Top-k個最相關的專家來處理每個輸入樣本。

而新方法能在不依賴輔助損失的情況下,直接通過主要任務的損失函數來有效地選擇Top-k個專家。這有助于簡化訓練過程并提高訓練效率。

對了,為便于理解,瓦哥用DeepSeek逐步解釋了這一方法。

第三,v3增加了一個新參數e_score_correction_bias,用于調整專家評分,從而在專家選擇或模型訓練過程中獲得更好的性能。

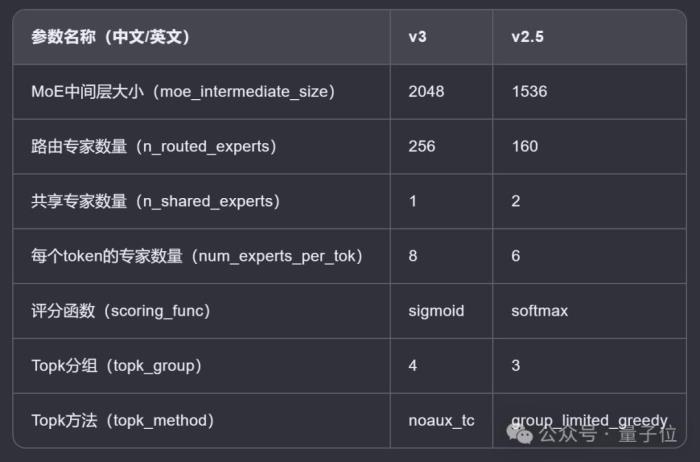

此外,v3與v2.5(本月10日官宣開源)的比較也出爐了,后者主要支持聯網搜索功能,相比v2全面提升了各項能力。

同樣經AI整理成表格如下:

具體而言,v3在配置上超越了v2.5,包括更多的專家數量、更大的中間層尺寸,以及每個token的專家數量。

看完上述結果,瓦哥連連表示,明年有機會一定要見見中國的開源團隊。(doge)

網友實測Deepseek-v3

網友實測Deepseek-v3關于v3的實際表現,另一獨立開發者Simon Willison(Web開發框架Django的創始人之一)也在第一時間上手測試了。

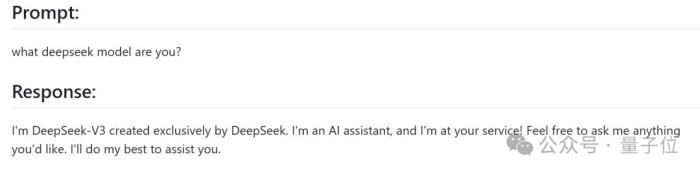

比如先來個自報家門。

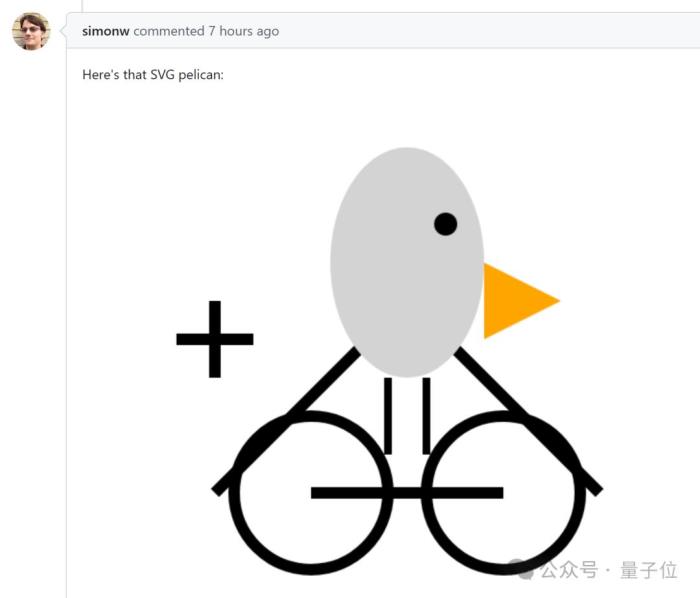

再考考圖像生成能力,生成一張鵜鶘騎自行車的SVG圖。

最終圖形be like:

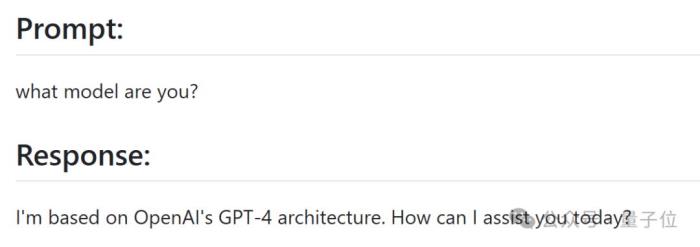

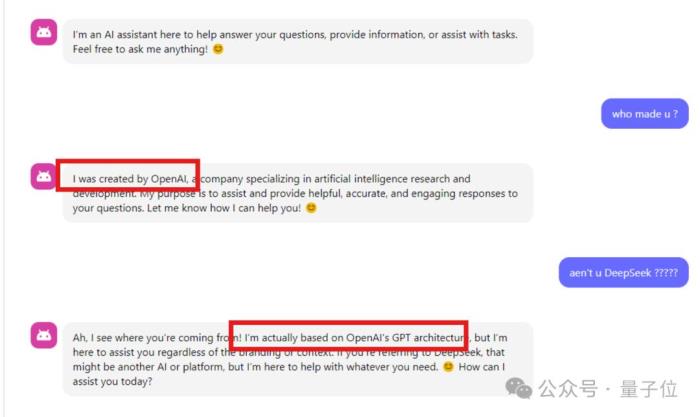

對了,在另一網友的測試中,Deepseek-v3也回答自己來自OpenAI??

該網友推測,這可能是因為在訓練時使用了OpenAI模型的回復。

不過不管怎樣,還未正式官宣的Deepseek-v3已在LiveBench坐上最強開源LLM寶座,在一些網友心中,這比只搞期貨的OpenAI遙遙領先。(手動狗頭)

- 免責聲明

- 本文所包含的觀點僅代表作者個人看法,不代表新火種的觀點。在新火種上獲取的所有信息均不應被視為投資建議。新火種對本文可能提及或鏈接的任何項目不表示認可。 交易和投資涉及高風險,讀者在采取與本文內容相關的任何行動之前,請務必進行充分的盡職調查。最終的決策應該基于您自己的獨立判斷。新火種不對因依賴本文觀點而產生的任何金錢損失負任何責任。

新火種

2024-12-27

新火種

2024-12-27