打入AI底層!NUS尤洋團(tuán)隊(duì)用擴(kuò)散模型構(gòu)建神經(jīng)網(wǎng)絡(luò)參數(shù),LeCun點(diǎn)贊

擴(kuò)散模型,迎來了一項(xiàng)重大新應(yīng)用——

像Sora生成視頻一樣,給神經(jīng)網(wǎng)絡(luò)生成參數(shù),直接打入了AI的底層!

這就是新加坡國(guó)立大學(xué)尤洋教授團(tuán)隊(duì)聯(lián)合UCB、Meta AI實(shí)驗(yàn)室等機(jī)構(gòu)最新開源的研究成果。

具體來說,研究團(tuán)隊(duì)提出了一種用于生成神經(jīng)網(wǎng)絡(luò)參數(shù)的擴(kuò)散模型p(arameter)-diff。

用它來生成網(wǎng)絡(luò)參數(shù),速度比直接訓(xùn)練最多提高44倍,而且表現(xiàn)毫不遜色。

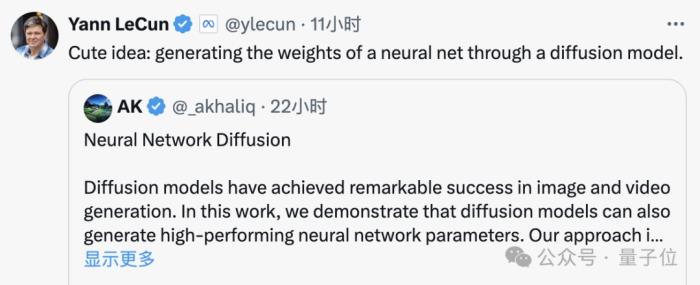

這一模型一經(jīng)發(fā)布,就迅速在AI社區(qū)引發(fā)強(qiáng)烈討論,圈內(nèi)人士對(duì)此的驚嘆,毫不亞于普通人看到Sora時(shí)的反應(yīng)。

甚至有人直接驚呼,這基本上相當(dāng)于AI在創(chuàng)造新的AI了。

就連AI巨頭LeCun看了之后,也點(diǎn)贊了這一成果,表示這真的是個(gè)cute idea。

而實(shí)質(zhì)上,p-diff也確實(shí)具有和Sora一樣重大的意義,對(duì)此同實(shí)驗(yàn)室的Fuzhao Xue(薛復(fù)昭)博士進(jìn)行了詳細(xì)解釋:

言歸正傳,p-diff到底是如何生成神經(jīng)網(wǎng)絡(luò)參數(shù)的呢?

將自編碼器與擴(kuò)散模型結(jié)合

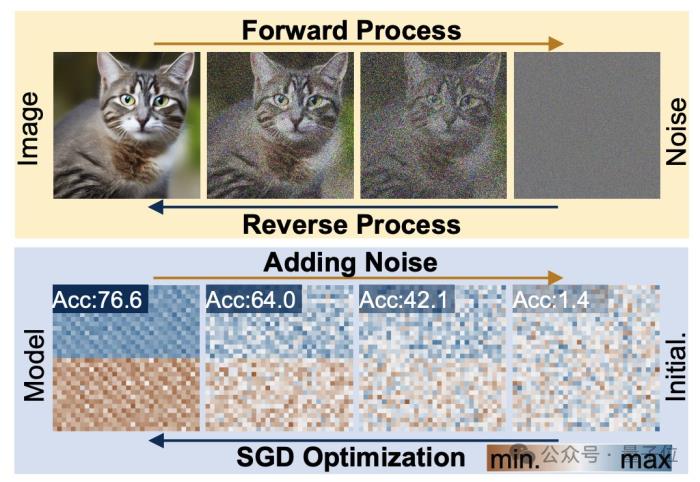

要弄清這個(gè)問題,首先要了解一下擴(kuò)散模型和神經(jīng)網(wǎng)絡(luò)各自的工作特點(diǎn)。

擴(kuò)散生成過程,是從隨機(jī)分布到高度特定分布的轉(zhuǎn)變,通過復(fù)合噪聲添加,將視覺信息降級(jí)為簡(jiǎn)單噪聲分布。

而神經(jīng)網(wǎng)絡(luò)訓(xùn)練,同樣遵循這樣的轉(zhuǎn)變過程,也同樣可以通過添加噪聲的方式來降級(jí),研究人員正是在這一特點(diǎn)的啟發(fā)之下提出p-diff方法的。

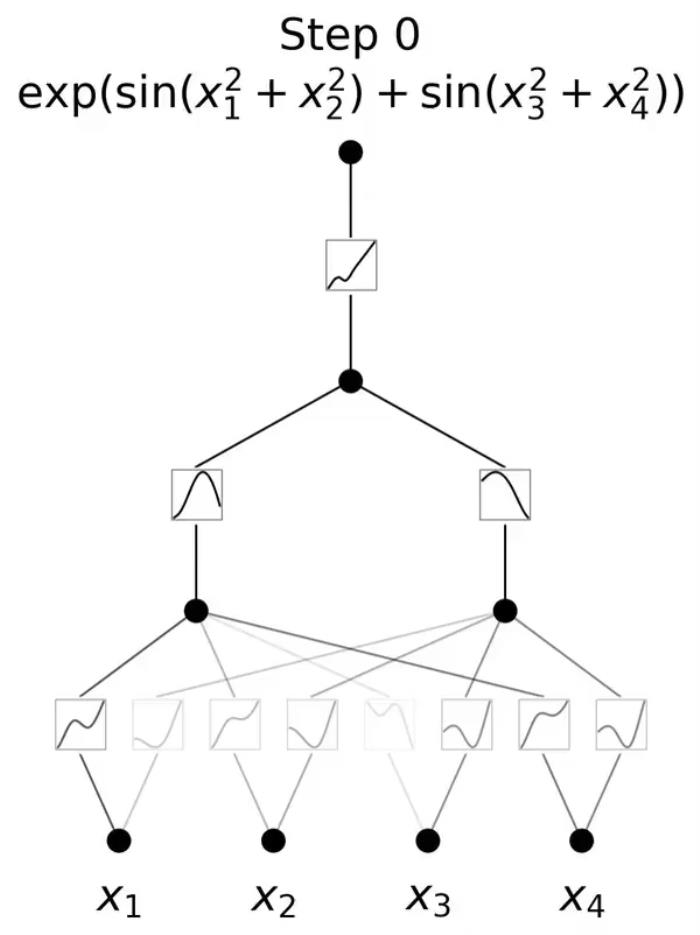

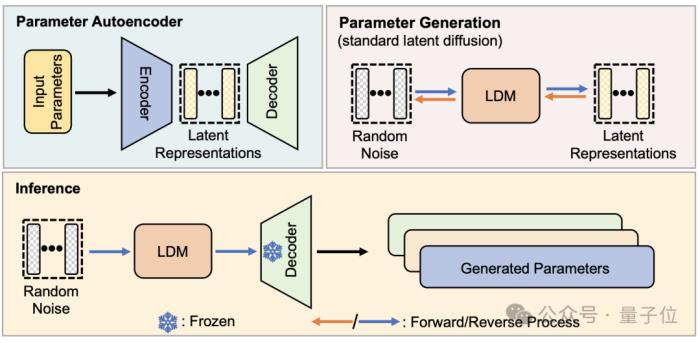

從結(jié)構(gòu)上看,p-diff是研究團(tuán)隊(duì)在標(biāo)準(zhǔn)潛擴(kuò)散模型的基礎(chǔ)之上,結(jié)合自編碼器設(shè)計(jì)的。

研究者首先從訓(xùn)練完成、表現(xiàn)較好的網(wǎng)絡(luò)參數(shù)中選取一部分,并展開為一維向量形式。

然后用自編碼器從一維向量中提取潛在表示,作為擴(kuò)散模型的訓(xùn)練數(shù)據(jù),這樣做可以捕捉到原有參數(shù)的關(guān)鍵特征。

訓(xùn)練過程中,研究人員讓p-diff通過正向和反向過程來學(xué)習(xí)參數(shù)的分布,完成后,擴(kuò)散模型像生成視覺信息的過程一樣,從隨機(jī)噪聲中合成這些潛在表示。

最后,新生成的潛在表示再被與編碼器對(duì)應(yīng)的解碼器還原成網(wǎng)絡(luò)參數(shù),并用于構(gòu)建新模型。

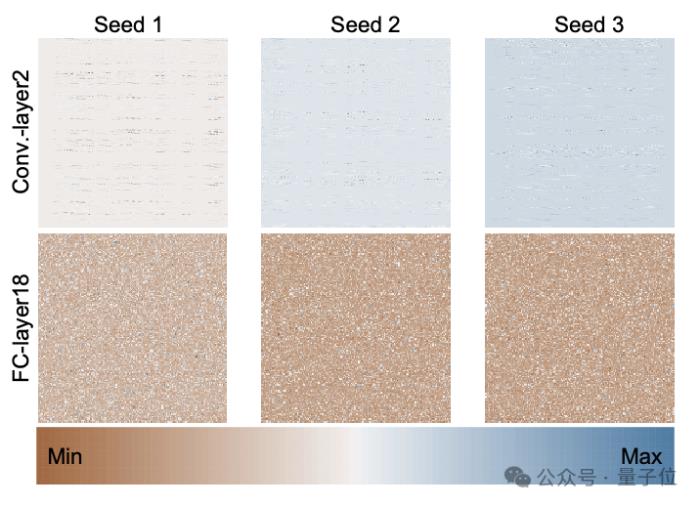

下圖是通過p-diff、使用3個(gè)隨機(jī)種子從頭開始訓(xùn)練的ResNet-18模型的參數(shù)分布,展示了不同層之間以及同一層不同參數(shù)之間的分布模式。

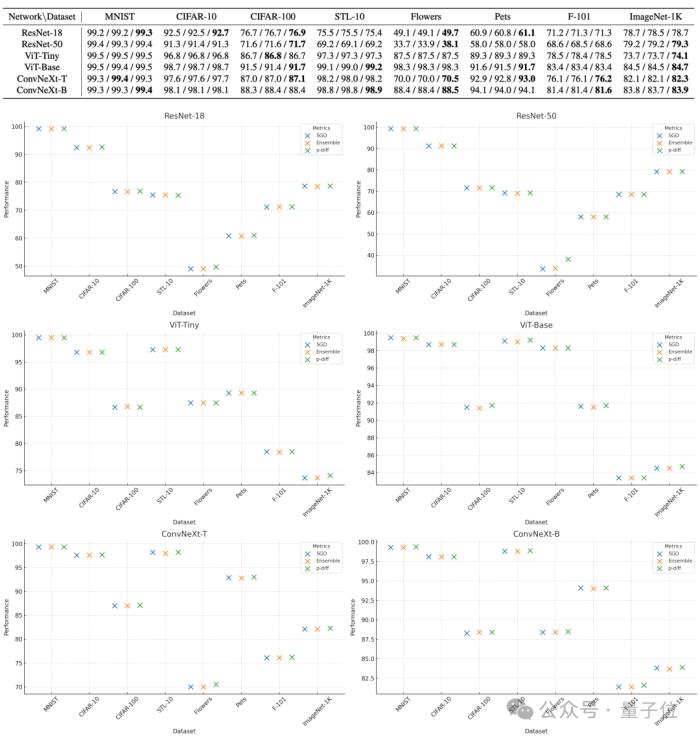

為了評(píng)估p-diff所生成參數(shù)的質(zhì)量,研究人員利用3種類型、每種兩個(gè)規(guī)模的神經(jīng)網(wǎng)絡(luò),在8個(gè)數(shù)據(jù)集上對(duì)其進(jìn)行了測(cè)試。

下表中,每組的三個(gè)數(shù)字依次表示原始模型、集成模型和用p-diff生成的模型的測(cè)評(píng)成績(jī)。

結(jié)果可以看到,用p-diff生成的模型表現(xiàn)基本都接近甚至超過了人工訓(xùn)練的原始模型。

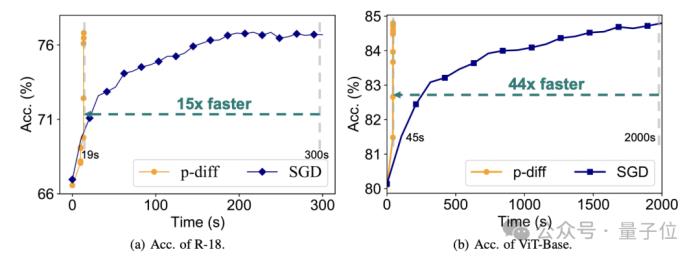

效率上,在不損失準(zhǔn)確度的情況下,p-diff生成ResNet-18網(wǎng)絡(luò)的速度是傳統(tǒng)訓(xùn)練的15倍,生成Vit-Base的速度更是達(dá)到了44倍。

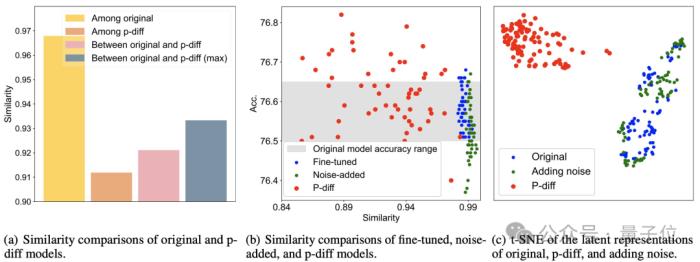

額外的測(cè)試結(jié)果證明,p-diff生成的模型與訓(xùn)練數(shù)據(jù)有顯著差異。

從下圖(a)可以看到,p-diff生成的模型之間的相似度低于各原始模型之間的相似度,以及p-diff與原始模型的相似度。

而從(b)和(c)中可知,與微調(diào)、噪聲添加方式相比,p-diff的相似度同樣更低。

這些結(jié)果說明,p-diff是真正生成了新的模型,而非僅僅記憶訓(xùn)練樣本,同時(shí)也表明其具有良好的泛化能力,能夠生成與訓(xùn)練數(shù)據(jù)不同的新模型。

目前,p-diff的代碼已經(jīng)開源,感興趣的話可以到GitHub中查看。

- 免責(zé)聲明

- 本文所包含的觀點(diǎn)僅代表作者個(gè)人看法,不代表新火種的觀點(diǎn)。在新火種上獲取的所有信息均不應(yīng)被視為投資建議。新火種對(duì)本文可能提及或鏈接的任何項(xiàng)目不表示認(rèn)可。 交易和投資涉及高風(fēng)險(xiǎn),讀者在采取與本文內(nèi)容相關(guān)的任何行動(dòng)之前,請(qǐng)務(wù)必進(jìn)行充分的盡職調(diào)查。最終的決策應(yīng)該基于您自己的獨(dú)立判斷。新火種不對(duì)因依賴本文觀點(diǎn)而產(chǎn)生的任何金錢損失負(fù)任何責(zé)任。

新火種

2024-03-01

新火種

2024-03-01