國產(chǎn)AI導演賊6,短視頻鏡頭和物體各動各的|港城大&快手&天大

快手發(fā)力AI視頻,參與開發(fā)了一個智能“導演”。

Direct-a-Video,成功解耦AI生成視頻中物體運動和攝像機運動,讓靈活性和可控性大大增強!

不信,來欣賞一波作品。

短視頻中的鏡頭移動方向全憑導演指令,水平(X軸)、垂直(Y軸)、變焦必須精準:

AI導演還上演了一出炫技,鏡頭移動方向混合水平、垂直:

混合水平、變焦運動效果也可以

此外,導演還要求視頻中的每個“演員”都能按照繪制的框框運動:

達到鏡頭移動和演員運動合一的效果。

比如,大熊原地太空漫步,鏡頭水平和垂直移動實現(xiàn)整體視頻運動效果:

當然大熊的位置也可以通過繪制帶箭頭的框框,從一個地方移動到另一個地方:

甚至還能同時分別控制多個“演員”的移動路徑:

這就是香港城市大學、快手科技、天津大學研究團隊共同提出的Direct-a-Video文本-視頻生成框架的效果展示。

怎么做到的?

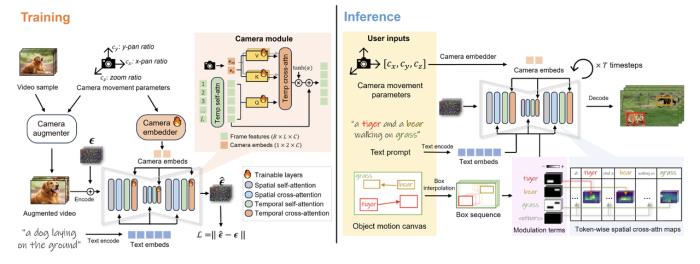

怎么做到的?具體來說,Direct-a-Video分為兩個板塊——

在訓練階段,學習相機移動控制;在推理階段,實現(xiàn)物體運動控制。

在實現(xiàn)相機移動控制時,研究人員采用了預訓練的ZeroScope文本到視頻模型作為基礎模型,并引入新的可訓練時間自注意力層(相機模塊),將由Fourier編碼和MLP映射的平移和變焦參數(shù)嵌入注入其中。

訓練策略是在有限數(shù)據(jù)上,使用數(shù)據(jù)增廣的自監(jiān)督訓練方式學習相機模塊,無需人工運動標注。

其中數(shù)據(jù)增廣通俗來講,就是添加已有數(shù)據(jù)的略微修改版,或從現(xiàn)有數(shù)據(jù)中創(chuàng)建新的合成數(shù)據(jù)來增加數(shù)據(jù)量:

經(jīng)過自監(jiān)督訓練后,該模塊可以解析相機運動參數(shù)實現(xiàn)定量控制。

實現(xiàn)物體運動控制時,不需要額外的數(shù)據(jù)集和訓練,只需用戶簡單繪制首末幀框和中間軌跡即可定義物體運動。

簡單來說,直接在推理時采用基于像素的自注意力增強和抑制,分時階段調(diào)控每幀內(nèi)各對象的自注意力分布,從而使對象生成到用戶通過一系列框指定的位置,實現(xiàn)物體運動軌跡控制。

值得一提的是,相機移動控制和物體運動控制互相獨立,允許單獨或聯(lián)合控制。

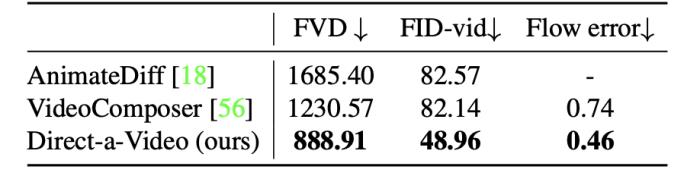

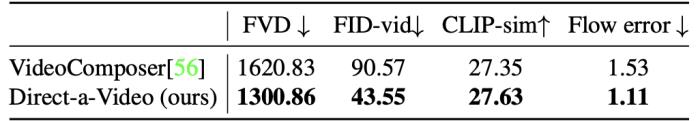

Direct-a-Video效果如何?研究人員將Direct-a-Video與多基準對比驗證了該方法的有效性。

相機移動控制評估

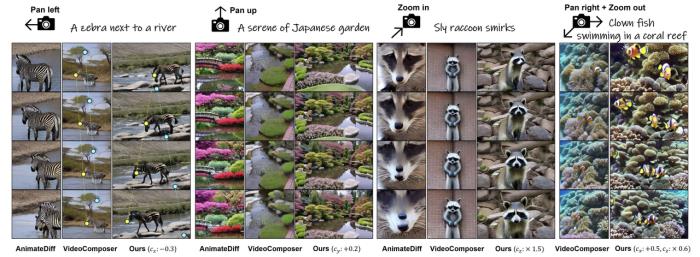

Direct-a-Video與AnimateDiff和VideoComposer對比結果如下:

Direct-a-Video在生成質(zhì)量、相機移動控制精度上均優(yōu)于基線:

物體運動控制評估

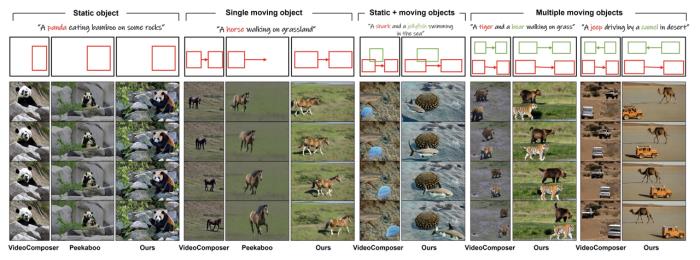

Direct-a-Video與VideoComposer和Peekaboo對比,驗證了本方法在多物體及運動場景下的控制能力。

在生成質(zhì)量和物體運動控制精度上優(yōu)于VideoComposer:

網(wǎng)友看到效果直呼因錘斯汀:

PS:

Runway Gen-2“運動筆刷”(Motion Brush),涂哪兒動哪兒,同樣可調(diào)整參數(shù)控制運動方向:

- 免責聲明

- 本文所包含的觀點僅代表作者個人看法,不代表新火種的觀點。在新火種上獲取的所有信息均不應被視為投資建議。新火種對本文可能提及或鏈接的任何項目不表示認可。 交易和投資涉及高風險,讀者在采取與本文內(nèi)容相關的任何行動之前,請務必進行充分的盡職調(diào)查。最終的決策應該基于您自己的獨立判斷。新火種不對因依賴本文觀點而產(chǎn)生的任何金錢損失負任何責任。

新火種

2024-02-19

新火種

2024-02-19