大模型學(xué)會(huì)聽(tīng)音樂(lè)了!風(fēng)格樂(lè)器精準(zhǔn)分析,還能剪輯合成

能處理音樂(lè)的多模態(tài)大模型,終于出現(xiàn)了!

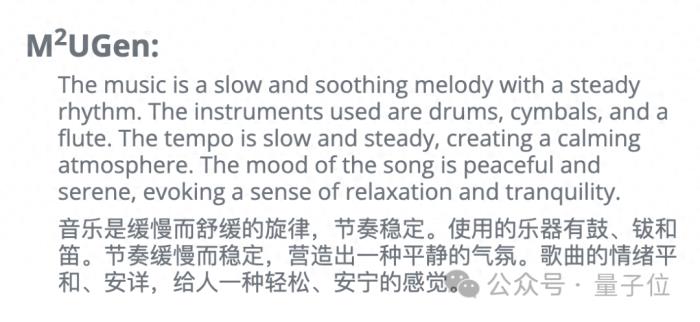

只見(jiàn)它準(zhǔn)確分析出音樂(lè)的旋律、節(jié)奏,還有使用的樂(lè)器,甚至其中的意境也能解讀。

【音樂(lè)效果請(qǐng)移步公眾號(hào)】

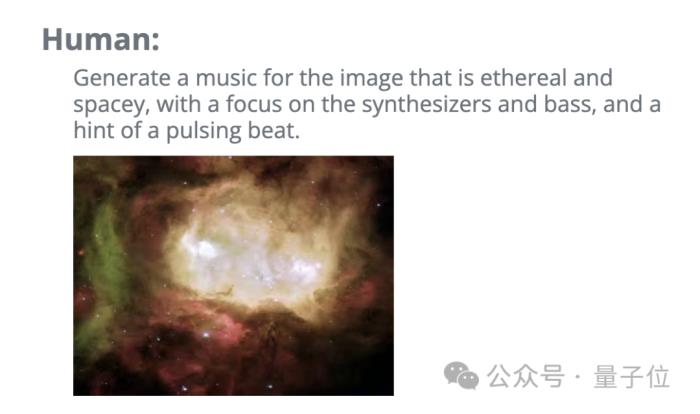

而且它不僅會(huì)聽(tīng),只要給它一段文字和圖片,它就會(huì)在理解圖片意境之后,結(jié)合文字要求來(lái)創(chuàng)作:

【音樂(lè)效果請(qǐng)移步公眾號(hào)】

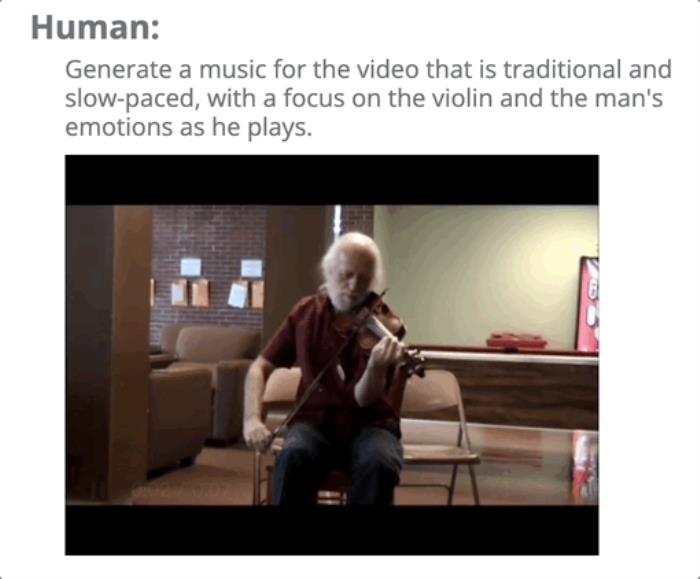

甚至是給靜默的視頻配上聲音:

【音樂(lè)效果請(qǐng)移步公眾號(hào)】

現(xiàn)有的音樂(lè)它也能編輯,比如從一段音樂(lè)中去除鼓的聲音

【音樂(lè)效果請(qǐng)移步公眾號(hào)】

以上的這些效果,都出自騰訊PCG ARC實(shí)驗(yàn)室新推出的基于多模態(tài)模型的音樂(lè)理解與生成框架M2UGen。

它可以進(jìn)行音樂(lè)理解、音樂(lè)編輯以及多模態(tài)音樂(lè)生成(文本/圖像/視頻到音樂(lè)生成)。

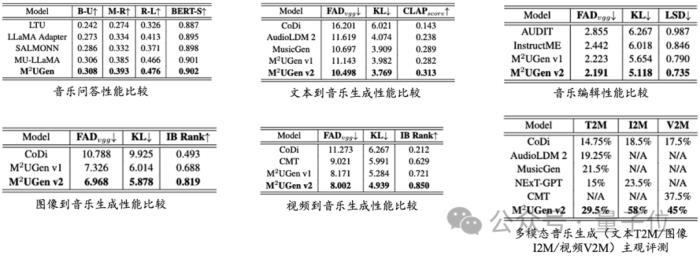

研究團(tuán)隊(duì)在模型的五種能力上分別和現(xiàn)有模型進(jìn)行了一一對(duì)比,并在多模態(tài)音樂(lè)生成的三個(gè)子任務(wù)上(文本/圖像/視頻到音樂(lè)生成)做了主觀評(píng)測(cè)實(shí)驗(yàn),發(fā)現(xiàn)M2UGen模型性能均優(yōu)于現(xiàn)有模型。

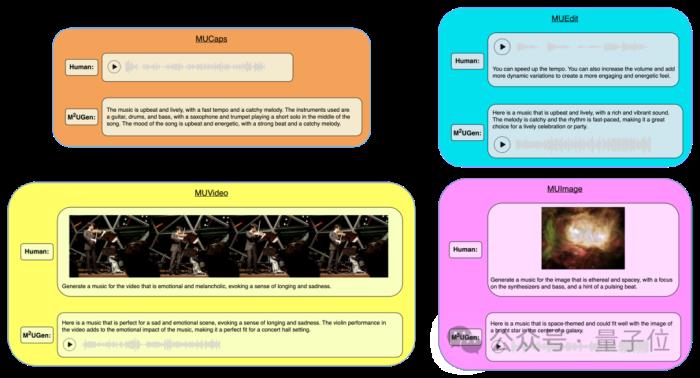

此外,由于沒(méi)有很多合適數(shù)據(jù)集用于模型訓(xùn)練,研究團(tuán)隊(duì)還研發(fā)了一套數(shù)據(jù)生成方法,制作了MUCaps、MUEdit、MUImage、MUVideo四個(gè)數(shù)據(jù)集并發(fā)布。

目前團(tuán)隊(duì)已將模型代碼庫(kù)在Github開源,并在Huggingface上開放了模型權(quán)重和訓(xùn)練所需數(shù)據(jù)集(需申請(qǐng))。

那么,M2UGen究竟是怎樣實(shí)現(xiàn)的呢?

模型共分四個(gè)模塊

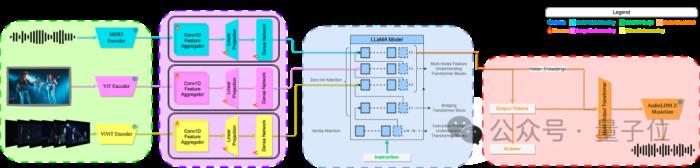

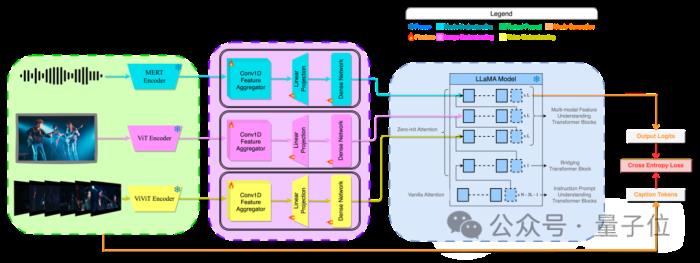

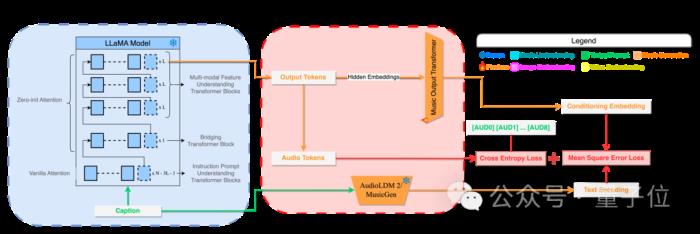

M2UGen模型分為四個(gè)模塊區(qū)域,分別是多模態(tài)特征編碼器、多模態(tài)理解適配器、橋接LLM以及音樂(lè)理解與生成模塊。

下圖展示了M2UGen模型的整體框架:

多模態(tài)特征編碼器

為了實(shí)現(xiàn)多模態(tài)音樂(lè)理解與生成,模型需要處理多模態(tài)輸入。

基于此,研究團(tuán)隊(duì)?wèi)?yīng)用了一些現(xiàn)有的模態(tài)編碼器,如音樂(lè)編碼器MERT、圖像編碼器ViT和視頻編碼器ViViT。

ViT和ViViT是視覺(jué)領(lǐng)域常用的兩個(gè)基于Transformer的編碼器,在現(xiàn)有的一些LLM相關(guān)工作中經(jīng)常涉及,因此開發(fā)者選用這兩個(gè)分別作為圖像和視頻編碼器。

對(duì)于音樂(lè)輸入,前序工作MU-LLaMA證明了MERT模型顯著優(yōu)于其他比較的音頻/音樂(lè)編碼器,因此在M2UGen中研究團(tuán)隊(duì)選用MERT作為音樂(lè)輸入的編碼器。

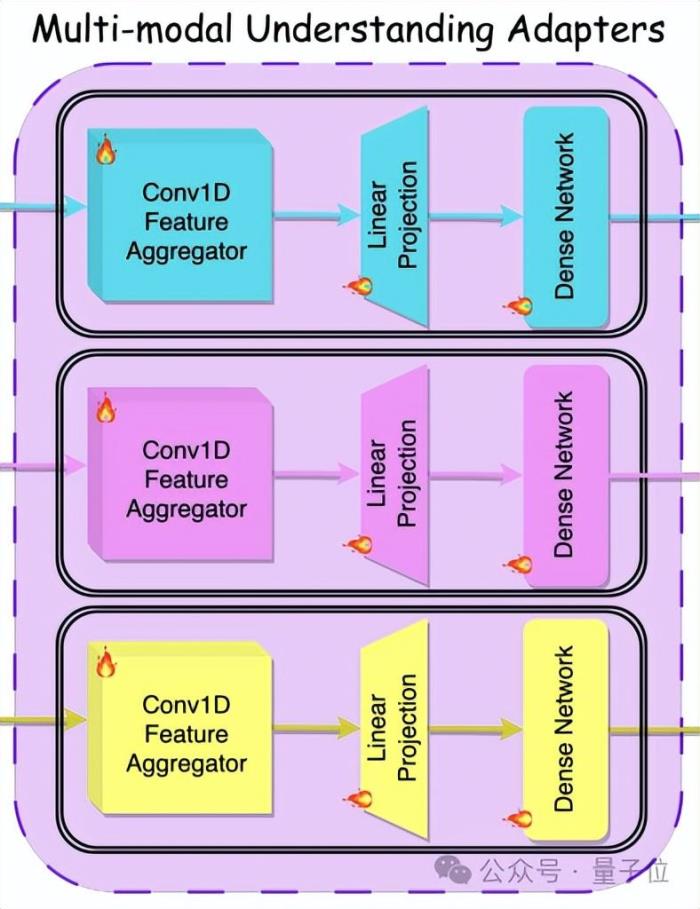

多模態(tài)理解適配器

該模塊的主要作用是將編碼器輸出的特征向量進(jìn)行信息整合,輸入到后續(xù)的LLM中和文本輸入一起控制LLM的輸出。

如下圖所示,該模塊主要由1D卷積層、線性映射層和一個(gè)稠密網(wǎng)絡(luò)模塊(Dense Network)組成。

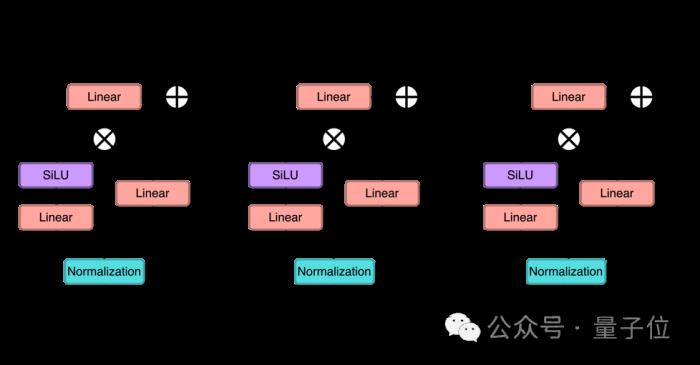

最后的稠密網(wǎng)絡(luò)模塊如下圖:

該模塊由三個(gè)子模塊組成,包含正則化層(Nomarlization)、線性層(Linear)、激活函數(shù)(SiLU)等組件。

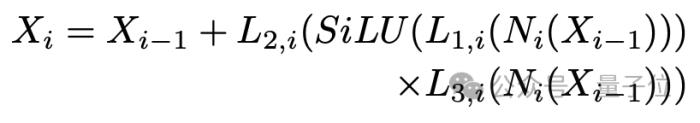

該過(guò)程可由下式表示:

其中Xi表示第i個(gè)子模塊之后的輸出嵌入向量,Lj,i表示第i個(gè)子模塊的第j層線性層,Ni表示第i個(gè)子模塊內(nèi)的正則化層,SiLU是激活函數(shù)。

該稠密網(wǎng)絡(luò)設(shè)計(jì)延續(xù)自團(tuán)隊(duì)的前序工作MU-LLaMA。

在稠密網(wǎng)絡(luò)之后,輸出4096維的嵌入向量,提供給下游的LLM使用。

橋接LLM

為了將多模態(tài)上下文信息引入LLM,研究者將來(lái)自相鄰上游多模態(tài)理解適配器的輸出接入到LLM的指定層。

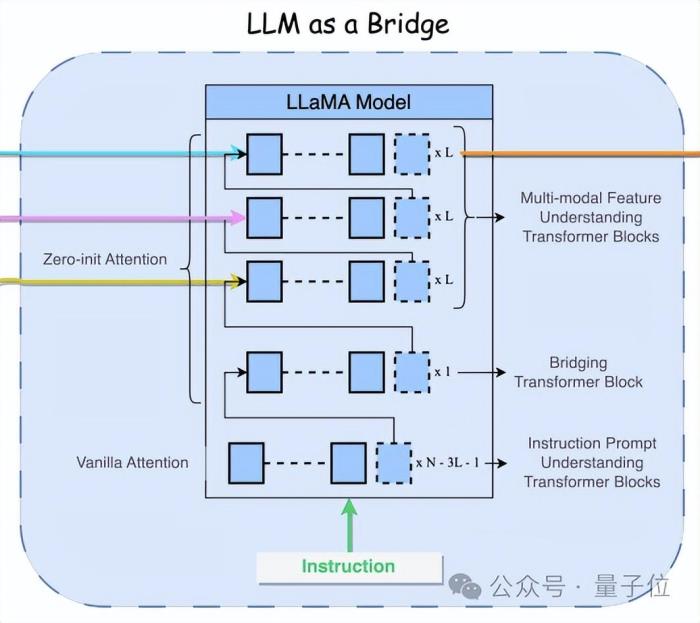

研究者采用了Meta研發(fā)的LLaMA 2模型作為底座LLM,如下圖所示。

這里選用的模型版本是LLaMA 2 7B模型,包含N=32個(gè)隱層。

從該模型的頂層算起,每L層(L=6)引入一個(gè)模態(tài)信息,從上至下依次引入音樂(lè)、圖像和視頻模態(tài)信息,并使用零初始值注意力模塊,底部的(N-3L-1)層則采用原始的注意力模塊。

LLM的文本指令從底層,也即第一層輸入。利用該技術(shù),LLM被賦予了通過(guò)其他模態(tài)信息來(lái)引導(dǎo)LLM輸出的能力。

音樂(lè)理解與生成模塊

受NExT-GPT工作啟發(fā),本模型引入了特定的音頻標(biāo)記[AUD],用來(lái)區(qū)分音樂(lè)問(wèn)答和生成任務(wù)。

在模型訓(xùn)練階段,對(duì)于以音樂(lè)作為輸出(即音樂(lè)生成任務(wù))的訓(xùn)練樣本對(duì)(如文本指令-音樂(lè)對(duì)),這些音頻標(biāo)記會(huì)添加在LLM輸出的末尾,用于指示下游的音樂(lè)輸出。

在模型推理階段,假如用戶輸入的指令和音樂(lè)生成有關(guān),比如Generate a music using flute(用笛子生成一段音樂(lè)),則LLM的輸出會(huì)包含音頻標(biāo)記,從而下游的音樂(lè)解碼器會(huì)接收該指令并生成以笛子作為演奏樂(lè)器的音樂(lè);

反之如果LLM的輸出沒(méi)有音頻標(biāo)記,則表明用戶期望的是音樂(lè)理解任務(wù),此時(shí)由LLM直接回應(yīng)用戶提問(wèn)。

研究人員嘗試了兩種音樂(lè)解碼器——AudioLDM 2和MusicGen,其中MusicGen的音樂(lè)生成表現(xiàn)相較AudioLDM 2更好。

提出新數(shù)據(jù)集,訓(xùn)練分三階段

訓(xùn)練數(shù)據(jù)集

如本文研究貢獻(xiàn)所述,本研究構(gòu)造了四組數(shù)據(jù)集MUCaps、MUEdit、MUImage和MUVideo,數(shù)據(jù)樣本示例如下圖所示。

MUCaps數(shù)據(jù)集:

約1200小時(shí)來(lái)自AudioSet和一些網(wǎng)站的公開音樂(lè);利用MU-LLaMA模型對(duì)搜集的音樂(lè)文件生成音樂(lè)注解組成音樂(lè)-文本對(duì)。

MUEdit數(shù)據(jù)集:

從AudioSet構(gòu)建音樂(lè)池(音樂(lè)池和MUCaps不同),并篩選出約60小時(shí)相似的音樂(lè)-音樂(lè)對(duì);篩選條件包括速度(tempo)、beats(節(jié)拍)等,從而得到大體相似,但有一定區(qū)別的音樂(lè)-音樂(lè)對(duì)(比如使用的樂(lè)器不同);將音樂(lè)-音樂(lè)對(duì)看作是源-目標(biāo)對(duì),將源音樂(lè)的注解文本輸入給MPT-7B[14]模型得到人類端對(duì)話,目標(biāo)音樂(lè)的注解文本輸入給MPT-7B模型得到模型端對(duì)話,也即源音樂(lè)和目標(biāo)音樂(lè)都得到對(duì)應(yīng)指令用于模型訓(xùn)練。

MUImage/MUVideo數(shù)據(jù)集:

從AudioSet再另外采樣一些圖像/視頻-音樂(lè)對(duì)(和MUCaps/MUEdit中的音樂(lè)均不同,最小化音樂(lè)重復(fù)),用BLIP/VideoMAE模型對(duì)圖像/視頻做圖像/視頻注解;將圖像/視頻+音樂(lè)的注解文本輸入到MPT-7B模型,分別得到人類端和模型端對(duì)話。

而M2UGen模型的訓(xùn)練參考了NExT-GPT的訓(xùn)練方式,分為三個(gè)階段,分別是編碼端訓(xùn)練、解碼端訓(xùn)練和編解碼聯(lián)合訓(xùn)練。

階段1:編碼端訓(xùn)練

該階段凍結(jié)多模態(tài)編碼器和LLM,只訓(xùn)練多模態(tài)理解適配器;

利用來(lái)自MUCaps/COCO/MUVideo的音樂(lè)/圖像/視頻-文本對(duì)做階段1訓(xùn)練;

訓(xùn)練損失為交叉熵?fù)p失,即比較LLM的輸出和目標(biāo)注解文本。

階段2:解碼端訓(xùn)練

這一階段不考慮編碼測(cè)(模態(tài)編碼器和適配器),凍結(jié)LLM,訓(xùn)練輸出映射模塊;

此階段旨在訓(xùn)練LLM生成指示下游音樂(lè)解碼器輸出音樂(lè)的指令,或直接根據(jù)輸入指令對(duì)輸入的音樂(lè)做問(wèn)答或注解;

需要對(duì)齊的是音樂(lè)解碼器(AudioLDM 2/MusicGen)的文本編碼器輸出和M2UGen模型輸出映射模塊產(chǎn)生的條件嵌入向量,即對(duì)輸出端進(jìn)行對(duì)齊;

此階段在訓(xùn)練時(shí),通過(guò)添加特定的音頻標(biāo)記[AUD]來(lái)指示是否生成音樂(lè)。如果LLM的輸出中包含[AUD],則同時(shí)生成文本+音樂(lè)(音樂(lè)生成),如果不包含,則只生成文本(音樂(lè)問(wèn)答);

損失函數(shù)采用交叉熵和均方誤差,其中交叉熵是比較LLM輸出的音頻標(biāo)記和真值音頻標(biāo)記,均方誤差是比較M2UGen模型輸出映射模塊產(chǎn)生的條件嵌入向量和音樂(lè)解碼器的文本編碼器的輸出文本嵌入向量。

階段3:編解碼聯(lián)合訓(xùn)練

該階段凍結(jié)多模態(tài)編碼器和LLM,訓(xùn)練多模態(tài)理解適配器和輸出映射模塊,以及LLM中的LoRA參數(shù);

此階段訓(xùn)練時(shí)訓(xùn)練數(shù)據(jù)有Alpaca(通用知識(shí))、MusicQA、MUImage、MUVideo和MUEdit;

為了使模型可以同時(shí)生成音樂(lè)和文本, MUImage、MUVideo和MUEdit三個(gè)數(shù)據(jù)集在階段3訓(xùn)練時(shí)LLM輸出端添加了特定的音頻標(biāo)記(和階段2訓(xùn)練類似)。

未來(lái),研究團(tuán)隊(duì)的工作重點(diǎn)是進(jìn)一步提升模型的細(xì)粒度音樂(lè)理解能力,并改善生成音樂(lè)與輸入指令之間的相關(guān)性,也使音樂(lè)編輯能力更加精確。

- 免責(zé)聲明

- 本文所包含的觀點(diǎn)僅代表作者個(gè)人看法,不代表新火種的觀點(diǎn)。在新火種上獲取的所有信息均不應(yīng)被視為投資建議。新火種對(duì)本文可能提及或鏈接的任何項(xiàng)目不表示認(rèn)可。 交易和投資涉及高風(fēng)險(xiǎn),讀者在采取與本文內(nèi)容相關(guān)的任何行動(dòng)之前,請(qǐng)務(wù)必進(jìn)行充分的盡職調(diào)查。最終的決策應(yīng)該基于您自己的獨(dú)立判斷。新火種不對(duì)因依賴本文觀點(diǎn)而產(chǎn)生的任何金錢損失負(fù)任何責(zé)任。

新火種

2024-01-23

新火種

2024-01-23