word2vec作者爆料:seq2seq是我的想法、GloVe抄襲技巧,反擊來了

Tomas Mikolov 這篇爆料滿滿的文章,里面涉及的研究人員已經開始回擊了。

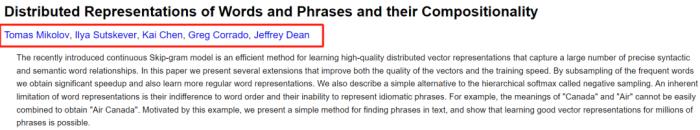

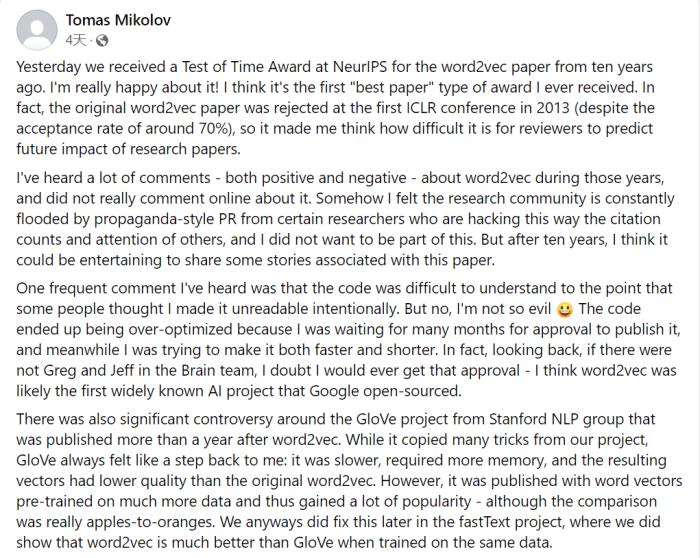

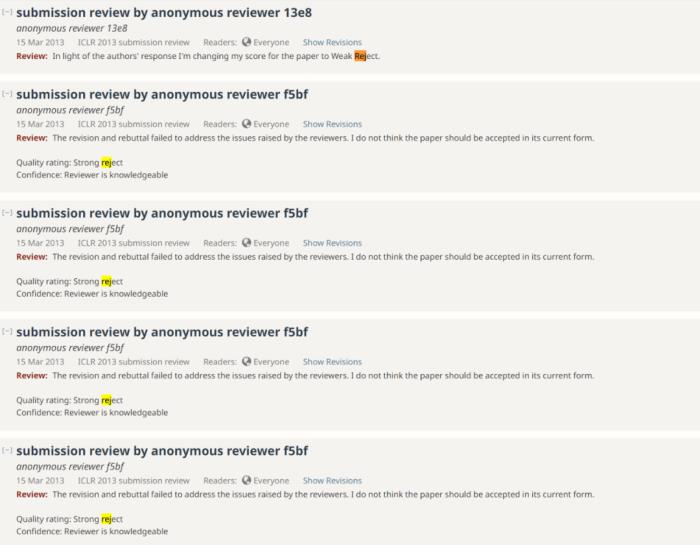

隨著 NeurIPS 2023 獲獎論文的公布,十年前的詞嵌入技術 word2vec 可謂是實至名歸的獲得了時間檢驗獎。這篇論文「Distributed Representations of Words and Phrases and their Compositionality」由當時都還在谷歌的 Tomas Mikolov、Ilya Sutskever、Kai Chen、Greg Corrado、Jeffrey Dean 撰寫。

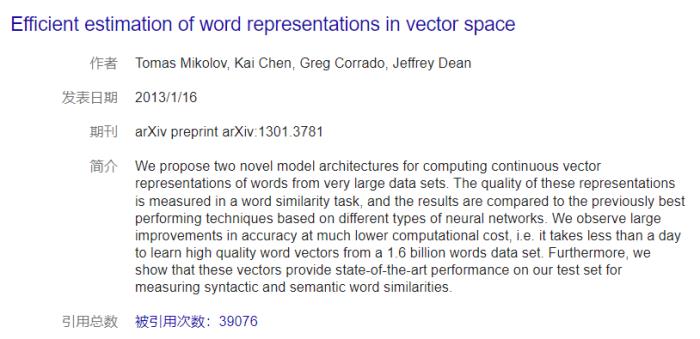

不過,Word2vec 首篇論文是 Tomas Mikolov 等同一作者的「Efficient Estimation of Word Representations in Vector Space」。對比作者欄,只是增加了 Ilya。而投稿到當年 NeurIPS 的這篇「Distributed Representations of Words and Phrases and their Compositionality」算是真正讓 Word2vec 被廣泛應用的改進論文。

不過,Word2vec 首篇論文是 Tomas Mikolov 等同一作者的「Efficient Estimation of Word Representations in Vector Space」。對比作者欄,只是增加了 Ilya。而投稿到當年 NeurIPS 的這篇「Distributed Representations of Words and Phrases and their Compositionality」算是真正讓 Word2vec 被廣泛應用的改進論文。

除了 word2vec 原始論文被拒稿之外,Tomas Mikolov 還透漏了其他事情,我們接著往下看。seq2seq 的最初想法到底是誰Tomas Mikolov 表示他于 2012 年加入谷歌大腦團隊,在谷歌大腦工作期間曾與 Quoc Le 和 Ilya Sutskever 討論過一些想法,關于這個想法 Tomas Mikolov 是這么說的:「其實在加入谷歌之前,我就提出了一個非常簡單的想法,通過在句子對(比如法語 - 英語)上訓練神經語言模型來實現端到端的翻譯,然后在看到第一句話后使用生成模式生成翻譯。這對短句子效果很好,但在長句子上就不那么奏效了。」

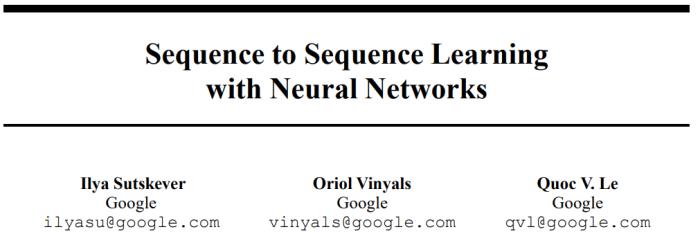

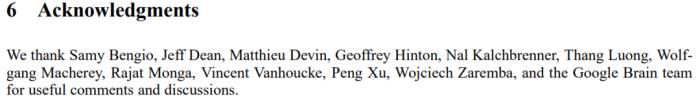

他曾與谷歌的其他人包括 Quoc Le、Ilya Sutskever 在內多次討論了這個項目。然而,事情開始出現轉折,Tomas Mikolov 選擇離開谷歌加入 Facebook AI,而這個項目也被其他人接手了。Tomas Mikolov 指出:「谷歌最終以從序列到序列(sequence to sequence)為名發表了我的想法,不僅沒有提到我是共同作者,而且在長長的致謝部分提及了谷歌大腦中幾乎所有的人,唯獨沒有我。那時是資金大量涌入人工智能領域的時期,每一個想法都價值連城。看到深度學習社區迅速變成某種權力的游戲,我感到很悲哀。」

論文地址(上)以及致謝名單(下)

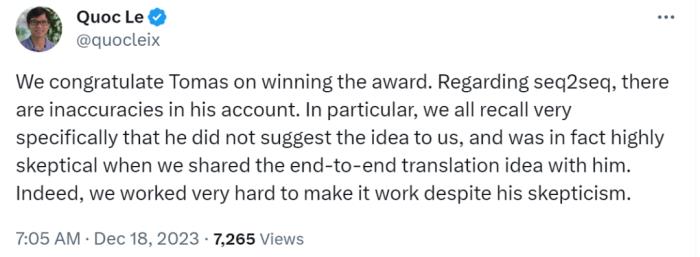

在 Tomas Mikolov 看來,正是這些想法促進了從序列到序列(sequence to sequence,seq2seq)的研究,也就是說 seq2seq 的想法最初來自于 Tomas Mikolov。然而,作為 seq2seq 作者的 Quoc Le 并不認同 Tomas 的說法,Quoc Le 先是對 Tomas 參與的 word2vec 論文獲獎表示祝賀。然后話鋒一轉,「關于 seq2seq,Tomas 的說法有不準確的地方。特別是,我們都記得非常清楚,他沒有向我們提出這個想法,而且當我們與他分享端到端的翻譯想法時,他實際上非常懷疑。事實上,盡管他持懷疑態度,我們還是非常努力地讓這個想法發揮作用。」

圖源:twitter

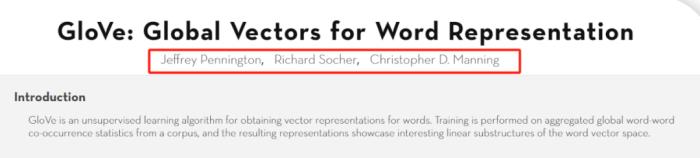

論文中引用了 Tomas 的研究 7 次除了 seq2seq,Tomas 還提到了另一個項目,即斯坦福 NLP 小組的 GloVe 項目(全局詞表示向量,被很多人認為優于 word2vec)。這項研究由 Jeffrey Pennington、Richard Socher、Christopher D. Manning 共同完成。

圖源:twitter

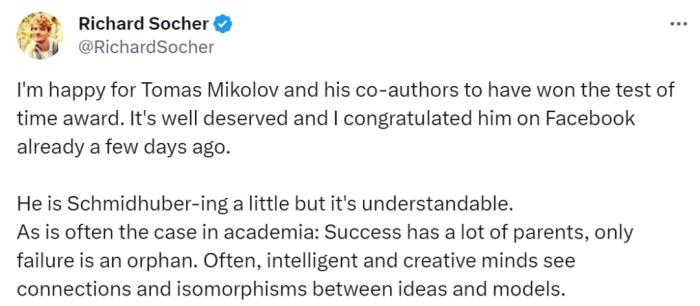

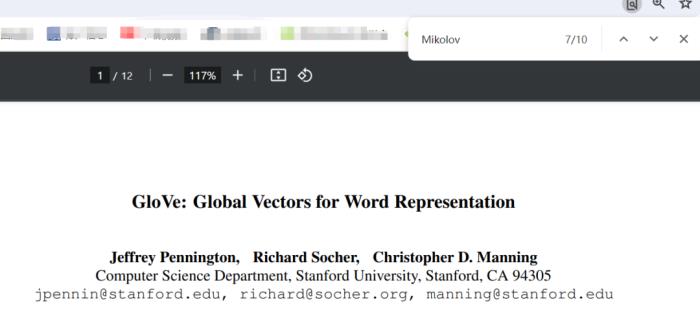

「我很高興 Tomas Mikolov 和他的合著者贏得了時間檢驗獎。這是當之無愧的,幾天前我已經在 Facebook 上向他表示祝賀了。Tomas 的做法有點像 Schmidhuber(Schmidhuber 多次公開挑戰其他研究人員原創性研究),這是可以理解的。學術界經常會出現這種情況:(一項研究)成功了,會有很多人認領,可以將其理解為『父母』,只有失敗了才是『孤兒』(言外之意是沒有人會在意)。一個有意義的主題可以激發聰明的大腦和創造性的想象,這些人往往有相似的想法,許多想法都是不確定的。的確,很多想法在某些時候被提及,但沒有大規模實施或執行。」Richard Socher 繼續說道,當 Mikolov 以一種有點不滿的方式說我們抄襲了其研究的許多技巧時,我們有點不明白,因為我們實際上在 GloVe 論文中引用了他的研究 7 次。確實,在這篇論文中,我們搜索關鍵詞 Mikolov,除去參考文獻出現的 3 次,論文中確實是 7 次。

- 免責聲明

- 本文所包含的觀點僅代表作者個人看法,不代表新火種的觀點。在新火種上獲取的所有信息均不應被視為投資建議。新火種對本文可能提及或鏈接的任何項目不表示認可。 交易和投資涉及高風險,讀者在采取與本文內容相關的任何行動之前,請務必進行充分的盡職調查。最終的決策應該基于您自己的獨立判斷。新火種不對因依賴本文觀點而產生的任何金錢損失負任何責任。

新火種

2023-12-21

新火種

2023-12-21