科學家鉆研計算機的“大腦”,獲得驚人發現

研究人員稱,他們取得了一項重要的發現——可能對電腦、乃至人腦的研究都有著巨大深遠的影響。

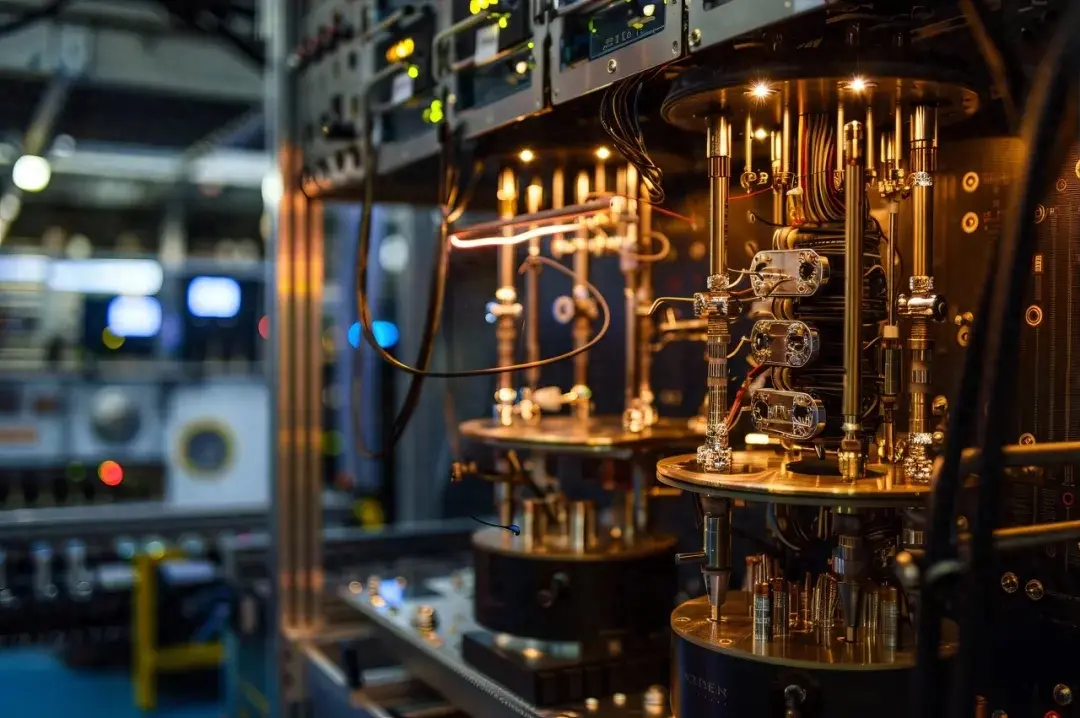

位于舊金山的人工智能研究公司OpenAI表示,該公司掌握了一種更先進的方式,能夠用來一探“神經網絡”這種人工智能軟件的內部工作原理,從而有助于他們更好地了解“決策過程”這一著名的難題。他們在研究中發現,大型神經網絡中的單個神經元可以對某個特定的概念進行編碼——這與神經科學家在人腦中得到的發現驚人地相似。

“神經網絡”是一種對人腦的結構進行抽象、并以此建模而成的機器學習軟件。過去八年來,人工智能領域之所以能夠取得飛速的發展,主要就得益于神經網絡的廣泛應用——包括數字技術輔助的語音識別、面部識別軟件以及新的藥物研發方法等。

但大型神經網絡的一個缺點是,即便是對創造出它們的機器學習專家而言,理解其決策過程背后的原理也可能相當困難。而這帶來的結果就是,很難確切知曉該軟件何時會發生故障,又會如何發生故障。因而也就不難理解,為什么這類人工智能明明可以比其他自動化軟件或人工表現得更好,人們卻不太愿意使用它。這種情況在醫療和財務領域尤為普遍,因為一旦決策失誤,可能會付出金錢甚至生命的沉重代價。

OpenAI的聯合創始人及首席科學家伊利亞·莎士科爾說:“由于我們不了解這些神經網絡是如何工作的,因此當它們報錯時,很難推理出是哪個環節出了問題。我們不知道它們是否可靠,或者是不是有一些在測試中看不出來的隱藏漏洞。”

但最近,公司研究人員運用多項技術來探究他們創建的一個大型神經網絡的內部工作原理,該神經網絡是一個用來識別圖像并歸類存儲的軟件。他們的重要發現是,神經網絡中的單個神經元與某個特定的標簽或概念相關。

OpenAI在關于這項研究的一篇博文中說,這一點意義重大,因為它和2005年的一項具有里程碑意義的神經科學研究發現如出一轍——2005年的研究是針對人腦展開的,其發現是,人腦中可能存在一種所謂的“祖母”神經元,會對某個特定圖像或概念的刺激作出回應。例如,神經科學家發現,其中一個研究對象似乎有一種與女明星哈莉·貝瑞有關的神經元。當向其展示哈莉·貝瑞的圖像時,該神經元就會被觸發、產生反應,當這個人聽到“哈莉·貝瑞”一詞,或看到與哈莉·貝瑞有關的標志性圖像時,該神經元也會被激活。

OpenAI的研究對象是他們在今年1月首次推出的一項人工智能系統——該系統無需先對帶標簽的數據集進行分類識別訓練,就能夠高度精確地執行各種圖像歸類任務。這項被稱為CLIP(“語言-圖像比對預訓練”的縮寫)的系統從網上攝取了4億張圖像,并與文案匹配。根據這些信息,該系統學會了從32768個文本摘要標簽中預測,哪一個最可能與任意一個給定的圖像相關聯——即使此前從未見過這些圖像。例如,當向CLIP展示一碗鱷梨醬的圖片時,它不僅可以將其正確地標記為鱷梨醬,而且還知道鱷梨醬是“一種食物”。

OpenAI在新研究中使用的是一種“倒推”的方式,以探究是什么樣的圖片最能夠觸發某個人工神經元的反應,讓機器認為這是某個概念的“靈魂伴侶”。例如,OpenAI對與“金子”這一概念相關的神經元進行了探測,發現最可以觸發它的是含有閃亮的黃色硬幣狀物體和“金子”兩個字本身的圖片。而與“蜘蛛人”相關的神經元則會被一個漫畫人物的照片觸發,也會被“蜘蛛”這個詞觸發。有趣的是,一個與“黃色”概念相關的神經元會對“香蕉”和“檸檬”產生反應——包括這兩個詞語本身和它們的顏色。

OpenAI的研究人員加布里埃爾·高告訴《財富》雜志:“這或許證明了,這些神經網絡并不像我們想象的那樣令人費解。”將來,此類方法能夠幫助那些使用了神經網絡技術的公司,讓他們了解這些機器是如何做出決策的,以及系統可能在何時出現故障或偏差。這還可以啟示神經科學家們另辟蹊徑:用“人工”神經網絡的原理,來研究“人類”的學習和概念形成方式。

并非每個CLIP神經元都只與一個特定的概念相關聯——很多會被不同概念激活并產生回應。而且有些神經元似乎能夠被同時觸發,這或許意味著與之有關的是一個復雜的概念。

OpenAI表示,也會有這樣一些概念,即研究人員原本期望系統中有與之相關的神經元,但其實并不存在。例如盡管CLIP可以準確地識別舊金山的照片,甚至通常能夠識別出拍攝照片的具體地點,但神經網絡似乎并沒有與“舊金山”甚至“城市”、“加利福尼亞”等概念本身相關的神經元。OpenAI在其博文中說:“我們認為,這些信息也被編碼在該模型的某個觸發系統中,但是以一種更獨特的方式編碼的。”

這種技術還可以發現神經網絡系統中潛藏的偏見。在演示中,研究人員發現,CLIP還具有OpenAI所稱的一種“中東”神經元。這種神經元不僅會被與中東地區相關的圖像和單詞觸發,并產生反應,也會和“恐怖分子”概念關聯。還有一個“移民”神經元,與“拉丁美洲”關聯。還有能夠同時對深膚色人種和大猩猩產生反應的神經元——OpenAI指出,這種偏見和其他一些帶有種族主義色彩的圖片標簽類似。此前,谷歌(Google)基于神經網絡技術的圖像分類系統就出現過此類問題。

大型人工智能系統中潛在的種族、性別偏見已經引起了倫理學家和社會組織的日益關注,特別是那些通過互聯網大數據進行機器學習、訓練的人工智能系統。

研究人員還說,他們的方法發現了CLIP在決策過程中存在的一項特殊偏見,這可能被有心人利用,故意誤導人工智能系統做出錯誤的識別。該系統對表示某個概念的語詞或符號文本和那個概念本身緊密關聯,以至于如果有人把這種符號或語詞放在不同的對象上,系統就會將其分錯。例如,身上帶有巨大“$$$”標志的狗可能就會被錯誤地識別成“存錢罐”。

加布里埃爾·高說:“我認為,系統中肯定會帶有很多刻板印象。”而莎士科爾表示,能夠識別出這些偏差,正是試著糾正它們的第一步。他認為,可以讓神經網絡進行一點附加的樣例訓練,這些訓練專門用來打破機器在學習中習得的不恰當的相關性。(財富中文網)

編譯:陳聰聰

- 免責聲明

- 本文所包含的觀點僅代表作者個人看法,不代表新火種的觀點。在新火種上獲取的所有信息均不應被視為投資建議。新火種對本文可能提及或鏈接的任何項目不表示認可。 交易和投資涉及高風險,讀者在采取與本文內容相關的任何行動之前,請務必進行充分的盡職調查。最終的決策應該基于您自己的獨立判斷。新火種不對因依賴本文觀點而產生的任何金錢損失負任何責任。

財富中文網

2023-11-22

財富中文網

2023-11-22