WPS隱私政策引信任風波AI訓練數據何以平衡開發和保護?

21世紀經濟報道記者鄭雪北京報道

近日,金山辦公更新的隱私政策掀起一陣波瀾。

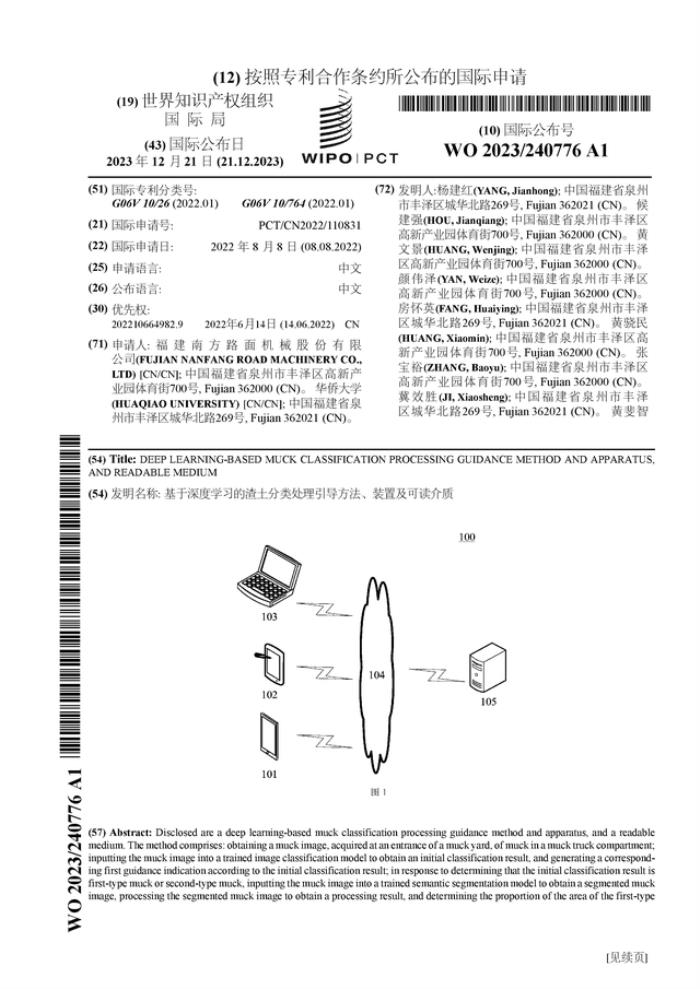

有用戶針對WPS隱私政策表達質疑:是否會通過用戶的文檔內容喂養AI。根據WPS隱私政策,將對用戶主動上傳的文檔材料脫敏處理后用于AI訓練的基礎材料使用。據了解,該隱私政策更新于11月15日。11月16日,WPS AI宣布開啟公測,面向全體用戶陸續開放體驗。

AI帶來的巨大想象力讓不少企業紛紛押注。而當前最火的生成式人工智能建立在海量數據基礎之上,如何獲取足夠的數據用于訓練早已成為相關企業迫切需要解決的問題。金山辦公隱私政策事件的背后,需要思考和回應,當前AI發展,如何彌補海量數據缺口以及如何保護數據開發和利用中的隱私。

隱私政策引發的風波

根據金山辦公11月15日更新的隱私政策,4.2.1在線服務提及,“為提升您使用我們提供的包括但不限于在線文檔美化、在線PPT美化、在線表格美化的AI功能的準確性,我們將對您主動上傳的文檔材料,在采取脫敏處理后作為AI訓練的基礎材料使用,同時請您放心,我們將采取嚴格的安全措施和技術手段對該資料進行去標識化處理,以降低其他組織或個人通過去標識化處理后的個人信息識別到您的風險、保護您的個人信息。”

16日,有相關用戶在社交媒體發文質疑,同時不少用戶稱感覺其個人隱私受到侵犯。事情發酵兩天之后,11月18日深夜,WPS官方微博表示,之前版本的相關表述為用戶造成困擾。為此更新《WPS隱私政策》,去除容易引起誤解的表述,并確保內容與實際操作嚴格對應。同時鄭重聲明,“所有用戶文檔不會被用于任何AI訓練目的,也不會在未經用戶同意的情況下用于任何場景。”

同時金山辦公重申,WPS始終嚴格遵守所有可適用的用戶隱私保護法律和標準。為進一步加強用戶信任,將定期進行隱私政策的審查,并通過第三方獨立機構進行合規性審核,以確保承諾得到兌現。

20日記者通過WPS Office查詢WPS隱私政策,已無相關AI表述,“當您使用我們目前所提供的在線預覽、編輯、多人在線協同編輯、文檔分享、文檔實時保存至云端等需要在云端實現的功能及后續推出依托于云的服務時,需要您在聯網狀態下、登錄賬號后將相關文檔材料主動上傳(包括您手動上傳及/或主動開啟的自動上傳)至云端,我們將基于為您提供前述云服務,所必要收集您上傳至云端文檔及文檔信息(包括文檔類型、大小、頁數、修改時間、文檔權限、存放位置)。請您放心,您使用在線服務過程中主動上傳至云端的文檔內容數據,我們僅以為您提供相關服務之目進行處理,不會用于任何與該服務無關的場景、目的。”

至此,金山辦公人工智能因隱私政策引起的風波告一段落。

AI訓練數據的保護與開發

金山辦公AI隱私政策風波背后,需要回答更深層次的問題是,如何彌補海量訓練數據缺口,以及,如何保護數據開發利用中的隱私。生成式人工智能是大力出奇跡的典型代表。海量數據作用之下,AI可以自信回應一切內容。而當前一個緊迫的問題在于,數據總有一天會被用完,相關研究表示,高質量的語言數據存量將在2026年耗盡。隨著入局者增多,數據海量缺口如何彌補?

據了解,AIGC廠商的數據來源大致分為三個面向,各個廠商歷史積累的數據、公開渠道爬取的數據、各類免費或付費的第三方數據庫與數據集。

當前,收集公開信息用于訓練數據,成為不少廠商豐富數據的選擇。如谷歌、X(前twitter)、Meta表示將收集公開數據予以訓練。

今年7月,谷歌更新隱私政策,表示將利用網絡公開數據訓練旗下的AI模型。谷歌表示,“我們可能會收集公開的在線信息或來自其他公共來源的信息,幫助訓練Google的人工智能模型。”

根據X今年9月29日生效的隱私政策2.1規定,“We may use the information we collect and publicly available information to help train our machine learning or artificial intelligence models for the purposes outlined in this policy。”即X可能會使用收集的信息和公開信息來幫助訓練機器學習或人工智能模型。

Meta產品管理總監 Mike Clark在9月發表的《Privacy Matters: Metas Generative AI Features》一文表示,生成式 AI 模型需要大量數據來進行有效訓練,因此使用多種來源進行訓練,包括在線公開的信息、許可數據以及來自 Meta 產品和服務的信息。私人帖子、私人消息內容則不在訓練范圍之內。

公開數據的使用是否合規?競天公誠律師事務所合伙人袁立志此前在接受記者采訪時表示,無論在我國還是域外,對公開數據的正常收集和使用,在一般情況下不算違法。

同時在袁立志看來,解決行業高質量數據缺口問題,首先還是需要相信市場的力量,隨著優質數據的需求逐漸顯現,各個市場主體都會被“無形的手”推動向前。

同時彌補訓練數據缺口時需要回答的一個問題,如何保護用戶的隱私?每個公司都有相關保護實踐,但最重要的一點,尊重用戶的權利和選擇。

以OpenAI為例,根據OpenAI中文文檔的數據使用政策,從2023年3月1日開始,其對數據使用和保留政策做出了兩項更改:“除非您明確決定與我們共享您的數據,否則OpenAI將不會使用通過我們的API提交的數據來訓練或改進我們的模型。您可以選擇加入以共享數據。通過API發送的任何數據將被保留用于濫用和誤用監控目的,最長時間為30天,之后將被刪除(除非法律另有規定)。”

從法律角度來看,在人工智能發展鏈條中,數據處理主體和數據被處理的主體呈現多元化,責任鏈條難以界定,如何解決該問題?相關主體的權利和義務如何劃分?

2023全球數字經濟大會人工智能高峰論壇上,中國政法大學互聯網金融法律研究院院長、中國政法大學教授李愛君從數據本體出發,認為數據擁有內容層和載體層,在數據使用過程中,要尊重數據客體內容層和載體層的相關權益。在她看來,訓練數據使用的法理關系其實事關數據處理,主體包括數據處理主體和數據被處理的主體。對于人工智能鏈條中數據主體多元、責任難以清晰劃分的情況,未來值得進一步探討。

(記者馮戀閣亦對此文有貢獻)

(文章來源:21世紀經濟報道)

- 免責聲明

- 本文所包含的觀點僅代表作者個人看法,不代表新火種的觀點。在新火種上獲取的所有信息均不應被視為投資建議。新火種對本文可能提及或鏈接的任何項目不表示認可。 交易和投資涉及高風險,讀者在采取與本文內容相關的任何行動之前,請務必進行充分的盡職調查。最終的決策應該基于您自己的獨立判斷。新火種不對因依賴本文觀點而產生的任何金錢損失負任何責任。

21世紀經濟報道

2023-11-21

21世紀經濟報道

2023-11-21