GAN的反擊:朱俊彥CVPR新作GigaGAN,出圖速度秒殺StableDiffusion

圖像生成是當前 AIGC 領域最熱門的方向之一。近期發布的圖像生成模型如 DALL?E 2、Imagen、Stable Diffusion 等等,開創了圖像生成的新時代,實現了前所未有的圖像質量和模型靈活性水平。擴散模型也成為目前占據主導地位的范式。然而,擴散模型依賴于迭代推理,這是一把雙刃劍,因為迭代方法可以實現具有簡單目標的穩定訓練,但推理過程需要高昂的計算成本。

在擴散模型之前,生成對抗網絡(GAN)是圖像生成模型中常用的基礎架構。相比于擴散模型,GAN 通過單個前向傳遞生成圖像,因此本質上是更高效的,但由于訓練過程的不穩定性,擴展 GAN 需要仔細調整網絡架構和訓練因素。因此,GAN 擅長對單個或多個對象類進行建模,但擴展到復雜數據集(更不用說現實世界)則極具挑戰性。因此,超大型模型、數據和計算資源現在都專用于擴散模型和自回歸模型。

但作為一種高效的生成方法,許多研究者并沒有完全放棄 GAN 方法。例如,最近英偉達提出了 StyleGAN-T 模型;港中文等用基于 GAN 的方法生成流暢視頻,這些都是 CV 研究者在 GAN 上做的進一步嘗試。

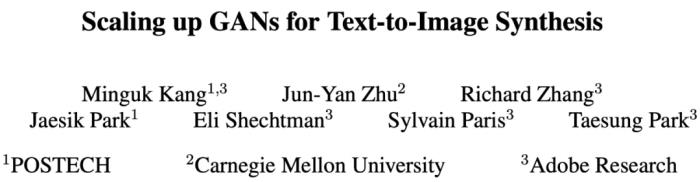

現在,在一篇 CVPR 2023 論文中,來自 POSTECH、卡耐基梅隆大學和 Adobe 研究院的研究者們聯合探究了關于 GAN 的幾個重要問題,包括:

GAN 能否繼續擴大規模并從大量資源中受益,GAN 遇到瓶頸了嗎?

是什么阻止了 GAN 的進一步擴展,我們能否克服這些障礙?

論文鏈接:https://arxiv.org/abs/2303.05511

項目鏈接:https://mingukkang.github.io/GigaGAN/

值得注意的是,CycleGAN 的主要作者、曾獲 2018 年 ACM SIGGRAPH 最佳博士論文獎的朱俊彥是這篇 CVPR 論文的第二作者。

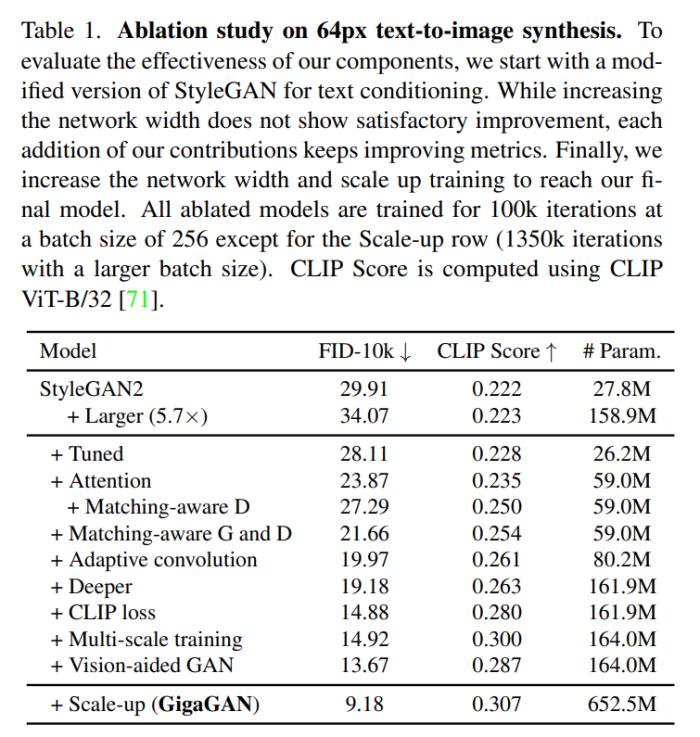

該研究首先使用 StyleGAN2 進行實驗,并觀察到簡單地擴展主干網絡會導致訓練不穩定。基于此,研究者確定了幾個關鍵問題,并提出了一種在增加模型容量的同時穩定訓練的技術。

首先,該研究通過保留一組濾波器(filter)并采用特定于樣本的線性組合來有效地擴展生成器的容量。該研究還采用了擴散上下文(diffusion context)中常用的幾種技術,并證實它們為 GAN 帶來了類似的好處。例如,將自注意力(僅圖像)和交叉注意力(圖像 - 文本)與卷積層交織在一起可以提高模型性能。

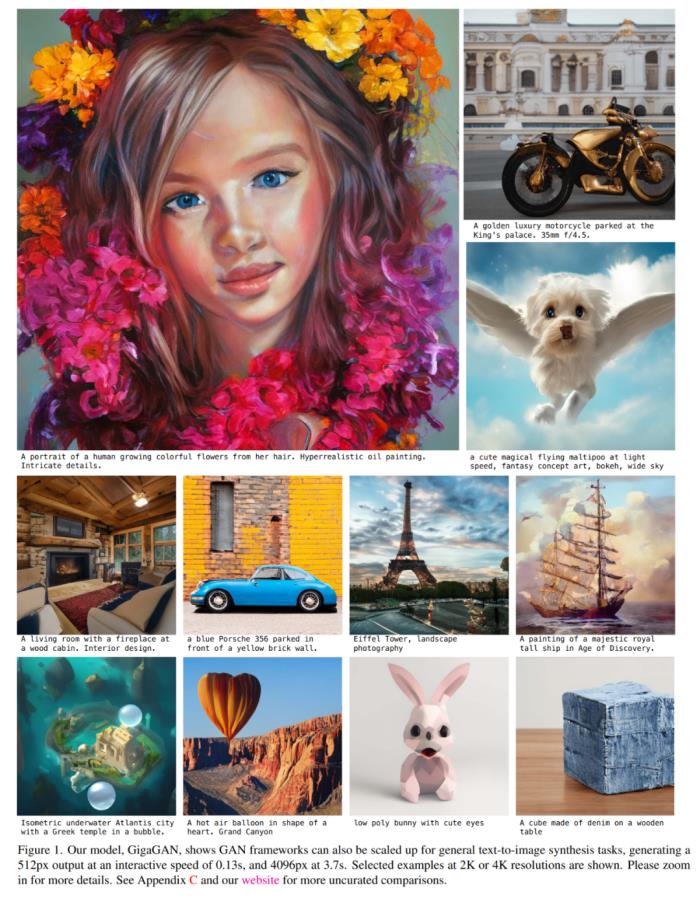

該研究還重新引入了多尺度訓練,并提出一種新方案來改進圖像 - 文本對齊和生成輸出的低頻細節。多尺度訓練允許基于 GAN 的生成器更有效地使用低分辨率塊中的參數,從而實現了更好的圖像 - 文本對齊和圖像質量。經過仔細調整后,該研究提出了十億參數的新模型 GigaGAN,并在大型數據集(例如 LAION2B-en)上實現了穩定和可擴展的訓練,實驗結果如下圖 1 所示。

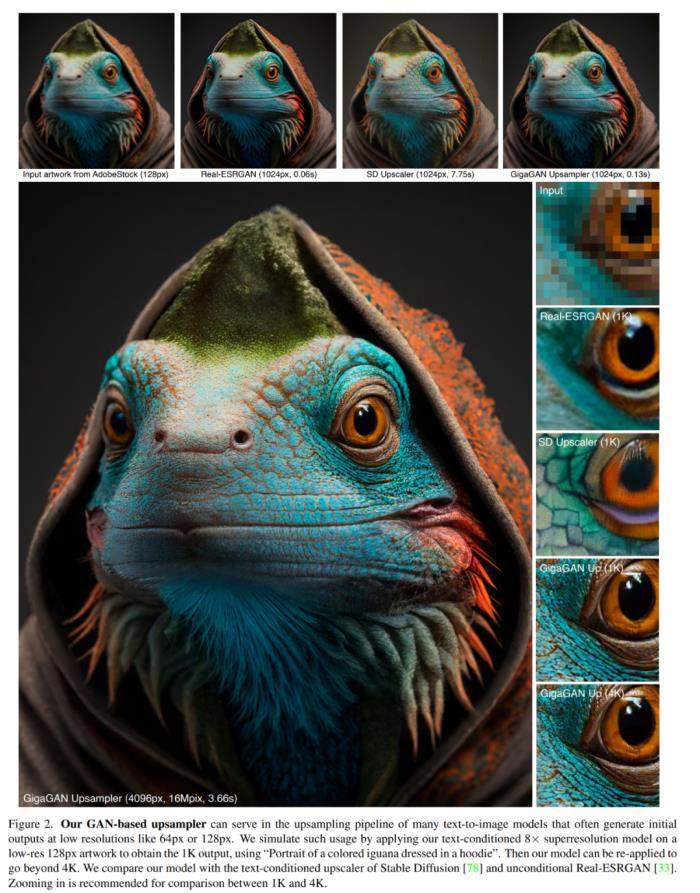

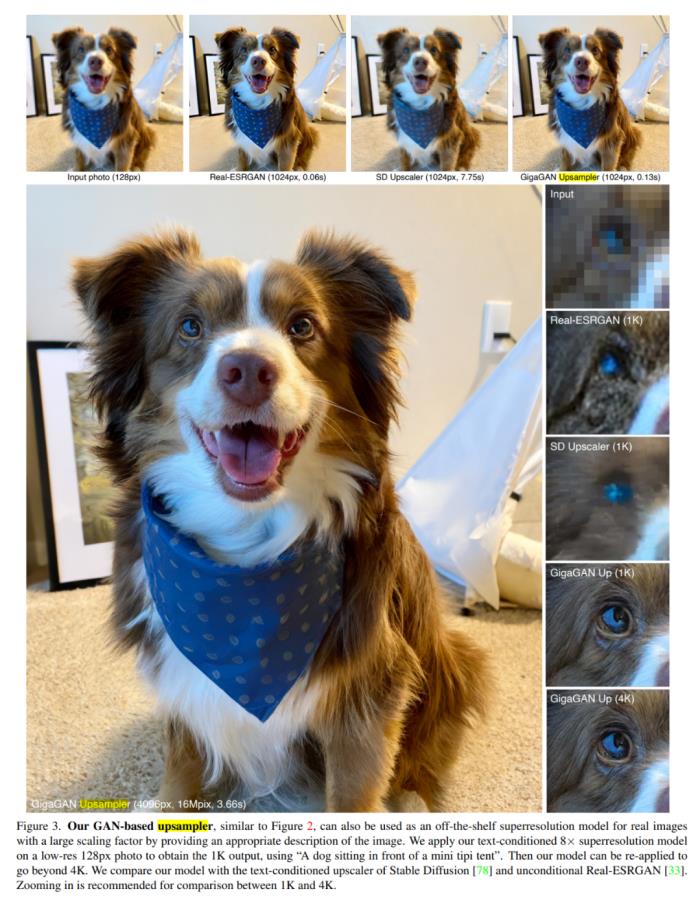

此外,該研究還采用了多階段方法 [14, 104],首先以 64 × 64 的低分辨率生成圖像,然后再上采樣到 512 × 512 分辨率。這兩個網絡是模塊化的,并且足夠強大,能夠以即插即用的方式使用。

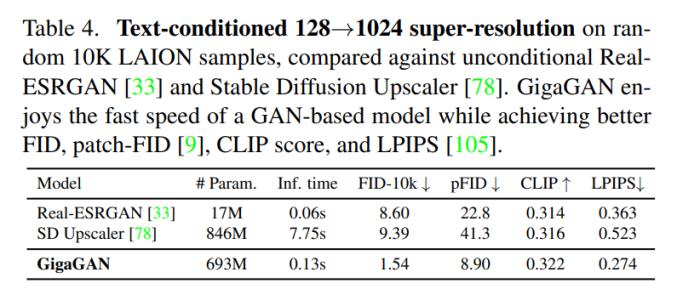

該研究表明,基于文本條件的 GAN 上采樣網絡可以用作基礎擴散模型的高效且更高質量的上采樣器,如下圖 2 和圖 3 所示。

上述改進使 GigaGAN 遠遠超越了以前的 GAN:比 StyleGAN2 大 36 倍,比 StyleGAN-XL 和 XMC-GAN 大 6 倍。雖然 GigaGAN 十億(1B)的參數量仍然低于近期的大型合成模型,例如 Imagen (3.0B)、DALL?E 2 (5.5B) 和 Parti (20B),但研究者表示他們尚未觀察到關于模型大小的質量飽和。

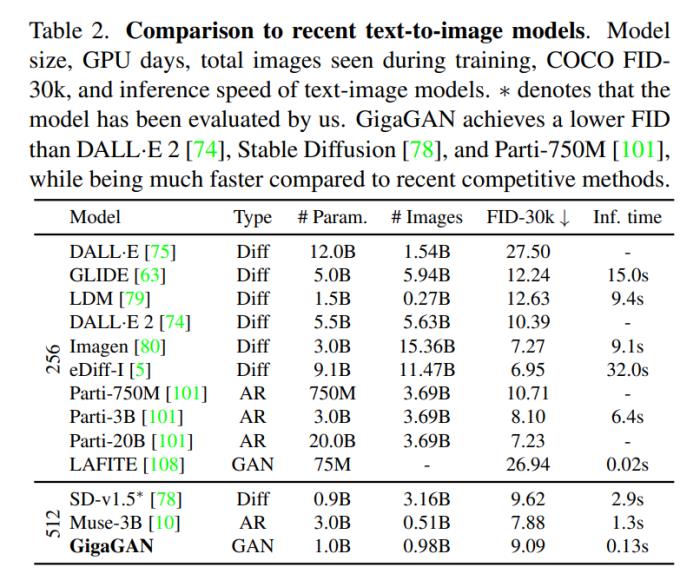

GigaGAN 在 COCO2014 數據集上實現了 9.09 的零樣本 FID,低于 DALL?E 2、Parti-750M 和 Stable Diffusion。

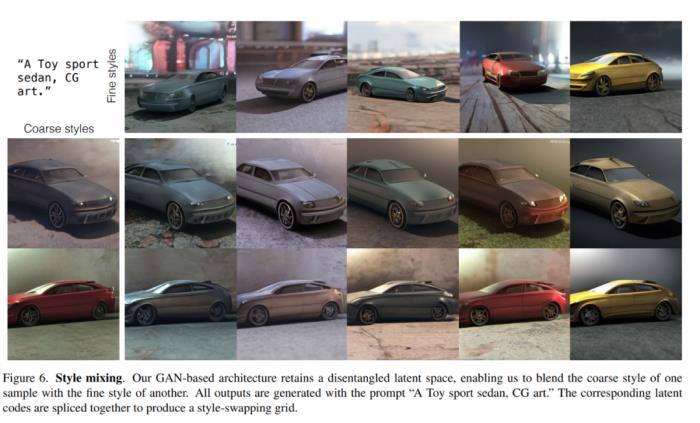

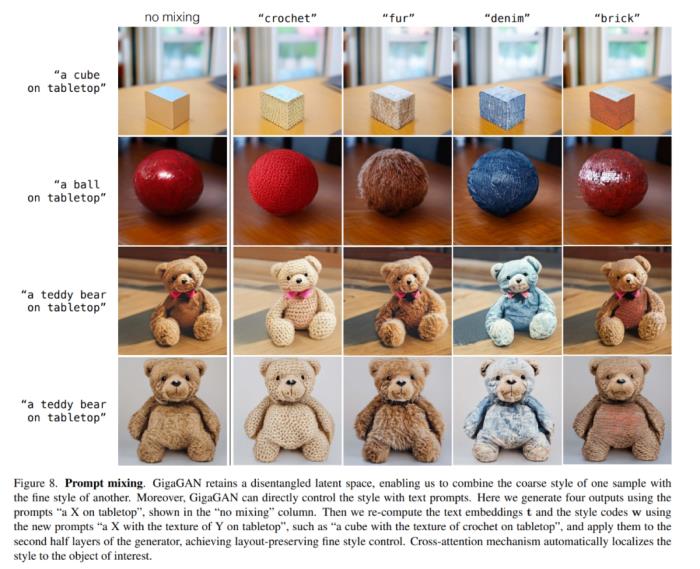

此外,與擴散模型和自回歸模型相比,GigaGAN 具有三大實用優勢。首先,它的速度快了幾十倍,在 0.13 秒內生成了 512 像素的圖像(圖 1)。其次,它可以在 3.66 秒內合成 4k 分辨率的超高分辨率圖像。第三,它具有可控的潛在向量空間,適用于經過充分研究的可控圖像合成應用,例如風格混合(圖 6)、prompt 插值(圖 7)和 prompt 混合(圖 8)。

該研究成功地在數十億現實世界圖像上訓練了基于 GAN 的十億參數規模模型 GigaGAN。這表明 GAN 仍然是文本到圖像合成的可行選擇,研究人員們應考慮將其用于未來的積極擴展。

方法概覽

研究者訓練了一個生成器 G (z, c),在給定一個潛在編碼 z~N (0, 1)∈R^128 和文本調節信號 c 的情況下,預測一個圖像 x∈R^(H×W×3)。他們使用一個判別器 D (x, c) 來判斷生成的圖像的真實性,與訓練數據庫 D 中的樣本相比較,后者包含圖像 - 文本對。

盡管 GAN 可以成功地在單類和多類數據集上生成真實的圖像,但在互聯網圖像上進行開放式文本條件合成仍然面臨挑戰。研究者假設,目前的限制源于其對卷積層的依賴。也就是說,同樣的卷積濾波器被用來為圖像所有位置上的所有文本條件進行通用圖像合成函數建模,這是個挑戰。有鑒于此,研究者試圖通過根據輸入條件動態選擇卷積濾波器,并通過注意力機制捕捉長程依賴,為參數化注入更多的表現力。

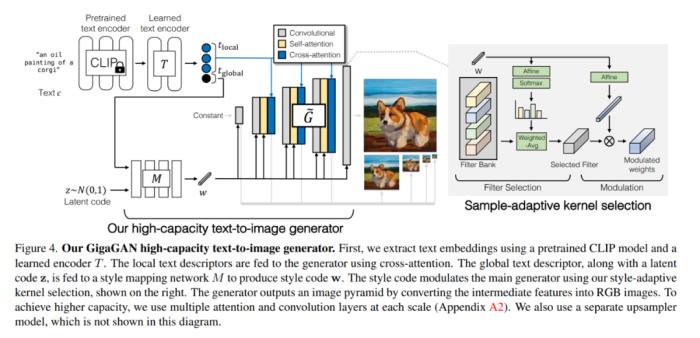

GigaGAN 高容量文本 - 圖像生成器如下圖 4 所示。首先,研究者使用預訓練的 CLIP 模型和學習過的編碼器 T 來提取文本嵌入。使用交叉注意力將局部文本描述符提供給生成器。全局文本描述符,連同潛在編碼 z,被送入風格映射網絡 M 以產生風格碼 w。風格碼使用論文中的風格 - 自適應內核選擇調節主生成器,如右側所示。

生成器通過將中間特征轉換為 RGB 圖像來輸出一個圖像金字塔。為了達到更高的容量,研究者在每個尺度上使用多個注意力層和卷積層(附錄 A2)。他們還使用了一個單獨的上采樣器模型,該模型未在此圖中顯示。

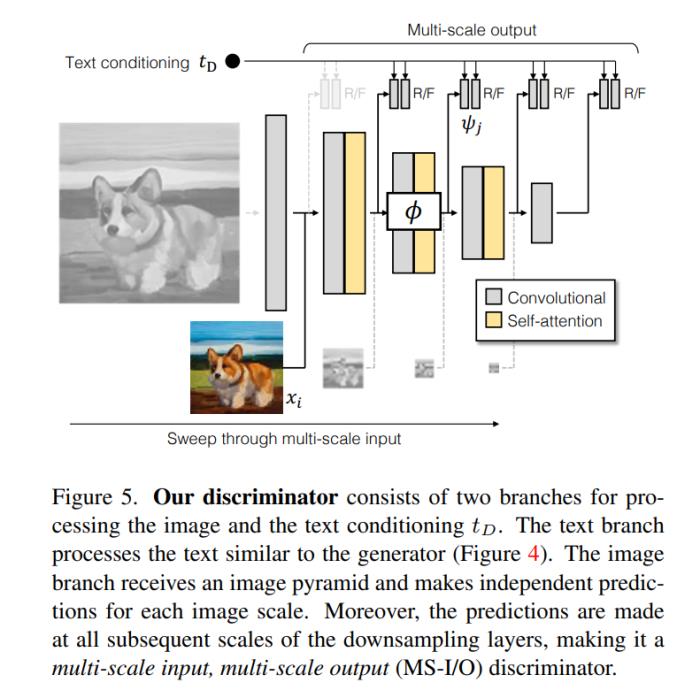

判別器由兩個分支組成,用于處理圖像和文本調節 t_D。文本分支對文本的處理與生成器類似(圖 4)。圖像分支接收一個圖像金字塔,并對每個圖像尺度進行獨立預測。此外,預測是在下采樣層的所有后續尺度上進行的,這使得它成為一個多尺度輸入、多尺度輸出(MS-I/O)的判別器。

實驗結果

在論文中,作者記錄了五個不同的實驗。

在第一個實驗中,他們通過逐個納入每個技術組件來展示所提方法的有效性。

在第二個實驗中,他們測試了模型文生圖的能力,結果顯示,GigaGAN 表現出與 Stable Diffusion(SD-v1.5)相當的 FID,同時產生的結果比擴散或自回歸模型快得多。

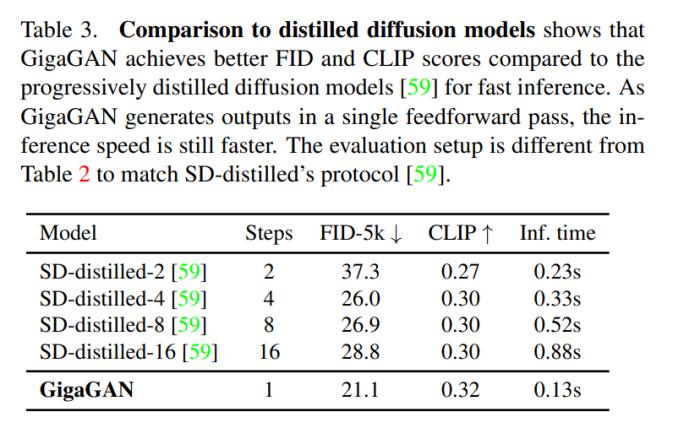

在第三個實驗中,他們將 GigaGAN 與基于蒸餾的擴散模型進行比較,結果顯示,GigaGAN 能比基于蒸餾的擴散模型更快地合成更高質量的圖像。

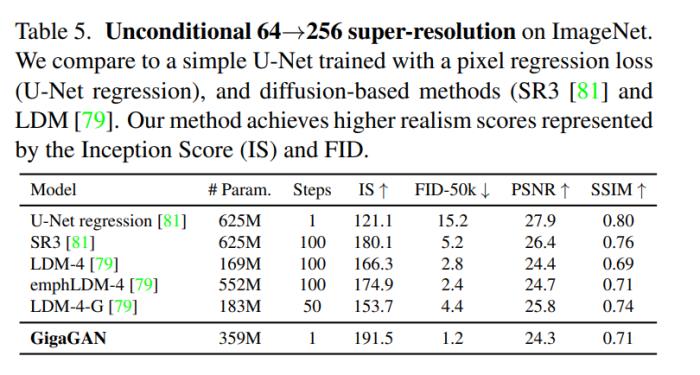

在第四個實驗中,他們驗證了 GigaGAN 的上采樣器在有條件和無條件的超分辨率任務中相比其他上采樣器的優勢。

最后,他們展示了自己提出的大規模 GAN 模型仍然享受 GAN 的連續和解糾纏的潛在空間操作,從而實現了新的圖像編輯模式。圖表請參見上文中的圖 6 和圖 8。

- 免責聲明

- 本文所包含的觀點僅代表作者個人看法,不代表新火種的觀點。在新火種上獲取的所有信息均不應被視為投資建議。新火種對本文可能提及或鏈接的任何項目不表示認可。 交易和投資涉及高風險,讀者在采取與本文內容相關的任何行動之前,請務必進行充分的盡職調查。最終的決策應該基于您自己的獨立判斷。新火種不對因依賴本文觀點而產生的任何金錢損失負任何責任。

新火種

2023-10-31

新火種

2023-10-31