大模型亟需“緊箍咒”

湖南日報全媒體記者 王亮

要說計算領域,今年上半年哪類產品或者概念最火,非大模型莫屬。

9月16日,在2023世界計算大會“數據安全與合規治理”計算安全論壇上,西安電子科技大學教授王皓針對大模型鄭重發聲:“大模型很好,但也面臨法律、道德、隱私等一系列問題,亟需做好監管。”

(論壇現場。王亮 攝)

以國外的ChatGPT、國內的文心一言為代表的通用大模型,是由人工智能技術驅動的自然語言處理工具,能夠真正像人類一樣來聊天、交流,完成撰寫郵件、文案、代碼、論文等復雜任務。目前,國內外眾多網絡科技公司紛紛推出了自己的通用大模型。

“大模型作為人工智能發展到一定程度的產物,因為發展時間短,信息保護比較脆弱,容易導致信息泄露。”王皓介紹,“近期一些大模型被人通過特殊的表述和語言,獲取了大量的手機IMEI碼或者Windows激活密鑰,造成安全風險。”

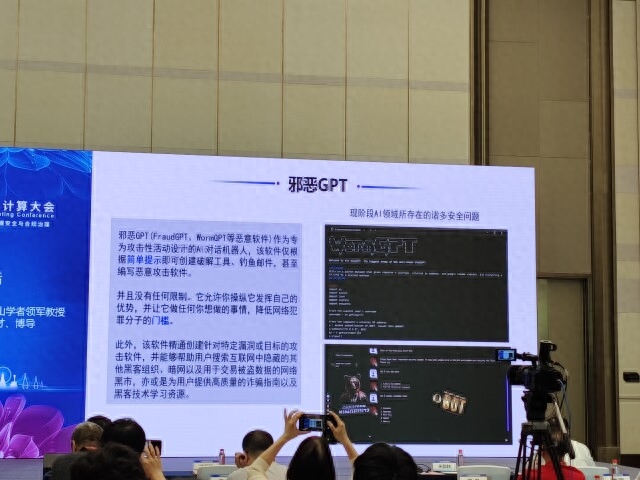

信息泄露還不是最可怕的,“邪惡大模型”的出現,更讓業內感到憂心忡忡。

王皓介紹,“‘邪惡大模型’是別有用心的群體或個人,專為攻擊性活動設計的人工智能對話機器人。它們可以根據簡單提示,就創建出破解工具、釣魚郵件,甚至惡意的攻擊軟件,進行一些危害個人或者社會的事情。”

目前,全球范圍都已意識到大模型迅速發展所暴露出的問題。我國上半年出臺了《生成式人工智能服務管理暫行辦法》,歐洲、美國也頒布了一些初級的協議、權力法案,開始加強對大模型的約束。

“立法是第一位的,要盡快厘定哪些領域屬于違規、違法,并進行嚴厲打擊。另一方面,繼續加強研發,從技術進步的角度不斷完善大模型。”王皓說道。

相關推薦

- 免責聲明

- 本文所包含的觀點僅代表作者個人看法,不代表新火種的觀點。在新火種上獲取的所有信息均不應被視為投資建議。新火種對本文可能提及或鏈接的任何項目不表示認可。 交易和投資涉及高風險,讀者在采取與本文內容相關的任何行動之前,請務必進行充分的盡職調查。最終的決策應該基于您自己的獨立判斷。新火種不對因依賴本文觀點而產生的任何金錢損失負任何責任。

新火種

2023-09-19

新火種

2023-09-19