中國證監(jiān)會科技監(jiān)管局局長:關于大模型生態(tài)建設的若干思考

·實現(xiàn)大、小模型的數(shù)據(jù)交互,除了要依靠數(shù)據(jù)源管理機構(gòu)外,還需考慮建立數(shù)據(jù)托管和交易機構(gòu),使得大、小模型的訓練數(shù)據(jù)可以有序管控和流動,并為各方合理分配相應的權益。

·構(gòu)建大模型持續(xù)發(fā)展、健康交互的良好產(chǎn)業(yè)生態(tài),必須推進大模型訓練數(shù)據(jù)與底層技術的標準化,加快模型的迭代與落地。

進入2023年,ChatGPT、GPT-4以及Midjourney等以內(nèi)容生成為導向的人工智能應用,引發(fā)了一輪又一輪的創(chuàng)新浪潮。有人甚至認為,大模型正在以日為單位迭代進化。作為新型生產(chǎn)要素,大模型訓練數(shù)據(jù)的良性可持續(xù)發(fā)展,對于大模型和人工智能產(chǎn)業(yè)的發(fā)展至關重要。金融業(yè)作為大數(shù)據(jù)和人工智能應用的重要領域,理應密切關注當前大模型訓練相關技術的最新態(tài)勢。本文首先分析大模型的進化與升級路徑,之后通過探討大模型和中小模型可能的交互方式,闡述大模型的數(shù)據(jù)生態(tài)和模型生態(tài)建設,為保障產(chǎn)業(yè)安全健康發(fā)展、規(guī)避數(shù)據(jù)和技術風險以及構(gòu)建可持續(xù)發(fā)展的大模型生態(tài)提供相關思路。

大模型的升級與進化路徑分析

從長期視角來看,大模型的進化衍生出眾多分支。最近一段時間,大模型迭代不僅速度加快,而且參與者也越來越多,基本上涵蓋了所有的大型科技公司,生態(tài)的多樣性和復雜性已初步顯現(xiàn)。

目前,大模型升級迭代過程中的底層算法框架并沒有本質(zhì)的變化,算力投入以及訓練數(shù)據(jù)的豐富仍然是其快速進化的關鍵,只不過最新的GPT-4呈現(xiàn)出一些新的特征。

一是算法方面更適配具體的下游任務。GPT-3與GPT-3.5都是1750億參數(shù)的大模型。GPT-4目前沒有公布具體參數(shù),但有人推測其參數(shù)將達到萬億級別,同時在強化學習和解決具體任務方面也將有顯著提升,比較流行的術語是“對齊”(Alignment)。如果說GPT-3系列模型向大家證明了人工智能能夠在一個模型里做多個任務,那么GPT-4則在很多任務上已經(jīng)達到甚至超過人類水平,比如,在律師等專業(yè)學術考試上,分數(shù)能夠達到應試者前10%左右的水平。

二是具備更規(guī)范的訓練數(shù)據(jù)治理能力且支持多模態(tài)。GPT-4擁有“堪比人腦”的多模態(tài)能力,跟目前很多論文闡述的多模態(tài)機理并無太多差別,但它能夠把文本模型的少樣本處理能力和思維鏈(Chain of Thought,CoT)結(jié)合進來。GPT-4訓練數(shù)據(jù)的治理與供給,離不開數(shù)據(jù)標注、數(shù)據(jù)管理與評估、數(shù)據(jù)自動化以及數(shù)據(jù)合成。

三是構(gòu)建更強大的算力集群,以滿足更多的訓練數(shù)據(jù)集和更大的輸入?yún)?shù)。例如,微軟已經(jīng)將超過一半的云資源投入大模型訓練與人工智能生成內(nèi)容(AIGC)應用。英偉達更是與臺積電、荷蘭阿斯麥、新思科技強強聯(lián)手,打造全新的算力平臺與更強大的GPU。

構(gòu)建各類模型相互聯(lián)通的生態(tài)

GPT類大模型功能強大,在未來會成為許多行業(yè)如互聯(lián)網(wǎng)、金融、醫(yī)療等領域的重要基礎設施之一。例如,在金融領域,經(jīng)過相關專業(yè)數(shù)據(jù)的訓練,大模型可以具備理解金融業(yè)務知識的能力,并能針對具體場景提出解決方案,支持金融機構(gòu)開展營銷自動化、客戶關聯(lián)關系挖掘、智能風險識別、智能客服、智能投研等。

但在具體應用落地的過程中,GPT類大模型還會面臨一系列挑戰(zhàn)。一是如何確保訓練數(shù)據(jù)的數(shù)量與質(zhì)量。一般而言,大模型的訓練語料為來自于多個領域的通用語料,而專業(yè)語料的收集通常比較耗時費力,同時也存在隱私問題,由此導致大模型在具體的個別應用領域可能出現(xiàn)專業(yè)性不足的情況。二是如何降低大模型的運行和維護成本。大模型需要巨大的算力支持和嚴格的數(shù)據(jù)治理,普通的機構(gòu)和應用部門往往難以支撐大模型的運行以及迭代升級工作。為此,需要建立一個各類模型健康交互和協(xié)同進化的生態(tài),以保證大模型相關人工智能產(chǎn)業(yè)可以在各個應用領域成功落地。

從技術角度來分析,大模型的進化依靠人工反饋的強化學習(Reinforcement Learning from Human Feedback,RLHF),其采用的數(shù)據(jù)標注與過去那種用低成本勞動力完成的簡單數(shù)據(jù)標注工作有所不同,需要非常專業(yè)的人士來寫詞條,針對相應的問題和指令,給出符合人類邏輯與表達的高質(zhì)量答案。但由于人工與機器的交互存在一定的隔閡,比較理想的模式是通過模型之間的交互來進行強化學習,即依靠模型反饋的強化學習(Reinforcement Learning from Model Feedback,RLMF)。基于各類模型的交互,可以將整個大模型的數(shù)據(jù)和模型生態(tài)統(tǒng)一為一個框架。

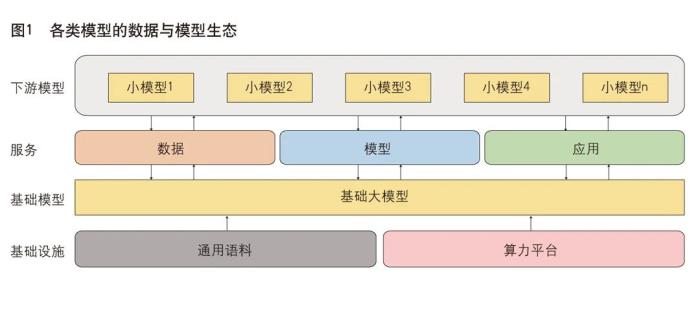

過去,在分散化的模型研發(fā)模式下,單一的人工智能應用場景下多個任務需要由多個模型共同支撐完成,每一個模型建設都要經(jīng)歷算法開發(fā)、數(shù)據(jù)處理、模型訓練與調(diào)優(yōu)過程。預訓練大模型增強了人工智能的通用性、泛化性,基于大模型通過零樣本或小樣本精調(diào),就可在多種任務上取得較好效果。大模型“預訓練+精調(diào)”模式為人工智能研發(fā)帶來了新的標準化范式,使人工智能模型可以在更統(tǒng)一、更簡明的方式下實現(xiàn)規(guī)模化生產(chǎn)。圍繞技術創(chuàng)新與應用落地,大模型的數(shù)據(jù)和產(chǎn)業(yè)生態(tài)可劃分為基礎設施(包括通用語料及算力平臺)、基礎大模型、大模型服務(包括合成數(shù)據(jù)、模型供給及應用插件)。在下游應用中,用戶可以部署自己的小模型,通過大模型的各種服務來提升性能,同時也可反向給大模型提供相應的反饋服務,幫助大模型迭代進化(見圖1)。

基礎大模型是大模型產(chǎn)業(yè)生態(tài)的核心引擎,其優(yōu)勢在于基礎性和通用性,面向典型任務如自然語言處理、計算機視覺、跨模態(tài)任務等需求,進一步結(jié)合任務特性,優(yōu)化模型算法,學習相關數(shù)據(jù)與知識,從而使大模型表現(xiàn)出更優(yōu)異的效果,甚至可以零樣本直接應用。

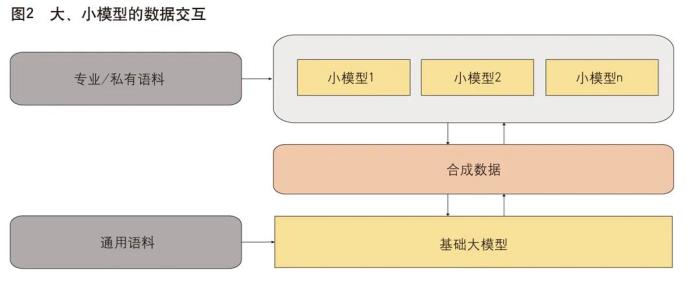

小模型具有體量小(通常在百億參數(shù)級別)、易于訓練及維護的特點,因此適合各垂直領域,適合各行業(yè)進行內(nèi)部開發(fā)和使用。在通常情況下,小模型訓練成本較低,但性能遠不及大模型。通過大、小模型交互應用,可以讓小模型獲得大模型的部分能力或?qū)崿F(xiàn)部分功能,從而在不增加運維成本的前提下,使小模型的性能得到較大提升,滿足具體的應用需求。大、小模型交互的方式可以分為三類:數(shù)據(jù)交互、模型交互和應用交互(見圖2)。

數(shù)據(jù)交互

數(shù)據(jù)交互是指大、小模型不直接參與彼此的訓練或推理過程,而是間接通過彼此產(chǎn)生的數(shù)據(jù)來進行交互。大模型的訓練通常需要大規(guī)模的通用語料,如GPT-3的訓練語料多達753GB,來自維基百科等多個數(shù)據(jù)源。通用語料指的是覆蓋多個領域的語料,在某些特定領域的知識覆蓋可能存在不足。大模型訓練完成后,可以通過指令生成一些特定領域的合成語料,再通過本地化部署,連同該領域的專用語料或行業(yè)內(nèi)的私有語料一起訓練小模型。小模型訓練語料的領域比較集中,因此可以系統(tǒng)掌握本領域的知識,從而使模型的輸出更專業(yè)、更細致、更精準。大模型在這一過程中的作用是產(chǎn)生大規(guī)模的高質(zhì)量合成語料,使小模型的訓練可以更加充分,防止專用語料或私有語料因規(guī)模小而導致模型的過度擬合。反之,小模型生成的專業(yè)語料,也可以作為大模型訓練語料的補充,增強大模型在不同領域的專業(yè)能力,使大模型可以不斷迭代進化。

實現(xiàn)大、小模型的數(shù)據(jù)交互,除了要依靠數(shù)據(jù)源管理機構(gòu)外,還需考慮建立數(shù)據(jù)托管和交易機構(gòu),使得大、小模型的訓練數(shù)據(jù)可以有序管控和流動,并為各方合理分配相應的權益。

模型交互

除了間接的數(shù)據(jù)交互之外,大、小模型還可在模型層面進行交互,通過參與彼此的訓練過程,使得雙方可以共同受益,提升大模型的迭代效率。一方面,大模型可以指導小模型的訓練,常用的方式為蒸餾學習(Knowledge Distillation)。在蒸餾學習模式中,訓練好的大模型可以作為教師模型,待訓練的小模型作為學生模型,針對同一批訓練數(shù)據(jù),通過設計合理的損失函數(shù),將大模型產(chǎn)生的軟標簽與訓練數(shù)據(jù)本身的硬標簽對小模型的訓練進行聯(lián)合指導。同樣,小模型也可對大模型進行反向蒸餾,利用小模型做樣本價值判斷幫助大模型加速收斂——將訓練好的小模型在下游數(shù)據(jù)集上進行進一步微調(diào)之后,得到樣本價值判斷模型。

應用交互

大、小模型在應用層面進行交互的典型方式為插件模式,即將模型構(gòu)建的應用封裝為插件服務供其他模型調(diào)用。插件模式具有兩大優(yōu)點:一是便捷高效,模型無需重復訓練;二是隔離性好,可以避免模型細節(jié)的泄露,從而更好地保護模型訓練方和使用方的權益。

一方面,大模型基本上采用預訓練方式,實時性不高。通過調(diào)用小模型應用插件,大模型應用不僅可以提高輸出結(jié)果的實時性,也可以擴展自身在特定領域的知識缺失。另一方面,小模型構(gòu)建的應用也可以通過調(diào)用GPT類大模型提供的插件,直接獲得大模型強大的生成能力和推理能力。這種應用交互方式可以讓小模型免去通用知識的訓練過程,以較低成本來專注于特定領域的內(nèi)容生產(chǎn),用戶也可以感受到各類模型互聯(lián)互通后產(chǎn)生的“化學”反應。

開放人工智能(OpenAI)近期發(fā)布的新產(chǎn)品ChatGPT plugins可以通過應用插件連接ChatGPT與第三方應用。這些第三方應用,可以是由單個領域的小模型構(gòu)建而成。通過這種方式,小模型可以在ChatGPT類的大模型中完成多種擴展功能,如檢索實時資訊或知識庫信息、代替用戶對現(xiàn)實世界進行“智能調(diào)度”等。

大模型訓練數(shù)據(jù)與模型工具鏈的標準化和安全管控

大模型的性能依賴于訓練數(shù)據(jù)的質(zhì)量,同時,模型在不同落地場景下所需的底層技術規(guī)格也不盡相同。因此,構(gòu)建大模型持續(xù)發(fā)展、健康交互的良好產(chǎn)業(yè)生態(tài),必須推進大模型訓練數(shù)據(jù)與底層技術的標準化,加快模型的迭代與落地。

一方面,大模型自身的訓練數(shù)據(jù)集以及定義的數(shù)據(jù)服務接口(API),將會成為行業(yè)的事實標準,而接入大模型的各種應用都必須遵循該標準。目前,模型“預訓練+微調(diào)”已經(jīng)成為行業(yè)統(tǒng)一的標準流程和范式。在此基礎上,結(jié)合具體的應用場景和專業(yè)數(shù)據(jù),可以進一步定制和優(yōu)化各領域各行業(yè)的小模型。從某種程度上來說,大模型訓練數(shù)據(jù)和數(shù)據(jù)服務接口標準,將會成為下一代國際標準的核心之一。

另一方面,處理大模型訓練數(shù)據(jù)的底層技術所需的工具鏈也必須產(chǎn)品化和標準化。大模型在標準化技術服務的有力支撐下,可輸出硬件適配、模型蒸餾和壓縮、模型分布式訓練和加速、向量數(shù)據(jù)庫、圖數(shù)據(jù)庫、模型互聯(lián)互通等技術方案,提供自然語言處理、計算機視覺、跨模態(tài)、知識圖譜等各類能力,讓更多的企業(yè)、開發(fā)者可以低門檻地將大模型應用于自身業(yè)務并構(gòu)建行業(yè)垂直模型,從而促進人工智能在各領域廣泛落地。

值得注意的是,大模型的開發(fā)和應用雖然會對產(chǎn)業(yè)和經(jīng)濟發(fā)展帶來巨大紅利,但如果不加以合理管控,也會給國家和產(chǎn)業(yè)安全帶來風險。一是數(shù)據(jù)泄露風險。大模型的訓練、落地,都需要以海量的數(shù)據(jù)支撐,其中包含行業(yè)或個人敏感信息的數(shù)據(jù)。如果沒有合理的數(shù)據(jù)脫敏和數(shù)據(jù)托管機制,則可能造成數(shù)據(jù)泄露,給行業(yè)和個人造成損失。二是模型安全風險。比如,插件可能被植入有害內(nèi)容,成為不法分子欺詐和“投毒”的工具,危及社會和產(chǎn)業(yè)安全。

相關建議

以大模型訓練數(shù)據(jù)為抓手,標準制定和數(shù)據(jù)治理雙管齊下。通過制定模型應用規(guī)范,統(tǒng)一接口標準,促進行業(yè)規(guī)范化發(fā)展。可考慮對模型的合成數(shù)據(jù)進行托管,以加強監(jiān)督,保障數(shù)據(jù)內(nèi)容合規(guī)、權益清晰、流通順暢。同時完善法律法規(guī),優(yōu)化政策制度,以多種途徑與方式形成監(jiān)管合力,嚴防惡意篡改模型和滲入有害數(shù)據(jù)等行為。

構(gòu)建大模型訓練數(shù)據(jù)要素市場。厘清訓練數(shù)據(jù)采集處理、合成數(shù)據(jù)服務、大小模型互聯(lián)互通、應用API之間的產(chǎn)業(yè)鏈。加快數(shù)據(jù)要素市場建設,為訓練數(shù)據(jù)提供市場化定價,以利權益分配與激勵。

構(gòu)建大小模型共生發(fā)展、相互促進的良好生態(tài)。總體來看,目前國內(nèi)外主流大模型在算法層面尚不存在代際差,但是在算力和數(shù)據(jù)方面存有差距。建議在通用領域大力支持國內(nèi)頭部科技企業(yè)研發(fā)自主可控的國產(chǎn)大模型,同時鼓勵各垂直領域在大模型基礎上,利用開源工具構(gòu)建規(guī)范可控的自主工具鏈,既探索“大而強”的通用模型,又研發(fā)“小而美”的垂直行業(yè)模型,從而構(gòu)建基礎大模型和專業(yè)小模型交互共生、迭代進化的良好生態(tài)。

(作者姚前,系中國證監(jiān)會科技監(jiān)管局局長。本文首發(fā)于《中國金融》2023年第13期,澎湃科技獲《中國金融》授權刊發(fā)。原標題為《姚前:關于大模型生態(tài)建設的若干思考》)

- 免責聲明

- 本文所包含的觀點僅代表作者個人看法,不代表新火種的觀點。在新火種上獲取的所有信息均不應被視為投資建議。新火種對本文可能提及或鏈接的任何項目不表示認可。 交易和投資涉及高風險,讀者在采取與本文內(nèi)容相關的任何行動之前,請務必進行充分的盡職調(diào)查。最終的決策應該基于您自己的獨立判斷。新火種不對因依賴本文觀點而產(chǎn)生的任何金錢損失負任何責任。

新火種

2023-10-28

新火種

2023-10-28