中國首個網(wǎng)絡大模型,pick了CPU

當電信網(wǎng)絡用上了大模型,會是一種什么體驗?

以前網(wǎng)絡上若是出了問題,運維人員需得是先靠著經(jīng)驗反復排查,找到了“病根”再“對癥下藥”。

而現(xiàn)在有了大模型,這事兒的“打開方式”就變得截然不同了。

首先,網(wǎng)絡上若是出現(xiàn)了問題,大模型已經(jīng)學會自己去找“病根”了,然后會把它的判斷結果呈現(xiàn)到運維人員的面前。

若是結果跟運維人員的診斷一致,那么OK,“啪的一下”,問題就可以快速得到解決。

其次,即使診斷結果有所偏差或者描述不夠詳細,運維人員現(xiàn)在也只需做一個動作——問。

大模型不僅會像一位領域專家一樣,憑借專業(yè)且豐厚的知識,對人類提出的問題做詳盡的解答;更重要的是,它還非常得快。

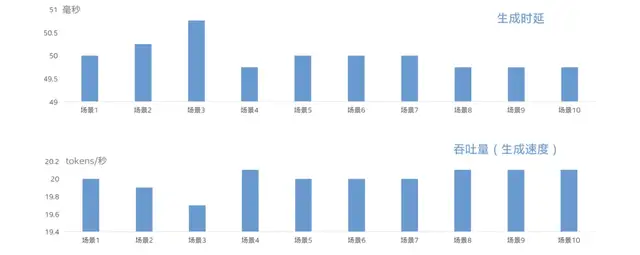

業(yè)界一般認為文本生成延時小于100毫秒是人類覺得較為舒適的閾值,而這個大模型它的生成速度則是:

首字符時延在1秒以內,生成延時在50毫秒左右。

因此,即使面對再多再復雜的問題,運維人員工作的感覺就好比旁邊有一位“高人”在現(xiàn)場指導一樣了。

值得一提的是,這個網(wǎng)絡大模型并不只是個現(xiàn)象級產品,而是已經(jīng)實實在在的做到了“上崗”。

據(jù)悉,某電信運營商已經(jīng)在全國31個省將它鋪開應用,日均調用量高達10萬次!

也正因如此,就在剛剛落幕的第二屆“華彩杯”算力大賽·智能計算專題賽中,它還拿下了一等獎的好成績,是獲得了官方認證的那種。

另外,方案白皮書《中國電信攜英特爾積極探索基于至強® CPU 平臺的網(wǎng)絡大模型推理算力方案》也在中國通信標準化協(xié)會CCSA TC610、歐洲電信標準化協(xié)會ENI產業(yè)標準組主辦的云網(wǎng)運營自智與網(wǎng)絡大模型技術研討會上正式發(fā)布。

那么接下來,我們就來進一步深入了解一下這個網(wǎng)絡大模型。

當大模型“上崗”電信網(wǎng)絡就目前“上崗”的結果來看,該電信運營商的各級運維人員均已接入網(wǎng)絡大模型。

正如我們剛才提到的,他們運維的方式已經(jīng)產生了實質性的改變——

專業(yè)知識問答、信息篩選、總結信息等等,統(tǒng)統(tǒng)交給大模型來處理即可。

不僅如此,在網(wǎng)絡規(guī)劃方面,網(wǎng)絡大模型也在發(fā)揮著作用。

它的推理輸出結果已經(jīng)涵蓋了網(wǎng)絡建設、網(wǎng)絡維護、網(wǎng)絡優(yōu)化和運營決策等場景。

基層運維人員通過這些結果,就可以實現(xiàn)精準理解與分析規(guī)則、自動規(guī)則核查;同時,網(wǎng)絡大模型提供的專業(yè)領域專業(yè)知識,還可以幫助電信行業(yè)方案分析與生成。

或許有小伙伴就要問了,這和市面上的眾多大模型問答產品又有什么區(qū)別呢?

重點就在于夠垂直。

網(wǎng)絡大模型作為行業(yè)的“專家”,它所提供的答案是可以深入理解運維人員的用戶需求和意圖的,因此生成的答案和知識更精準、更個性化。

生成內容是夠專業(yè)了,接下來我們就要聊聊速度的問題。

眾多的運維場景都屬于邊緣端,也正因如此,就會對數(shù)據(jù)在邊側的即時響應速度提出了較高的要求。

畢竟若是等大模型生成答案還要好幾分鐘,那么對于運營商網(wǎng)絡故障修復來說就成了臃腫的包袱。

對此,該電信運營商的“解法”是:

邊緣服務器的部署環(huán)境要求要比數(shù)據(jù)中心高,有時甚至需要部署在一些極端的惡劣情況下。

這意味著邊緣服務器需要在功耗、體積、耐用性、 TCO 等方面符合特定的要求,能夠在極端高低溫、灰塵、腐蝕、震動沖擊、電磁干擾下保持設備的正常運行。

而該電信運營商所采用的OTII服務器部署在邊緣場景下就具備了相對的優(yōu)勢,例如針對環(huán)境適應的問題,它可以在高溫55°以下工作。

除此之外,它還支持IP65,符合EMC ClassB設計,支持9級地震烈度,機身小巧,有1U/2U/4U等多種型號,支持掛墻安裝等等。

不僅如此,服務器還支持前維護,適應邊緣的運維需求,該電信運營商大量的邊緣機房無需任何改造,就可以部署基于OTII標準的標準服務器。

也正因為在如此,便讓數(shù)據(jù)的及時交互和響應有了強有力的安全保障。

其生成速度也正如剛才所述,已經(jīng)達到了首字符時延在1秒以內,生成時延在50毫秒左右,可以滿足大模型推理的功能和性能需求。

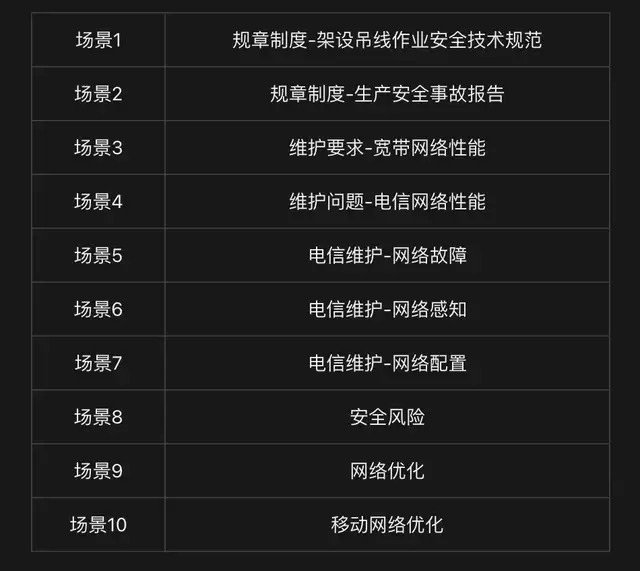

就目前來看,網(wǎng)絡大模型已覆蓋網(wǎng)絡“規(guī)、建、維、優(yōu)、營”全生命周期五大類場景,圍繞知識問答、輔助助手、智能體三個維度,已經(jīng)打造了12個AI助手。

具體場景和性能表現(xiàn)如下表、圖所示:

△網(wǎng)絡大模型在不同應用場景中的性能表現(xiàn)

據(jù)悉,該電信運營商網(wǎng)絡大模型已實現(xiàn)問答準確率85%、方案生成可用率90%、故障處置效率提升30%、高危指令稽核效率提升50%的總體目標。

由此可見,網(wǎng)絡大模型已然是一個合格有效且可放心“上崗”的AI了。

而在它能夠做到“夠快、夠準”的背后,該電信運營商還有一個殺手锏——

在背后起關鍵作用的算力“馬達”,某電信運營商pick的是CPU。

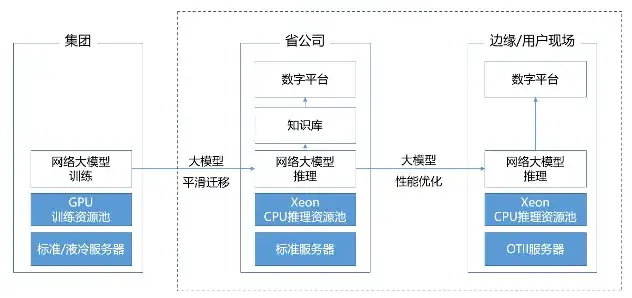

Why CPU?從上述”網(wǎng)絡”大模型的應用流程可以看到,模型推理是至關重要的一個環(huán)節(jié),它直接決定了故障定位、處置方案的生成速度和準確率。

而這恰恰是CPU大顯身手的”主場”。

從電信行業(yè)本身的特點來說,歷來整個系統(tǒng)中就有大量的CPU存量,無需引入全新的異構架構,而是繼續(xù)采用成熟的CPU方案,對電信行業(yè)來說有幾大優(yōu)勢:

減少采購環(huán)節(jié),降低總擁有成本。

該電信運營商作為全球規(guī)模最大的通信運營商之一,其網(wǎng)絡中部署著數(shù)以百萬計的X86服務器。這些服務器往往還處于使用周期內,完全可以通過軟件升級的方式,快速實現(xiàn)大模型的部署與應用。相比重新采購新的硬件設備,這種方式可以大幅降低前期投入,提高投資回報率。

電信行業(yè)對系統(tǒng)穩(wěn)定性要求更高。

電信業(yè)務覆蓋范圍廣,涉及社會運行方方面面,從醫(yī)療救援到金融交易等等,對連續(xù)性要求極高,輕微故障也會直接影響客戶體驗。現(xiàn)代通信網(wǎng)絡又是全球最復雜的工程系統(tǒng)之一,一處小小的異常都可能引發(fā)連鎖反應,影響整網(wǎng)運轉。而以X86平臺為代表的英特爾CPU架構安全和穩(wěn)定性經(jīng)過幾十年的積累和驗證,經(jīng)得起考驗。

已建立成熟的運維技術團隊。

作為ICT領域的傳統(tǒng)企業(yè),該電信運營商擁有一支規(guī)模龐大、經(jīng)驗豐富的IT技術團隊。這些工程師、運維人員,對英特爾CPU的微架構、指令集、調優(yōu)工具等都有著深入的理解和掌握。繼續(xù)采用CPU部署大模型無需太多學習和培訓成本,大大降低了新技術的采用門檻。

△網(wǎng)絡網(wǎng)絡大模型在不同應用場景中的性能表現(xiàn)

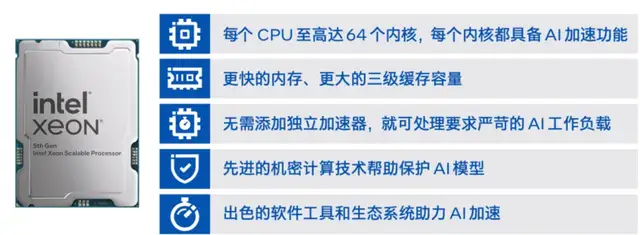

具體到CPU產品的選型,“網(wǎng)絡”大模型方案使用第五代英特爾® 至強® 可擴展處理器作為算力核心,來應對高強度、高并發(fā)的大模型推理需求。

首先,第五代英特爾® 至強® 可擴展處理器配備了更多的處理器內核數(shù)量、更強的單核性能和更大的三級緩存(LLC)容量。尤其是LLC容量的提升,使得大多數(shù)模型參數(shù)能夠直接駐留其中,從而大幅提升推理速度。此外,每路處理器還支持多達8個DDR5-4800內存通道,能夠有效緩解高內存需求場景下的帶寬瓶頸。

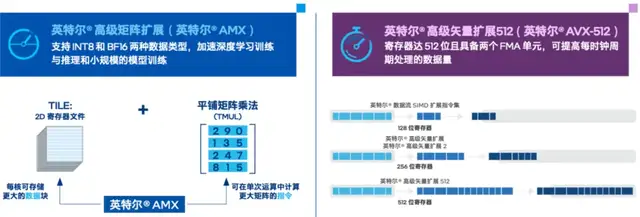

更重要的是,第五代至強® 還內置了多個專用于AI加速的引擎。特別是英特爾® AMX(高級矩陣擴展),采用分塊矩陣乘法的創(chuàng)新方式,通過Tile矩陣乘法單元(TMUL)對數(shù)據(jù)實施矩陣運算。并且AMX支持INT8、BF16等低精度數(shù)據(jù)類型,在保證精度的前提下顯著提高每時鐘周期的指令數(shù)。

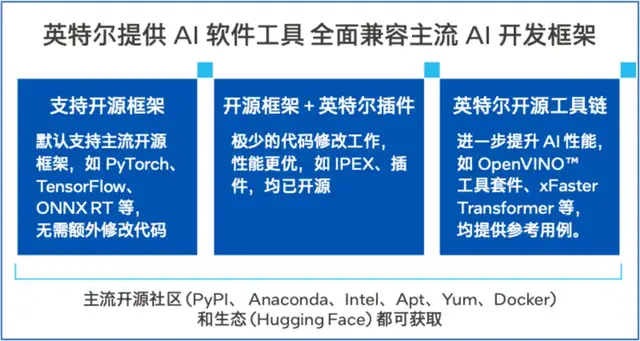

軟件方面,方案還引入了一系列英特爾AI工具來進一步釋放硬件潛力。

例如,英特爾開源的分布式推理優(yōu)化框架xFastTransformer(xFT),可基于至強® 平臺的指令集實現(xiàn)張量并行、流水線并行等多種性能優(yōu)化,并支持 BF16、INT8、INT4等多種數(shù)據(jù)類型以及多種主流大模型。

這些AI 軟件工具實現(xiàn)了對主流AI開發(fā)框架的全面兼容,使得網(wǎng)絡大模型無需修改代碼即可從GPU遷移到CPU,真正實現(xiàn)“一次編寫,隨處部署”。

此外,得益于CPU的能效優(yōu)勢,采用第五代至強® 方案還能顯著降低模型運營的能耗成本。數(shù)據(jù)顯示,第五代至強® 的開箱即用能耗比較上一代提升高達34%,啟用BIOS優(yōu)化后還可進一步提高。

除了對CPU本身的選擇,網(wǎng)絡大模型由于需要部署到生產一線,有時甚至需要在極端惡劣環(huán)境部署,對于整個服務器的要求非常高。

為了更好地滿足業(yè)務需求并提升使用體驗,該電信運營商選用了符合OTII標準的邊緣服務器。

OTII標準由英特爾聯(lián)合中國通信標準化協(xié)會、該電信運營商等企業(yè)共同制定,滿足電信邊緣場景對開放性、可擴展性的要求,涵蓋了服務器外形、散熱、電源、管理等各方面的規(guī)范,在功耗、體積、耐用性等方面符合特定要求,能在極端高低溫、灰塵、腐蝕、震動沖擊、電磁干擾等情況下保持運行。

由此可見,選擇CPU進行網(wǎng)絡大模型推理部署,已被該電信運營商這樣的大型企業(yè)實際驗證。這既是出于技術成熟度與穩(wěn)定性的考量,更契合了企業(yè)客觀的IT環(huán)境與人才儲備。

該電信運營商的實踐表明,在時延、吞吐、功耗等關鍵指標上,CPU不僅可以滿足嚴苛的業(yè)務需求,借助軟硬件的聯(lián)合優(yōu)化,推理成本也大幅下降。

特別是該方案還在2024 華彩杯取得好成績,為大模型在更多場景應用打造了一個標桿。該電信運營商和英特爾的合作模式,也成為一個可以值得借鑒的“范本”。

隨著未來技術發(fā)展,大模型還會深入走進更多行業(yè),需要在性能、功耗、成本、易用性等多方面實現(xiàn)最佳平衡。

總的來說,CPU在AI推理加速上仍然大有可為。

- 免責聲明

- 本文所包含的觀點僅代表作者個人看法,不代表新火種的觀點。在新火種上獲取的所有信息均不應被視為投資建議。新火種對本文可能提及或鏈接的任何項目不表示認可。 交易和投資涉及高風險,讀者在采取與本文內容相關的任何行動之前,請務必進行充分的盡職調查。最終的決策應該基于您自己的獨立判斷。新火種不對因依賴本文觀點而產生的任何金錢損失負任何責任。

新火種

2024-09-14

新火種

2024-09-14