大模型微調(diào)非得依賴人類數(shù)據(jù)嗎?DeepMind:用帶反饋的自訓(xùn)練更好

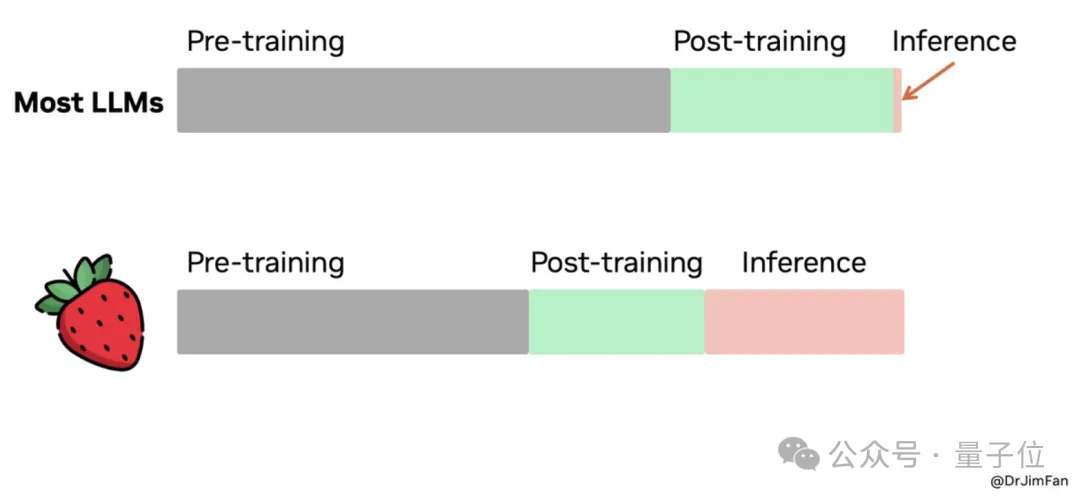

面對當(dāng)前微調(diào)大模型主要依賴人類生成數(shù)據(jù)的普遍做法,谷歌 DeepMind 探索出了一種減少這種依賴的更高效方法。

如你我所見,大語言模型(LLM)正在改變深度學(xué)習(xí)的格局,在生成人類質(zhì)量的文本和解決各種語言任務(wù)方面展現(xiàn)出了卓越的能力。雖然業(yè)界通過對人類收集的數(shù)據(jù)進行監(jiān)督微調(diào)進一步提升了在具體任務(wù)上的性能,但獲取高質(zhì)量人類數(shù)據(jù)卻面臨著重大瓶頸。這對于要解決復(fù)雜問題的任務(wù)來說尤為明顯,需要大量資源和專業(yè)知識。怎么解決呢?模型生成得合成數(shù)據(jù)是一種有潛力的替代方案,只要能保證數(shù)據(jù)的質(zhì)量,就能實現(xiàn)可擴展性和成本效益。雖然 LLM 能夠自我評估生成的數(shù)據(jù),但在本文中,谷歌 DeepMind 探索了一種更簡單的設(shè)置,將外部標(biāo)量反饋信號用作每個生成樣本的質(zhì)量指標(biāo)。

Tags:

相關(guān)推薦

- 免責(zé)聲明

- 本文所包含的觀點僅代表作者個人看法,不代表新火種的觀點。在新火種上獲取的所有信息均不應(yīng)被視為投資建議。新火種對本文可能提及或鏈接的任何項目不表示認(rèn)可。 交易和投資涉及高風(fēng)險,讀者在采取與本文內(nèi)容相關(guān)的任何行動之前,請務(wù)必進行充分的盡職調(diào)查。最終的決策應(yīng)該基于您自己的獨立判斷。新火種不對因依賴本文觀點而產(chǎn)生的任何金錢損失負(fù)任何責(zé)任。

新火種

2024-01-02

新火種

2024-01-02