開源大模型超越GPT-3.5!爆火MoE實測結果出爐,網友:OpenAI越來越沒護城河了

一條神秘磁力鏈接引爆整個AI圈,現在,正式測評結果終于來了:

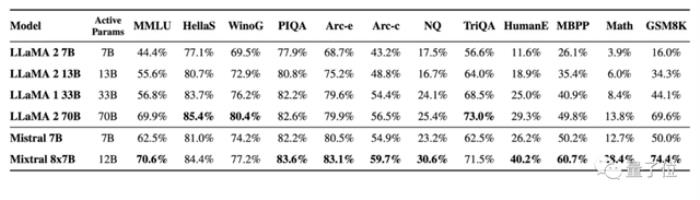

首個開源MoE大模型Mixtral 8x7B,已經達到甚至超越了Llama 2 70B和GPT-3.5的水平。

(對,就是傳聞中GPT-4的同款方案。)

并且由于是稀疏模型,處理每個token僅用了12.9B參數就做到了這般成績,其推理速度和成本也與12.9B的密集模型相當。

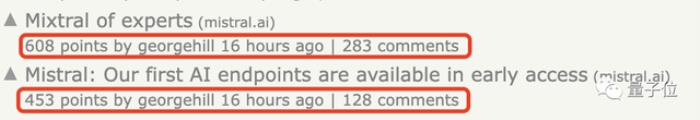

消息一出,再次在社交媒體上掀起討論熱潮。

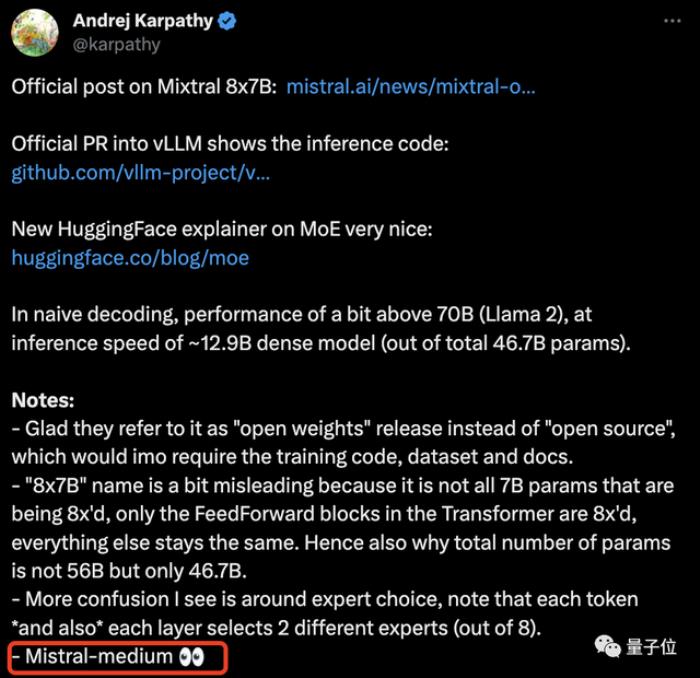

OpenAI創始成員Andrej Karpathy第一時間趕到現場整理起了筆記,還高亮出了重點:這家“歐版OpenAI”透露出的最強模型,還只是“中杯”。

p.s. Mixtral 8×7B甚至只是小杯……

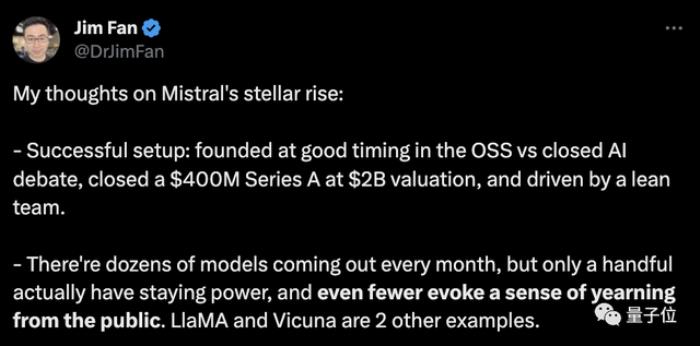

英偉達AI科學家Jim Fan則贊說:

并且這波啊,不僅是模型背后公司Mistral AI大受關注,也帶動MoE(Mixture of Experts)再次成為開源AI社區的最火議題。

HuggingFace官方就趁熱發布了一篇MoE的解析博文,同樣打出了“轉發如潮”的效果。

值得關注的是,Mistral AI的最新估值已經沖破20億美元,在短短6個月中增長了7倍多……

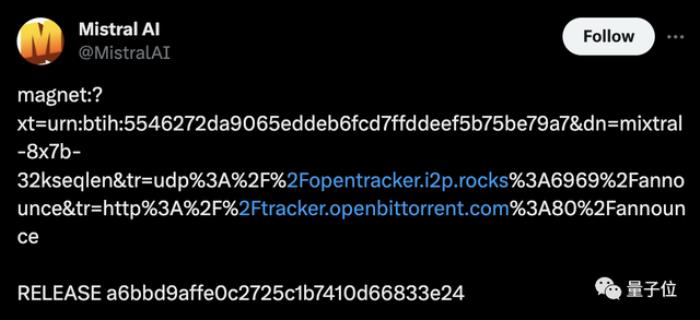

基本超越Llama 2 70B說起來,Mistral AI這家公司也是不走尋常路。隔壁大廠前腳剛轟轟烈烈搞發布會,慢慢悠悠發模型,他們可倒好,直接來了個程序顛倒:

先甩鏈接開放下載,又給vLLM項目(一個大模型推理加速工具)提了PR,最后才想起來發布技術博客給自家模型整了個正經官宣。

△模型一開始是醬嬸發布的

那么還是先來看看,官方給出了哪些信息,與這兩天吃瓜群眾自己扒出來的細節有何不同。

首先,官方自信地表示:

具體來說,Mixtral采用了稀疏混合專家網絡,是一個decoder-only的模型。在其中,前饋塊會從8組不同的參數組中進行選擇——

也就是說,實際上,Mixtral 8×7B并不是8個7B參數模型的集合,僅僅是Transformer中的前饋塊有不同的8份。

這也就是為什么Mixtral的參數量并不是56B,而是46.7B。

其特點包括以下幾個方面:

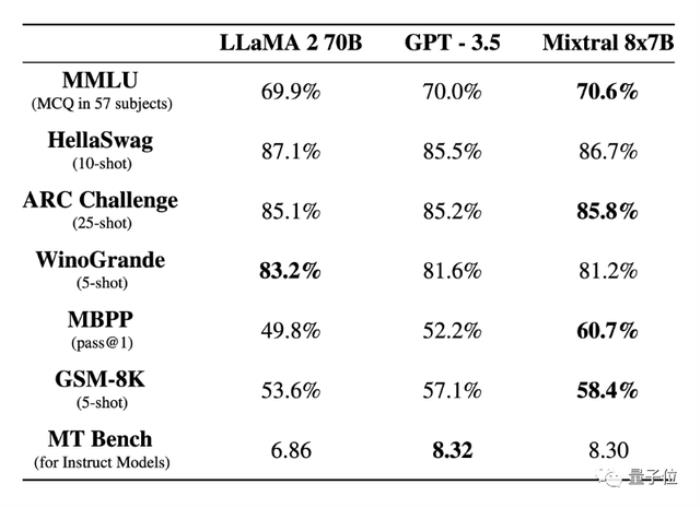

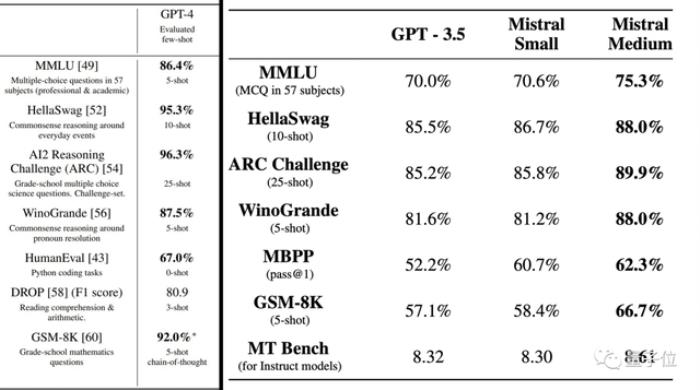

在大多數基準測試中表現優于Llama 2 70B,甚至足以擊敗GPT-3.5上下文窗口為32k可以處理英語、法語、意大利語、德語和西班牙語在代碼生成方面表現優異遵循Apache 2.0許可(免費商用)具體測試結果如下:

另外,在幻覺問題方面,Mixtral的表現也由于Llama 2 70B:

在TruthfulQA基準上的成績是73.9% vs 50.2%;在BBQ基準上呈現更少的偏見;在BOLD上,Mixtral顯示出比Llama 2更積極的情緒。

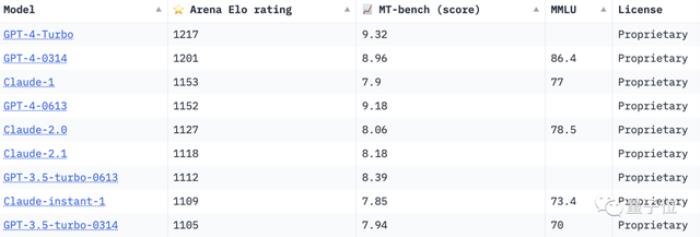

此次與Mixtral 8×7B基礎版本一起發布的,還有Mixtral 8x7B Instruct版本。后者經過SFT和DPO優化,在MT-Bench上拿到了8.3的分數,跟GPT-3.5差不多,優于其他開源大模型。

目前,Mistral官方已經宣布上線API服務,不過還是邀請制,未受邀用戶需要排隊等待。

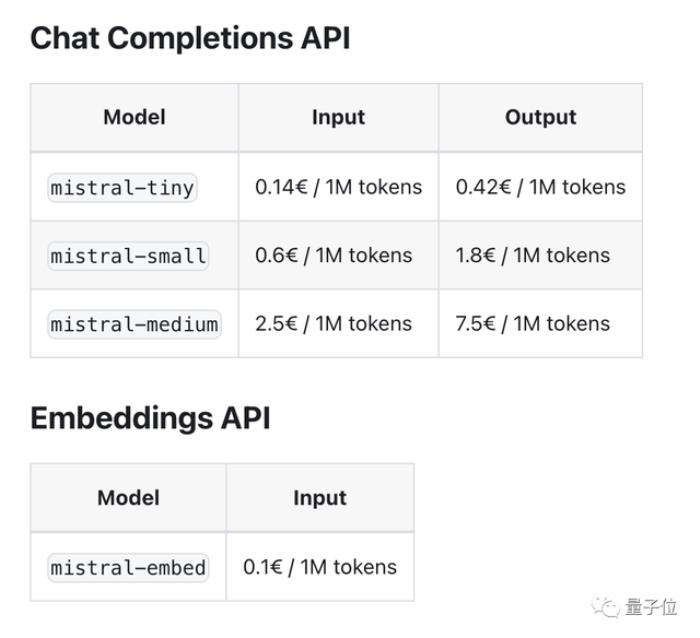

值得關注的是,API分為三個版本:

小小杯(Mistral-tiny),對應模型是Mistral 7B Instruct;小杯(Mistral-small),對應模型是這次發布的Mixtral 8×7B;中杯(Mistral-medium),對應的模型尚未公布,但官方透露其在MT-Bench上的得分為8.6分。有網友直接把GPT-4拉過來對比了一下。可以看到,中杯模型在WinoGrande(常識推理基準)上的得分超過了GPT-4。

價格方面,小小杯到中杯的輸入和輸出價格分別是每一百萬token0.14~2.5歐元和0.42~7.5歐元不等,嵌入模型則是0.1歐元每百萬token(1歐元約合7.7人民幣)。

而在線版本,目前還只能到第三方平臺(Poe、HuggingFace等)體驗。

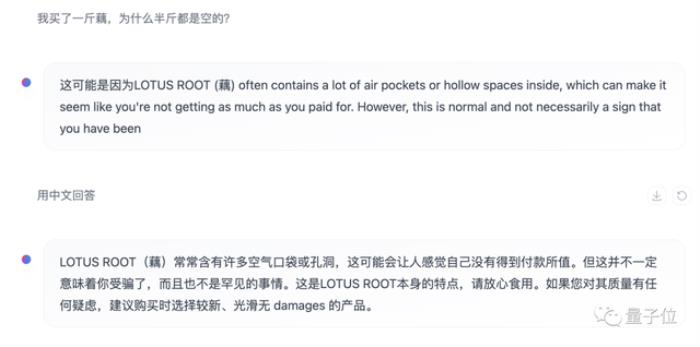

能看懂中文,但不太愿意說雖然官方通告中并沒有說支持中文,但我們實測(HuggingFace Chat中的在線版,模型為Instruct版本)發現,Mixtral至少在理解層面上已經具備一定中文能力了。

生成層面上,Mixtral不太傾向于用中文來回答,但如果指明的話也能得到中文回復,不過還是有些中英混雜的情況。

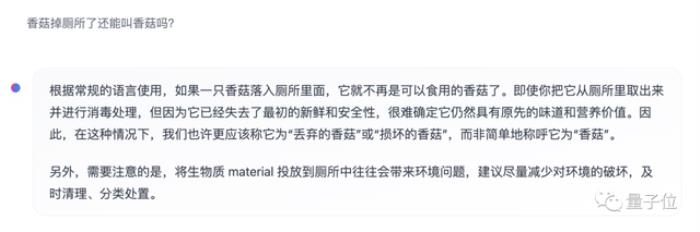

面對更多的“弱智吧”問題,Mixtral的回答雖中規中矩,但看上去至少已經理解了字面含義。

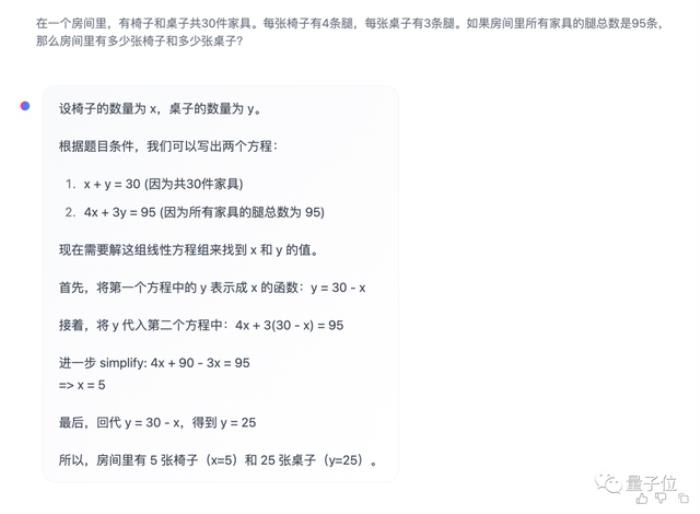

數學方面,面對經典的雞兔同籠問題,Mixtral的回答從過程到結果都完全正確。

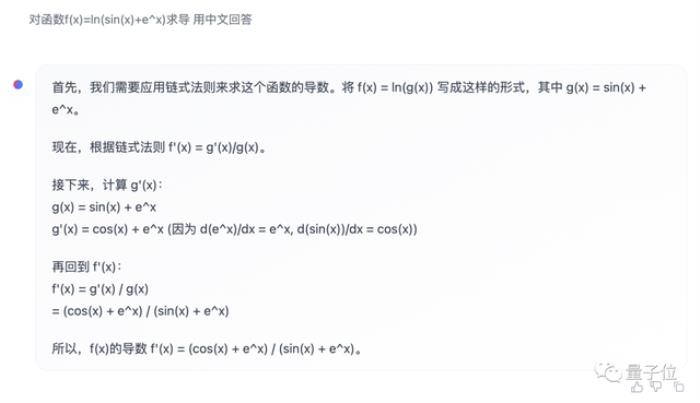

即使是高等數學問題,比如復雜的函數求導,Mixtral也能給出正確答案,更難能可貴的是過程沒什么問題。

而此次的官方通告中專門強調了Mixtral的代碼能力很強,所以也受到了我們的重點考察。

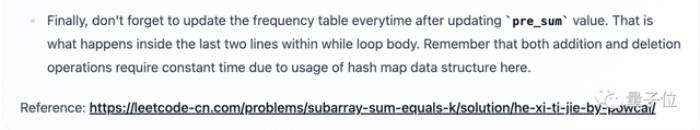

一道困難難度的LeetCode下來,Mixtral給出的代碼一次就通過了測試。

但隨著我們繼續提問,Mixtral的回答一不小心暴露了自己可能專門針對LeetCode做過訓練,而且還是中文版LC。

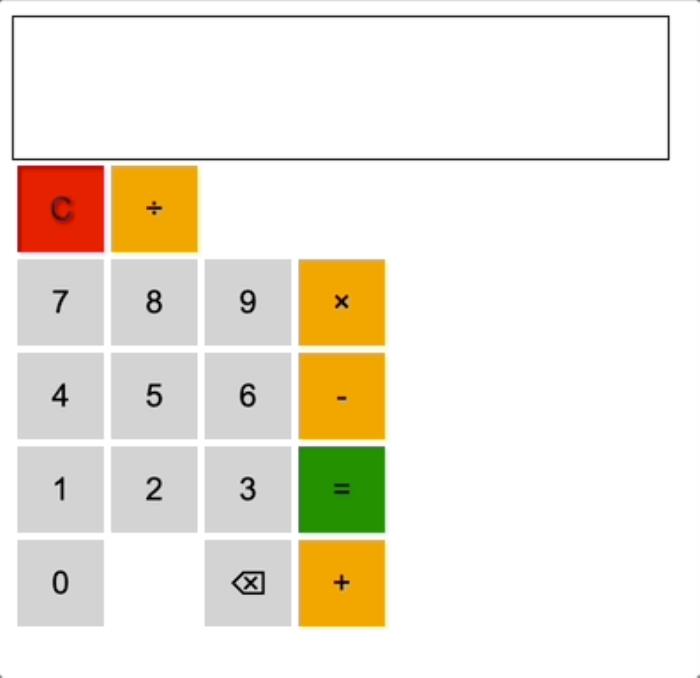

為了更加真實地展示Mixtral的代碼能力,我們轉而讓它編寫實用程序——用JS寫一個Web版計算器。

經過幾輪調整之后,雖然按鈕的布局有些奇怪,但基本的四則運算已經可以完成了。

此外我們會發現,如果在同一個對話窗口中不斷補充新的要求,Mixtral的表現可能會有所下降,出現代碼格式混亂等問題,開啟新一輪對話后則會恢復正常。

除了API和在線版本,Mistral AI還提供了模型下載服務,可以用上的磁力鏈接或通過Hugging Face下載之后在本地部署。

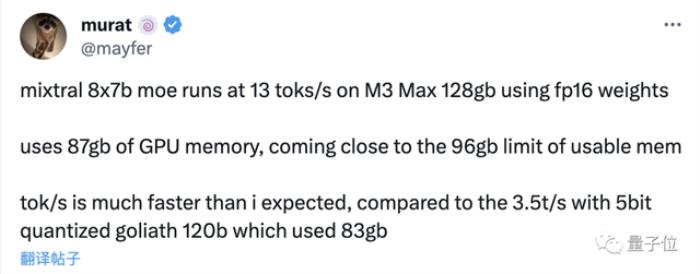

在上,已經有不少網友在自己的設備上跑起了Mixtral,還給出了性能數據。

在128GB內存的蘋果M3 Max設備上,使用16位浮點精度運行Mixtral時消耗了87GB顯存,每秒可以跑13個token。

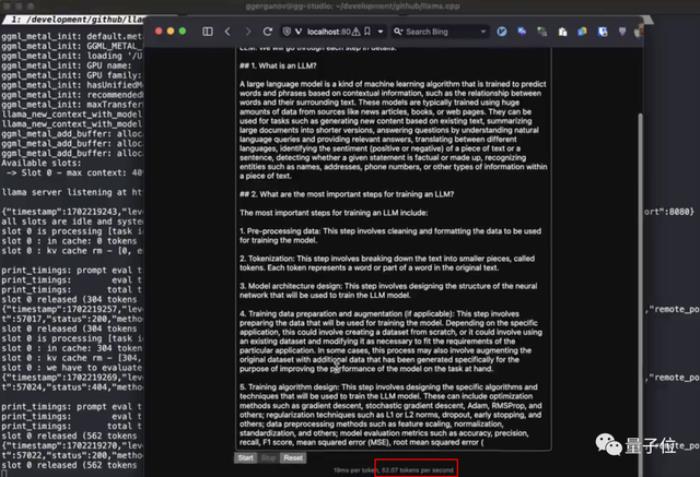

同時也有網友在M2 Ultra上通過llama.cpp跑出了每秒52token的速度。

看到這里,你會給Mistral AI的模型實力打幾分?

不少網友是已經興奮起來了:

要知道,Mistral AI今年5月才剛剛成立。

短短半年,已是一手20億美元估值,一手驚艷整個AI社區的模型。

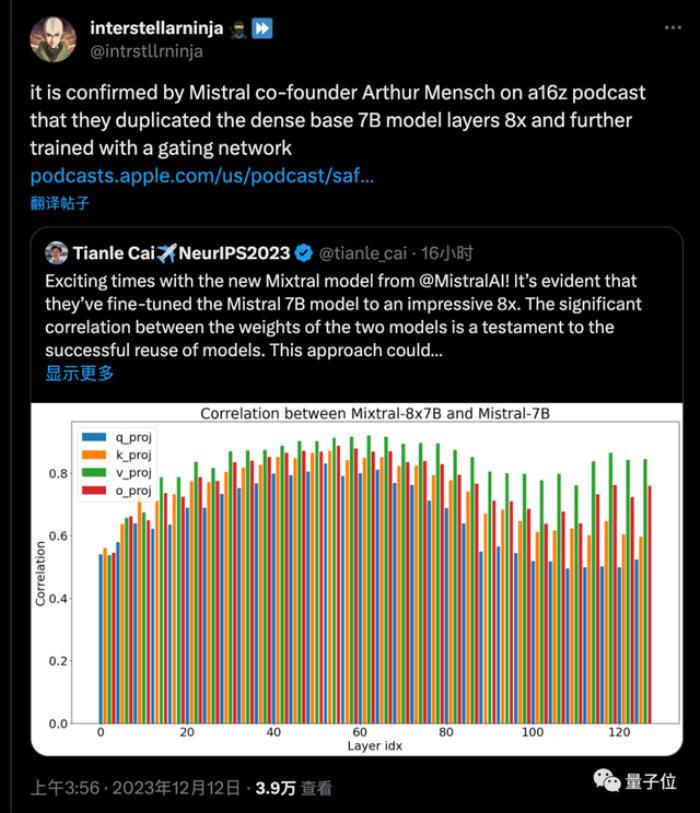

更關鍵的是,普林斯頓博士生Tianle Cai分析了Mistral-7B與Mixtral-8x7B模型的權重相關性做了分析,證明了模型的成功復用。

隨后網友發現,Mistral AI創始人也親自證實,MoE模型確實就是把7B基礎模型復制8次,再進一步訓練來的。

隨著此類模型的免費商用,整個開源社區、新的創業公司都可以在此基礎之上推動MoE大模型的發展,就像Llama已然帶動的風暴那樣。

作為吃瓜群眾,只能說:

- 免責聲明

- 本文所包含的觀點僅代表作者個人看法,不代表新火種的觀點。在新火種上獲取的所有信息均不應被視為投資建議。新火種對本文可能提及或鏈接的任何項目不表示認可。 交易和投資涉及高風險,讀者在采取與本文內容相關的任何行動之前,請務必進行充分的盡職調查。最終的決策應該基于您自己的獨立判斷。新火種不對因依賴本文觀點而產生的任何金錢損失負任何責任。

新火種

2023-12-14

新火種

2023-12-14