PyTorch更新!谷歌幫助開發(fā),正式支持TensorBoard|5大開源項目

邊策 乾明 發(fā)自 凹非寺 量子位 報道 | 公眾號 QbitAI大家又少了一個用TensorFlow的理由。在一年一度的開發(fā)者大會F8上,F(xiàn)acebook放出PyTorch的1.1版本,直指TensorFlow“腹地”。不僅宣布支持TensorFlow的可視化工具TensorBoard,還正式向工業(yè)界邁進,為生產(chǎn)環(huán)境改進了PyTorch處理分布式訓練的方式。而且,根據(jù)Facebook介紹,開發(fā)這一版本的過程中谷歌還幫了不少忙。科技媒體TechCrunch評論稱,雖然版本號只從1.0到1.1的變化,但依舊非常重要。 此外,圍繞著打造“開發(fā)和協(xié)作的AI社區(qū)”的愿景,F(xiàn)acebook還介紹了5大開源工具。同時,他們也分享了Facebook在自家程序中應用AI的情況,以及對AI研究的展望。下面,我們一個個來看~Pytorch大更新與2018年12月正式發(fā)布的Pytorch1.0相比,這次發(fā)布的1.1版本提高了性能,并增加了新的模型理解和可視化工具,來提高可用性,還提供了新的API。

此外,圍繞著打造“開發(fā)和協(xié)作的AI社區(qū)”的愿景,F(xiàn)acebook還介紹了5大開源工具。同時,他們也分享了Facebook在自家程序中應用AI的情況,以及對AI研究的展望。下面,我們一個個來看~Pytorch大更新與2018年12月正式發(fā)布的Pytorch1.0相比,這次發(fā)布的1.1版本提高了性能,并增加了新的模型理解和可視化工具,來提高可用性,還提供了新的API。 其中,最重要的功能是支持TensorBoard,它是谷歌為TensorFlow打造的可視化工具,能夠幫助開發(fā)人員評估和調試模型。根據(jù)Facebook介紹,在開發(fā)這一功能的時候,他們與谷歌有非常密切的合作。現(xiàn)在,Pytorch使用一個簡單的“from torch.utils.TensorBoard import SummaryWriter”命令來支持TensorBoard。其他的更新還有:Jit編譯器:改進了Just-in-time(JIT)編譯。包括各種錯誤的修復以及TorchScript中擴展的功能,例如對字典、用戶類和屬性的支持。新API:支持布爾張量,更好地支持自定義循環(huán)神經(jīng)網(wǎng)絡。分布式訓練:改進了常見模型(如CNN)的性能,增加了對多設備模塊的支持,包括在仍使用分布式數(shù)據(jù)并行(DDP)的情況下跨GPU分割模型的能力,以及對并非所有參數(shù)都用于每次迭代的模塊的支持(如控制流,如自適應SoftMax等)。關于本次更新,Pytorch在下面的GitHub文檔中進行了詳細的解釋,

其中,最重要的功能是支持TensorBoard,它是谷歌為TensorFlow打造的可視化工具,能夠幫助開發(fā)人員評估和調試模型。根據(jù)Facebook介紹,在開發(fā)這一功能的時候,他們與谷歌有非常密切的合作。現(xiàn)在,Pytorch使用一個簡單的“from torch.utils.TensorBoard import SummaryWriter”命令來支持TensorBoard。其他的更新還有:Jit編譯器:改進了Just-in-time(JIT)編譯。包括各種錯誤的修復以及TorchScript中擴展的功能,例如對字典、用戶類和屬性的支持。新API:支持布爾張量,更好地支持自定義循環(huán)神經(jīng)網(wǎng)絡。分布式訓練:改進了常見模型(如CNN)的性能,增加了對多設備模塊的支持,包括在仍使用分布式數(shù)據(jù)并行(DDP)的情況下跨GPU分割模型的能力,以及對并非所有參數(shù)都用于每次迭代的模塊的支持(如控制流,如自適應SoftMax等)。關于本次更新,Pytorch在下面的GitHub文檔中進行了詳細的解釋,

。對于這次更新,PyTorch的產(chǎn)品經(jīng)理Joe Spisa表示,他們并不是要將PyTorch變成金錢,而是希望PyTorch擁有一個社區(qū)。他表示,現(xiàn)在這個社區(qū)正開始從一個以研究為中心的社區(qū)向生產(chǎn)型的社區(qū)轉變,而且轉變速度也在快速增長。PyTorch路線圖的下一步是,以更少的比特數(shù)運行神經(jīng)網(wǎng)絡,實現(xiàn)更快的CPU和GPU性能,并支持AI從業(yè)者創(chuàng)建命名張量維數(shù)。5大開源工具 為了更好地建設AI社區(qū),今年的F8大會上,F(xiàn)acebook還開源了5大工具:Ax、BoTorch、idb、Memscout、Mvfst。Ax

為了更好地建設AI社區(qū),今年的F8大會上,F(xiàn)acebook還開源了5大工具:Ax、BoTorch、idb、Memscout、Mvfst。Ax Ax是一個可訪問的通用自適應實驗平臺,用于管理、部署和自動化實驗。該平臺利用BoTorch提供的最新進展,使開發(fā)人員更容易優(yōu)化其產(chǎn)品和基礎設施。Ax還降低了貝葉斯優(yōu)化(Bayesian optimization)、多臂老虎機(multiarmed bandit)和其他復雜實驗技術的門檻,幫助研究人員將想法從研究轉向生產(chǎn)。

Ax是一個可訪問的通用自適應實驗平臺,用于管理、部署和自動化實驗。該平臺利用BoTorch提供的最新進展,使開發(fā)人員更容易優(yōu)化其產(chǎn)品和基礎設施。Ax還降低了貝葉斯優(yōu)化(Bayesian optimization)、多臂老虎機(multiarmed bandit)和其他復雜實驗技術的門檻,幫助研究人員將想法從研究轉向生產(chǎn)。 BoTorch是PyTorch上的貝葉斯優(yōu)化軟件庫,為Ax優(yōu)化模型參數(shù)提供支持。BoTorch將模塊化設計和PyTorch的自動微分特性基于蒙特卡羅的提取函數(shù)使用相結合,顯著提高了開發(fā)人員的效率。BoTorch具有與任何PyTorch模型集成的能力,在貝葉斯優(yōu)化和深度學習中實現(xiàn)高度靈活性、便利的研究。以上兩種工具已經(jīng)在Facebook內部大規(guī)模部署,F(xiàn)acebook用它們改善信息流推薦和視頻播放。idb

BoTorch是PyTorch上的貝葉斯優(yōu)化軟件庫,為Ax優(yōu)化模型參數(shù)提供支持。BoTorch將模塊化設計和PyTorch的自動微分特性基于蒙特卡羅的提取函數(shù)使用相結合,顯著提高了開發(fā)人員的效率。BoTorch具有與任何PyTorch模型集成的能力,在貝葉斯優(yōu)化和深度學習中實現(xiàn)高度靈活性、便利的研究。以上兩種工具已經(jīng)在Facebook內部大規(guī)模部署,F(xiàn)acebook用它們改善信息流推薦和視頻播放。idb idb(iOS development bridge)是自動化iOS模擬器和設備的命令行界面。它提供的簡單原始的API,輕松構建復雜的工作流。idb還有客戶機-服務器架構,可以更容易地在一組機器之間分配工作。Memscout是一個分析工具,它是jemalloc內存分配器的伴侶。Memscout為正在運行的流程的解釋jemalloc統(tǒng)計文件(JSON格式)原始數(shù)據(jù),并突出顯示相關指標。它會發(fā)現(xiàn)分配器的低效率,并提供對流程內存分配模式的深入觀察,然后提供可用于快速診斷與內存相關的性能問題的統(tǒng)計信息。

idb(iOS development bridge)是自動化iOS模擬器和設備的命令行界面。它提供的簡單原始的API,輕松構建復雜的工作流。idb還有客戶機-服務器架構,可以更容易地在一組機器之間分配工作。Memscout是一個分析工具,它是jemalloc內存分配器的伴侶。Memscout為正在運行的流程的解釋jemalloc統(tǒng)計文件(JSON格式)原始數(shù)據(jù),并突出顯示相關指標。它會發(fā)現(xiàn)分配器的低效率,并提供對流程內存分配模式的深入觀察,然后提供可用于快速診斷與內存相關的性能問題的統(tǒng)計信息。 Mvfst是QUIC傳輸協(xié)議的實現(xiàn)。mvfst的目標是構建最靈活、高性能的傳輸協(xié)議,讓應用程序可以適應互聯(lián)網(wǎng)上和數(shù)據(jù)中心內的用例。它的特性包括流多路復用、0-RTT連接的建立,更好的損失恢復、從頭開始的安全性以及靈活的擁塞控制。用AI改善用戶體驗Facebook信息流可以說是國外的“朋友圈”,里面有太多的假新聞和有害信息,扎克伯格也因此受到美國國會質詢。所以Facebook的AI工具一個重要的用途就是用來識別和處理社交網(wǎng)絡上有害的言論、照片和視頻。一個具體例子是新的“最近鄰”算法。Facebook用這種算法發(fā)現(xiàn)色情暴力圖片比以前快8.5倍。

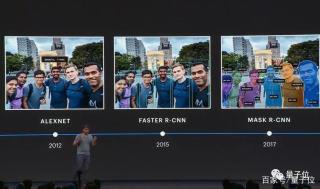

Mvfst是QUIC傳輸協(xié)議的實現(xiàn)。mvfst的目標是構建最靈活、高性能的傳輸協(xié)議,讓應用程序可以適應互聯(lián)網(wǎng)上和數(shù)據(jù)中心內的用例。它的特性包括流多路復用、0-RTT連接的建立,更好的損失恢復、從頭開始的安全性以及靈活的擁塞控制。用AI改善用戶體驗Facebook信息流可以說是國外的“朋友圈”,里面有太多的假新聞和有害信息,扎克伯格也因此受到美國國會質詢。所以Facebook的AI工具一個重要的用途就是用來識別和處理社交網(wǎng)絡上有害的言論、照片和視頻。一個具體例子是新的“最近鄰”算法。Facebook用這種算法發(fā)現(xiàn)色情暴力圖片比以前快8.5倍。 另一個例子是開源工具包LASER。Facebook用它來訓練單一模型以理解大量不同語言,而不必為每一種語言使用不同的模型,它可以檢測用戶是否發(fā)布違反社交網(wǎng)絡政策的言論。在視頻中發(fā)現(xiàn)有害信息的難度比照片高出幾個數(shù)量級,F(xiàn)acebook的新技術能將其分解為短片段,去掉其中冗余和不相關的內容。這種更有針對性的分析和訓練使得AI理解視頻更快,更準確。

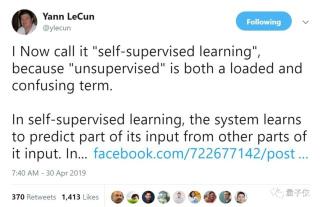

另一個例子是開源工具包LASER。Facebook用它來訓練單一模型以理解大量不同語言,而不必為每一種語言使用不同的模型,它可以檢測用戶是否發(fā)布違反社交網(wǎng)絡政策的言論。在視頻中發(fā)現(xiàn)有害信息的難度比照片高出幾個數(shù)量級,F(xiàn)acebook的新技術能將其分解為短片段,去掉其中冗余和不相關的內容。這種更有針對性的分析和訓練使得AI理解視頻更快,更準確。 One More Thing目前,F(xiàn)acebook正在大力發(fā)展自監(jiān)督學習技術,將未標記數(shù)據(jù)與少量標記數(shù)據(jù)結合使用,以提高機器學習的準確性。所謂的“自監(jiān)督學習”就是我們說的“無監(jiān)督學習”。Facebook首席AI科學家Yann LeCun說,把“自監(jiān)督”說成“無監(jiān)督”是具有誤導性的,因為自監(jiān)督學習比監(jiān)督學習使用更多的監(jiān)督信號,并且遠遠超過強化學習。

One More Thing目前,F(xiàn)acebook正在大力發(fā)展自監(jiān)督學習技術,將未標記數(shù)據(jù)與少量標記數(shù)據(jù)結合使用,以提高機器學習的準確性。所謂的“自監(jiān)督學習”就是我們說的“無監(jiān)督學習”。Facebook首席AI科學家Yann LeCun說,把“自監(jiān)督”說成“無監(jiān)督”是具有誤導性的,因為自監(jiān)督學習比監(jiān)督學習使用更多的監(jiān)督信號,并且遠遠超過強化學習。 自監(jiān)督學習在自然語言處理方面取得了巨大成功。在LeCun看來,在圖像和視頻上使用這項技術未來幾年ML和AI的最大挑戰(zhàn)。

自監(jiān)督學習在自然語言處理方面取得了巨大成功。在LeCun看來,在圖像和視頻上使用這項技術未來幾年ML和AI的最大挑戰(zhàn)。

- 免責聲明

- 本文所包含的觀點僅代表作者個人看法,不代表新火種的觀點。在新火種上獲取的所有信息均不應被視為投資建議。新火種對本文可能提及或鏈接的任何項目不表示認可。 交易和投資涉及高風險,讀者在采取與本文內容相關的任何行動之前,請務必進行充分的盡職調查。最終的決策應該基于您自己的獨立判斷。新火種不對因依賴本文觀點而產(chǎn)生的任何金錢損失負任何責任。

新火種

2023-11-13

新火種

2023-11-13