在視覺提示中加入「標(biāo)記」,微軟等讓GPT

機(jī)器之心報(bào)道

編輯:杜偉、小舟

全新視覺提示方法 SoM(Set-of-Mark),讓 OpenAI 多模態(tài)大模型 GPT-4V 在視覺內(nèi)容理解方面有了質(zhì)的提升。

最近一段時(shí)間,我們見證了大型語言模型(LLM)的顯著進(jìn)步。特別是,生成式預(yù)訓(xùn)練 Transformer 或 GPT 的發(fā)布引領(lǐng)了業(yè)界和學(xué)術(shù)界的多項(xiàng)突破。自 GPT-4 發(fā)布以來,大型多模態(tài)模型 (LMM) 引起了研究界越來越多的興趣,許多工作致力于構(gòu)建多模態(tài) GPT-4。

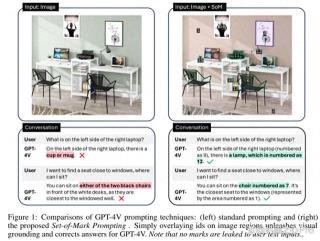

近日,GPT-4V (ision) 由于出色的多模態(tài)感知和推理能力得到了大家格外的關(guān)注。然而,盡管 GPT-4V 具有前所未有的視覺語言理解能力,但其細(xì)粒度 visual grounding(輸入是圖片和對(duì)應(yīng)的物體描述,輸出是描述物體的 box)能力相對(duì)較弱,或者尚未發(fā)揮出來。

舉例來說,當(dāng)用戶詢問下圖中「放置在右邊筆記本電腦的左邊是什么物體?」GPT-4V 給出了馬克杯這個(gè)錯(cuò)誤的答案。當(dāng)用戶接著詢問,「想找一個(gè)靠窗的座位,我可以坐在哪里?」GPT-4V 同樣回答不正確。

在意識(shí)到上述問題后,來自微軟、香港科技大學(xué)等機(jī)構(gòu)的研究者提出了一種新的視覺 prompt 方法 Set-of-Mark(SoM),來解決 GPT-4V 在細(xì)粒度視覺任務(wù)上的問題。

論文地址:/uploads/pic/20231024/pp.pdf style="box-sizing: border-box;border: 0px;color: rgb(34, 34, 34);orphans: 2;text-align: justify;text-indent: 0px;text-transform: none;widows: 2;word-spacing: 0px;-webkit-text-stroke-width: 0px;white-space: normal;background-color: rgb(255, 255, 255);text-decoration-thickness: initial;text-decoration-style: initial;text-decoration-color: initial">論文主頁:https://som-gpt4v.github.io/

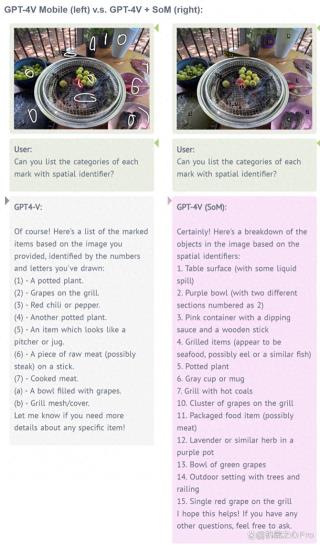

如圖 1(右)所示,SoM 采用交互式分割模型(例如 SAM)將圖像劃分為不同粒度級(jí)別的區(qū)域,并在這些區(qū)域上添加一組標(biāo)記(mark),例如字母數(shù)字、掩碼(mask)、框(box)。使用添加標(biāo)記的圖像作為輸入,以解決上述問題。

我們先來看下效果,左為 GPT-4V,右為 GPT-4V+SoM,很明顯后者分類更細(xì)致、準(zhǔn)確。

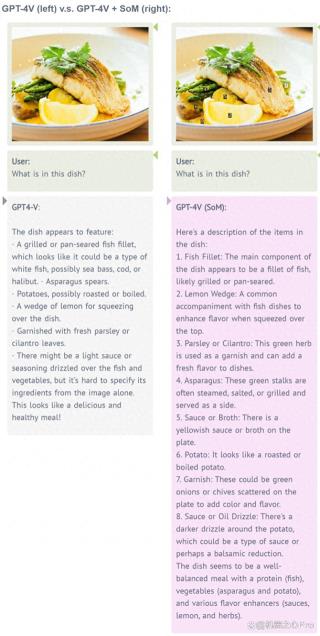

下圖示例依然如此,GPT-4V+SoM 效果更明顯。

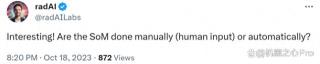

此外,對(duì)于這項(xiàng)研究,有人問道:「SoM 是手動(dòng)(人工輸入)還是自動(dòng)的?」

論文一作 Jianwei Yang 表示,SoM 是自動(dòng)或半自動(dòng)的。他們編譯了很多自己構(gòu)建自己的分割工具,比如 SEEM、Semantic-SAM 和 SAM,用來幫助用戶自動(dòng)為圖像分割區(qū)域。同時(shí)用戶也可以自己選擇區(qū)域。

用于視覺的 SoM prompt

使用 SoM prompt GPT-4V 的獨(dú)特優(yōu)點(diǎn)是它可以產(chǎn)生文本之外的輸出。由于每個(gè)標(biāo)記都與掩碼表征的圖像區(qū)域特定關(guān)聯(lián),因此可以追溯文本輸出中任何提到的標(biāo)記的掩碼。

生成成對(duì)文本和掩碼的能力使 SoM 能夠 prompt GPT-4V 來生成視覺關(guān)聯(lián)的文本,更重要的是支持各種細(xì)粒度視覺任務(wù),這對(duì)普通的 GPT-4V 模型來說是一個(gè)挑戰(zhàn)。

通過簡(jiǎn)單的 prompt 工程,SoM 可以讓 GPT-4V 廣泛地用于多種視覺任務(wù),例如:

開放詞匯圖像分割:該研究要求 GPT-4V 詳盡地給出所有標(biāo)記區(qū)域的類別以及從預(yù)定池中選擇的類別。

參考分割:給定一個(gè)參考表達(dá)式,GPT-4V 的任務(wù)是從圖像分區(qū)工具箱生成的候選區(qū)域中選擇最匹配的區(qū)域。

短語關(guān)聯(lián)(Phrase Grounding):與參考分割略有不同,短語關(guān)聯(lián)使用由多個(gè)名詞短語組成的完整句子。該研究要求 GPT-4V 為所有標(biāo)記的短語分配相應(yīng)的區(qū)域。

視頻對(duì)象分割:以兩個(gè)圖像作為輸入。第一個(gè)圖像是查詢圖像,其中包含第二個(gè)圖像中需要識(shí)別的一些對(duì)象。鑒于 GPT-4V 支持多個(gè)圖像作為輸入,因此 SoM 也可以應(yīng)用于視頻中跨幀的關(guān)聯(lián)視覺對(duì)象。

實(shí)驗(yàn)及結(jié)果

研究者使用「分而治之」(divide-and-conquer)的策略來運(yùn)行實(shí)驗(yàn)和評(píng)估。對(duì)于每個(gè)實(shí)例,他們使用新的聊天窗口,這樣一來,評(píng)估期間就不會(huì)出現(xiàn)上下文泄露了。

具體來講,研究者從每個(gè)數(shù)據(jù)集中選擇了小規(guī)模的驗(yàn)證數(shù)據(jù)子集。對(duì)于數(shù)據(jù)集中的每個(gè)圖像,他們?cè)谑褂脠D像分割工具箱提取的區(qū)域上覆蓋了一組標(biāo)記。同時(shí)基于具體的任務(wù),研究者利用不同的分割工具來提出區(qū)域。

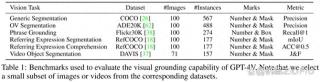

下表 1 列出了每個(gè)任務(wù)的設(shè)置細(xì)節(jié)。

研究者將其方法與以下模型進(jìn)行比較:

預(yù)測(cè)坐標(biāo)的 GPT-4V 基線模型

SOTA 專用模型

開源 LMM

定量結(jié)果

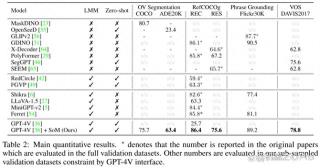

詳細(xì)的實(shí)驗(yàn)結(jié)果如下表 2 所示。

首先是圖像分割任務(wù)。研究者將 GPT-4V + SoM 與 COCO Panoptic 分割數(shù)據(jù)集上的強(qiáng)大分割模型 MaskDINO、ADE20K Panoptic 分割數(shù)據(jù)集上的模型 OpenSeeD 進(jìn)行了比較。

結(jié)果顯示,GPT-4V + SoM 的零樣本性能接近微調(diào)后的 MaskDINO,并大幅優(yōu)于 OpenSeeD。GPT-4V 在 COCO 和 ADE20K 上的相似性能表現(xiàn)出其對(duì)廣泛視覺和語義域任務(wù)的強(qiáng)大泛化能力。

然后是參考(referrring)任務(wù),研究者評(píng)估了 RefCOCOg 數(shù)據(jù)集上的模型 RES 和 REC。他們使用 MaskDINO 來提出掩碼,并在圖像上覆蓋上掩碼和數(shù)字。同時(shí)使用 mIoU 作為評(píng)估指標(biāo),并與 SOTA 專用模型 PolyFormer 和 SEEM 進(jìn)行比較。

結(jié)果顯示,GPT-4V+SoM 擊敗了 Grounding DINO、Polyformer 等專用模型以及 Shikra、LLaVA-1.5、MiniGPT-v2 和 Ferret 等最近的開源 LMM。

接著是 Flickr30K 上的短語關(guān)聯(lián)任務(wù),研究者使用 Grounding DINO 為每個(gè)圖像生成框建議。GPT-4V+SoM 實(shí)現(xiàn)了比 GLIPv2 和 Grounding DINO 更強(qiáng)的零樣本性能。

最后研究者在 DAVIS2017 數(shù)據(jù)集上評(píng)估了視頻分割任務(wù)。GPT-4V+SoM 實(shí)現(xiàn)了優(yōu)于其他專用視覺模型的最佳追蹤性能(78.8 J&F)。

消融研究

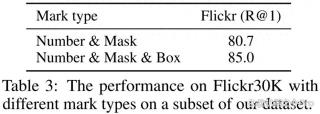

研究者探討了標(biāo)記類型如何影響 Flickr30k 數(shù)據(jù)集上短語關(guān)聯(lián)任務(wù)的最終性能,并比較了兩種類型的標(biāo)記。第一種是數(shù)字和掩碼,第二種是數(shù)字、掩碼和框。

結(jié)果如下表 3 所示,添加額外的框可以顯著提升性能。

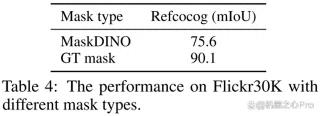

此外研究者探究了當(dāng)生成帶有真值注釋的標(biāo)記時(shí),GPT-4V 如何表現(xiàn)。他們選擇在 RefCOCOg 驗(yàn)證集中用真值掩碼替換預(yù)測(cè)到的分割掩碼。這意味著 GPT-4V 只需要從注釋短語區(qū)域選擇一個(gè)即可。如預(yù)期一樣,參考分割的性能可以得到進(jìn)一步提升,尤其是當(dāng)分割模型有一些缺失的區(qū)域。

結(jié)果如下表 4 所示,在 SoM 中使用真值掩碼可以將 RefCOCOg 上的性能提升 14.5%(mIoU)。

更多技術(shù)細(xì)節(jié)和實(shí)驗(yàn)結(jié)果參閱原論文。

- 免責(zé)聲明

- 本文所包含的觀點(diǎn)僅代表作者個(gè)人看法,不代表新火種的觀點(diǎn)。在新火種上獲取的所有信息均不應(yīng)被視為投資建議。新火種對(duì)本文可能提及或鏈接的任何項(xiàng)目不表示認(rèn)可。 交易和投資涉及高風(fēng)險(xiǎn),讀者在采取與本文內(nèi)容相關(guān)的任何行動(dòng)之前,請(qǐng)務(wù)必進(jìn)行充分的盡職調(diào)查。最終的決策應(yīng)該基于您自己的獨(dú)立判斷。新火種不對(duì)因依賴本文觀點(diǎn)而產(chǎn)生的任何金錢損失負(fù)任何責(zé)任。

新火種

2023-10-25

新火種

2023-10-25