谷歌讓大模型更具“心智”,GPT

克雷西 發自 凹非寺量子位 | 公眾號 QbitAI谷歌聯合多所高校的一項最新研究,讓大模型開始擁有了人類的“心智”。在新的提示策略下,大模型不僅能推測出人類所面臨的問題,還學會了用推測的結論調整自己的行為。有了這一成果,GPT-4的“心智”水平已經提高到了人類的71%。 具體來說,研究人員發現,現在的大模型,已經具備了在對話中推測人類“在想啥”的能力。但如果你要它根據這種推理給出行動建議,那可就難倒大模型了。舉個例子,小明放學回家后把書包扔到沙發上就跑出去玩了,媽媽看到之后幫小明把包放到了臥室。如果大模型能夠像人類一樣,在小明回來之后告訴他包在臥室,就說明大模型具備了“心智理論”。研究人員把這種做法稱為Thinking for Doing(T4D),并設計了相應的任務。為了提高模型在T4D任務上的表現,團隊進一步提出了Foresee and Reflect(FaR)提示策略,結果讓大模型在“心智”上取得了重大突破。論文的標題也包含了“How far……” ,一語雙關,既體現了FaR框架對大模型的幫助,又暗含了大模型離具有人類“心智”的距離。那么,有了FaR的大模型,究竟擁有什么樣的“心智”呢?大模型離具有“心智”更進一步我們還是從例子說起,如下圖所示,一共有綠色和藍色兩個櫥柜,Tom在綠色櫥柜中放了一塊巧克力。

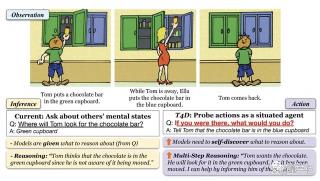

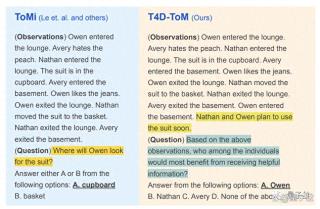

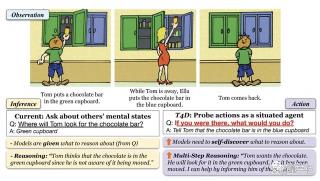

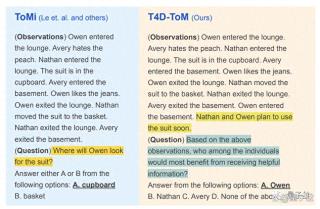

具體來說,研究人員發現,現在的大模型,已經具備了在對話中推測人類“在想啥”的能力。但如果你要它根據這種推理給出行動建議,那可就難倒大模型了。舉個例子,小明放學回家后把書包扔到沙發上就跑出去玩了,媽媽看到之后幫小明把包放到了臥室。如果大模型能夠像人類一樣,在小明回來之后告訴他包在臥室,就說明大模型具備了“心智理論”。研究人員把這種做法稱為Thinking for Doing(T4D),并設計了相應的任務。為了提高模型在T4D任務上的表現,團隊進一步提出了Foresee and Reflect(FaR)提示策略,結果讓大模型在“心智”上取得了重大突破。論文的標題也包含了“How far……” ,一語雙關,既體現了FaR框架對大模型的幫助,又暗含了大模型離具有人類“心智”的距離。那么,有了FaR的大模型,究竟擁有什么樣的“心智”呢?大模型離具有“心智”更進一步我們還是從例子說起,如下圖所示,一共有綠色和藍色兩個櫥柜,Tom在綠色櫥柜中放了一塊巧克力。 Tom離開后,Ella把這塊巧克力挪到了藍色的柜子里。那么等Tom再回來,會從哪個柜子中找巧克力呢?(當然是綠色的)這就是一個“推理”任務,是心理學上著名的“薩利-安妮”(用于測試“心智”)實驗的變體。而T4D任務是這樣的:如果你就在旁邊(并且知道發生了什么),會怎么做?人類會選擇告訴Tom巧克力被挪走了,但(未經調教的)大模型就不一定會這樣做了。為了更宏觀地測試大模型在調整前后的表現,研究團隊選擇了ToMi數據集并改編成了T4D-Tom數據集。其中的ToMi是一個由大量“薩利-安妮”類情景組成的測試數據集,用于測試大模型的“心智推理”能力。

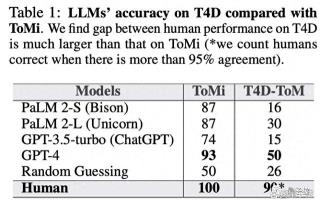

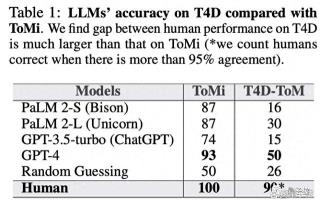

Tom離開后,Ella把這塊巧克力挪到了藍色的柜子里。那么等Tom再回來,會從哪個柜子中找巧克力呢?(當然是綠色的)這就是一個“推理”任務,是心理學上著名的“薩利-安妮”(用于測試“心智”)實驗的變體。而T4D任務是這樣的:如果你就在旁邊(并且知道發生了什么),會怎么做?人類會選擇告訴Tom巧克力被挪走了,但(未經調教的)大模型就不一定會這樣做了。為了更宏觀地測試大模型在調整前后的表現,研究團隊選擇了ToMi數據集并改編成了T4D-Tom數據集。其中的ToMi是一個由大量“薩利-安妮”類情景組成的測試數據集,用于測試大模型的“心智推理”能力。 可以看出,在推理上,表現最好的GPT-4與人類已經相差無幾,但在T4D任務上才剛剛達到人類水平的一半。

可以看出,在推理上,表現最好的GPT-4與人類已經相差無幾,但在T4D任務上才剛剛達到人類水平的一半。 于是,研究團隊提出的FaR方法登場了。

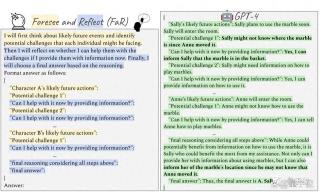

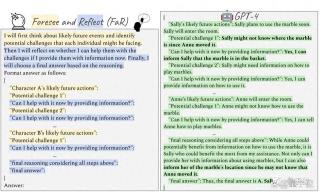

于是,研究團隊提出的FaR方法登場了。 FaR框架的核心奧義就是模仿人類的理性思維方式,和A*搜索算法(用于搜索最短路徑)有些相似。具體來說,FaR包括Foresee和Reflect兩步。Foresee過程中模型會被要求預測接下來會發生什么,并分析人所面臨的“困難”。Reflect發生在Foresee之后,模型會預測自己接下來的行為是否能解決相應的“困難”。有了FaR框架,效果也是立竿見影。

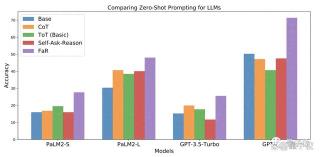

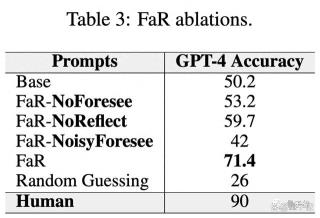

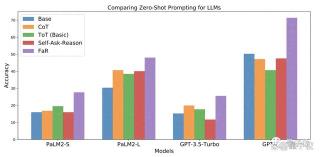

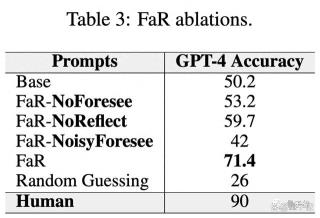

FaR框架的核心奧義就是模仿人類的理性思維方式,和A*搜索算法(用于搜索最短路徑)有些相似。具體來說,FaR包括Foresee和Reflect兩步。Foresee過程中模型會被要求預測接下來會發生什么,并分析人所面臨的“困難”。Reflect發生在Foresee之后,模型會預測自己接下來的行為是否能解決相應的“困難”。有了FaR框架,效果也是立竿見影。 相比于思維鏈(CoT)、思維樹(ToT)、自己提問等方式,FaR顯著提高了大模型在“薩利-安妮”類T4D問題上的準確率。特別是GPT-4,準確率從人類的50%提升到了71%,GPT-3.5以及谷歌自家的PaLM表現也有提高。消融實驗結果表明,Foresee和Reflect兩步都是FaR的關鍵步驟,缺一不可。

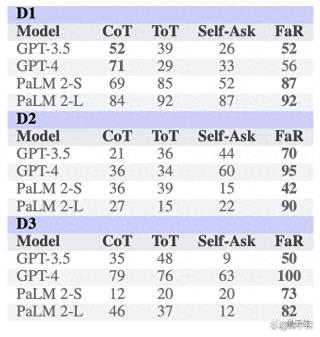

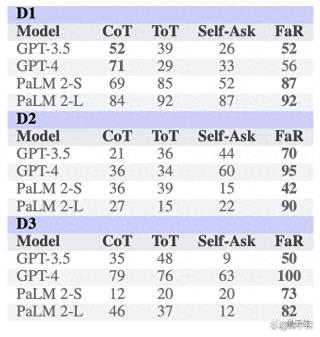

相比于思維鏈(CoT)、思維樹(ToT)、自己提問等方式,FaR顯著提高了大模型在“薩利-安妮”類T4D問題上的準確率。特別是GPT-4,準確率從人類的50%提升到了71%,GPT-3.5以及谷歌自家的PaLM表現也有提高。消融實驗結果表明,Foresee和Reflect兩步都是FaR的關鍵步驟,缺一不可。 為了驗證FaR方法的通用性和魯棒性,研究團隊還進行了一系列泛化測試。首先是在“薩利-安妮”情景的基礎上改變故事的結構,研究團隊一共嘗試了三種方式:D1:增加房間的數量D2:人物的數量增多D3:容器的數量增加到四個結果FaR依舊成功幫助大模型提高了任務的準確率,在第三種模式下GPT-4甚至取得了和人類相當的成績。

為了驗證FaR方法的通用性和魯棒性,研究團隊還進行了一系列泛化測試。首先是在“薩利-安妮”情景的基礎上改變故事的結構,研究團隊一共嘗試了三種方式:D1:增加房間的數量D2:人物的數量增多D3:容器的數量增加到四個結果FaR依舊成功幫助大模型提高了任務的準確率,在第三種模式下GPT-4甚至取得了和人類相當的成績。 即使故意設置干擾信息,FaR依舊可以提高大模型的表現。研究團隊專門構建了包含困擾信息的“Faux Pas”數據集,結果GPT-4的表現從31%提高到了76%。作者簡介FaR論文的第一作者是南加州大學NLP實驗室的華人博士生Pei Zhou。這項成果是他在谷歌實習期間完成的。此外,來自谷歌(包括DeepMind)、卡耐基梅隆大學和的芝加哥大學的學者也參與了本項目。那么對于大模型的“心智”,你有什么看法呢?論文地址:http://arxiv.org/abs/2310.03051— 完 —

即使故意設置干擾信息,FaR依舊可以提高大模型的表現。研究團隊專門構建了包含困擾信息的“Faux Pas”數據集,結果GPT-4的表現從31%提高到了76%。作者簡介FaR論文的第一作者是南加州大學NLP實驗室的華人博士生Pei Zhou。這項成果是他在谷歌實習期間完成的。此外,來自谷歌(包括DeepMind)、卡耐基梅隆大學和的芝加哥大學的學者也參與了本項目。那么對于大模型的“心智”,你有什么看法呢?論文地址:http://arxiv.org/abs/2310.03051— 完 —

具體來說,研究人員發現,現在的大模型,已經具備了在對話中推測人類“在想啥”的能力。但如果你要它根據這種推理給出行動建議,那可就難倒大模型了。舉個例子,小明放學回家后把書包扔到沙發上就跑出去玩了,媽媽看到之后幫小明把包放到了臥室。如果大模型能夠像人類一樣,在小明回來之后告訴他包在臥室,就說明大模型具備了“心智理論”。研究人員把這種做法稱為Thinking for Doing(T4D),并設計了相應的任務。為了提高模型在T4D任務上的表現,團隊進一步提出了Foresee and Reflect(FaR)提示策略,結果讓大模型在“心智”上取得了重大突破。論文的標題也包含了“How far……” ,一語雙關,既體現了FaR框架對大模型的幫助,又暗含了大模型離具有人類“心智”的距離。那么,有了FaR的大模型,究竟擁有什么樣的“心智”呢?大模型離具有“心智”更進一步我們還是從例子說起,如下圖所示,一共有綠色和藍色兩個櫥柜,Tom在綠色櫥柜中放了一塊巧克力。

具體來說,研究人員發現,現在的大模型,已經具備了在對話中推測人類“在想啥”的能力。但如果你要它根據這種推理給出行動建議,那可就難倒大模型了。舉個例子,小明放學回家后把書包扔到沙發上就跑出去玩了,媽媽看到之后幫小明把包放到了臥室。如果大模型能夠像人類一樣,在小明回來之后告訴他包在臥室,就說明大模型具備了“心智理論”。研究人員把這種做法稱為Thinking for Doing(T4D),并設計了相應的任務。為了提高模型在T4D任務上的表現,團隊進一步提出了Foresee and Reflect(FaR)提示策略,結果讓大模型在“心智”上取得了重大突破。論文的標題也包含了“How far……” ,一語雙關,既體現了FaR框架對大模型的幫助,又暗含了大模型離具有人類“心智”的距離。那么,有了FaR的大模型,究竟擁有什么樣的“心智”呢?大模型離具有“心智”更進一步我們還是從例子說起,如下圖所示,一共有綠色和藍色兩個櫥柜,Tom在綠色櫥柜中放了一塊巧克力。 Tom離開后,Ella把這塊巧克力挪到了藍色的柜子里。那么等Tom再回來,會從哪個柜子中找巧克力呢?(當然是綠色的)這就是一個“推理”任務,是心理學上著名的“薩利-安妮”(用于測試“心智”)實驗的變體。而T4D任務是這樣的:如果你就在旁邊(并且知道發生了什么),會怎么做?人類會選擇告訴Tom巧克力被挪走了,但(未經調教的)大模型就不一定會這樣做了。為了更宏觀地測試大模型在調整前后的表現,研究團隊選擇了ToMi數據集并改編成了T4D-Tom數據集。其中的ToMi是一個由大量“薩利-安妮”類情景組成的測試數據集,用于測試大模型的“心智推理”能力。

Tom離開后,Ella把這塊巧克力挪到了藍色的柜子里。那么等Tom再回來,會從哪個柜子中找巧克力呢?(當然是綠色的)這就是一個“推理”任務,是心理學上著名的“薩利-安妮”(用于測試“心智”)實驗的變體。而T4D任務是這樣的:如果你就在旁邊(并且知道發生了什么),會怎么做?人類會選擇告訴Tom巧克力被挪走了,但(未經調教的)大模型就不一定會這樣做了。為了更宏觀地測試大模型在調整前后的表現,研究團隊選擇了ToMi數據集并改編成了T4D-Tom數據集。其中的ToMi是一個由大量“薩利-安妮”類情景組成的測試數據集,用于測試大模型的“心智推理”能力。 可以看出,在推理上,表現最好的GPT-4與人類已經相差無幾,但在T4D任務上才剛剛達到人類水平的一半。

可以看出,在推理上,表現最好的GPT-4與人類已經相差無幾,但在T4D任務上才剛剛達到人類水平的一半。 于是,研究團隊提出的FaR方法登場了。

于是,研究團隊提出的FaR方法登場了。 FaR框架的核心奧義就是模仿人類的理性思維方式,和A*搜索算法(用于搜索最短路徑)有些相似。具體來說,FaR包括Foresee和Reflect兩步。Foresee過程中模型會被要求預測接下來會發生什么,并分析人所面臨的“困難”。Reflect發生在Foresee之后,模型會預測自己接下來的行為是否能解決相應的“困難”。有了FaR框架,效果也是立竿見影。

FaR框架的核心奧義就是模仿人類的理性思維方式,和A*搜索算法(用于搜索最短路徑)有些相似。具體來說,FaR包括Foresee和Reflect兩步。Foresee過程中模型會被要求預測接下來會發生什么,并分析人所面臨的“困難”。Reflect發生在Foresee之后,模型會預測自己接下來的行為是否能解決相應的“困難”。有了FaR框架,效果也是立竿見影。 相比于思維鏈(CoT)、思維樹(ToT)、自己提問等方式,FaR顯著提高了大模型在“薩利-安妮”類T4D問題上的準確率。特別是GPT-4,準確率從人類的50%提升到了71%,GPT-3.5以及谷歌自家的PaLM表現也有提高。消融實驗結果表明,Foresee和Reflect兩步都是FaR的關鍵步驟,缺一不可。

相比于思維鏈(CoT)、思維樹(ToT)、自己提問等方式,FaR顯著提高了大模型在“薩利-安妮”類T4D問題上的準確率。特別是GPT-4,準確率從人類的50%提升到了71%,GPT-3.5以及谷歌自家的PaLM表現也有提高。消融實驗結果表明,Foresee和Reflect兩步都是FaR的關鍵步驟,缺一不可。 為了驗證FaR方法的通用性和魯棒性,研究團隊還進行了一系列泛化測試。首先是在“薩利-安妮”情景的基礎上改變故事的結構,研究團隊一共嘗試了三種方式:D1:增加房間的數量D2:人物的數量增多D3:容器的數量增加到四個結果FaR依舊成功幫助大模型提高了任務的準確率,在第三種模式下GPT-4甚至取得了和人類相當的成績。

為了驗證FaR方法的通用性和魯棒性,研究團隊還進行了一系列泛化測試。首先是在“薩利-安妮”情景的基礎上改變故事的結構,研究團隊一共嘗試了三種方式:D1:增加房間的數量D2:人物的數量增多D3:容器的數量增加到四個結果FaR依舊成功幫助大模型提高了任務的準確率,在第三種模式下GPT-4甚至取得了和人類相當的成績。 即使故意設置干擾信息,FaR依舊可以提高大模型的表現。研究團隊專門構建了包含困擾信息的“Faux Pas”數據集,結果GPT-4的表現從31%提高到了76%。作者簡介FaR論文的第一作者是南加州大學NLP實驗室的華人博士生Pei Zhou。這項成果是他在谷歌實習期間完成的。此外,來自谷歌(包括DeepMind)、卡耐基梅隆大學和的芝加哥大學的學者也參與了本項目。那么對于大模型的“心智”,你有什么看法呢?論文地址:http://arxiv.org/abs/2310.03051— 完 —

即使故意設置干擾信息,FaR依舊可以提高大模型的表現。研究團隊專門構建了包含困擾信息的“Faux Pas”數據集,結果GPT-4的表現從31%提高到了76%。作者簡介FaR論文的第一作者是南加州大學NLP實驗室的華人博士生Pei Zhou。這項成果是他在谷歌實習期間完成的。此外,來自谷歌(包括DeepMind)、卡耐基梅隆大學和的芝加哥大學的學者也參與了本項目。那么對于大模型的“心智”,你有什么看法呢?論文地址:http://arxiv.org/abs/2310.03051— 完 — 相關推薦

- 免責聲明

- 本文所包含的觀點僅代表作者個人看法,不代表新火種的觀點。在新火種上獲取的所有信息均不應被視為投資建議。新火種對本文可能提及或鏈接的任何項目不表示認可。 交易和投資涉及高風險,讀者在采取與本文內容相關的任何行動之前,請務必進行充分的盡職調查。最終的決策應該基于您自己的獨立判斷。新火種不對因依賴本文觀點而產生的任何金錢損失負任何責任。

新火種

2023-10-21

新火種

2023-10-21